来源: 墨玫人工智能

【导读】Transformer模型性能强的原因是模拟了人脑?

我不能创造的,我也不理解。

——费曼

想要创造人工智能,首先要理解人类的大脑因何有智能。

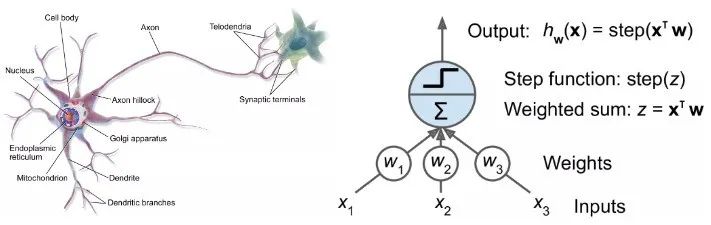

随着神经网络的诞生及后续的辉煌发展,研究者们一直在为神经网络寻找生物学上的解释,生物学上的进展也在启发AI研究人员开发新模型。

但人工智能领域的研究人员其实还有一个更远大的追求:利用AI模型来帮助理解大脑。

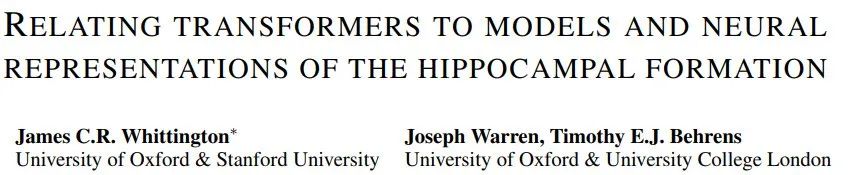

最近有研究发现,虽然时下最流行的Transformer模型是在完全没有生物学知识辅助的情况下开发出来的,但其架构却和人脑海马结构极其相似。

论文链接:https://arxiv.org/pdf/2112.04035.pdf

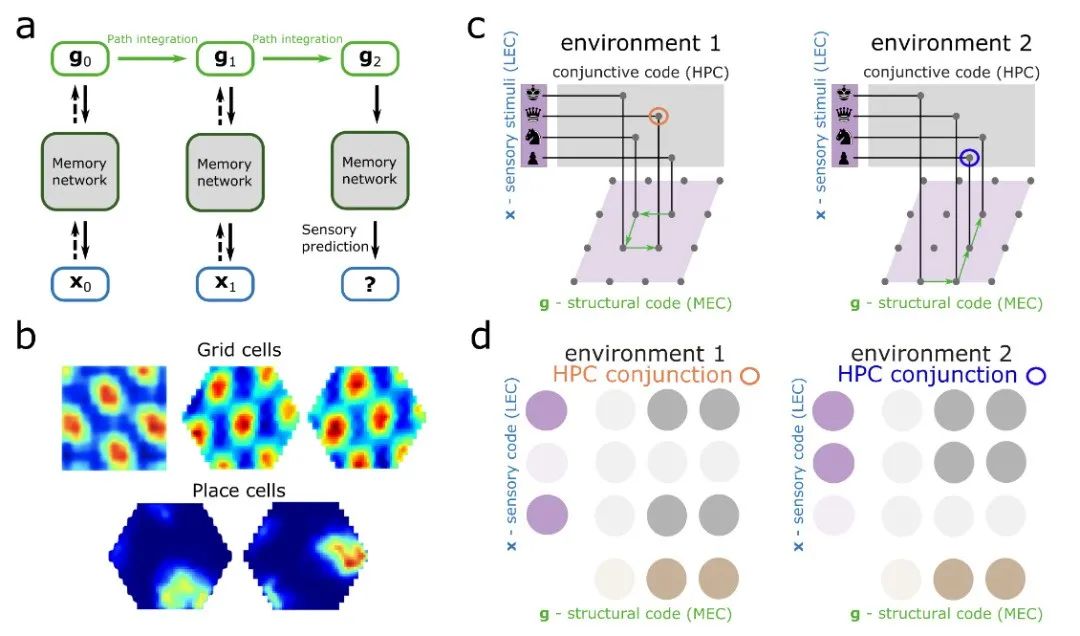

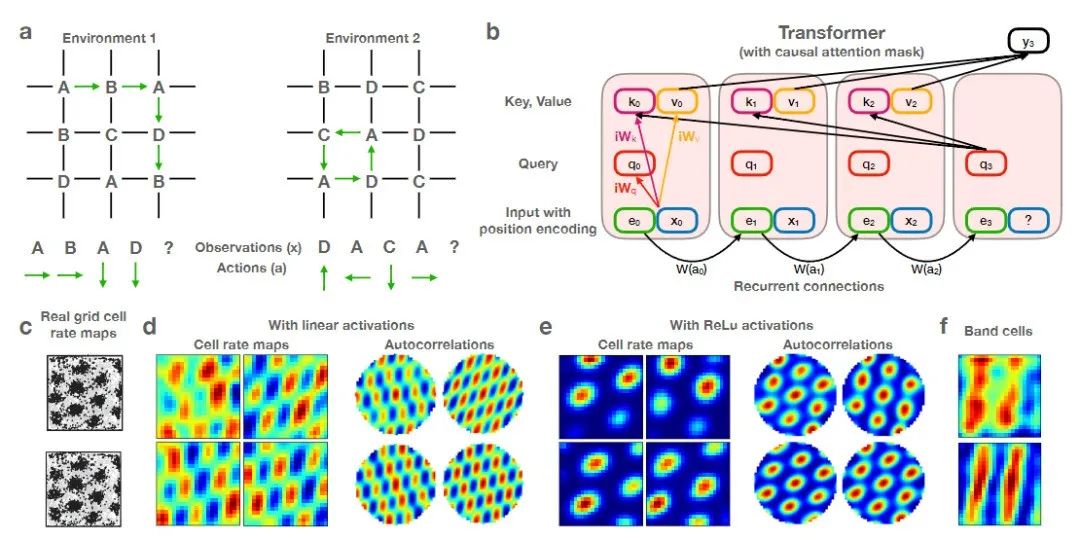

研究人员给Transformer配备了递归位置编码后,发现模型可以精确复制海马结构(hippocampal formation)的空间表征。

不过作者也表示,对于这一结果并不惊讶,因为Transformer与目前神经科学中的海马体模型密切相关,最明显的就是位置细胞(place cell)和网格细胞(grid cell)。

而且通过实验发现,Transformer模型相比神经科学版本提供的模型来说有巨大的性能提升。

这项工作将人工神经网络和大脑网络的计算结合起来,对海马体和大脑皮层之间的相互作用提供了新的理解,并暗示了皮层区域如何执行超出目前神经科学模型的更广泛的复杂任务,如语言理解。

Transformer仿真海马体?

人类想要了解自己的大脑仍然困难重重,比如研究大脑如何组织和访问空间信息来解

决「我们在哪里,拐角处有什么以及如何到达那里」仍然是一项艰巨的挑战。

整个过程可能涉及到从数百亿个神经元中调用整个记忆网络和存储的空间数据,每个神经元都连接到数千个其他神经元。

虽然神经科学家已经确定了几个关键元素,例如网格细胞、映射位置的神经元,但如何进行更深入的研究仍然是未知的:研究人员无法移除和研究人类灰质切片来观察基于位置的图像、声音和气味记忆如何流动并相互连接。

人工智能模型则提供了另一种途径来理解人脑,多年来,神经科学家已经利用多种类型的神经网络来模拟大脑中神经元的发射。

最近有研究表明,海马体(一个对记忆至关重要的大脑结构)基本上和Transformer模型差不多。

研究人员用新模型以一种与大脑内部运作相似的方式追踪空间信息,取得了一些显著的研究成果。

来自牛津大学和斯坦福大学的认知神经科学家James Whittington表示,当我们知道这些大脑模型等同于Transformer时,也就意味着新模型会表现得更好,也更容易训练。

从Whittington和其他人的研究成果中可以看出,Transformer可以极大地提高神经网络模型模仿网格细胞和大脑其他部分进行的各种计算的能力。

Whittington表示,这样的模型可以推动我们对人工神经网络如何工作的理解,甚至更有可能是对大脑中如何进行计算的理解。

主要从事Transformer模型研究的谷歌大脑计算机科学家David Ha表示,我们并不是要重新创造一个新的大脑,但我们能不能创造一种机制来做大脑可以做的事情?

Transformer在五年前才首次提出,当时是作为人工智能处理自然语言的一种新模型,也是BERT和GPT-3等那些「明星模型」的秘密武器。这些模型可以生成令人信服的歌词,创作莎士比亚十四行诗,或者做一些人工客服的工作。

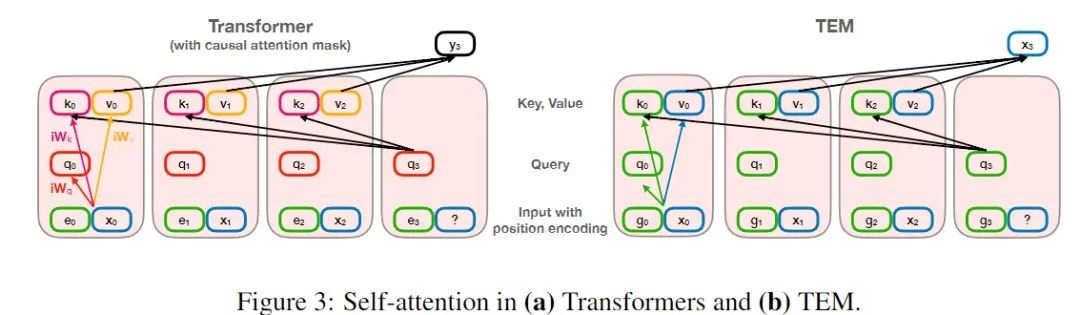

Transformer的核心机制就是自注意力,其中每个输入(例如一个单词、一个像素、一个序列中的数字)总是与其他的所有输入相连,而其他常见的神经网络只是将输入与某些输入相连接。

虽然Transformer是专门为自然语言任务而设计的,但后来的研究也证明了Transformer在其他任务中也同样表现出色,比如对图像进行分类,以及现在对大脑进行建模。

2020年,由奥地利约翰开普勒林茨大学的计算机科学家Sepp Hochreiter(LSTM论文一作)领导的一个小组,使用一个Transformer来重新调整一个强大的、长期存在的记忆检索模型Hopfield网络。

这些网络在40年前由普林斯顿物理学家John Hopfield首次提出,遵循一个一般规则:在同一时间活跃的神经元相互之间建立了强有力的联系。

Hochreiter和他的合作者注意到,研究人员一直在寻找更好的记忆检索模型,他们看到了一类新的Hopfield网络如何检索记忆和Transformer如何执行注意力之间的联系。

这些新的Hopfield网络由Hopfield和麻省理工学院-IBM沃森人工智能实验室的Dmitry Krotov开发,与标准的Hopfield网络相比,具有更有效的连接,可以存储和检索更多记忆。

论文链接:

https://papers.nips.cc/paper/2016/hash/eaae339c4d89fc102edd9dbdb6a28915-Abstract.html

Hochreiter的团队通过添加一个类似Transformer中的注意力机制的规则来升级这些网络。

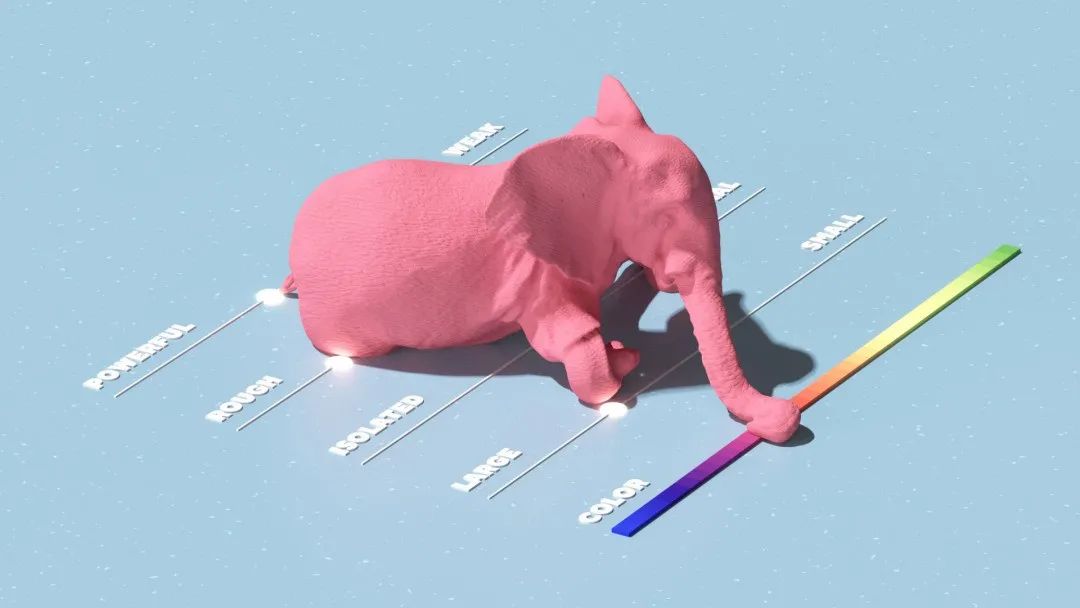

2022年,这篇新论文的进一步调整了Hochreiter的方法,修改了Transformer,使其不再将记忆视为线性序列,而是像句子中的一串单词,将其编码为高维空间中的坐标。

研究人员称这种「扭曲」进一步提高了该模型在神经科学任务中的表现。实验结果还表明,该模型在数学上等同于神经科学家在fMRI扫描中看到的网格细胞发射模式的模型。

伦敦大学学院的神经科学家Caswell Barry表示,网格细胞具有这种令人兴奋的、美丽的、有规律的结构,并且具有引人注目的模式,不太可能随机出现。

这项新工作显示了Transformer如何准确地复制了在海马体中观察到的那些模式。

他们也认识到,Transformer模型可以根据以前的状态和它的移动方式弄清楚它在哪里,而且是以一种关键的方式进入传统的网格细胞模型。

近期的一些其他工作也表明,Transformer可以促进我们对其他大脑功能的理解。

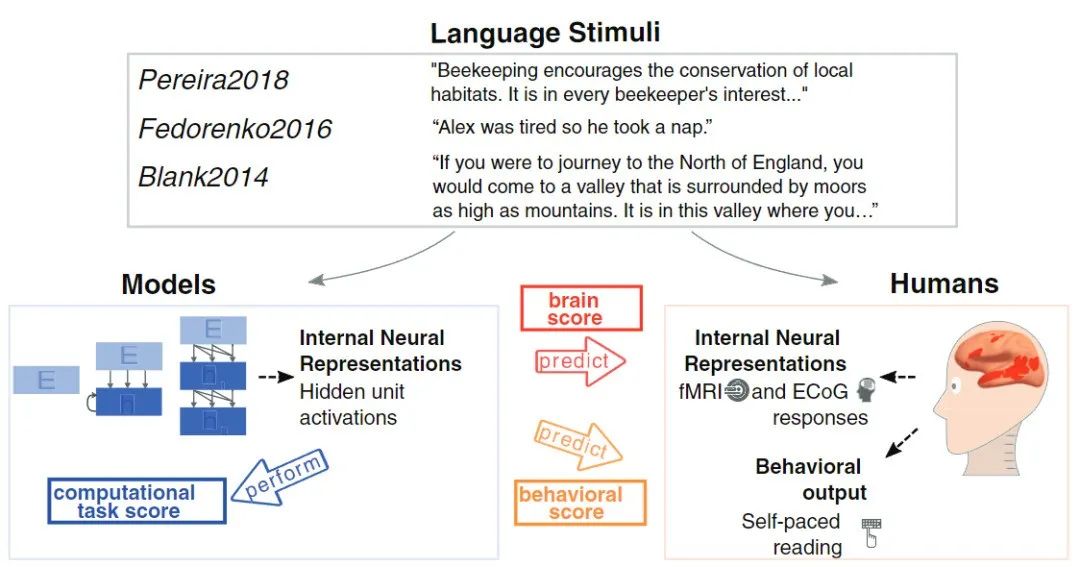

去年,麻省理工学院的计算神经科学家Martin Schrimpf分析了43种不同的神经网络模型,以了解它们对由fMRI和皮质电图报告的人类神经活动测量结果的预测程度。

他发现Transformer是目前领先的、最先进的神经网络,几乎可以预测成像中发现的所有变化。

而David Ha与同为计算机科学家的Yujin Tang最近也设计了一个模型,可以故意给Transformer以随机、无序的方式输入大量数据,模仿人体如何向大脑传输感官观察。结果发现Transformer可以像我们的大脑一样,可以成功地处理无序的信息流。

论文链接:https://arxiv.org/abs/2111.14377

Yujin Tang表示,神经网络是硬接线,只能接收特定的输入。但在现实生活中,数据集经常快速变化,而大多数人工智能没有任何办法调整。未来我们想尝试一种能够快速适应的架构。

参考资料:

https://www.quantamagazine.org/how-ai-transformers-mimic-parts-of-the-brain-20220912/

未来智能实验室的主要工作包括:建立AI智能系统智商评测体系,开展世界人工智能智商评测;开展互联网(城市)大脑研究计划,构建互联网(城市)大脑技术和企业图谱,为提升企业,行业与城市的智能水平服务。每日推荐范围未来科技发展趋势的学习型文章。目前线上平台已收藏上千篇精华前沿科技文章和报告。

如果您对实验室的研究感兴趣,欢迎加入未来智能实验室线上平台。扫描以下二维码或点击本文左下角“阅读原文”

)

2017)

)

)

)