文章目录

- abstract

- 1.introduction

- 3.问题形式化

- 4.系统架构

- 5. 命名实体识别

- 6.关系抽取(核方法)

- 6.1global context kernel

- 6.2 local context kernel

- 6.3 shallow linguistic kernel

- 7实验

Giuliano, C., et al. “Relation extraction and the influence of automatic named-entity recognition.” Acm Transactions on Speech & Language Processing 5(1): 1-26.

http://portal.acm.org/citation.cfm?doid=1322391.1322393

abstract

我们提出了一种从自然语言文档中提取命名实体之间关系的方法。该方法仅基于浅层语言处理,例如标记化,句子拆分,词性标记和词形化。它使用内核功能的组合来集成两个不同的信息源:(i)有关系出现的整个句子,以及(ii)交互实体周围的局部上下文。我们介绍了从新闻专线文档数据集中提取五种不同类型关系的实验结果,并表明每个信息源都为识别任务提供了有用的帮助。通常,组合内核相对于基本内核会显着提高精度,有时会以召回率略低为代价。此外,我们进行了一组实验,以评估命名实体识别的准确性对关系提取算法性能的影响。使用正确的命名实体(即,在语料库中手动注释的实体)和嘈杂的命名实体(即,由基于机器学习的命名实体识别器生成的实体)进行此类实验。结果表明,我们的方法大大改善了先前在同一数据集上获得的结果。

- 该方法仅基于浅层语言处理

- 使用内核函数(kernel function)集成连个信息源

- 句子

- 交互实体周围的局部上下文

- 组合内核>基本内核

1.introduction

- ner:使用线性链CRFs [Lafferty et al. 2001]来执行NER。

- 关系提取:我们采用了Giuliano等人[2006]的方法(仅仅基于浅层的语言处理)–核

- (i)实体出现的全局上下文和

- (ii)交互实体周围的本地上下文。

- 组合的核:将上两步分类器的结果组合起来,输出与全局概率推断相结合。

3.问题形式化

我们首先描述一些关于输入数据的假设。首先,这些实体已经被识别并作为输入提供给我们。请注意,以下生成过程既适用于自动识别命名实体时,也适用于手动识别它们时(即,取自金本位)。在本文中,我们提供了这两种情况下的实验结果。第二,只考虑同一句话内的实体之间的关系;虽然在不同的句子中可能存在实体之间的关系,但在用于评价的语料库中没有注释。因此没有考虑这个问题。我们将在下面看到,这种假设限制了数据集的大小。第三,我们不考虑自我关系。因为它们在语料库中没有注释。最后,每一种关系类型都是独立学习的,因此需要在不同的数据集上进行训练和测试。

- 关系分类中的候选实体:同一句子中的实体的排列组合。—不平衡,有关系的是少数。(有关系+1,无则-1)

- 改进:只考虑组合,不考虑排列(无序)

- 在本例中,如果两个候选实体之间存在关系,则根据关系的方向将示例标记为1或2;否则,标记为0。

- 关系的两个实体可分为

- 两个实体是同类的

- 两个实体是不同类的

- 满足头实体尾实体的类型约束(生成候选实体时)

- 改进:只考虑组合,不考虑排列(无序)

4.系统架构

首先,从指定的带注释的语料库脱机学习两个模型,一个用于实体识别(参见第5节),另一个用于关系提取(参见第6节)。然后,将这些模型应用到管道中以标记新文档。

- 管道方法??

- 用实体部分预测的实体标签来进行关系抽取,而非用标注的标签(在训练中也是)

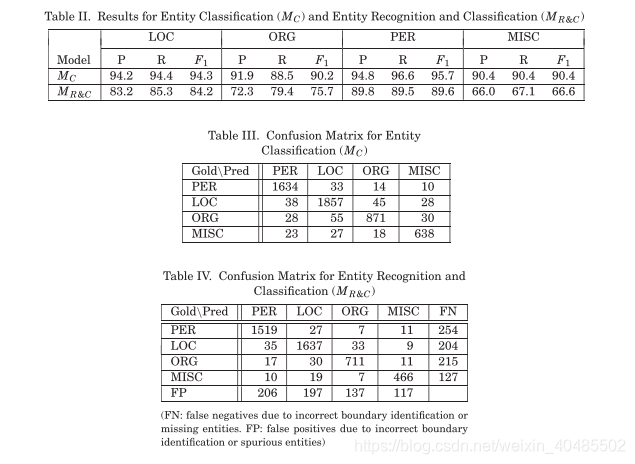

5. 命名实体识别

- CRFs

- 训练两个模型

- 实体分类

- 实体提取+分类

- 都用五折交叉验证

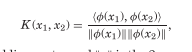

6.关系抽取(核方法)

- 输入X–》embedding

- kernel function:X,X->R

- 学习算法可以用SVM

- 两个核函数:global context kernels and local context kernels

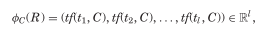

6.1global context kernel

- R–关系

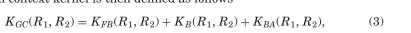

where KFB, KB and KBA are n-gram kernels that operate on the Fore-Between, Between and Between-After patterns, respectively.

6.2 local context kernel

候选实体的局部上下文可以为检测关系的方向以及关系本身的存在提供有用的线索。与实体识别一样,我们使用以下基本特性来表示每个本地上下文

- L=t-w,…,t0,t1,…tw

where Kleft and Kright are defined by substituting the embedding ofthe left and right local context into Equation (1), respectively.

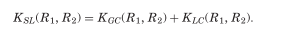

6.3 shallow linguistic kernel

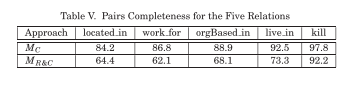

7实验

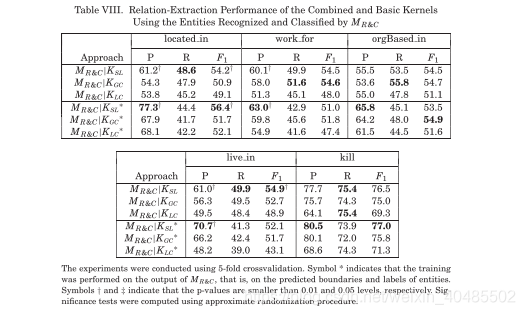

(1) MO|K. The correct entities are used during relation extraction training and testing;

(2) MC|K. The entity predictions given by the MC model are used as input to the relation extraction algorithm when it is run on the test set;

(3) MR&C|K. The entity predictions given by the MR&C model are used as input to the relation extraction algorithm when it is run on the test set.

)

)