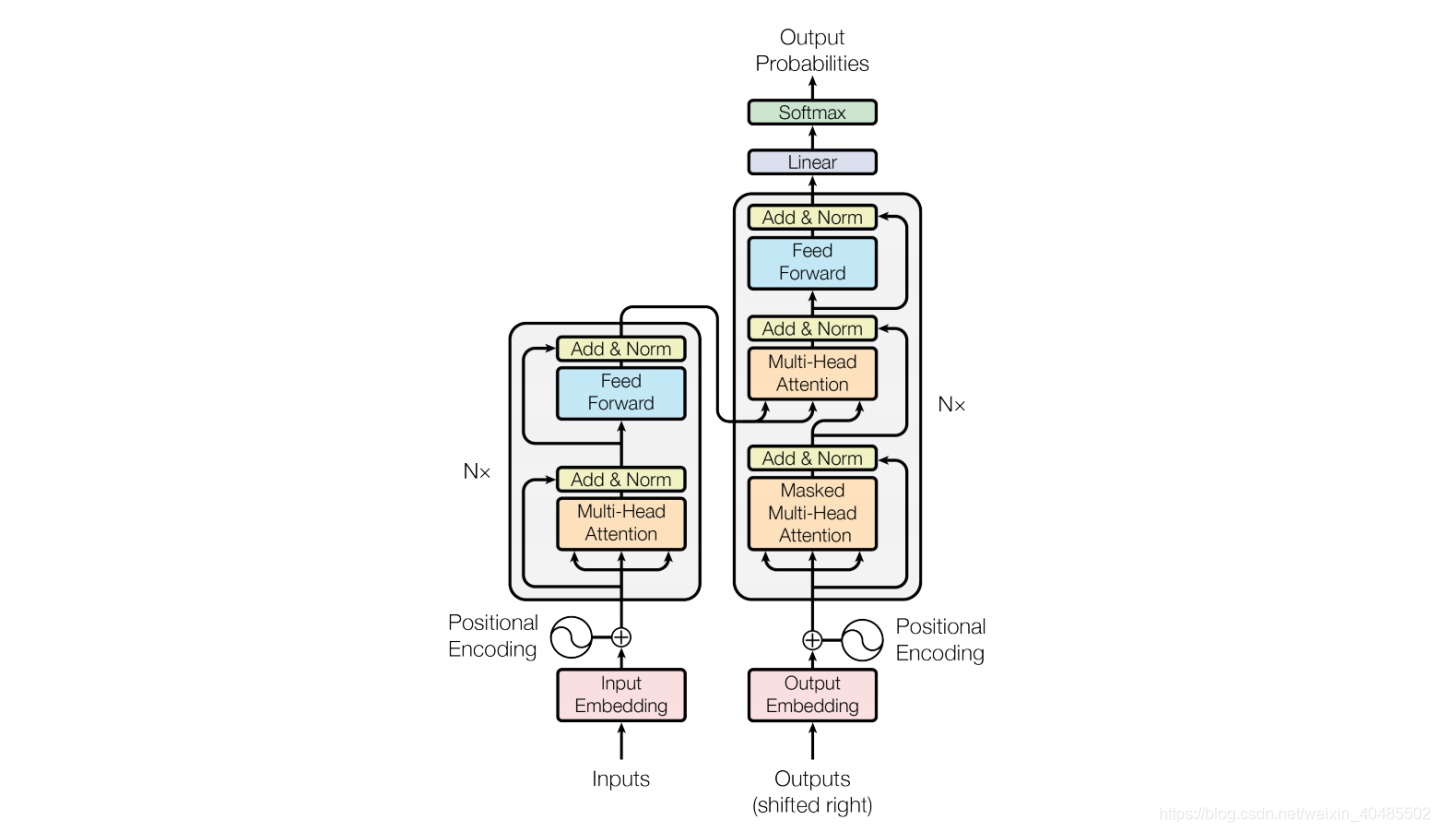

1.Transformer

-

multihead attention block:MAB(X,Y)=LayerNorm(H+rFF(H))H=LayerNorm(X+multihead(X,Y,Y;ω)MAB(X,Y)=LayerNorm(H+rFF(H))\\ H=LayerNorm(X+multihead(X,Y,Y;\omega)MAB(X,Y)=LayerNorm(H+rFF(H))H=LayerNorm(X+multihead(X,Y,Y;ω)

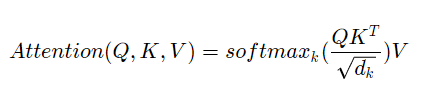

* Attention:Att(Q,K,Vl;ω)=ω(QKT)VAtt(Q,K,Vl;\omega)=\omega(QK^T)VAtt(Q,K,Vl;ω)=ω(QKT)V

* multi:multihead(Q,K,V;λ,ω)=concat(O1,...,Oh)WOmultihead(Q,K,V;\lambda,\omega)=concat(O_1,...,O_h)W^Omultihead(Q,K,V;λ,ω)=concat(O1,...,Oh)WO -

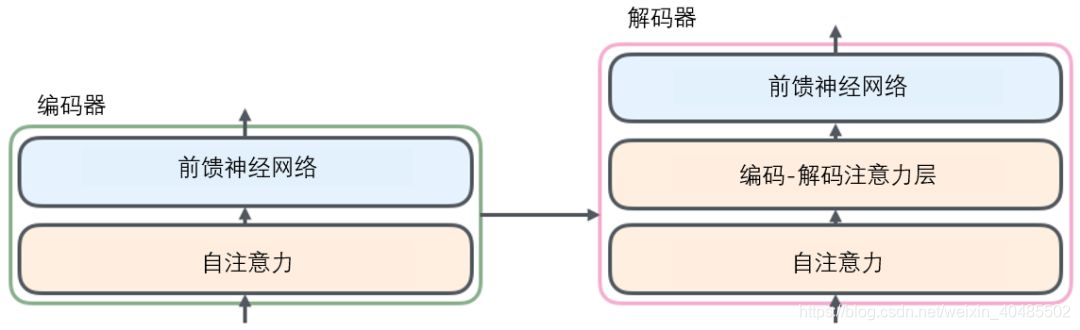

self-attention

- self-attention:Q=Wqx;K=Wkx;V=WvxQ=W_qx;K=W_kx;V=W_vxQ=Wqx;K=Wkx;V=Wvx

-

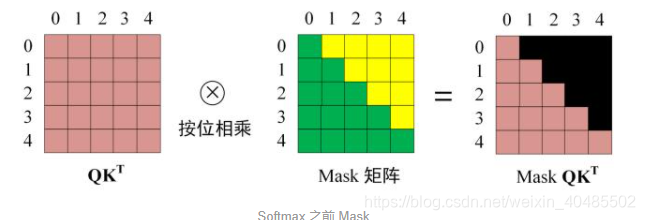

Mask:解码第i个单词,只知道第i-1及之前的信息,然后与self-attention 一致

- 被mask的为1:因为att+softmax之后会变成0

- 被mask的为1:因为att+softmax之后会变成0

-

encoder-decorder Attention

- K,V使用encoder,Q用上一层的输出

-

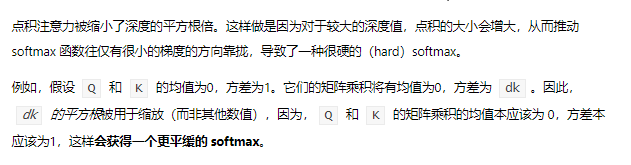

除根号:

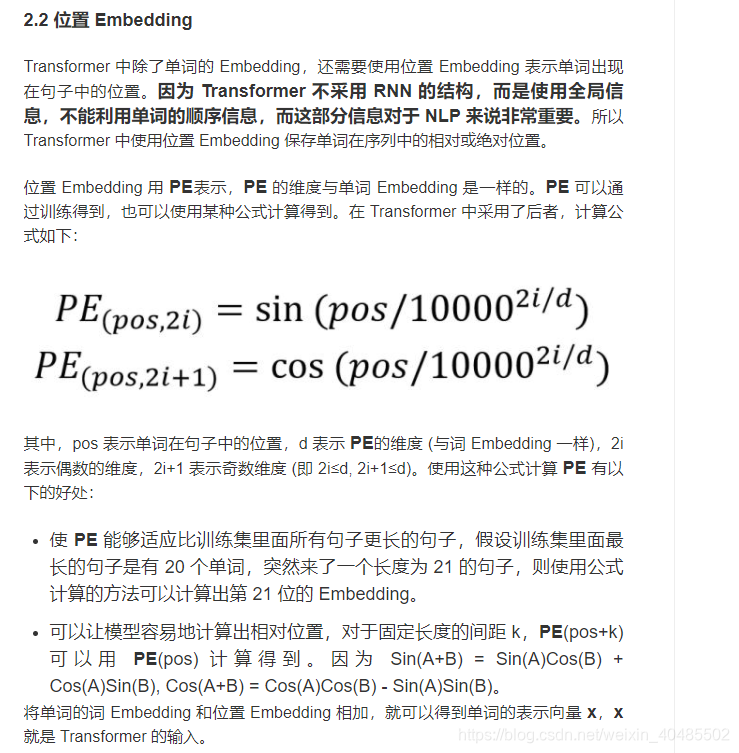

1.1 PE

1.2优点

- 并行

- 无PE则是词袋模型

- 重点self-attention

set transformer

1.1 19年ICML::Set Transformer: A Framework for Attention-based Permutation-Invariant Neural Networks

- problem:set-input

- 需求:

- 排列不变性

- 可输入任意尺寸集合

- 与transformer区别:

- 不输入PE

- decoder第一个self-attention改为:pooling

- 公式

- SAB(X)=MAB(X,X)SAB(X)=MAB(X,X)SAB(X)=MAB(X,X)–说是set attention实际是self-attention?$

- 时间复杂度O(n^2)$

- 改进,降低空间复杂度ISAB(X)=MAB(X,H)∈Rn×dwhereH=MAB(I,X)∈Rm×d,I是可训练参数ISAB(X)=MAB(X,H)\in R^{n\times d}\\ where H=MAB(I,X)\in R^{m\times d},I是可训练参数ISAB(X)=MAB(X,H)∈Rn×dwhereH=MAB(I,X)∈Rm×d,I是可训练参数

- 时间复杂度O(mn)O(mn)O(mn)

- 降维了大概

- Pooling,可训练的:PMAk(Z)=MAB(S,rFF(Z)),S∈Rk×d,Z是encoder的输出PMA_k(Z)=MAB(S,rFF(Z)),S\in R^{k\times d},Z是encoder的输出PMAk(Z)=MAB(S,rFF(Z)),S∈Rk×d,Z是encoder的输出

- SAB(X)=MAB(X,X)SAB(X)=MAB(X,X)SAB(X)=MAB(X,X)–说是set attention实际是self-attention?$

1.2 pool:另一种pool的方式

- code

- ICLR2020: FSPOOL: LEARNING SET REPRESENTATIONS WITH FEATUREWISE SORT POOLING

- loss:排序后可用 MSE

1.2.1集合输出的损失函数

- 都具有排列不变性

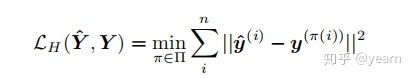

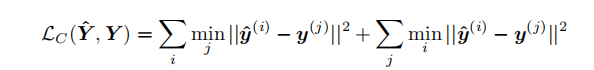

- O(n3)O(n^3)O(n3)的匈牙利算法:找最优匹配

- Joint Entity and Relation Extraction with Set Prediction Networks用的也是这个?

- Joint Entity and Relation Extraction with Set Prediction Networks用的也是这个?

- O(n^2):找最像的

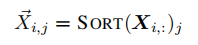

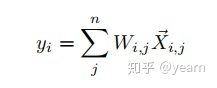

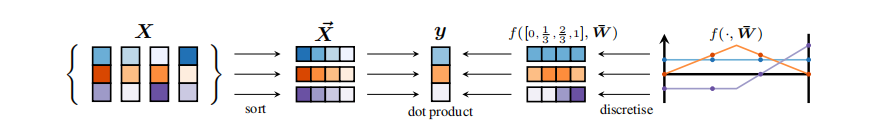

1.2.2排序使得模型具备排列不变性:feature sort pooling

- 先对每一维度的特征排序,将排序后的特征加权求和。

- 排序后就无需再计算loss前进行分配,而分配的复杂度高

- why 按行排序???为什么不对object排序??

- 因为这样可以忽略object的个数问题。

1.2.2.1 fixed-size sets

- 先按行排序(对特征排序),这样每一列不能单独代表一个object,但是特征是解耦的,所以排序不会丢失信息

- 排序不可微分,但可以梯度反传(像最大池化一样)

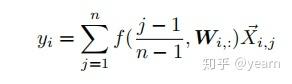

1.2.2.2 VARIABLE-SIZE SETS

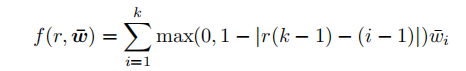

- W:是个固定长度的向量

1.2.3 decoder

- 自编码器,使用逆排序对齐x

- loss

1.2 对抗学习的set transformer:loss

- ICML2020 Spotlight:Generative Adversarial Set Transformers

- 用对抗学习充当loss

参考

【1】transformer

【2】set transformer

【3】fs pool