文章目录

- 模板的简述

- 简述

- 1.Introduction

- 2. preliminatries

- 2.1 literature review

- 2.1.1 knowledge graph embedding

- 2.1.2 Conventional Entity Alignment

- 2.1.3 embedding-based entity alignment

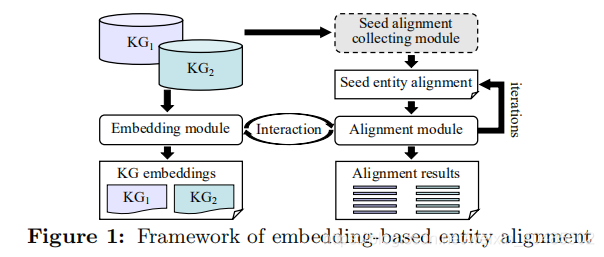

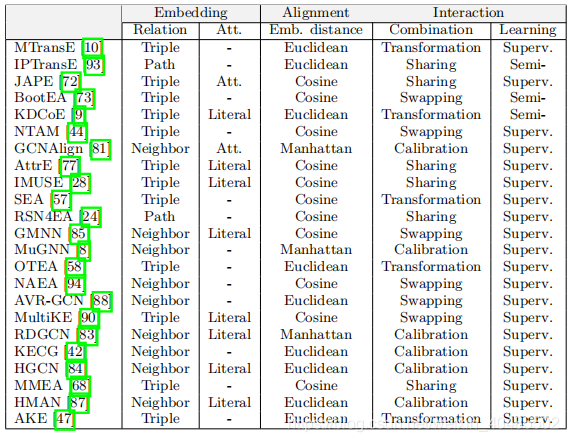

- 2.2 Categorization of Techniques

- 2.2.1 Embedding Module

- 2.2.1.1 关系嵌入

- 2.2.1.2 属性嵌入

- 2.2.3Interaction Mode

- 2.2.3.1 Combination mode

- 2.2.3.2 learning

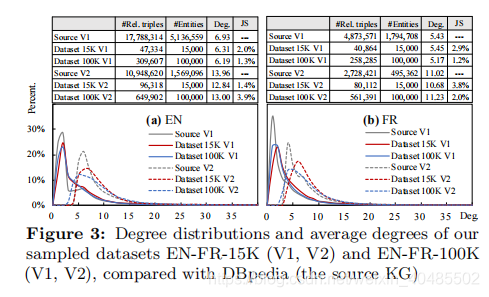

- 3.dataset generation

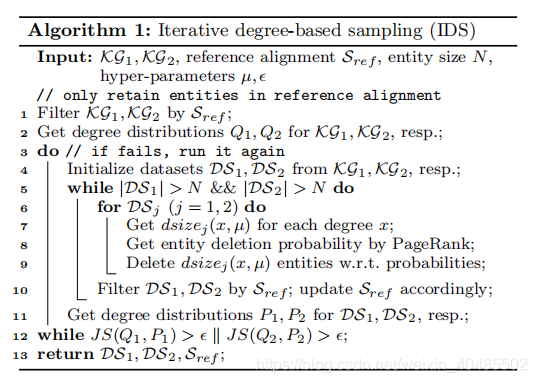

- 3.1IDS(Iterative Degree-based sampling

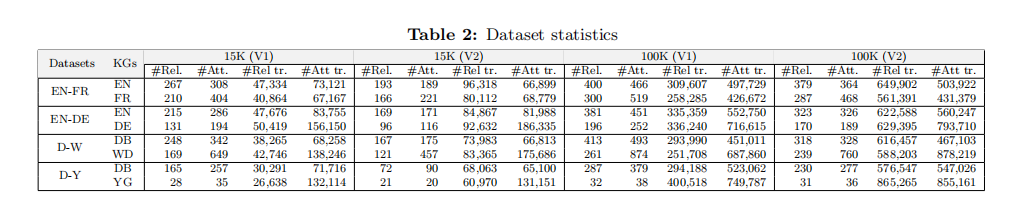

- 3.2 data overview

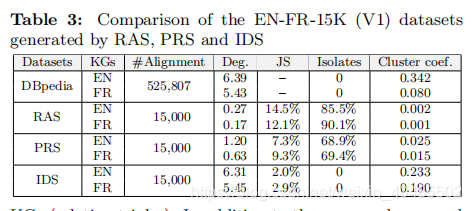

- 3.3 Dataset Evaluation

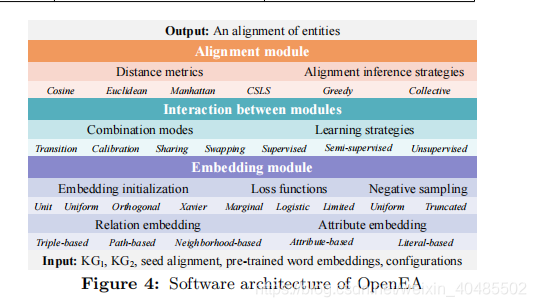

- 4. Open-source Library

- 5.实验

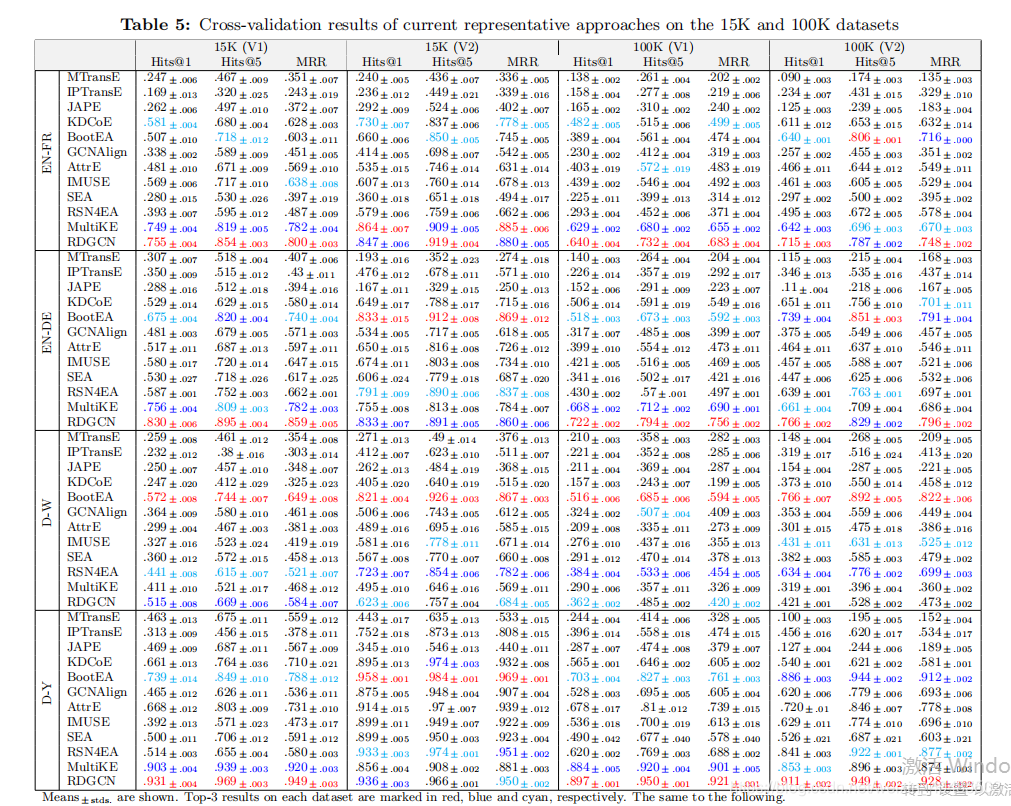

- 5.2 主要结果

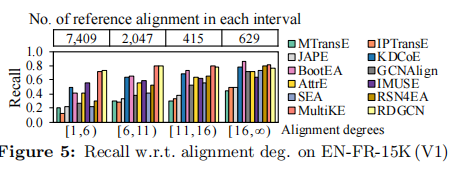

- 5.2.1 稀疏vs稠密

- 5.2.2 15K datasets vs. 100K datasets

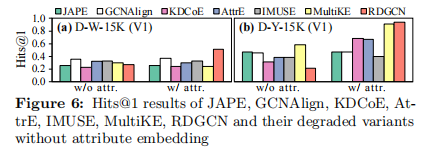

- 5.2.3 关系和属性

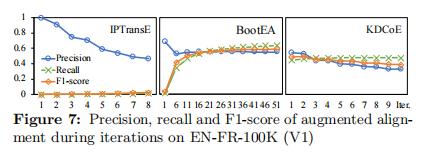

- 5.2.4 半监督

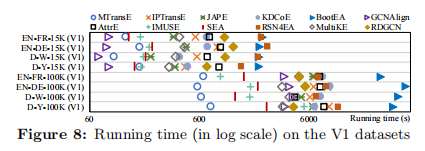

- 5.2.5速度

- 6.探索性实验

- 6.1几何分析

- 6.1.1 相似性分布

- 6.1.2 Hubness and Isolation

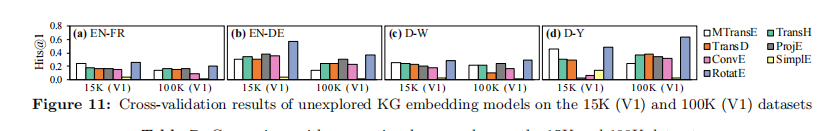

- 6.2 Unexplored KG Embedding Models

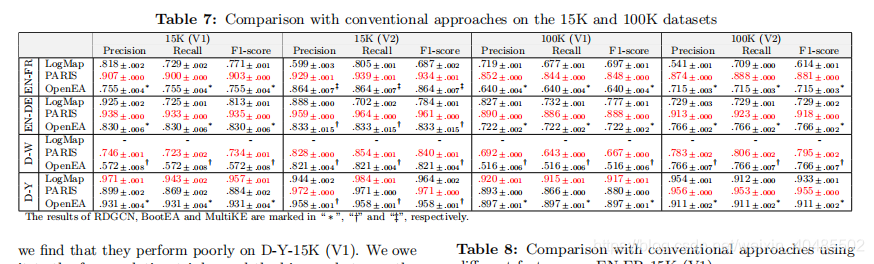

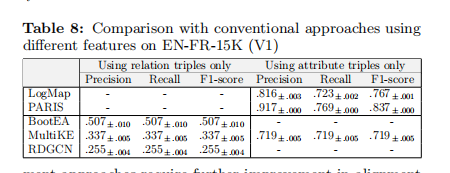

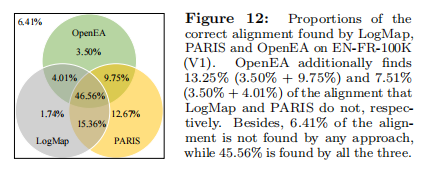

- 6.3 传统方法比较

- 7.总结

- 7.2 方向

模板的简述

- 推荐结论:

- 有开源的OpenEA组件库可自由组和pipeline

- 有IDS,可用来采样训练集,保持分布一致

- 短评

- 优点:开源,分析透彻

- 缺点:比较的传统方法为什么是11/12的?还有一部分比不过人家

- 不过传统方法对稀疏数据集支持非常不好 (我们的场景应该是稀疏的)

- 类别:

- 实体对齐

- 基于embedding的实体对齐

- 综述

- pipeline组件库

- 数据集:

- 自己提出的:EN-FR(15K/100K/V1/V2)–实验用的这个

- 英语、德语

- 自己提出的:EN-FR(15K/100K/V1/V2)–实验用的这个

- 图谱

- wikidata/DBpedia/yago3

- 规模:15K/100K–候选实体也差不多这么多

- 但transE可用在整个图谱上

- GCN用在大的上不行

- 所以数据集的规模这么大点

- 部分方法有负采样(BootEA),会自己增加负例?

- 底层模型:

- transE系列

- GCN系列

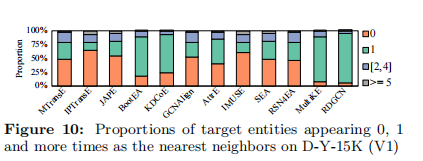

- Hubness

- Isolation

- 监督、半监督

- 关系嵌入、属性嵌入(文本嵌入)

- 速度

- 纯关系嵌入的快,但效果差

- 辅助信息提升效果,但也增加运行时间

- MultiEA:在两者之间均衡(其他都不是均衡的)

- 开源软件情况:有个组件库code

- 评估质量:-

简述

- 提供了OpenEA:开源的组件库(这一系列的方法都可以用这些拼接)

- IDS:一种保证数据集和原数据分布相同的采样方式 稠密数据:

- TransE在稠密数据上不好,但在稀疏数据上也一般,大多使用Embedding的方法在稠密上更好 关系多肯定更好

- 长尾实体

* 大多表现都不好

* Literal特征可以缓解这个不平衡

* 额外引入的属性值信息没有用 - 速度

- 额外引入信息:提升效果,速度也变慢 MultiEA平衡了两者

非欧的Rotate来做嵌入,比TransE好;TransH比TransE好

- 额外引入信息:提升效果,速度也变慢 MultiEA平衡了两者

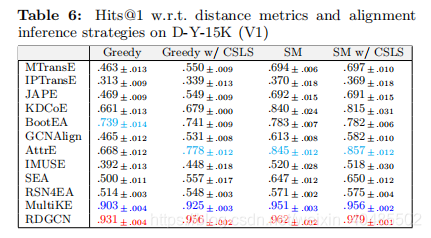

- 传统方法好于嵌入的方法,但是OpenEA+CSLS后能超过传统方法 但是他比较的Paris(2011)和LoMap(2012)比较古老

- 最近没有用GCN、TransE以外方法做的?

- 缓解hubness和isolate

- Stable match

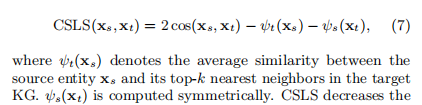

- CSLS:metrics

- 实体对齐的性能 顶部近邻的相似度 近邻相似度的差异 hubness和Isolation分析

- 有效的技术

- 负采样

- bootstrapping

- 去除错误的半监督self-training

- CSLS/SM

code

1.Introduction

- 三元组

- (头实体,关系,尾实体)

- (头实体,属性,literal value)

- 实体对齐

- 在不同KG中的相同实体对齐(名字可能不同,但指代的是一个东西)

- 传统方法:利用实体的特征(名称、描述性注释、关系结构)

- 难点:不同KG不同:符号、语言和结构异构性

- embedding-based 实体对齐

- 将实体、关系等映射到低纬向量,蕴含语义信息通过空间中的几何特征表示。

- 嵌入与对齐模型之间的交互

- 1)两个KG分别训练向量,对齐模块学习两个KG的映射

- 2)在一个空间里表示两个KG的嵌入向量(通过seed alignment保证非常相似的嵌入)

- 相似度度量

- cos

- 欧几里得

- 训练

- 有监督

- 半监督:迭代扩展seed

- 优点:克服seed alignment的短缺

- 优点:

- 减轻异构性

- 简化知识推理

- 缺点

- 基于关系的方法:在处理长尾不行

- 基于属性的方法:难以解决属性值的异质性

- seed alignment

- 使用owl:same as links

- 一个小的已经对其的训练集(或者半监督的监督部分

- 贡献

- 调研23中embedding-based实体对齐的方法,并根据其使用的技术和特性分类

- 新的标准数据集

-

- KG取样:新的,保证取样与现实数据集分不一致

- a set of dedicated benchmark datasets with various heterogeneity(异质性) and distributions

for a realistic evaluation

- a set of dedicated benchmark datasets with various heterogeneity(异质性) and distributions

- KG取样:新的,保证取样与现实数据集分不一致

- OpenEA:开源库,12种嵌入的实体对齐方法+评估

- 探索未被探索的方向的分析研究

- 实体嵌入的几何属性,了解其低层连接与最终性能

- 多种KGembedding方法未被引入,引入了8种受欢迎的

- 比较嵌入和传统方法,探寻他们的互补性

- 未来展望

- 无监督实体对齐

- 长尾实体对齐

- 在非欧几里得嵌入空间中的实体对齐

- 大规模实体对齐

- 综合的比较分析

2. preliminatries

2.1 literature review

2.1.1 knowledge graph embedding

- 方法

- translational models

- TransE

- TransH

- TransR

- TransD

- semantic matching models

- DistMult

- ComplEx

- HolE

- SimplE

- RotatE

- TuckER

- deep models

- ProjE

- ConvE

- R-GCN

- KB-GAN

- DSKG

- translational models

- 数据集

- FBK15

- FBK15-237

- WN18

- WN18RR

2.1.2 Conventional Entity Alignment

- 传统方法

- 1)基于等价性的OWL语义推理

-

- 基于相似度(实体的符号特征)

- 最近:统计类机器学习、众包

- 数据集

- OAEI(since 2004)

- 暂且没有embedding方法使用

- OAEI(since 2004)

- 指标:

- p/r/f1

2.1.3 embedding-based entity alignment

- 1)transE系列

- 2)GCN系列

- 3)其他

- 还有一些包含属性、值的嵌入

- 异构网络对齐

- 跨语言映射

- 两个研究:

- [14,52]设计了数据库中基于嵌入的实体解析方法。

- 实体:单词嵌入

- 向量距离:比较

- 缺点:

- 它们假设所有实体都遵循相同的模式,或者属性对齐方式必须是1对1的映射。

- 由于不同的KGs通常使

- 用不同的模式创建,因此很难满足这些要求。

- 因此,它们不能应用于KGs的实体对齐。

- 14:[14] M. Ebraheem, S. Thirumuruganathan, S. R. Joty,M. Ouzzani, and N. Tang. Distributed representationsof tuples for entity resolution. PVLDB,11(11):1454–1467, 2018.

- 54: M. Nickel, L. Rosasco, and T. A. Poggio. Holographic embeddings of knowledge graphs. In AAAI, pages 1955–1961, Phoenix, AZ, USA, 2016. AAAI Press.

- 数据集

- DBP15K

- WK3L

- 问题:分布和真实世界分布很不一样

- 标度:Hits@m,MR,MRR (Hits@1==precision)

2.2 Categorization of Techniques

2.2.1 Embedding Module

- Embedding Module

- 功能:encode KG->低纬向量

- 分类:

- 基于三元组的类型

- relation embedding

- 利用关系学习技术捕获KG结构

- 现有的实体对齐都是用关系嵌入的方法

- attribute embedding

- 利用实体的属性

- relation embedding

- 基于三元组的类型

2.2.1.1 关系嵌入

- 关系嵌入

- 基于三元组的嵌入

- 捕捉到了关系三元组的局部语义信息

- 定义能量函数(如transE)

- transE:ϕ(e1,r1,e2)=∣∣e1+r1−e2∣∣\phi(e_1, r_1, e_2)=||e_1+r_1-e_2||ϕ(e1,r1,e2)=∣∣e1+r1−e2∣∣

- 损失函数

- marginal ranking loss:transE(区分正负例以一个预定义的边界?)

- logistic loss(54,76)

- limit-based loss(73,91)

- 负采样

- uniform negative sampling

- truncated sampling

- 基于路径的嵌入

- 应用关系span在关系路径上长期依赖

- 路径:(e1,r1,e2)和(e2,r2,e3)

- IPTransE(93):多跳抵达==直接路径(优化目标)

- (e1,r1,e2)+(e2,r2,e3)=(e1,r3,e3)

- r∗=comb(r1,r2)r^*=comb(r_1,r_2)r∗=comb(r1,r2)

- 问题:忽视了实体

- RSN4EA(24):=RSNs

- 用RNN去建模实体和关系的序列

- 基于邻居的embedding:GCN

- 由大量实体间的关系构成的子图结构

- GCN:适合建模这种结构

- 多层图卷积层

- H(i+1)=σ(D^−12A^D^−12H(i)W)H^{(i+1)} = \sigma(\hat D^{-\frac{1}{2}}\hat{A}\hat D^{-\frac{1}{2}}H^{(i)}W)H(i+1)=σ(D^−21A^D^−21H(i)W)

- 最近用GCN做对齐的:8,42,81,83,84,85,87

- 基于三元组的嵌入

2.2.1.2 属性嵌入

- 用多种方法加强实体的相似度度量

- Attribute correlation embedding

- Literal emebdding

- Attribute correlation embedding

- 考虑属性之间的相关性

- 属性相关性:共现(共同出现于描述于同一实体中,如经纬度)

- JAPE(72) :

- 假设:相似的实体有相似的属性

- 相似的概率:Pr(a1,a2)=sigmoid(a1⋅a2)Pr(a_1,a_2)=sigmoid(a_1 \cdot a_2)Pr(a1,a2)=sigmoid(a1⋅a2)

- 考虑属性之间的相关性

- Literal embedding

- 将文本值引入到embedding中

- AttrE(77):

- character level encoder:可以处理未见过的值

- 在跨语言模型中失效

- v-词,c_i-字符

- v=comb(c1,c2,...,cn)v=comb(c_1,c_2,...,c_n)v=comb(c1,c2,...,cn)

- character level encoder:可以处理未见过的值

- literals:像实体关系三元组一样处理属性值(用类似的模型,如transE)

- AttrE

2.2.3Interaction Mode

2.2.3.1 Combination mode

- 1)Embedding Space Transformation:

- 其将两个KG嵌入到不同的空间之中,然后通过种子实体对学习一个映射矩阵M

- e2≈Me1e_2 \approx Me_1e2≈Me1

- 2)Embedding Space Calibration:

- 其将KGs嵌入到统一的空间之中,然后使种子实体对之间的距离最小

- min∣∣e1−e2∣∣对每一对(e1,e2)∈SKG1,KG2′min ||e_1-e_2||对每一对(e_1,e_2)\in S'_{KG_1,KG_2}min∣∣e1−e2∣∣对每一对(e1,e2)∈SKG1,KG2′

- 3)Parameter Sharing:

- 直接将对齐的实体对的表示用同一向量表示,相当于将两个知识图谱嵌入到同一空间中了。

- e1=e2e_1=e_2e1=e2

- 4)Parameter Swapping:

- 则将对应的三元组中实体替换成其对应的实体,从而构造出一些新的三元组加入训练集。

- (e1,e2)∈S′,则(e1,r1,e1′)−>(e2,r1,e1′)(e_1,e_2)\in S',则(e_1,r_1,e_1')->(e_2,r_1,e_1')(e1,e2)∈S′,则(e1,r1,e1′)−>(e2,r1,e1′)

2.2.3.2 learning

- 监督

- 大多数

- seed alignment->训练数据

- transformation:seed->M

- calibration:seed->用以使得embedding相似

- 在跨语言KG中失效

- 半监督

- 训练数据=seed+无标注

- self-training(73,93)

- 预测出新的aligment加入seed-alignment:扩充

- co-training(9)

- 2个model,从两个不相交的实体特征学习得到,交替增强彼此的对其学习

- OTEA,KECG:宣称是半监督学习,但没有扩充seed-alignment,不能算标准的半监督

- 无监督

- 没有用于实体对齐的

- 无训练数据

- IMUSE:自称是无监督方法

- 用预处理方法收集具有高字符串相似度的seed alignment

- 嵌入模块仍需要seed

3.dataset generation

- 找到与现实分布相当的dataset

3.1IDS(Iterative Degree-based sampling

- 与真实分布相似

- 实体的度的差异小

- 困难:

- 删除一个实体会改变连通性

- IDS

- 同时从两个KG钟删除了对齐的实体

- pagerank:删除影响小的

- 当前数据集中度度为x的实体的比例,用P(x)表示,不能始终等于原始比例Q(x)。

- desize(x)=μ(1+P(x)−Q(x))desize(x)=\mu(1+P(x)-Q(x))desize(x)=μ(1+P(x)−Q(x))和pagerank一起决定多少度的删除多少个,(是乘,不是函数)

- 散度衡量分布的差别,越小越好JS(Q,P)=12(Q(x)logQ(x)M(x)+P(x)logP(x)M(x)),M=P+Q2JS(Q,P)=\frac{1}{2}(Q(x)log\frac{Q(x)}{M(x)}+P(x)log\frac{P(x)}{M(x)}),M=\frac{P+Q}{2}JS(Q,P)=21(Q(x)logM(x)Q(x)+P(x)logM(x)P(x)),M=2P+Q

- 优点:同时考虑两个KG的度分布–两个KG中都有相似的聚类系数(这很难)

3.2 data overview

- 数据

- 数据源:

- DBpedia,

- 英法,英德

- wikidata,

- Yago3

- DBpedia,

- 棘手:

- 上述三者来源相近(wikipeidia),有相同的标签,成为实体对齐的棘手特征,影响实际性能

- 15K:μ=100\mu=100μ=100

- 100K:μ=500\mu=500μ=500

- V1:IDS

- V2:低度删除,使平均度翻倍,再IDS—稠密

- 划分:训练、预测。估计

- 数据源:

3.3 Dataset Evaluation

-

实体对齐的数据集要求

- 分布相似

- 足够的对齐数据

- 良好的连通性(因为是图方法)

-

baseline

- Random alignment sampling(RAS)

- 首先随机选择两个KG之间的实体对准的固定大小(例如,15K),然后提取头和尾实体都在采样实体中的关系三元组。

- Pagerank-based sampling(PRS)

- 一个kg里获取pagerank,以此采样实体

- 再从另一个KG中取出他们的伙伴

- Random alignment sampling(RAS)

-

指标

- JS

- 聚类系数(Cluster Coef)

- isolates(孤立实体 )

-

评估结果

- RAS

- 聚类系数低:随机采样不能保持连通性和度分布,

- 孤立实体多

- 不适宜实体对齐

- PRS

- 更关注高度实体、

- 属性好于RAS

- 低平均度,高JS,高isolated–不尽如意

- 它的实体选择过程只适用于一个KG,而不是两个KG

- IDS

- 同时考虑两个KG的度分布–两个KG中都有相似的聚类系数(这很难)

- 同时考虑两个KG的度分布–两个KG中都有相似的聚类系数(这很难)

- RAS

4. Open-source Library

- OpenEA

- python

- tf

- 基于嵌入的实体对齐开源库

- loose Coupling

- pipeline:可组合的组件库

- Functionality and Extensibility

- 基本组件:初始化函数、损失函数和嵌入模块中的负采样方法

- 交互:整合和学习策略

- 对齐:距离和对齐推理策略

- 高级选项:配置功能+调用(自由添加新功能)

- Off-theshelf Approaches

- 实现:

- 基于开源代码实现:MTransE, JAPE, KDCoE, BootEA, GCNAlign,AttrE, RSN4EA, MultiKE and RDGCN

- 自己实现:IPTransE, IMUSE and

SEA - 整合了:

- trans:TransH [82], TransR [49] and TransD等嵌入

- semantic matching model:HolE [54], SimplE [36] and RotatE

- deep model: ProjE [66] and ConvE

- 属性嵌入model: AC2Vec [72]

and Label2Vec(based on pre-trained multilingual word

embeddings)

(TransH、TransR、TrandD和HolE都是通过参考开源工具包OpenKE[27]来开发的;其余的都是基于其源代码来实现的。)

- 实现:

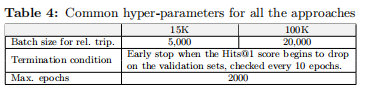

5.实验

5.2 主要结果

- 指标:Hits@1, Hits@5 and MRR

5.2.1 稀疏vs稠密

-

基于关系的方法

- 擅长稠密数据 :

- eg:IPTransE, BootEA, SEA and RSN4EA.

- 稠密数据:中实体参与到更多三元组中,保证模型捉到了更多的语义信息

- 特例:MTransE and JAPE

- 效果在稠密数据中下降了

- transE: 处理密集数据集中的多映射关系方面存在不足。

-

考虑了属性信息

- KDCoE, GCNAlign,AttrE, IMUSE and RDGCN

- 在稠密中更好:关系三元组仍起作用

- 特例:, MultiKE

- 多视角学习,对关系变化不敏感,在稠密和稀疏数据中无差

- 多视角学习,对关系变化不敏感,在稠密和稀疏数据中无差

-

不同度的数据中的效果

- 数据存在长尾关系

- 大多数方法,擅长关系丰富的实体对齐,而不擅长处理长尾实体

- literals:

- 减轻了对不平衡数据的处理偏差

- KDCoE, AttrE, IMUSE, MultiKE and RDGCN

- JAPE and GCNAlign除外:

- JAPE

5.2.2 15K datasets vs. 100K datasets

除了D-Y之外,所有的方法在15K数据集上都比在100K数据集上表现得更好,因为100K数据集有更复杂的结构,给基于嵌入的方法捕获实体接近带来了更多的困难。

100K数据集具有比15K数据集具有更大的候选对齐空间。从更大的候选空间和更多的负情况将目标实体在顶部的排名比较困难。

- 100K难

- 结构复杂

- 候选对齐空间更大

5.2.3 关系和属性

- 纯关系嵌入

- 无明显作用

- MTransE and BootEA both use TransE:但效果天差地别

- BootEA:

- 负采样:只有正例容易过拟合

- MtransE+负采样+marginal ranking loss:提升了0.271

- bootstrapping strategy:也有很大作用(但这个慢)

- 负采样:只有正例容易过拟合

- 关系-path:

- IPTransE

- shallow composition

- RSN4EA

- recurrent skipping network

- 比IPTransE好可能因为这个机制

- IPTransE

- 属性

- 有无属性比较:没什么改进

- 如果没有预对齐的属性,该技术将无法捕获不同KGs之间的属性相关性

- 即使发现了属性相关性,这个信号也太粗粒度,无法确定两个具有相关属性的实体是否对齐。

- Wikidata中属性的符号异质性(例如,属性的本地名称是数字IDs)—难以用属性的方法,影响很大

- Literal

- 比属性有用

- 除了IMUSE

- 他用Literal寻找新的实体对齐来增强训练集

- 新的对齐可能是错的,上海性能

- Literal有更强的信息

5.2.4 半监督

- IPTransE

- self-training:随着训练,引入了一些错误,无消除错误的机制

- KDCoE:

- co-training:用属性和关系这两种正交的特征分别训练两个模型

- 问题:许多实体缺乏文本描述–>没找到新的对齐

- BootEA

- 去错:一种启发式的编辑方法来删除错误的对齐方式。

- 消融:self-trainging能带来0.086 Hits@1

- 半监督的关键

- 增强新增实体对齐的数量和质量

- 更大的精度带来更好的性能

5.2.5速度

- BootEA最慢

- 截断负采样和bootstrapping的时间分别超过23.5%和13.3%。

- RSN4EA

- 多跳路径训练(三元组只有一条路径)

- Literal编码文字信息时间长

- KDCoE和AttrE

- 只用关系:GCNAlign和MTransE快

- 辅助信息:提升性能,增加训练时间

- MultiEA

- 平衡性能和其它

- 平衡性能和其它

6.探索性实验

6.1几何分析

6.1.1 相似性分布

- 在给定实体嵌入时,对齐推理算法通过嵌入空间中的最近邻搜索来识别对齐的实体。

- 发现

- 实体与他们的top-1近邻的相似度–>反映了其实体对齐的能力

- 相似度高,质量高

- 前五个近邻的相似度差异:一个小的相似方差意味着最近邻没有足够的区别,使实体正确识别其对应物。

- 差异小的:

- MTransE中的过拟合问题

- IPTransE中的引导错误

- JAPE:模糊实体簇

- 差异小的:

- 实体与他们的top-1近邻的相似度–>反映了其实体对齐的能力

- 结论

- 实体对齐性能好需要

- 好的顶级相似度

- 较大的相似度方差

- 实体对齐性能好需要

6.1.2 Hubness and Isolation

-

问题

- Hubness:

- 高纬向量的常见问题

- 一些点经常会出现在向量空间中其他许多点的顶级近邻

- isolation

- 将会存在一些与任何点簇分离的异常值

- 对依赖于最近邻搜索[11,55]的任务有负面影响。

- Hubness:

-

实体对齐中

- 多数目标实体不出现在顶级近邻中

- 如果我们使用选择顶级最近邻的贪婪策略来形成对齐,这种孤立的实体可能永远不会被考虑。因此,我们会错过许多正确的实体对齐。

- 存在Hubness,难以1v1

- We observe that the approaches which yield fewer isolated

and hub entities, such as MultiKE and RDGCN, achieve

the leading performance of entity alignment, and vice versa.

-

我们可以通过沉默和隔离分析来估计最终的实体对齐性能。

-

为了解决人们的沉默和孤立的问题

- cross-domain similarity local scaling (CSLS):

-

metric

-

嵌入邻居的密度将源和目标实体嵌入的相似性归一化。

-

CSLS可以提升贪婪匹配的性能

-

优点:

- CSLS减少了中心实体和其他实体之间的相似性。

- 它还可以让一些孤立的实体在测试中被公平地考虑,因为它们通常会受到较少的相似性惩罚。因此,我们使用CSLS来增强传统的距离指标。

- CSLS减少了中心实体和其他实体之间的相似性。

-

余弦

-

稳定的匹配(SM)

- 从全局的角度检索实体对齐,而不是基于最近邻搜索的贪婪策略。

- 稳定:没有更好的对象了

- 用CSLS衡量又没有更好的了

- SM可以考虑所有的实体,包括孤立的实体

- CSLS无法提升SM的性能:因为SM对距离度量的依赖较少。

-

- cross-domain similarity local scaling (CSLS):

6.2 Unexplored KG Embedding Models

- baseline:MtransE

- 用其他trans代替transE

- TransR和Hole的结果被省略了,因为它们在大多数数据集上的1分的命中率小于0.01。—不好用

- TransH和TransD:可以用

- TransH>MTransE

- 负采样

- TransR并没有变好:需要关系对齐

- TransR中实体嵌入的关系特定转换需要关系对齐来传播实体之间的对齐信息。然而,在我们的问题设置中,我们关注实体对齐,并且由于KG模式之间的巨大异质性,我们不提供关系对齐。

- deep:

- ConvE和ProjE也可以用,但有的数据集表现不好

- 因为关系三元组少,且关系数相差巨大

- ConvE的二维卷积或ProjE的非线性变换很难捕获这些异构KGs中实体和关系嵌入之间的相似相互作用。

- ConvE和ProjE也可以用,但有的数据集表现不好

- 语义匹配模型

- Rotate>SimpIE:并且优于其他所有。

- 总结:

- 不是所有方法都可以用来做实体对齐的

6.3 传统方法比较

-

传统方法

- Semantic web:LogMap

- 内置推理

- 不一致性修复能力

- 本体匹配系统

- 数据库社区:Paris

- 基于概率估计来调整KGs的整体解决方案。

- 基于概率估计来调整KGs的整体解决方案。

- Semantic web:LogMap

-

结果

- 各方面都比不过传统方法

- 学习了嵌入表示,但忽略了对齐推理

- 嵌入的对齐推理

- 基于相似度比较

- 缺乏:不一致修复和整体估计

- ---->导致hubness和isolate

- 解决了这个问题,就比传统方法好了

- 符号异质性:给传统方法带来了巨大的障碍

- 比如wikidata没有意义的uri

- 嵌入的对齐推理

-

特征研究

- LogMap和Paris依赖于属性三元组,并且在只使用关系三元组时无法输出对齐

- 只使用属性

- logmap无影响:本来就这么用的

- paris:

- 召回急剧下降,它不能使用关系推理来寻找更多的实体对齐

- 精度很高

- 考虑到paris不是为关系推理而设计的,关系三元组可能给他带入噪声

-

不同的模型有不同的应用场景

-

但是嵌入和传统方法有互补性,可以混合

7.总结

(i)RDGCN,BootEA和MultiKE达到了最具竞争力的性能。这表明,结合文字信息和精心设计的引导可以帮助实体对齐。

(ii)嵌入模型,我们发现并不是所有的它们都适合实体对齐。

(iii)目前,对齐推理策略很少得到关注。我们的初步结果表明,CSLS距离度量和稳定的匹配策略可以提高所有方法的性能。

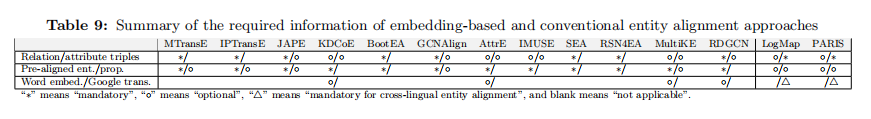

(iv)我们还发现,基于嵌入的和传统的实体对齐方法是互补的。(v)为了根据现实场景中的可用资源来选择适当的方法,表9总结了在我们的实验分析中基于嵌入的和传统的实体对齐方法所需的信息

7.2 方向

- 无监督

- 远程监督

- 长尾

- 更先进的GNN

- 注入更多的特征

- 多模态

- taxonomies

- KG还不完整

- 链路预测+实体对齐联合训练

- 从开放网络提取额外的信息

- 大规模实体对齐

- 数据集大,花费时间长

- 多项式增长

- 嵌入的方法难以在很大KG上运行

- 阻塞技术,如局部敏感的哈希[21]和哈希表示学习[45],可能有助于缩小候选空间。

- 非欧几里得模型

- Rotate优于其他

- 可能有效