Yang Lu , Yiu-ming Cheung , Yuan Yan Tang. Dynamic Weighted Majority for Incremental Learning ofImbalanced Data Streams with Concept Drift. In Proceedings of the Twenty-Sixth International Joint Conference on Artificial Intelligence (IJCAI-17)

论文链接:http://www.ijcai.org/proceedings/2017/0333.pdf

数据流中发生的概念漂移将降低在线学习过程的准确性和稳定性。如果数据流不平衡,检测和修正概念漂移将更具挑战性。目前已经对这两个问题分别进行了深入的研究,但是还没有考虑它们同时出现的情况。在本文中,作者提出了一种基于块的增量学习方法,称为动态加权多数增量学习(DWMIL)来处理具有概念漂移和类不平衡问题的数据流。DWMIL 根据基分类器在当前数据块上的性能,对基分类器进行动态加权,实现了一个整体框架。

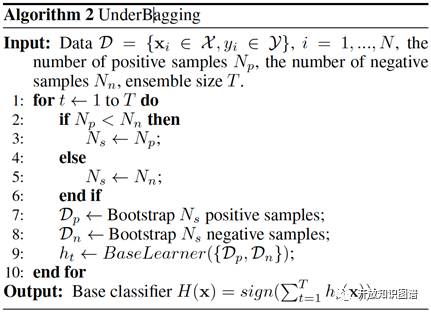

Algorithm & Ensemble Framework:

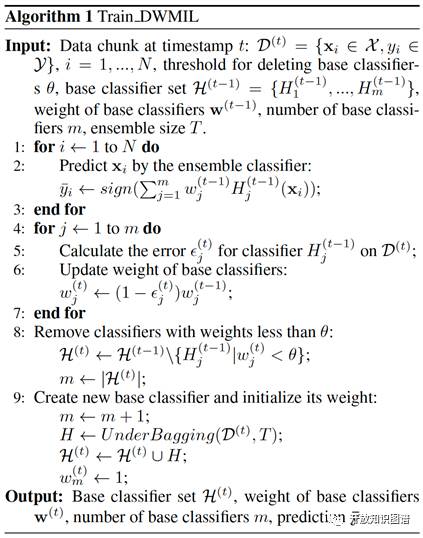

算法的输入:在时间点 t 的数据 D^(t)={xi belongs to X,yi belongs to Y}, i=1,...,N, 删除分类器的阈值 theta, 基分类器集合 H^(t-1)={H^(t-1)_1,...,H^(t-1)_m}, 基分类器的权重 w^(t-1), 基分类器的数量 m, 集成的规模大小 T。

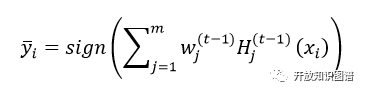

step 1: 通过集成分类器对输入的进行预测

step 2: 计算当前输入的数据块在基分类器上的错误率 epsilon^t_j, 并更新基分类器的权重

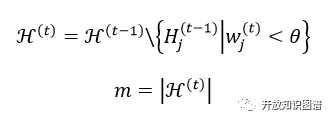

step 3: 移除过时的分类器(权重值小于阈值 theta)并更新基分类器数量

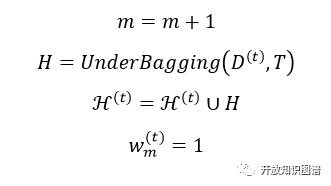

step 4: 构建新的分类器并对其初始化

算法的输出:更新的基分类器集合 H^(t), 基分类器的权重 W^(t), 基分类器的数量 m, 目标预测值 bar_y。

本文的算法如下图所示:

Experiments:

本文选取了4个合成、2个真实的均具有概念漂移的数据集。并且在集合方法、自适应方法、主动漂移检测方法中各选取了一个具有代表性的作为baseline,分别是:Learn++.NIE(LPN)、Recursive Ensemble Approach (REA)、Class-Based ensemble for Class Evolution(CBCE),并与Dynamic Weighted Majority (DWM)也进行了比较。对具有概念漂移的合成数据集和实际数据集的实验表明,DWMIL与现有技术相比,性能更好,计算成本更低。

Comparisons:

与现有方法相比,其优点在于以下 4 点:

能够使非偏移的数据流保持稳定,快速适应新的概念;

它是完全增量的,即不需要存储以前的数据;

模型中保持有限数量的分类器以确保高效;

简单,只需要一个阈值参数。

DWMIL与DWM相比:

在学习数据流的过程中,DWMIL和DWM都保留了一些分类器。但是,

在决定是否创建一个新的分类器时,DWM的依据是单个样本的预测性能。如果数据不平衡,则样本属于多数类的概率比少数类的高得多,并且对多数类样本错误分类的概率较低。因此,DWM在不平衡数据流上创建新分类器的机会很低。事实证明,它可能无法有效地适应新的概念。相比之下,DWMIL为每个数据块创建一个新的分类器,以及时学习新的概念。

在决定是否移除一个过时或低效的分类器时,DWM中分类器的权重通过固定的参数β减少,并且在归一化之后再次减小。相反,DWMIL根据性能降低了权重,没有任何标准化。因此,如果当前概念与创建分类器的概念类似,则分类器可以持续更长时间来对预测做出贡献。

DWMIL与Learn++相比:

Learn++和DWMIL都是为每个数据块创建分类,并使用分类错误率来调整权重。但是,

关于降低在过去的数据块上训练的分类器的权重这一问题,Learn++使用了时间衰减函数σ。这个σ取决于两个自由参数:a和b,其中不同的值会产生不同的结果。在DWMIL中,减重仅取决于没有自由参数的分类器的性能。

关于分类器权重的影响因素,在Learn++中,权重不仅取决于当前数据块,还取决于创建的分类器到当前数据块的数据块。在这种情况下,可能会产生偏差。具体来说,如果一个分类器在其创建的数据块上表现得非常好,它将在接下来几个数据块中持续获得更高的权重。如果概念发生变化,那么在旧概念上训练的分类器的高权重将降低预测效果。

关于分类器的性能,Learn++会保留所有的分类器。如果数据流很长,累积的分类器会增加计算负担,因为它需要评估当前分块上所有过去的分类器的性能。相比之下,DWMIL放弃了过时或无用的分类器来提高计算效率。

笔者认为,这篇文章的主要创新点在于:用数据块的输入代替传统的单一样本输入,使得模型可以更快地对概念漂移作出反应;通过对分类器性能的检测,动态调整它们的权重,并及时剔除过时或低效的分类器,使得模型比较高效。

本文作者邓淑敏,浙江大学计算机学院2017级直博生,研究兴趣为知识图谱,描述逻辑,ontology stream。

OpenKG.CN

中文开放知识图谱(简称OpenKG.CN)旨在促进中文知识图谱数据的开放与互联,促进知识图谱和语义技术的普及和广泛应用。

转载须知:转载需注明来源“OpenKG.CN”、作者及原文链接。如需修改标题,请注明原标题。

点击阅读原文,进入 OpenKG 博客。