摘要

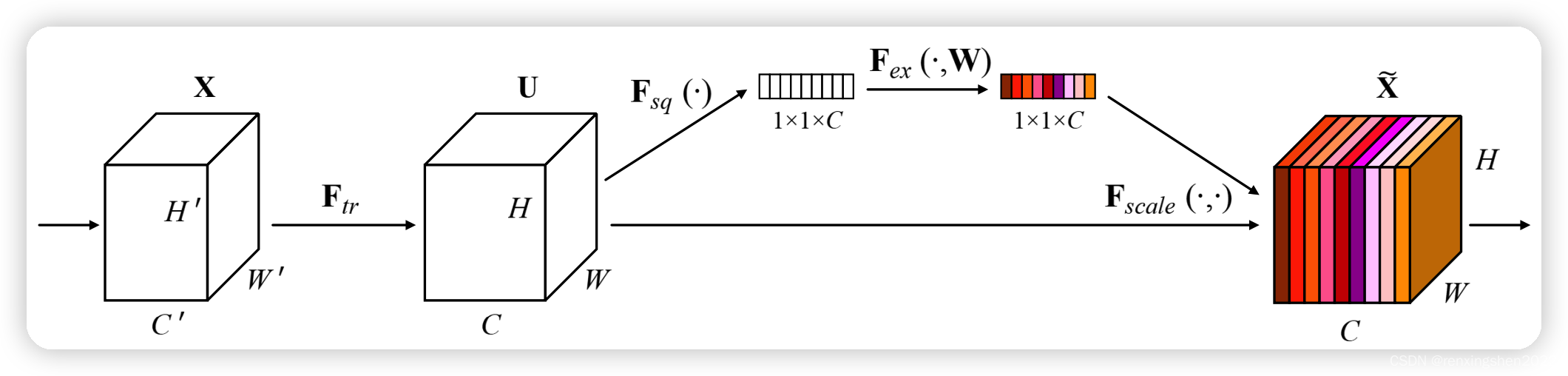

SE注意力机制是一种通过显式建模卷积特征的信道之间相互依赖性的方法,旨在提高网络产生的表示的质量。SE注意力机制包括两个步骤:Squeeze和Excitation。在Squeeze步骤中,通过全局平均池化操作将输入特征图压缩成一个向量,然后通过一个全连接层将其映射到一个较小的向量。在Excitation步骤中,使用一个sigmoid函数将这个向量中的每个元素压缩到0到1之间,并将其与原始输入特征图相乘,得到加权后的特征图。通过SE注意力机制,模型可以自适应地学习到每个通道的重要性,从而提高模型的表现能力。

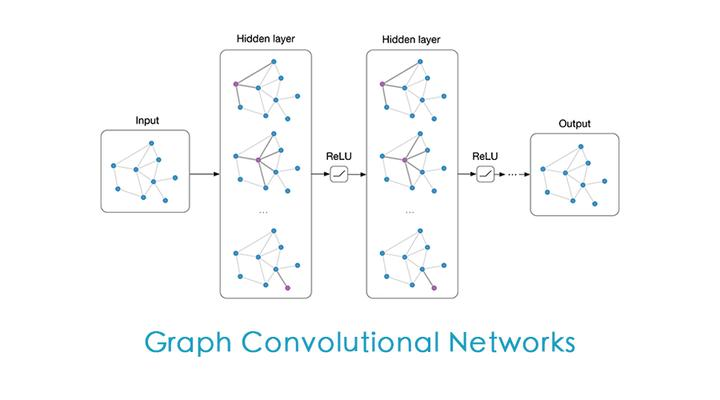

图卷积是一种用于处理图结构数据的卷积操作。与传统的卷积操作不同,图卷积的输入是一个图形,包含节点和边,而不是一个二维或三维的张量。图卷积的目的是通过学习节点之间的关系来进行特征提取和分类等任务。具体来说,图卷积可以聚合邻近节点的特征,对更新后的节点特征进行激活函数操作,从而进行特征提取和分类。

我们将二者结合会怎么样呢?

图卷积的SE注意力机制

代码如下:

class SELayer