论文笔记整理:朱珈徵,天津大学硕士,自然语言处理方向。

链接:https://arxiv.org/pdf/1912.08441.pdf

动机

反向词典将一段描述作为输入,并一起输出与该描述匹配的其他词,具有重要实用价值和自然语言处理研究价值,例如有助于解决舌尖现象。但现有的反向词典方法不能很好地处理高度多样化的输入问题且存在大量低频词,因此受人从描述到词的这一推理过程的启发,作者提出了多通道反向词典模型,可以同时缓解这两个问题。模型提供了一个句子编码器和多个预测器。预测器将从输入的描述中识别目标词的不同特征。作者在英汉数据集上评估了文中的模型,包括字典的定义和人类的书面描述,表明该模型达到了目前最先进的性能,甚至在人类书面描述数据集上超过了最流行的商业反向字典系统。

亮点

(1)基于人的描述-词的推断过程,作者提出了多通道反向词典模型,包含多个预测器,每个特征预测器都被视为搜索目标词的信息通道,且分为两个类型:内部通道和外部通道。内部通道与词本身的特征相对应,包括词性标记和语素;外部渠道则反映了与外部知识库相关的目标词的特征,如词类、义原。

(2)作者通过对模型的调试,解决了一词多义的词典任务以及高频和低频单词很难预测等难点,在真实场景数据集实现了当前最佳性能且具有相当良好的稳定性和鲁棒性。

方法及模型

基本框架

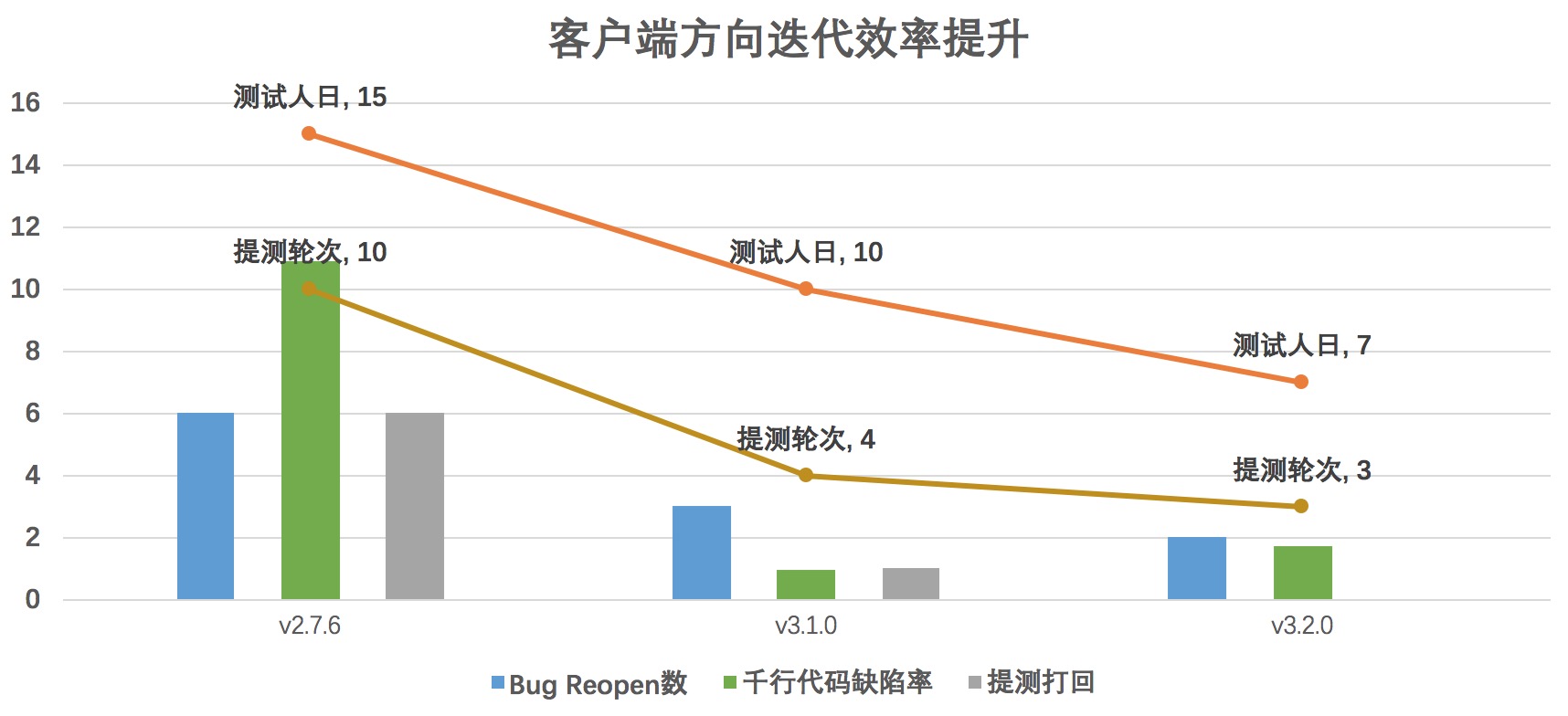

该模型的基本框架与句子分类模型基本相似,由一个句子编码器和几个预测器组成,其整体框架如下图所示。作者选择双向LSTM (Bi-LSTM)作为句子编码器,它将一个输入的问题编码为一个向量。在一个句子中,不同的词对句子的表现有不同的重要性,因此,作者将注意机制整合到Bi-LSTM中来学习更好的句子表示。

形式上,对于输入的问题 Q={q1,...,q2}, 然后将预训练好的 q1,...q_|Q| 得词向量输入Bi-LSTM,其中d为词向量的维数,得到了两个隐藏方向状态的序列:

然后将双向隐藏状态连接,得到无方向隐藏状态以及最后无方向性隐藏状态加权和的句子表示。

其中αi作为注意力的权重:

接下来将输入问题的句子向量v映射到词向量空间中,使用点积计算每个单词的置信分数:

其中sc_{w,word}表示w的置信分数,W_word 是权值矩阵,b_word 是偏置向量

预测器

预测器主要分为两个通道,共有四种类型,其中内部通道有POS标签预测器及语素预测器,外部通道有词类预测器及义原预测器。

1、内部通道: POS标签预测器

字典定义或人写的对一个词的描述通常能够反映该词相应意义的词性标签。作者认为,预测目标词的词性标签可以缓解现有逆向词典模型中返回词性标签与输入查询相矛盾的问题,所以作者将输入问题v的句子向量传递给单层感知机,并将得到某个词w对POS标签的预测得分之和作为该词在POS标签预测器上的置信得分:

其中记录每个POS标签的预测得分,

为权值矩阵,

为偏置向量,

返回

的POS标签索引。

2、内部通道: 语素预测器

大多数单词是由一个以上语素组成的复合词。词语的语素与词语的定义或描述之间存在着一种局部语义对应关系。逆向词典通过输入问题来预测目标词的语素,从而获取目标词的组合信息,并补充了词向量的上下文信息。作者设计了一个特殊的语素预测器,与POS标记预测器不同,它允许每个隐藏状态直接参与语素预测,并进行最大池运算获得最终的语素预测分数。具体来说,我们将每个无方向性隐藏状态输入到一个单层感知器中,得到局部语素预测分数,然后对所有局部语素预测分数进行最大池化,得到全局语素预测分数

,最后得出语素预测器对某个词w的置信度得分

3、外部通道: 词类预测器

语义相关的词尽管它们有紧密的词向量,但是通常属于不同的类别,如“car”和“road”。词汇类别信息有助于从反向词典的结果中剔除语义相关但不相似的词。基于此作者设计了一个层次预测器来计算词类的预测分数

具体地说,每个词在词的层次结构的每一层都属于一个特定的范畴,所以计算各层的单词类别预测得分,则某个词w在词类预测器上的最终置信度得分

为其在各层类别预测得分的加权和:

4、外部通道: 义原预测器

在语言学中,义原是自然语言的最小语义单位,知网(HowNet)是目前世界上最著名的义原知识库。它定义了大约2000个义原,并用它们手工注释了10万多个中文和英文单词,被广泛应用于各种自然语言处理任务。知网中词语的义原标注既包括义原的层次结构,也包括义原与义原之间的关系。为简单起见,我们为每个词提取一组非结构化义原,在这种情况下,一个词的义原可以看作是该词的多个语义标签。

作者发现,词汇的义原与词语的描述也存在着局部语义对应关系。因此,设计了一种与语素预测器相似的义原预测器。用S来表示所有义原的集合,Sw为单词w的义原集合,将每个隐藏状态传递给一个单层感知器来计算局部义原预测分数,通过最大池化得到最终的义原预测分数

,最后从义原预测器得到单词w的置信度得分

。

多通道反向词典模型

结合直接词预测中的句子编码器和间接特征预测中的预测器得到的置信度得分,得到多通道反向词典模型中给定词w的最终置信度得分:

其中 C = {pos, mor, cat, sem} 是各个通道的输出数据,λ_word 和 λ_c 为控制相应项相对权重的超参数。

实验

作者将本文中的多通道反向词典模型与其他反向词典模型的性能和鲁棒性进行比较,进行了详细的定量分析和案例研究,来探讨影响反求字典任务的因素,并展示了该模型的优点和缺点。实验中的评价指标主要有三个:目标词的中位排名(越低越好)、目标词出现在top 1/10/100的准确率(越高越好)、目标词排名的标准差(越低越好)。

上表展示了所有模型在三个测试集上的反词典性能,其中“Mor”、“Cat”和“Sem”分别代表语素、词类和义原预测器。从表中可以看出:

1、与除OneLook之外的所有基准方法相比,文中的多通道模型在无定义数据集和描述集上取得了显著的性能提升,验证了该模型在推广到新的输入问题上的绝对优势。

2、当输入问题是字典定义时,OneLook的性能显著优于我们的模型。这个结果是预期的,因为输入字典定义已经存储在OneLook的数据库中,即使简单的文本匹配也可以轻松处理这种情况。但是,反向字典的输入问题实际上不可能是精确的字典定义。在描述集上,多通道模型取得了比单视图更好的整体性能。

3、MS-LSTM在可见定义集上表现良好,在描述集上表现较差,说明其泛化能力和实用价值有限。

4、通过各预测器加强的BiLSTM变体(+Mor、+Cat、+Sem)均优于BiLSTM。这些结果证明了在反向词典任务中预测目标词特征的有效性。与单通道模型相比,多通道模型的性能得到了进一步的提高,证明了特征融合的有效性,也验证了多通道模型的有效性。

5、BOW表现优于RNN,然而BiLSTM远远超过BOW和RNN。这验证了在神经网络模型中进行双向编码的必要性,也表明了神经网络的潜力。

此外作者还对进行了鲁棒性方面的实验,上图为各模型分别对不同义项数量、词频和查询长度这三个影响因素的实验。

首先在义项数方面,所有模型的性能都随着义项数的增加而下降,说明一词多义是反向词典任务中的难点。但多通道模型表现出了出色的鲁棒性,即使在最具意义的词语上,其性能也几乎没有下降;

其次在词频因素上,尽管最频繁和最不频繁的单词都很难预测,但模型仍有着非凡的稳定性;

最后在查询长度上,当输入只有一个词时,各个系统的性能都较差,是因为从输入查询中提取的信息非常有限,但模型仍在输入超过两个词时的性能较为优越。

总结

在文章中,作者创新地提出了一个多通道反向词典模型,该模型包含多个预测器来预测给定输入查询的目标词的特征。实验结果和分析表明,文章提出的模型达到了最先进的性能,并具有良好的鲁棒性。

OpenKG

开放知识图谱(简称 OpenKG)旨在促进中文知识图谱数据的开放与互联,促进知识图谱和语义技术的普及和广泛应用。

点击阅读原文,进入 OpenKG 博客。