笔记整理 | 赖泽升,东南大学本科生

来源:ACL2019

动机

先前实体链接的大多数工作都着重于与通用实体数据库的链接,通常希望链接到专门的实体词典,例如法律案件,公司项目描述,小说中的字符集或术语表。

但这些工作的不足之处在于,对于这些专用实体词典,带标签的数据不易获得,而且获取起来往往相当昂贵。

因此,为了解决上述问题,论文提出了一种新的实体链接模型,以将其推广到看不见的专业实体。但是,该任务的难度在于:在没有可用的完整别名表或频率统计数据和元数据的情况下,模型必须阅读实体描述并推断实体mention与其上下文的对应关系;由于带有标签的mention对于测试实体是不可用的,因此模型必须适应新mention的上下文和实体描述。

为了解决上述难题,论文提出了一种新的预训练模型DAP,去解决如何将不可见的实体链接到一个新的领域的问题,从而完成零样本的实体链接任务。

贡献

文章的主要贡献:

(1)提出了一个新的零样本实体链接任务,旨在以最小的假设条件下,挑战实体链接系统的泛化能力。并且为此任务构建了一个数据集,该数据集将公开提供。

(2)通过使用最前沿的阅读理解模型为实体链接任务来建立强大的基准。此外,论文还发现上下文和实体描述之间的attention对于此任务至关重要,而在以前的实体链接工作中并未使用attention。

(3)提出了一种简单但新颖的适应策略,该策略称为领域自适应预训练策略(DAP),并通过实验表明它可以进一步提高实体链接的性能。

模型

论文将实体链接任务分为两个阶段,第一阶段是快速产生候选实体,第二阶段是对每个候选实体计算得分,选出得分最高的即为目标实体。

对于第一阶段,论文使用BM25(TF-IDF的一种变体)来衡量mention字符串和候选文档之间的相似性。通过Lucene的BM25评分检索到的前k个实体用于培训和评估。在论文的实验中,k设置为64。排名前64位的候选实体的平均覆盖率小于77%。这说明任务艰巨,并且在候选实体生成阶段仍有很大的改进空间。

对于第二阶段,论文中使用了基于Transformer结构的BERT。在BERT中,mention用m表示,候选实体的描述用e表示,两者都由128个词标记表示,被连接起来并作为序列对连同特殊的开始和分隔符一起输入到模型中: Mention中的单词被特殊的嵌入向量标记,该向量被添加到mention的单词嵌入中。Transformer编码器对输入的信息产生向量hm,e,它是最后一个隐藏层输出的特殊表示。在候选实体集合中,每一个实体的得分由公式:

Mention中的单词被特殊的嵌入向量标记,该向量被添加到mention的单词嵌入中。Transformer编码器对输入的信息产生向量hm,e,它是最后一个隐藏层输出的特殊表示。在候选实体集合中,每一个实体的得分由公式: 得出,此处的

得出,此处的 是经过学习的参数向量。选出得分最高的候选实体即为目标实体。该模型的训练方法是使用softmax loss。在论文中,使用了具有12层,隐藏层数为768和12个attention的体系结构,此结构模型称为Full-Transformer。

是经过学习的参数向量。选出得分最高的候选实体即为目标实体。该模型的训练方法是使用softmax loss。在论文中,使用了具有12层,隐藏层数为768和12个attention的体系结构,此结构模型称为Full-Transformer。

为了评估这种新颖模型的价值,论文中还使用了Full-Transformer两个变种模型作对比实验。一个被称为Pool-Transformer,原理是分别将mention和候选实体描述输入到Transformer中,在最后的隐藏层分别输出hm和he。该mention和候选实体之间的相似度用公式: 计算,然后选出得分最高的候选实体。另外一个被称为:Cand-Pool-Transformer,原理是使用单个向量表示实体,但可以单独使用mention及其上下文。该模型还使用了两个Transformer编码器,但引入了一个额外的attention模块,该模块使hm可以在上下文中参与mention的单个token表示。

计算,然后选出得分最高的候选实体。另外一个被称为:Cand-Pool-Transformer,原理是使用单个向量表示实体,但可以单独使用mention及其上下文。该模型还使用了两个Transformer编码器,但引入了一个额外的attention模块,该模块使hm可以在上下文中参与mention的单个token表示。

实验

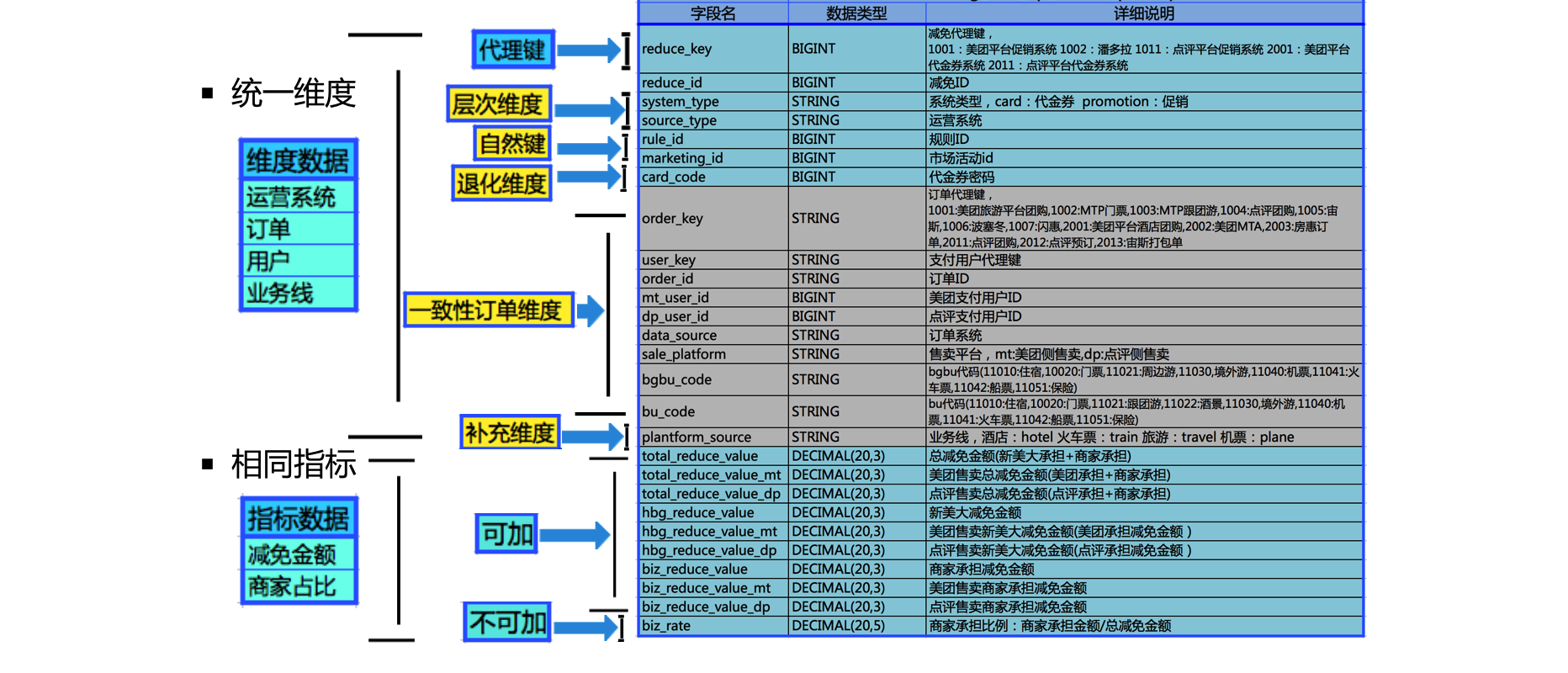

论文中,作者引入了一系列符号来描述组成预训练阶段的各种方式。

Usrc表示来自源世界文档的一系列的文本段

Utgt表示目标世界文档中的文本片段

Usrc+tgt表示从Usrc和Utgt中随机交错抽取的文本段

Uwb表示在开源语料库中的文本段,在此实验中语料库指的是Wikipedia和BookCorpus

如下表4所示,零样本实体链接的基准结果如下。在所有验证域上的平均归一化实体链接准确度中最高的是:Full-Transformer+Uwb组合,达到了76.06

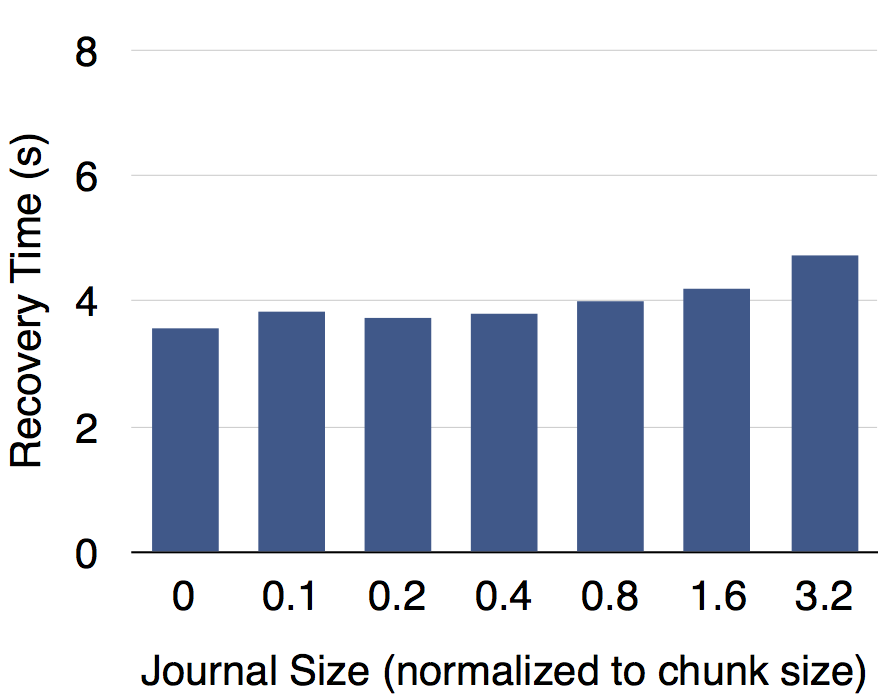

下图2(a)表示,使用DAP模型对实体链接任务的准确度相比其他模型要高,,并且经过对模型的微调后,准确度会比原来上升一些。图(b)表示了在目标域上评估的预训练模型的MLM(Masked LM)准确性与微调模型的实体链接性能之间的关系。可以看出。两者呈正相关的关系。

下表5显示了Full-Transformer(Uwb)对训练集和测试集中可见实体和不可见实体的预测准确度

下表6显示了Full-Transformer在测试域对实体链接的准确度

总结

本文提出了一种零样本实体链接的新任务,并为此构建了一个多世界数据集。该数据集可以用作实体链接研究的共享基准,该链接任务主要用于专门的专业领域,在领域中其中没有带有标注的mention,并且实体仅通过描述进行定义。并且文章还通过将强大的神经阅读理解与领域自适应预训练(DAP)相结合,提出了一个强大的基准。经过实验证明,论文中提出的模型比之前的实体链接工作准确率更好,验证了模型的有效性。但与此同时,候选实体生成阶段留有很大的改进空间。

OpenKG

开放知识图谱(简称 OpenKG)旨在促进中文知识图谱数据的开放与互联,促进知识图谱和语义技术的普及和广泛应用。

点击阅读原文,进入 OpenKG 网站。