本文作者:

陈想,浙江大学在读博士,研究方向为自然语言处理

张宁豫,浙江大学助理研究员,研究方向为自然语言处理、知识表示与推理

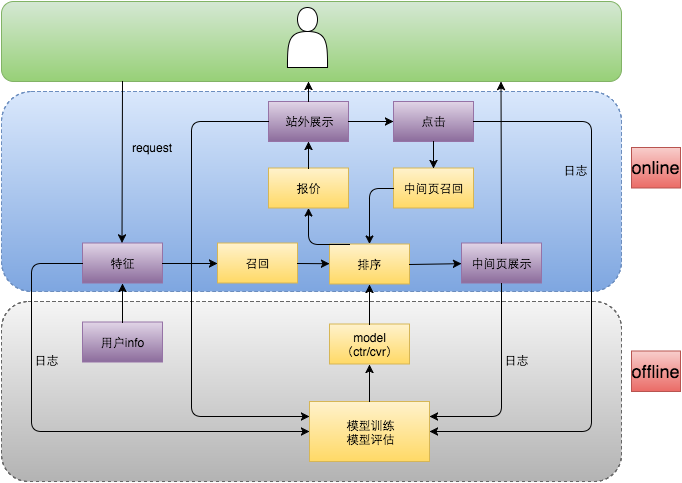

这篇推文是文档级关系抽取方法的第二部分,前面的部分请移步推文“论文小综 | 文档级关系抽取方法(上)”

3.2 基于序列的方法

传统基于序列的方法主要采用RNN等架构。随着近年来transformer模型在NLP领域的应用,基于序列的方法主要采用基于transformer架构。基于序列的模型认为transformer本身可以隐式建模长距离依赖性,此类方法没有引入graph结构而直接应用预训练语言模型。这里我们主要介绍以下2篇代表性的论文。

Document-Level Relation Extraction with Adaptive Thresholding and Localized Context Pooling

发表会议:AAAI 2021

论文链接:

https://arxiv.org/abs/2010.11304

Motivation

multi-entity (multiple entity pairs to classify in a document)和multi-label (multiple relation types for a particular entity pair) 属性是文档级关系抽取比句子级关系抽取难以实现的关键所在[2]。

1. 现有的方法在计算entity representation时,每个entity在不同的entity pair中保持相同的representation,这会引进不相关信息的噪声。作者引入localized context pooling技术,它可以解决对所有的实体对使用相同的entity embedding问题;

2. 对于multi-label问题,现有的方法将之归纳为二值的多标签分类问题,给每个class应用一个全局的阈值来获得关系类别。这种方法涉及启发式阈值调整,并且当来自开发数据的调整阈值可能并非对所有实例均不是最佳时,会引入决策错误。作者提出adaptive thresholding技术,此技术消除了对阈值调整的需要,并使阈值可调整为适用于不同的实体对,从而获得了更好的结果。

Model

ATLOP模型的核心主要为两部分:Localized Context Pooling和Adaptive Thresholding。

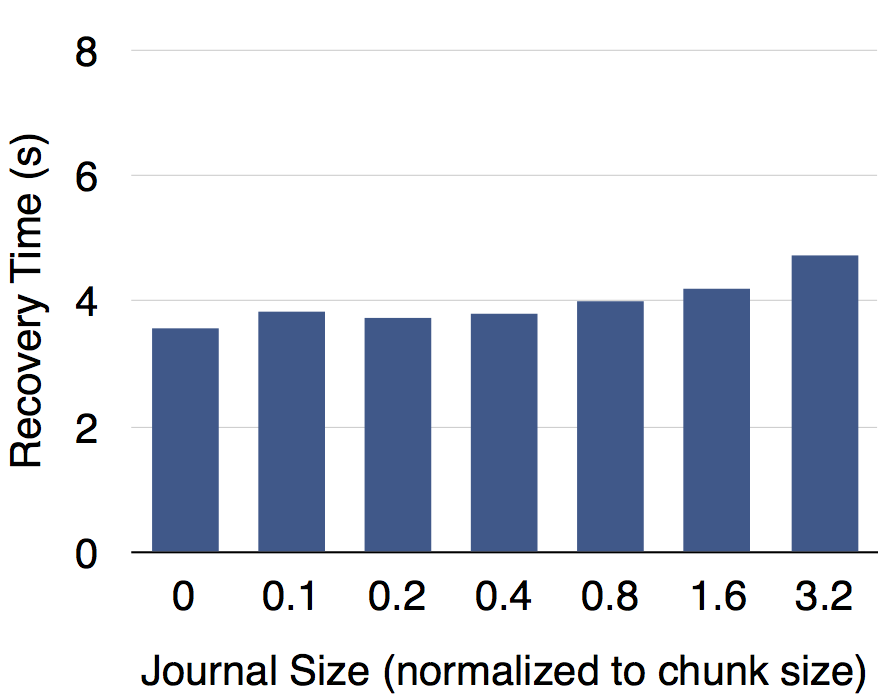

1. Localized Context Pooling:有的上下文可能和实体对没啥关系,所以作者只关心对决定实体对的关系有用的上下文。使用与两个实体相关的附加上下文embedding,来增强实体对的embedding。因为已经用了基于双向transformer的bert来编码,bert已经很强大了,其自带多头attention,不需要从头学习新的attention了,所以从最后一层transformer里直接取他们的注意力头来作为局部上下文。如下图所示:

对同一实体的所有提及的attention求平均,获得实体的attention。通过将它们的实体级attention相乘,然后进行规范化,我们获得了对两个实体都很重要的上下文embedding。

将上下文embedding融入到实体embedding中:

2. Adaptive Thresholding:作者认为全局阈值不合理,因为不同实体对,不同关系,不能一概而论。

Positive T:对于一对实体T,只要二者存在关系,Pt 就包含这类关系,如果不巧,这对实体没有关系,那Pt 就是空的。

Negative T:对于一对实体T,如果二者不存在任何关系,Nt 存储的是实体对T不存在的关系。

如果实体对分类正确,阳性标签的logit会高于阈值,阴性标签的logit低于阈值。这个阈值TH class就可以自己学习得到。自适应阈值的损失函数如下:

Experiment

数据集:DocRED、CDR、GDA

实验结果:

实验结果显示,在DocRED、CDR和GDA三种数据集上,作者提出的ATLOP均达到了SOTA,ATLOP未构建任何图结构,简单的应用bert自身的attention信息以及动态阈值方法便取得了显著的效果。

Entity Structure Within and Throughout: Modeling Mention Dependencies for Document-Level Relation Extraction

发表会议:AAAI 2021

论文链接:

https://arxiv.org/pdf/2102.10249.pdf

Motivation

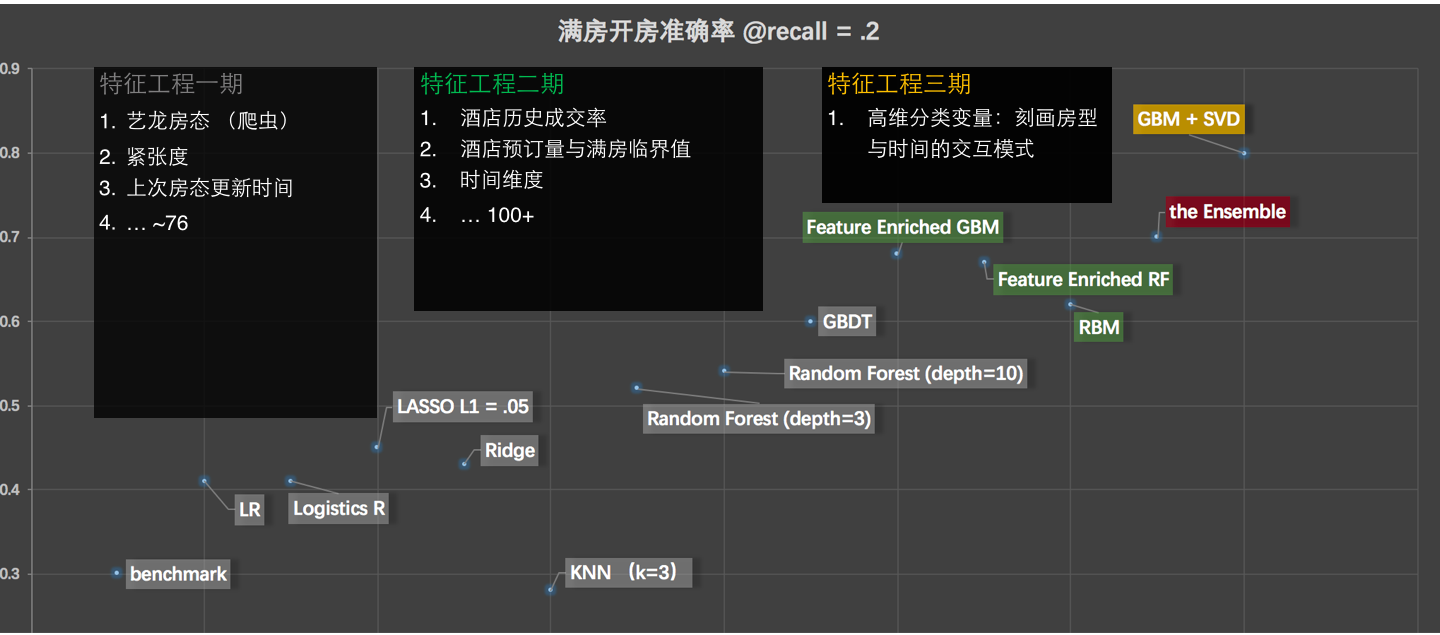

如下图示例所示,文档级文本需要在多个mention中定义大量的entity,这些entity在两者之间表现出有意义的依存关系。这样的依赖关系表明entity与mention之间丰富的信息交互,从而为关系提取提供了有益的先验[3]。

先前的许多工作都尝试利用这种entity structure,特别是coreference dependency,但大都只是将coreferential information简单编码为额外特征并将其集成到初始input word embeddings中,除了共指信息之外并没有引入其他有意义的依赖信息。

而最近的graph-based方法通常依赖于通用编码器(通常为LSTM/BERT)来首先获取输入文档的上下文表示。然后,他们通过构造精心设计的图来介绍实体结构,在图中通过传播相应地更新实体表示。由于编码网络和图网络之间的异质性,这种方法将上下文推理阶段和结构推理阶段隔离开来,这意味着上下文表示不能首先从结构指导中受益。

作者认为,structural dependencies应纳入编码网络内以及整个系统中,由此提出SSAN (Structured\ Self-Attention Network),可以有效地在其构造块内以及从下至上的所有网络层中对这些依赖性进行建模。

Approach

How to formulate the structure of entities?

Co-occurrence structure:区分依赖于局部上下文的intra-sentential interactions和需要交叉句子推理的句子间交互。

Coreference structure:区分两个mention是否指向同一个entity

作者提出了具有两个可替代的transformation modules的structured self-attention机制,如下图所示:

How to model entity structure?

即为原始的self-attention,而transformation modules作用为调节从到的注意力流,其结果作为原始attention的bias。通过这样简单有效的融合,该模型能够受益于结构依赖性的指导。

Experiment

数据集:DocRED、CDR、GDA

实验结果:

实验结果显示,在DocRED数据集上,SSAN未跟GAIN和ATLOP对比,我们可以看到在未加Adaptation的情况下,SSAN(roberta-based)的F1比ATLOP(Roberta-based)低1%,加上Adaptation后超越ATLOP跃居目前DocRED榜单的第一名,这里Adaptation指采用了远程监数据对模型进行了预训练,这也表明远程数据的预训练对这种加入结构先验信息的方法非常重要。

总之,SSAN将structural dependencies纳入encoder网络内以及整个系统中,能够同时地进行context reasoning and structure reasoning,这种方法很有启发意义,作者也提到SSAN方法很容易适用于其他各种基于Transformer的预训练语言模型以融合任何结构上的依赖性。

4 未来展望

尽管文档级关系抽取取得了一定程度的发展,其性能仍难以满足实际应用的需求。未来可能的方向有:

1. 设计文档实体结构相关的预训练。现有的MLM预训练目标并不能很好的建模实体及实体间的隐式关联,因此,一个能够显式建模实体及其包含的语义关系的预训练目标可以增强文档的实体的表达能力。目前已经有工作[4][7]开始尝试基于对比学习设计更好的实体关系预训练模型。

2. 减轻关系标签分布不平衡。文档级关系抽取中的关系存在明显的长尾分布,且大量的实体间不存在关系,因此类别分布不平衡在一定程度上影响模型效果。[2]针对这一问题提出了动态阈值的方法,然而对于长尾部分的关系仍然缺乏较好的模型进行抽取。

3. 引入外部知识。语言模型缺乏对实体知识的认知,先前的工作表明注入实体等事实类型知识可以显著提升知识敏感的任务性能,[13]提出了一个注入Probase知识库的关系抽取模型,然而知识库存在稀疏性和噪音,更加高效可靠的知识注入方法仍然值得研究。

4. 设计更好的实体交互模型。目前关系抽取中仅考虑实体对之间的一阶交互,缺乏对多个实体对之间的高阶交互建模。尽管基于文档图的模型在一定程度上使得模型得学习了实体与实体之间的交互信息,然而对于实体图中相聚较远的节点,实体之间缺乏足够的信息流通,制约模型的逻辑推理能力。

参考文献

[1] Yao etal., DocRED: A large-scale document-level relation extraction dataset, ACL2019

[2] Zhou etal., Document-Level Relation Extraction with Adaptive Thresholding and Localized Context Pooling, AAAI2021

[3] Xu etal., Entity Structure Within and Throughout: Modeling Mention Dependencies forDocument-Level Relation Extraction, AAAI2021

[4] Qin etal., ERICA: Improving Entity and Relation Understanding for Pre-trained Language Models via Contrastive Learning

[5] Huang etal., Entity and Evidence Guided Relation Extraction for DocRED

[6] Xiao etal., Denoising Relation Extraction from Document-level Distant Supervision, EMNLP2020

[7] Ye etal., Coreferential Reasoning Learning for Language Representation, EMNLP2020

[8] Wang., Fine-tune BERT for DOCRED with Two-step Process

[9] Tang etal., Hin: Hierarchical Inference Network for Document-level Relation Extraction, PAKDD2020

[10] Jia etal., Document-level N-ary Relation Extraction with Multiscale Representation Learning, NAACL2019

[11] Eberts etal., An End-to-end Model for Entity-level Relation Extraction using Multi-instance Learning

[12] Eyal etal., Bootstrapping Relation Extractors using Syntactic Search by Examples

[13] Li etal., Multi-view Inference for Relation Extraction with Uncertain Knowledge, AAAI2021

[14] Christopoulou etal., Connecting the Dots: Document-level Neural Relation Extraction with Edge-oriented Graphs, EMNLP2019

[15] Nan etal., Reasoning with Latent Structure Refinement for Document-Level Relation Extraction, ACL2020

[16] Zeng etal., Double Graph Based Reasoning for Document-level Relation Extraction, EMNLP2020

[17] Xu etal., Document-level Relation Extraction with Reconstruction, AAAI2021

[18] Zhou etal., Global Context-enhanced Graph Convolutional Networks for Document-level Relation Extraction, COLING2020

[19] Zhang etal., Document-level Relation Extraction with Dual-tier Heterogeneous Graph, COLING2020

[20] Wang etal., Global-to-local Neural Networks for Document-level Relation Extraction, EMNLP2020

[21] Li etal., Graph Enhanced Dual Attention Network for Document-level Relation Extraction, COLING2020

[22] Peng etal., Cross-sentence N-ary Relation Extraction with Graph LSTMs, TACL2017

OpenKG

开放知识图谱(简称 OpenKG)旨在促进中文知识图谱数据的开放与互联,促进知识图谱和语义技术的普及和广泛应用。

点击阅读原文,进入 OpenKG 网站。