*常用函数

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.mzph.cn/news/104210.shtml

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

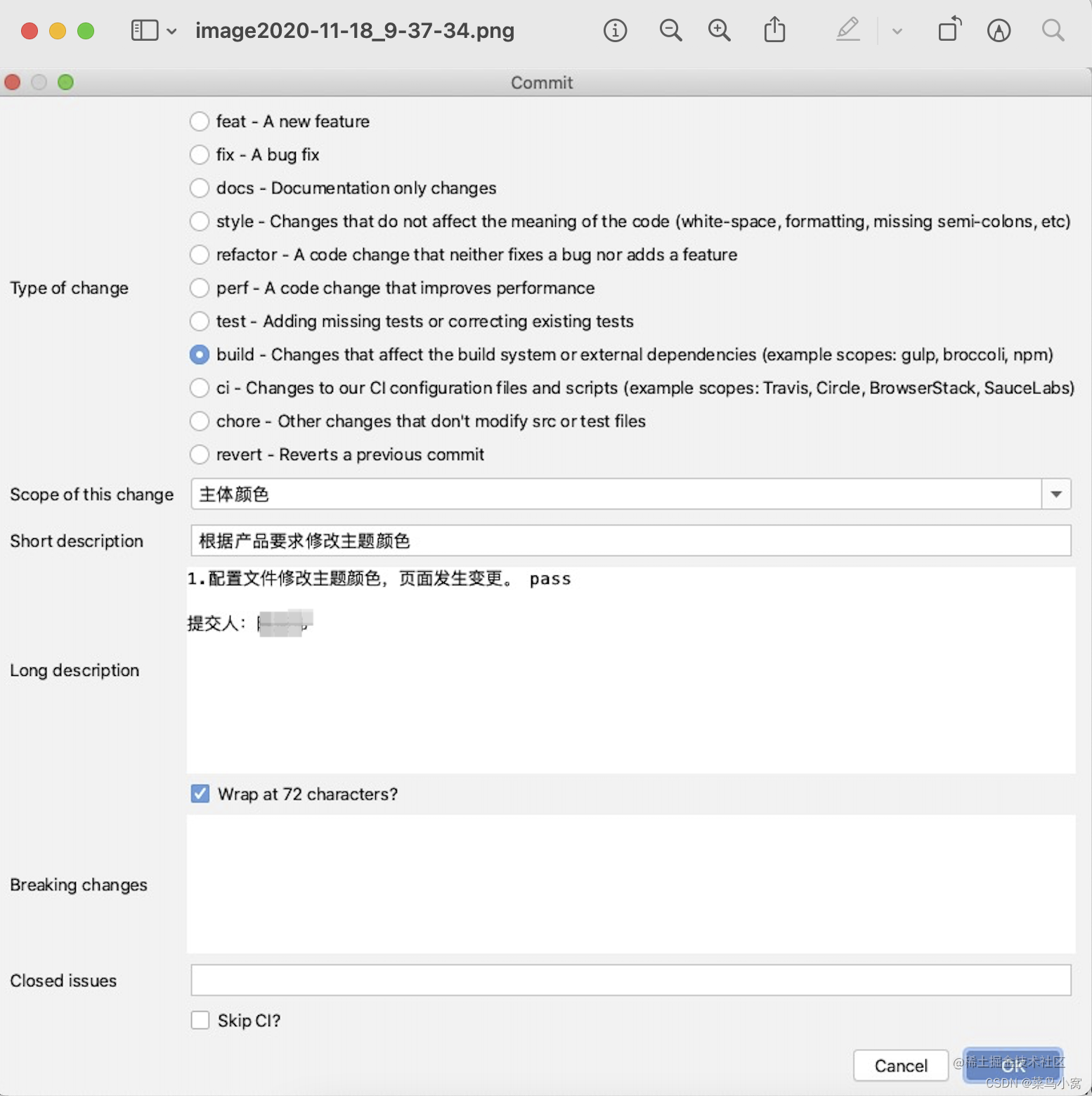

Git Commit Message规范

概述

Git commit message规范是一种良好的实践,可以帮助开发团队更好地理解和维护代码库的历史记录。它可以提高代码质量、可读性和可维护性。下面是一种常见的Git commit message规范,通常被称为"Conventional Commits"规范:

一…

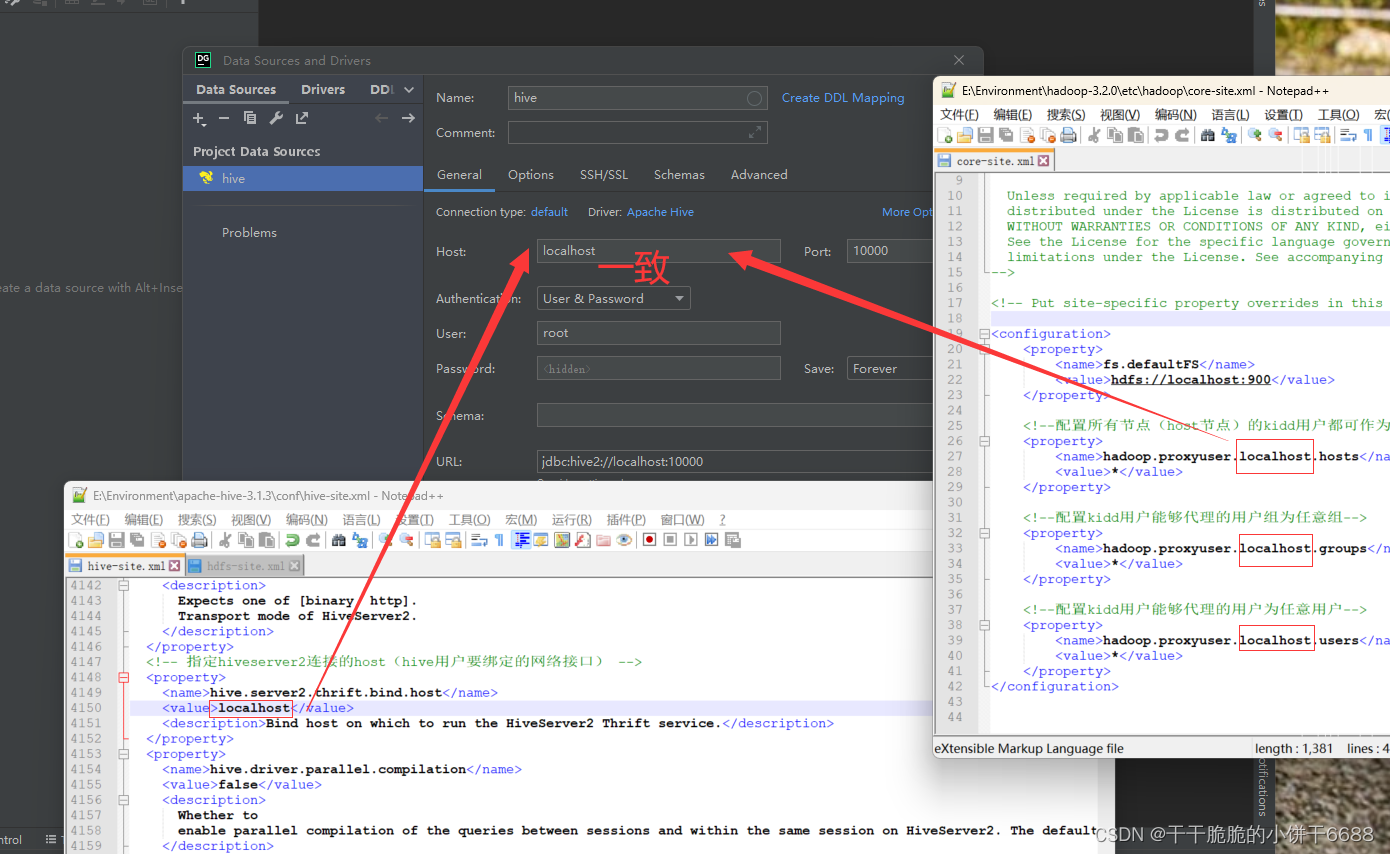

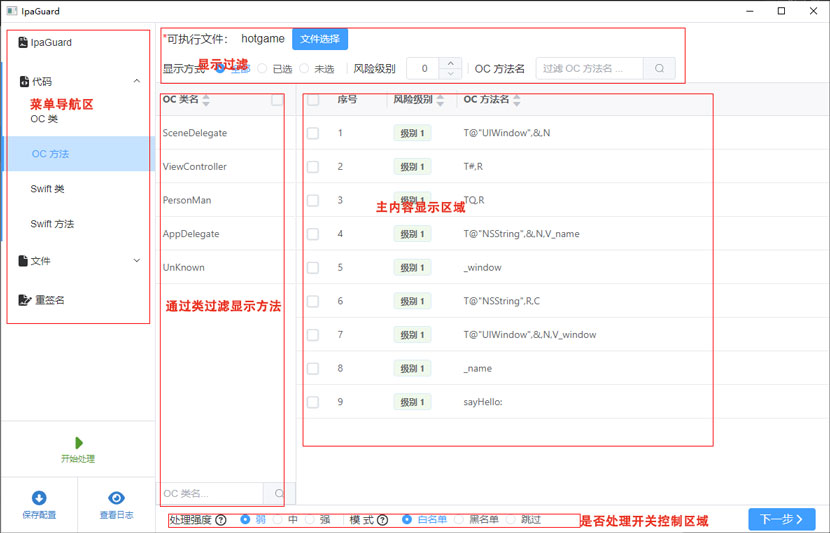

Windows下DataGrip连接Hive

DataGrip连接Hive 1. 启动Hadoop2. 启动hiveserver2服务3. 启动元数据服务4. 启动DG 1. 启动Hadoop 在控制台中输入start-all.cmd后,弹出下图4个终端(注意终端的名字)2. 启动hiveserver2服务

单独开一个窗口启动hiveserver2服务,…

0基础学习VR全景平台篇 第108篇:全景图细节处理(下,航拍)

上课!全体起立~

大家好,欢迎观看蛙色官方系列全景摄影课程! (调色前图库) (原图-大图)

一、导入文件

单击右下角导入按钮,选择航拍图片所在文件夹,选择图片࿰…

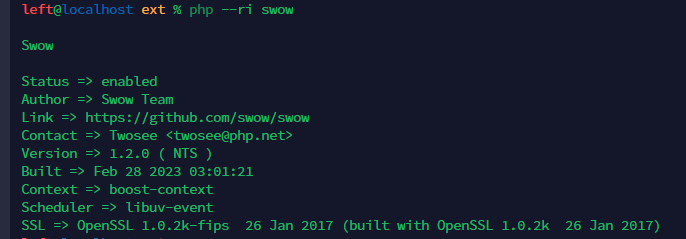

【运维笔记】swow源码编译安装

swow的github网址

https://github.com/swow/swow

从github中拉取源码

git pull https://github.com/swow/swow.git

编译安装

github中readme文件讲述了安装方法 这里整理了命令,进入拉取项目的目录后依次执行命令即可

#pwd 确保自己在swow目录中,如…

docker 搭建本地Chat GPT

要在CentOS7上安装Docker,您可以按照以下步骤进行操作:

1、更新系统包列表

sudo yum update2、安装Docker存储库的必要软件包

sudo yum install -y yum-utils device-mapper-persistent-data lvm23、添加Docker存储库

sudo yum-config-manager --add…

3DEXPERIENCE® SOLIDWORKS® 新功能

先前版本的兼容性 优点 即使其他用户正在使用旧版 SOLIDWORKS,也能轻松与其 协作。

• 通过将您的 3DEXPERIENCE SOLIDWORKS 设计作品保存为旧 版本,与使用旧版本的供应商无缝协作。

• 将零件、装配体和工程图保存为最新版本前两年之内的 3DEXPERIENC…

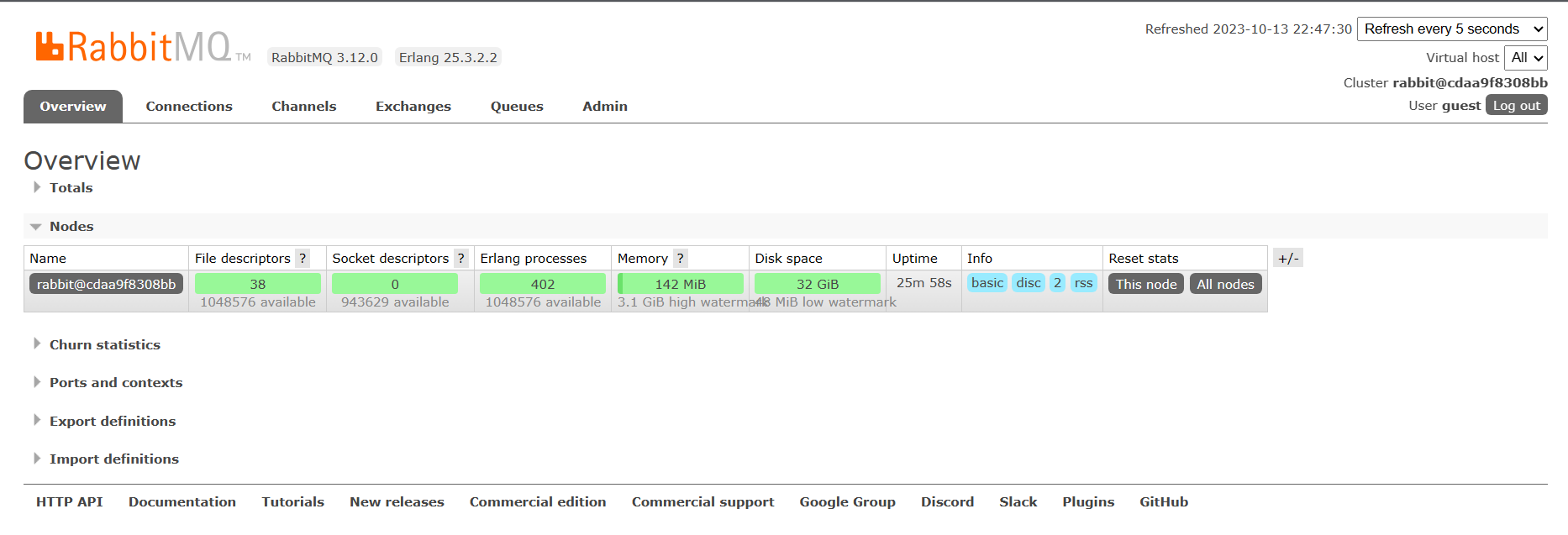

centos7部署Nginx和RabbitMQ

文章目录 Nginx安装部署【简单】简介安装 RabbitMQ安装部署【简单】简介安装 Nginx安装部署【简单】

简介

Nginx (engine x) 是一个高性能的HTTP和反向代理web服务器,同时也提供了IMAP/POP3/SMTP服务。Nginx可以托管用户编写的WEB应用程序成为可访问的网页服务&am…

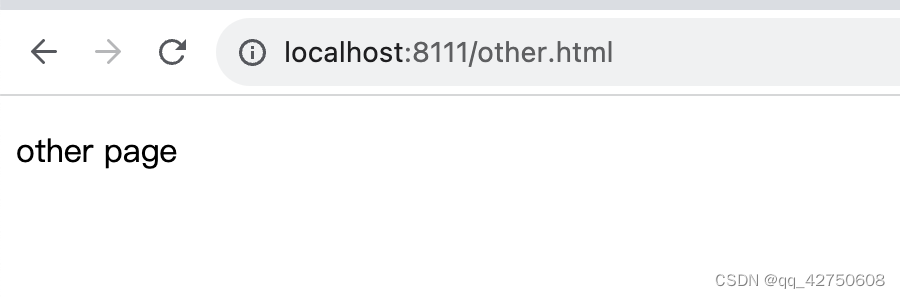

从零开始使用webpack搭建一个react项目

先做一个正常编译es6语法的webpack demo

1. 初始化package.json文件

npm init一路enter下去

2. 添加插件

{"name": "demo","version": "1.0.0","description": "","main": "index.js",&q…

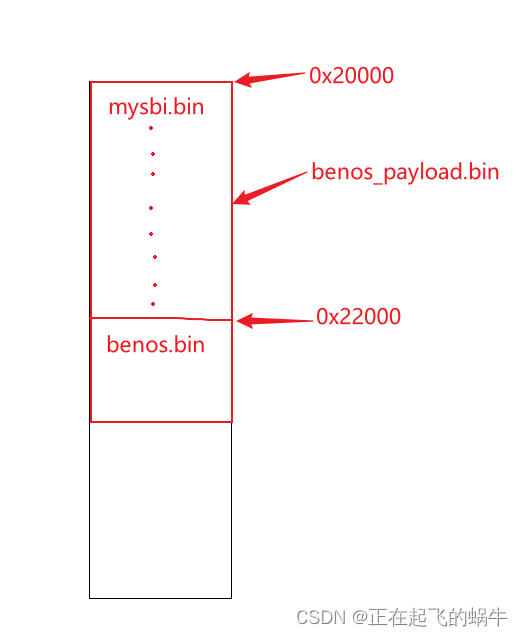

《RISC-V体系结构编程与实践》的benos_payload程序——mysbi跳转到benos分析

1、benos_payload.bin结构分析 韦东山老师提供的开发文档里已经对程序的结构做了分析,这里不再赘述,下面是讨论mysbi跳转到benos的问题; 2、mysbi跳转到benos的代码 3、跳转产生的疑问 我认为mysbi.bin最后跳转到0x22000地址处执行࿰…

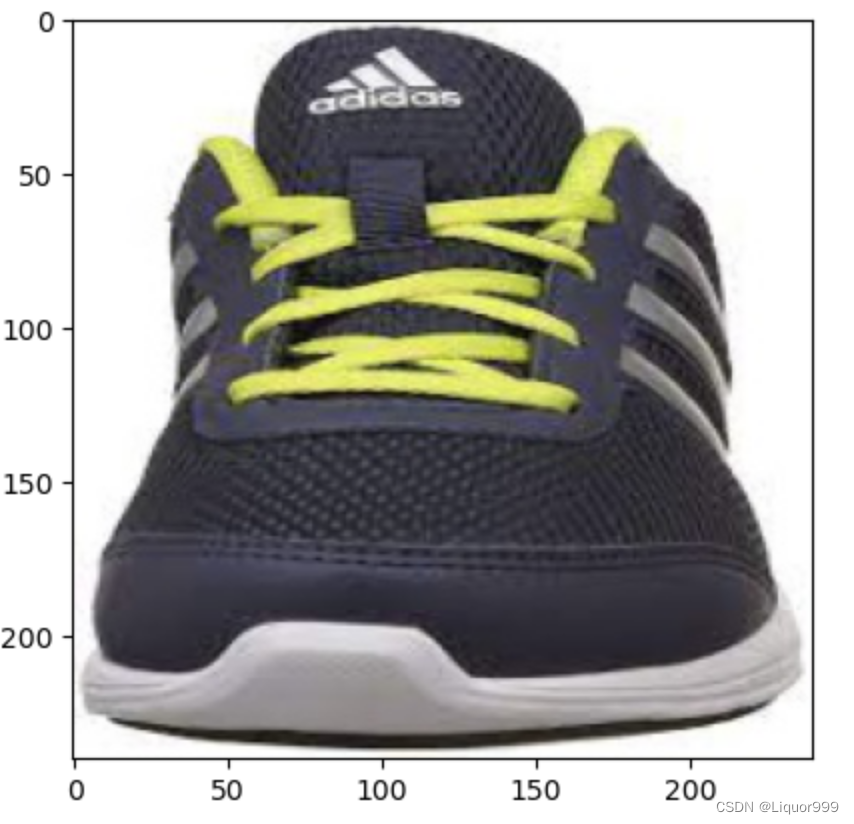

Pytorch从零开始实战05

Pytorch从零开始实战——运动鞋识别

本系列来源于365天深度学习训练营

原作者K同学 文章目录 Pytorch从零开始实战——运动鞋识别环境准备数据集模型选择数据可视化模型预测总结 环境准备

本文基于Jupyter notebook,使用Python3.8,Pytorch2.0.1cu118…

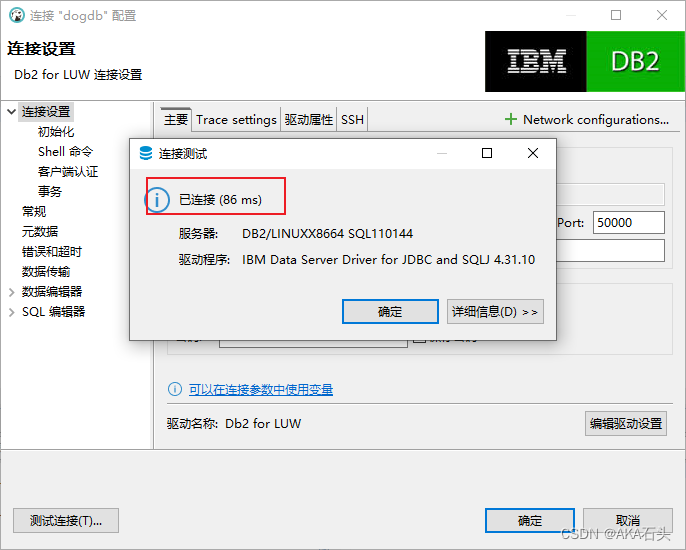

centos7安装db2 version11.1

centos7安装DB2 操作系统 linux centos7 DB2版本 11.1 1、取包

IBM MRS Tool 将安装包放在 /home/software 下面

mkdir -p /home/software cd /home/software wget https://iwm.dhe.ibm.com/sdfdl/v2/regs2/db2pmopn/Express-C/DB2ExpressC11/Xa.2/Xb.aA_60_-i7wWKFMFpbW1xl1…

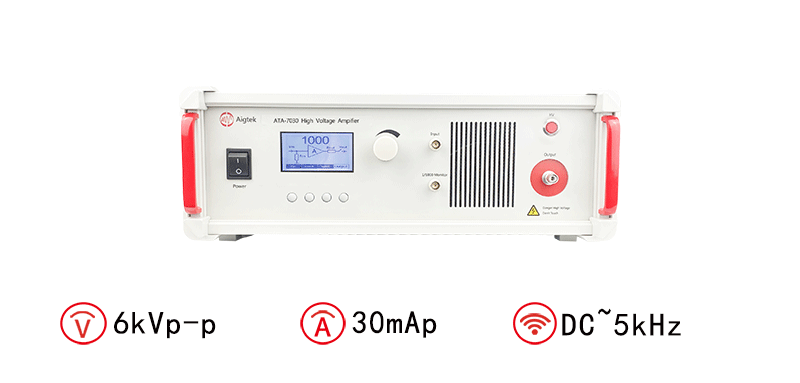

高压放大器在软体机器人领域的应用

软体机器人是一种新型机器人技术,与传统的硬体机器人有着很大的不同。软体机器人通常由柔软的材料制成,具有高度的柔韧性和灵活性,并且可以实现多种形状和动作。但是,软体机器人的发展面临很多技术挑战,其中之一就是控…

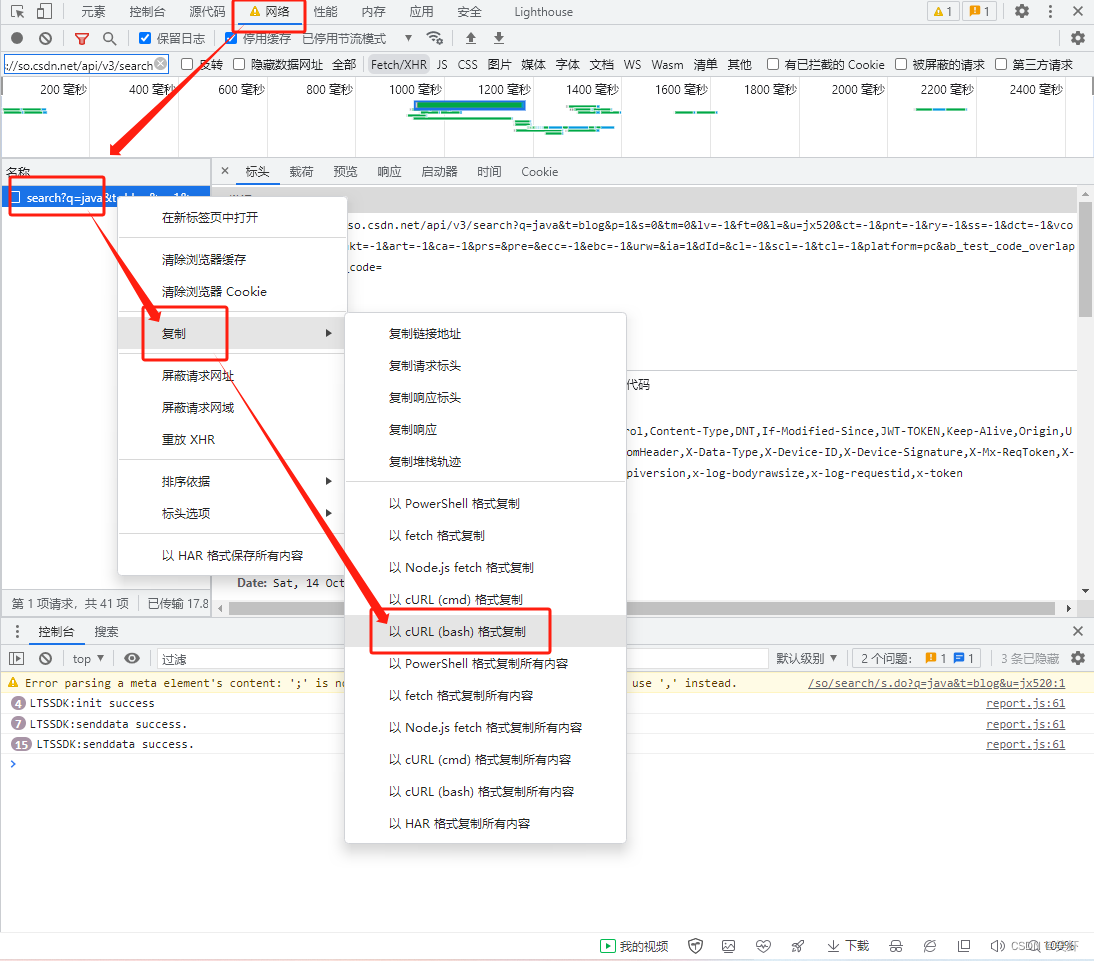

Java 解析 cURL(bash) 命令

解析 cURL(bash) 命令 1. 主要用于解析从浏览器复制来的 cURL(bash)2. 废话不多说,都在🍻代码里了。参考资料 1. 主要用于解析从浏览器复制来的 cURL(bash) curl https://eva2.csdn.net/v3/06981375190026432f77c01bfca33e32/lts/…

使用PyQt5创建图片查看器应用程序

使用PyQt5创建图片查看器应用程序

作者:安静到无声 个人主页

在本教程中,我们将使用PyQt5库创建一个简单的图片查看器应用程序。这个应用程序可以显示一系列图片,并允许用户通过按钮切换、跳转到不同的图片。

1. 准备工作

首先࿰…

在 TensorFlow 中调试

如果调试是消除软件错误的过程,那么编程一定是添加错误的过程。Edsger

Dijkstra。来自 https://www.azquotes.com/quote/561997

一、说明 在这篇文章中,我想谈谈 TensorFlow 中的调试。 在之前的一些帖子(此处、此处和此处)中&…

谜题(Puzzle, ACM/ICPC World Finals 1993, UVa227)

有一个5*5的网格,其中恰好有一个格子是空的,其他格子各有一个字母。一共有4种指令:A, B, L, R,分别表示把空格上、下、左、右的相邻字母移到空格中。输入初始网格和指令序列(以数字0结束),输出指…

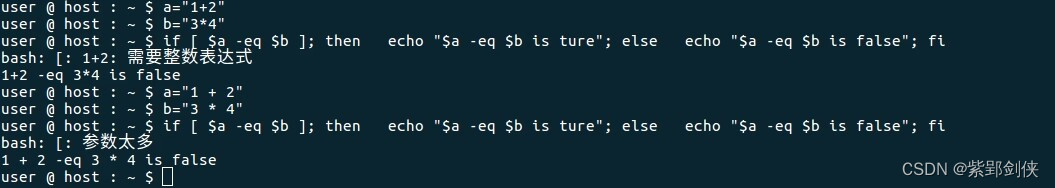

Linux shell编程学习笔记11:关系运算

Linux Shell 脚本编程和其他编程语言一样,支持算数、关系、布尔、字符串、文件测试等多种运算。前面几节我们研究了 Linux shell编程 中的 字符串运算 和 算术运算,今天我们来研究 Linux shell编程中的的关系运算。

一、关系运算符功能说明

运算符说明…

推荐文章

- CloudberryDB(四)并行执行

- 华为E9000刀箱服务器监控指标解读

- vue3组件传值具体使用

- 用java配合redis 在springboot上实现令牌桶算法

- oneplus3t-lineage-14编译-android7

- 如何使用usememo和usecallback进行性能优化,什么时候使用usecallback,什么时候使用usememo

- Part 2: Containers

- 利用Guava的Suppliers.memoize实现单例

- 致敬2016,拥抱2017

- 8086汇编求一组正整数{0x1223,0x1234,0x1434,0x2345,0x3412,0x1712}中的最大数并存在变量MAX中

- 真实不装| 阿里巴巴新人上路指北

- LeetCode解法汇总518. 零钱兑换 II