文章目录

- 1. 什么是Ollama?

- 2. 什么是Dify?

- 3. 下载Ollama

- 4. 安装Ollama

- 5. Ollama Model library模型库

- 6. 本地部署Llama 3.1模型

- 7. 安装Docker Desktop

- 8. 使用Docker-Compose部署Dify

- 9. 注册Dify账号

- 10. 集成本地部署的 Llama 3.1模型

- 11. 集成智谱AI大模型

- 12. 添加Dify团队成员

- 13. 导入DSL - 小红书文案生成脚本

- 14. 所遇问题

- 15. 参考链接

1. 什么是Ollama?

Ollama 是一种可以学习和回答问题的 AI 模型,它能够进行自然语言交互,类似于人类对话。它具备一些独特的功能,如:

- 自主学习: Ollama 可以通过自身的学习过程改善其回答质量和知识范围。

- 无限回复: Ollama 能够不断地回答问题,无论你问多少个,直到你满意为止。

- 自然语言: Ollama 支持多种语言,包括英语、西班牙语等,你可以与它进行母语对话。

2. 什么是Dify?

Dify是一个开源的LLM应用程序开发平台。Dify直观的界面结合了人工智能工作流程、RAG管道、代理功能、模型管理、可观察性功能等,让您快速从原型进入生产。

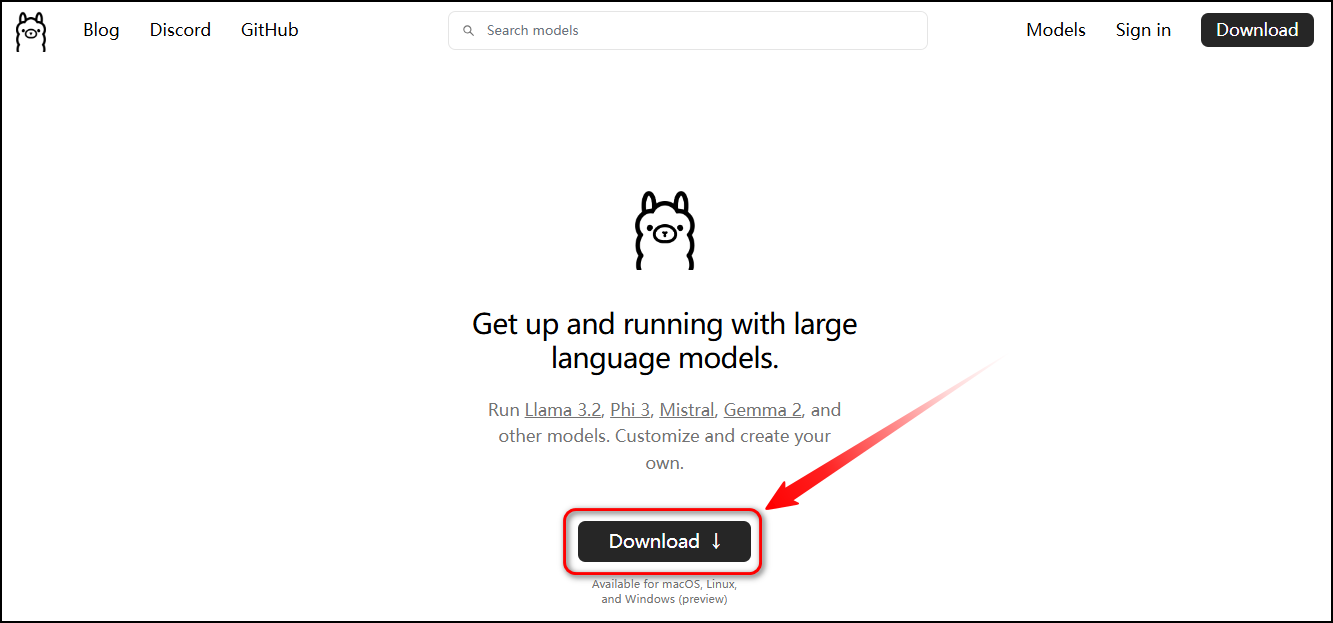

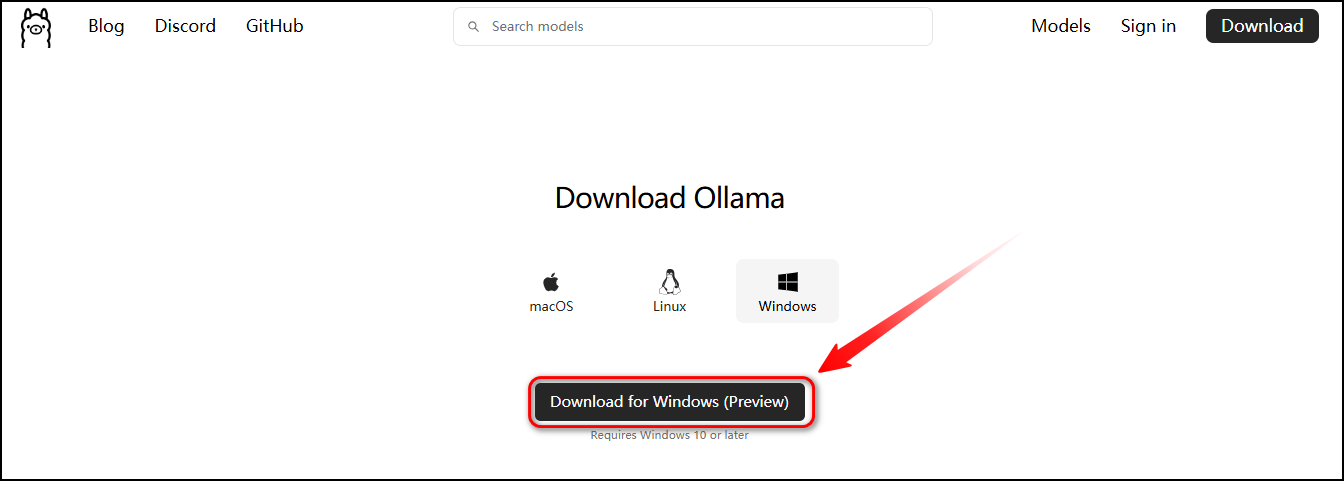

3. 下载Ollama

下载链接:https://ollama.com

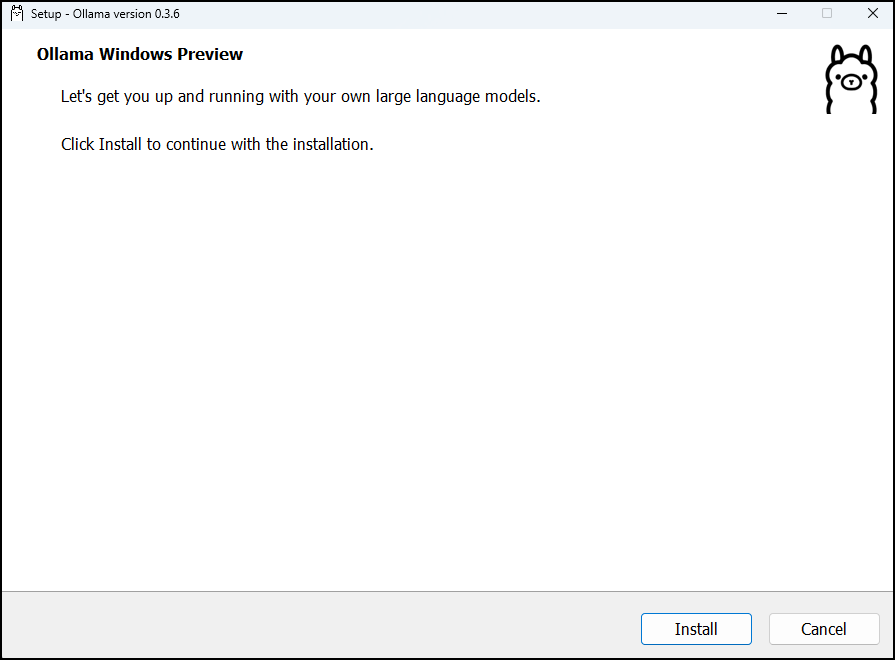

4. 安装Ollama

打开安装包,安装Ollama。

5. Ollama Model library模型库

Ollama supports a list of models available on ollama.com/library

Here are some example models that can be downloaded:

| Model | Parameters | Size | Download |

|---|---|---|---|

| Llama 3.1 | 8B | 4.7GB | ollama run llama3.1 |

| Llama 3.1 | 70B | 40GB | ollama run llama3.1:70b |

| Llama 3.1 | 405B | 231GB | ollama run llama3.1:405b |

| Phi 3 Mini | 3.8B | 2.3GB | ollama run phi3 |

| Phi 3 Medium | 14B | 7.9GB | ollama run phi3:medium |

| Gemma 2 | 2B | 1.6GB | ollama run gemma2:2b |

| Gemma 2 | 9B | 5.5GB | ollama run gemma2 |

| Gemma 2 | 27B | 16GB | ollama run gemma2:27b |

| Mistral | 7B | 4.1GB | ollama run mistral |

| Moondream 2 | 1.4B | 829MB | ollama run moondream |

| Neural Chat | 7B | 4.1GB | ollama run neural-chat |

| Starling | 7B | 4.1GB | ollama run starling-lm |

| Code Llama | 7B | 3.8GB | ollama run codellama |

| Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

| LLaVA | 7B | 4.5GB | ollama run llava |

| Solar | 10.7B | 6.1GB | ollama run solar |

Note:You should have at least 8 GB of RAM available to run the 7B models, 16 GB to run the 13B models, and 32 GB to run the 33B models.

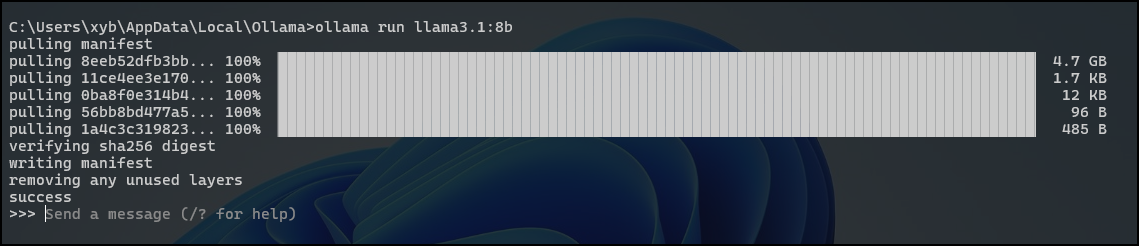

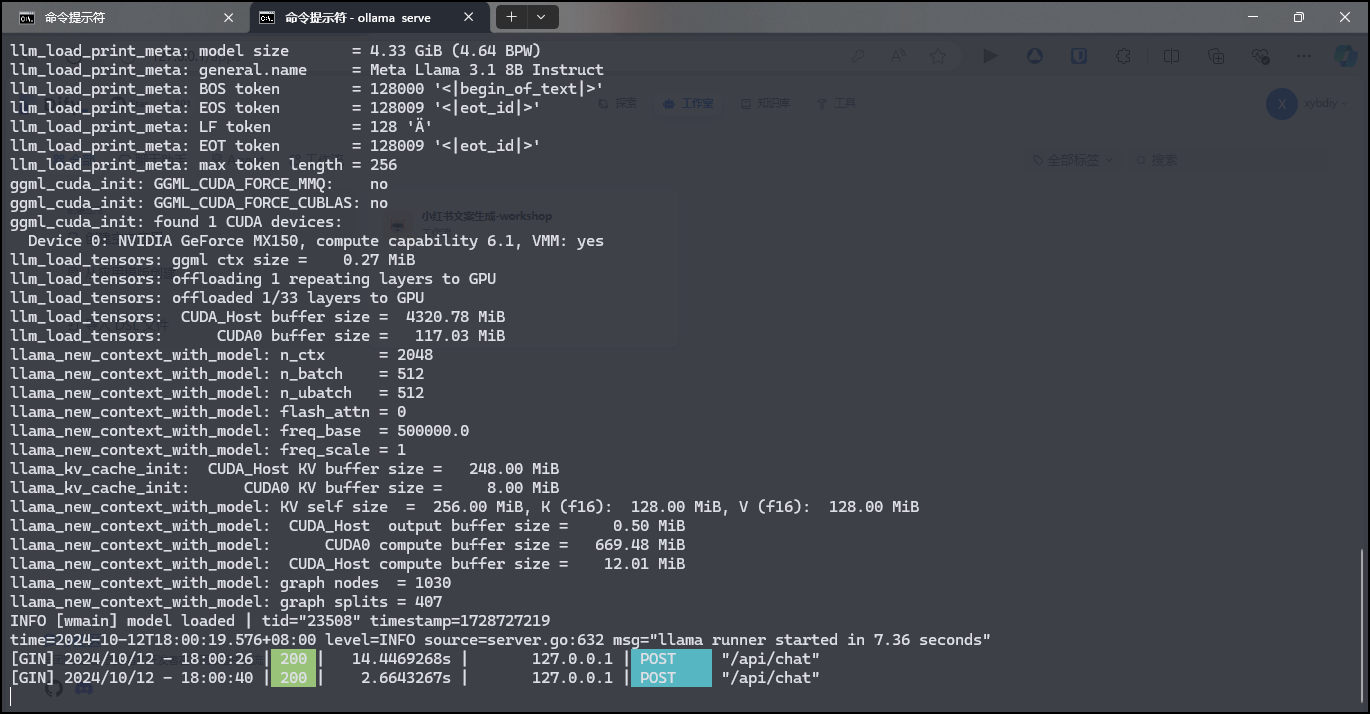

6. 本地部署Llama 3.1模型

To run and chat with Llama 3.1:

ollama run llama3.1:8b

Start ollama

C:\Users\xyb>ollama serve

List models on your computer

C:\Users\xyb>ollama list

NAME ID SIZE MODIFIED

llama3.1:8b 91ab477bec9d 4.7 GB 8 weeks ago

Show model information

C:\Users\xyb>ollama show llama3.1:8bModelarch llamaparameters 8.0Bquantization Q4_0context length 131072embedding length 4096Parametersstop "<|start_header_id|>"stop "<|end_header_id|>"stop "<|eot_id|>"LicenseLLAMA 3.1 COMMUNITY LICENSE AGREEMENTLlama 3.1 Version Release Date: July 23, 2024

ollama -h

C:\Users\xyb>ollama -h

Large language model runnerUsage:ollama [flags]ollama [command]Available Commands:serve Start ollamacreate Create a model from a Modelfileshow Show information for a modelrun Run a modelpull Pull a model from a registrypush Push a model to a registrylist List modelsps List running modelscp Copy a modelrm Remove a modelhelp Help about any commandFlags:-h, --help help for ollama-v, --version Show version informationUse "ollama [command] --help" for more information about a command.

7. 安装Docker Desktop

在Windows 环境下,安装Docker Desktop。

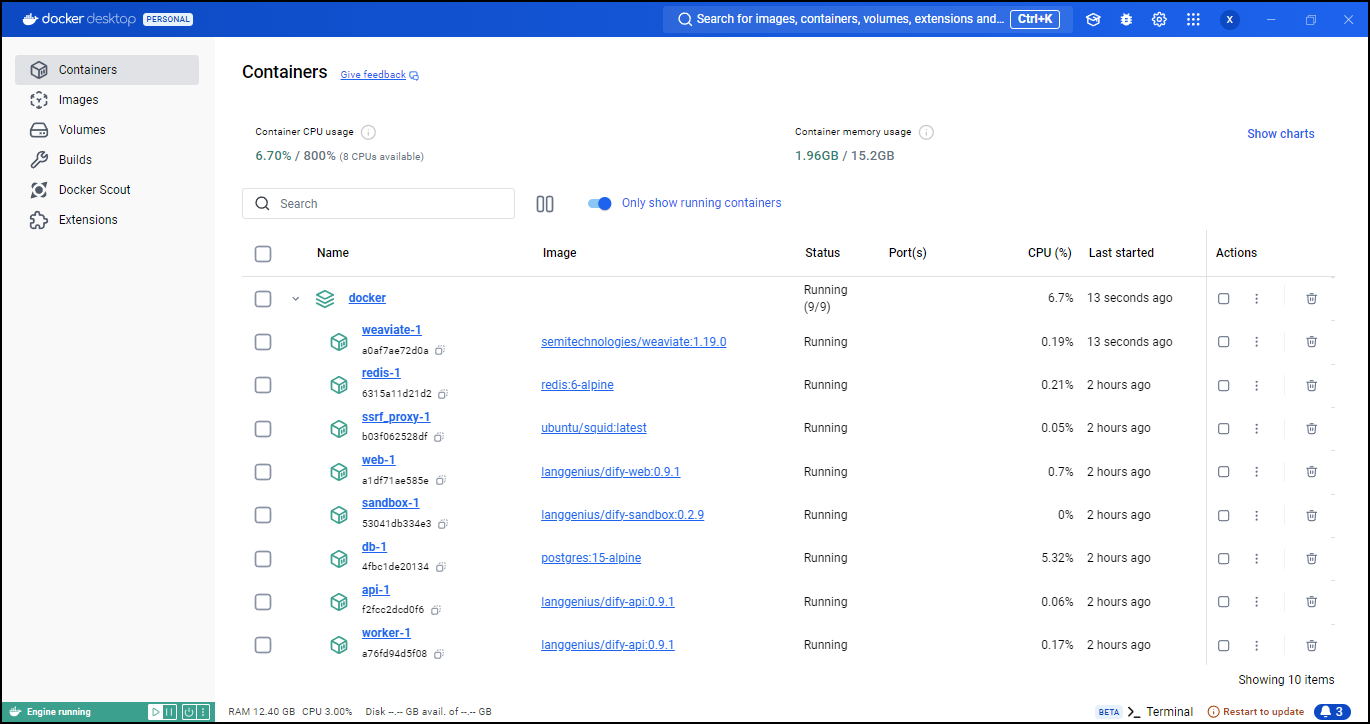

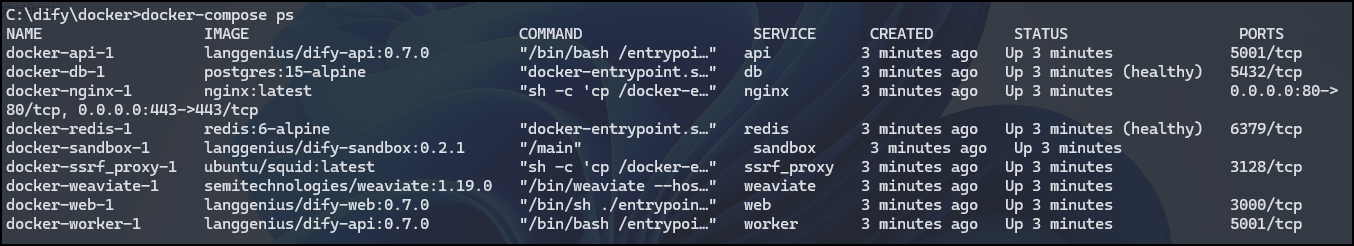

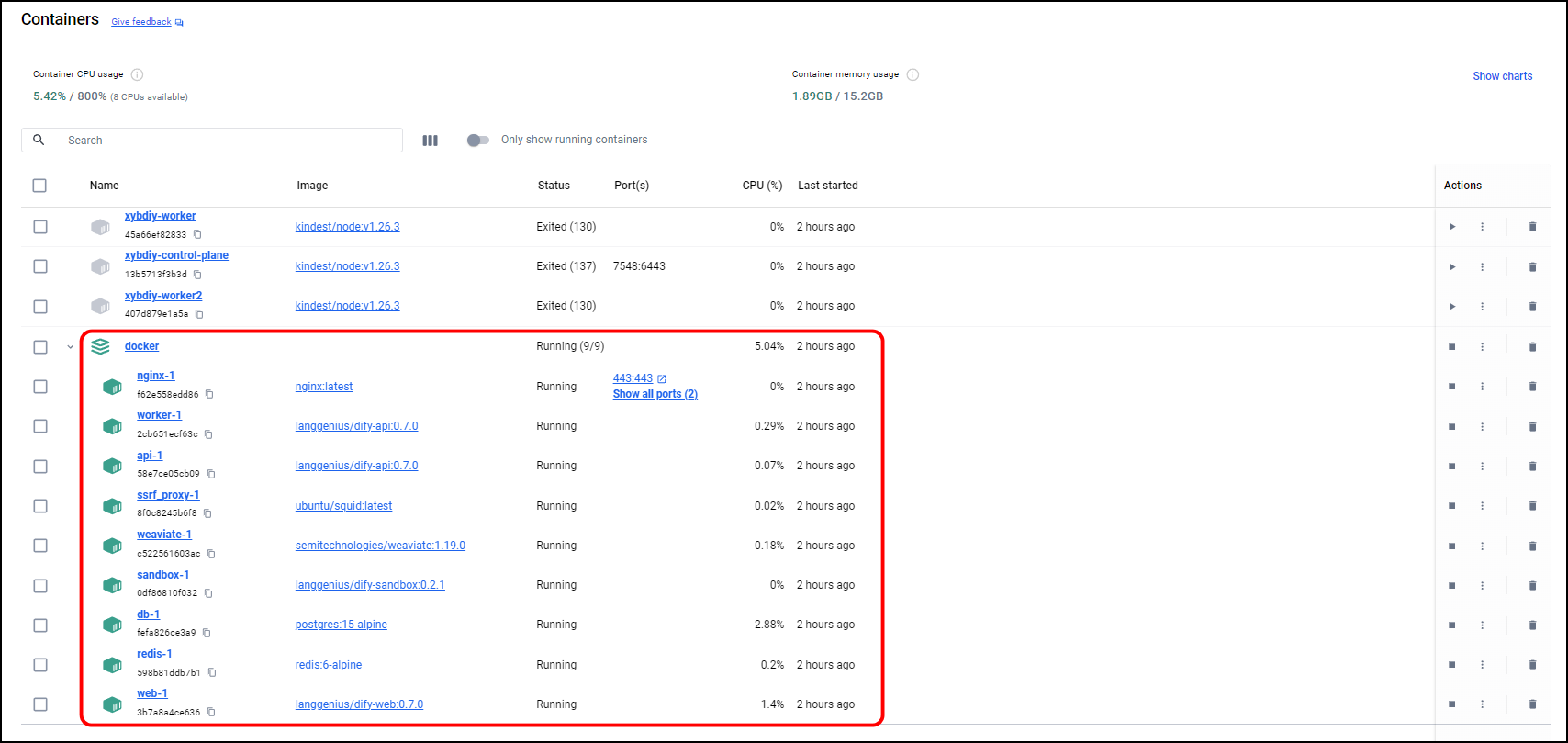

8. 使用Docker-Compose部署Dify

进入 Dify 源代码的 docker 目录,执行一键启动命令:

cd dify/dockercp .env.example .envdocker compose up -d

输入过程如下:

C:\dify\docker>docker-compose up -d

[+] Running 11/11✔ Network docker_default Created 0.1s✔ Network docker_ssrf_proxy_network Created 0.0s✔ Container docker-web-1 Started 1.4s✔ Container docker-weaviate-1 Started 1.2s✔ Container docker-ssrf_proxy-1 Started 1.9s✔ Container docker-sandbox-1 Started 1.9s✔ Container docker-redis-1 Started 1.4s✔ Container docker-db-1 Started 1.7s✔ Container docker-worker-1 Started 2.6s✔ Container docker-api-1 Started 2.8s✔ Container docker-nginx-1 Started 3.7s

启动完成后,你的 docker 里就会看到这个:

也可以在Docker-Compose中查看到已启动的容器。

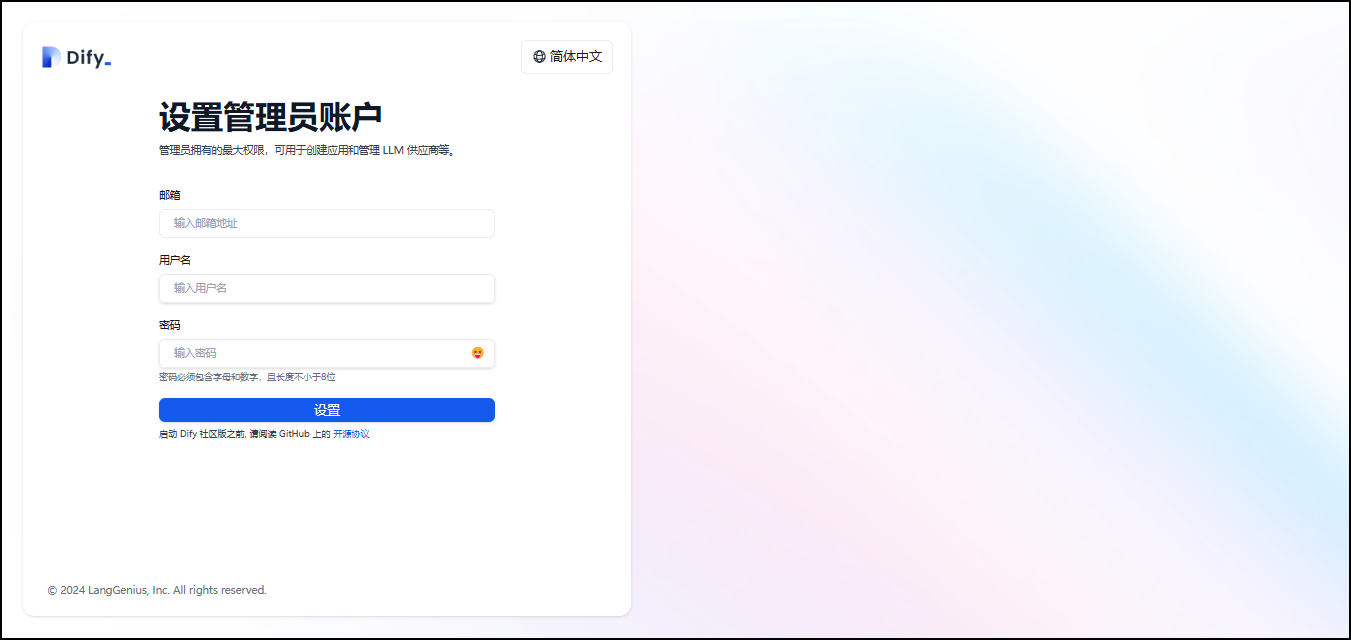

9. 注册Dify账号

打开浏览器,输入http://127.0.0.1

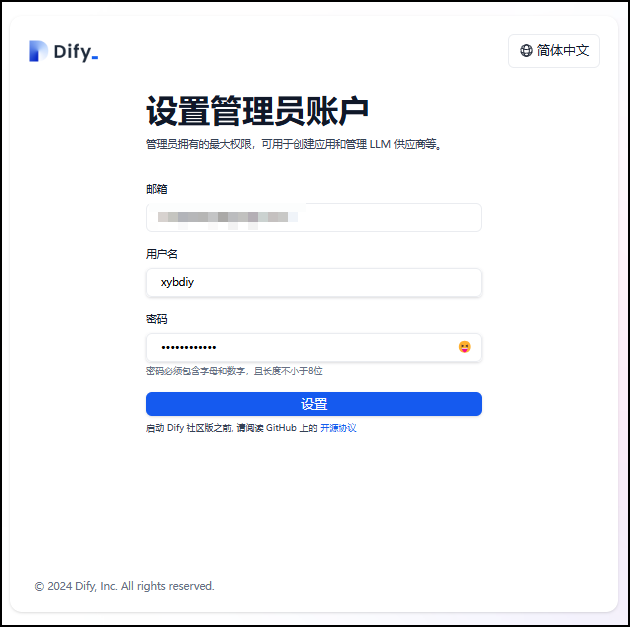

设置管理员账户。输入邮箱、用户名、密码。

填写完成后,点击设置。

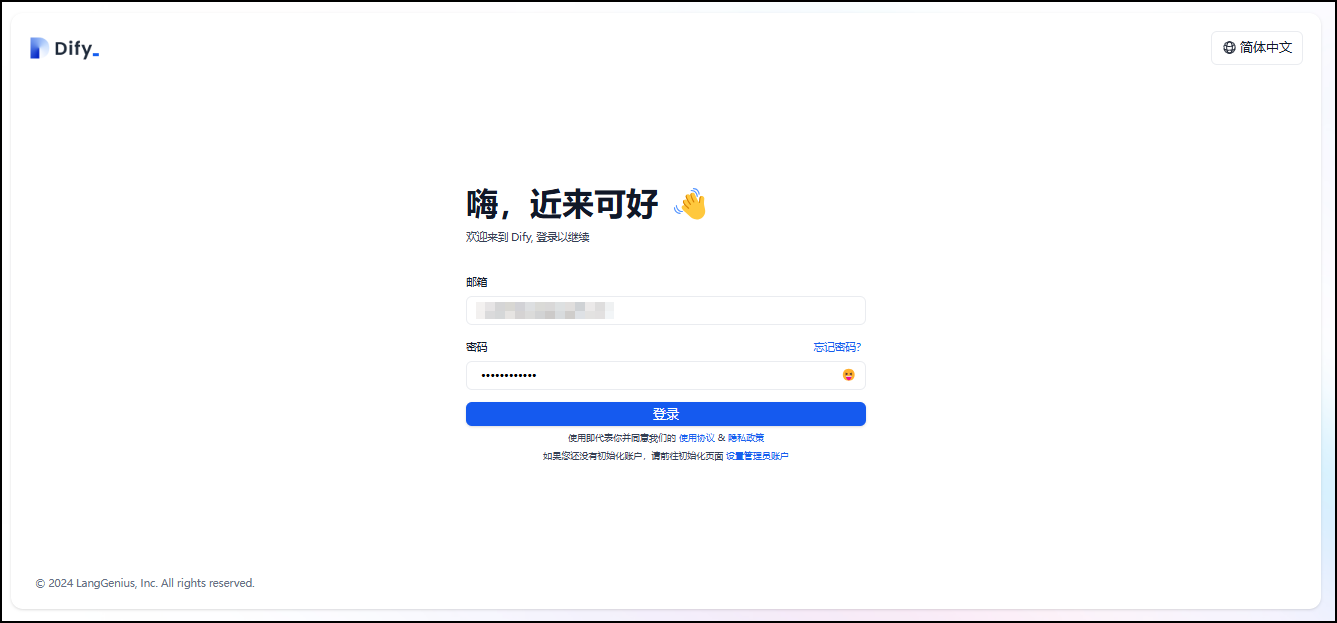

跳转至登录揭秘那,输入邮箱和密码完成登录。

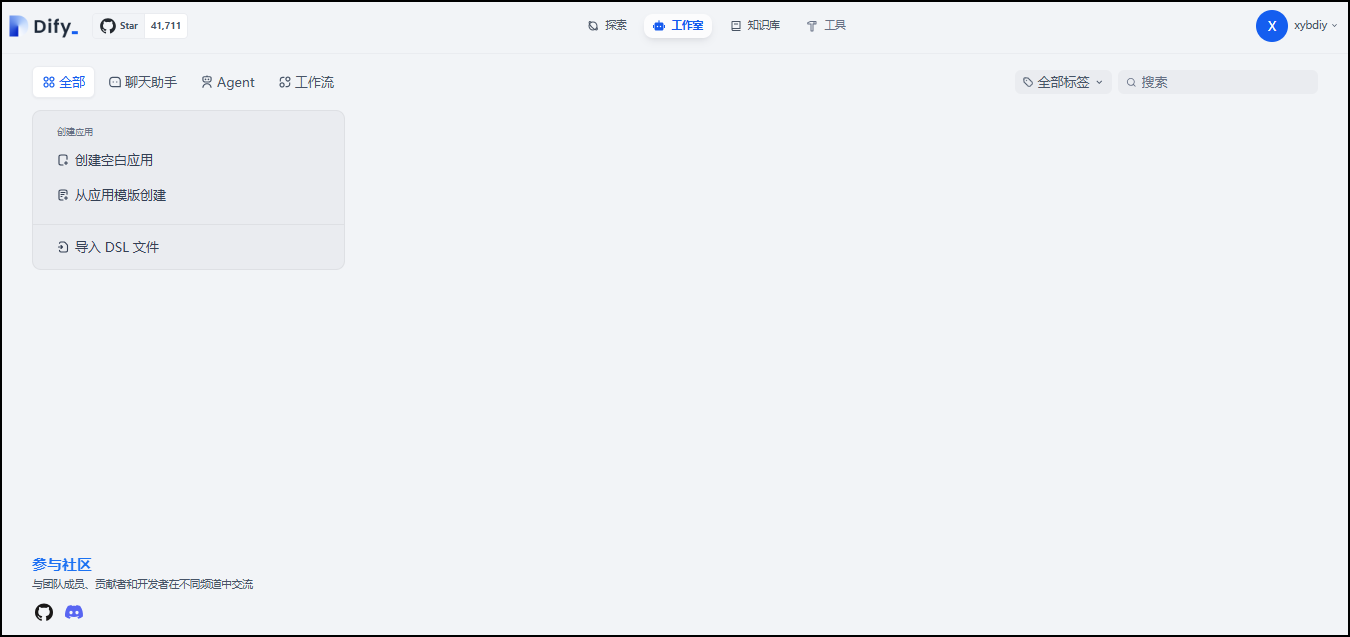

至此,我们利用Docker Compose 在Windows本地环境中,完成Dify的搭建部署工作。

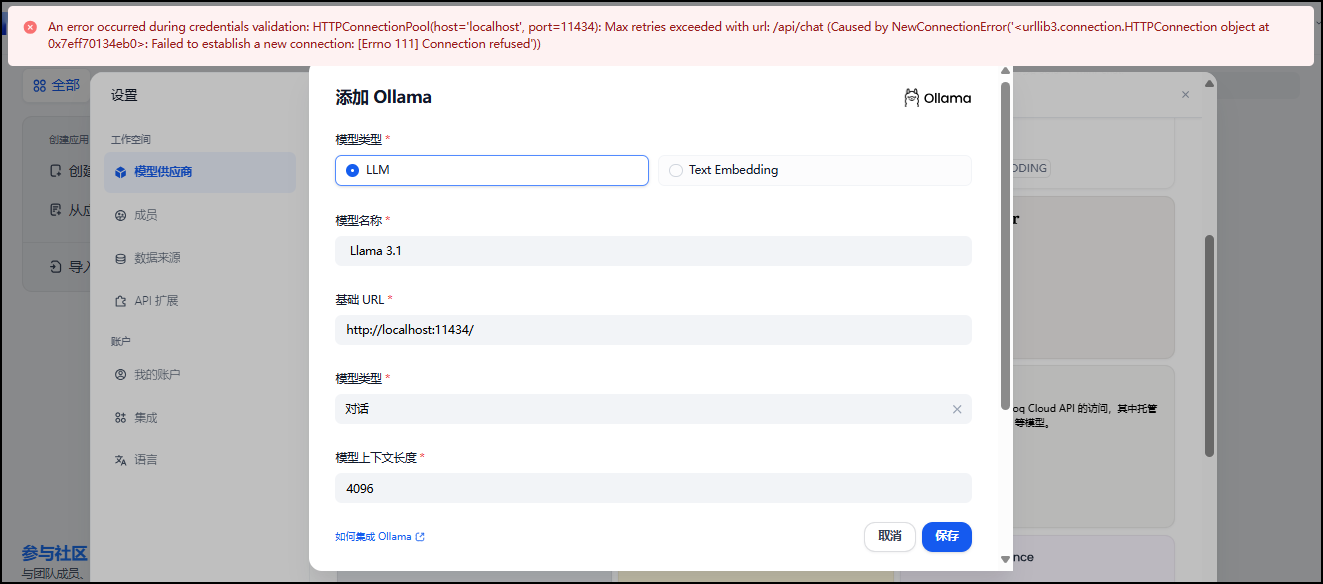

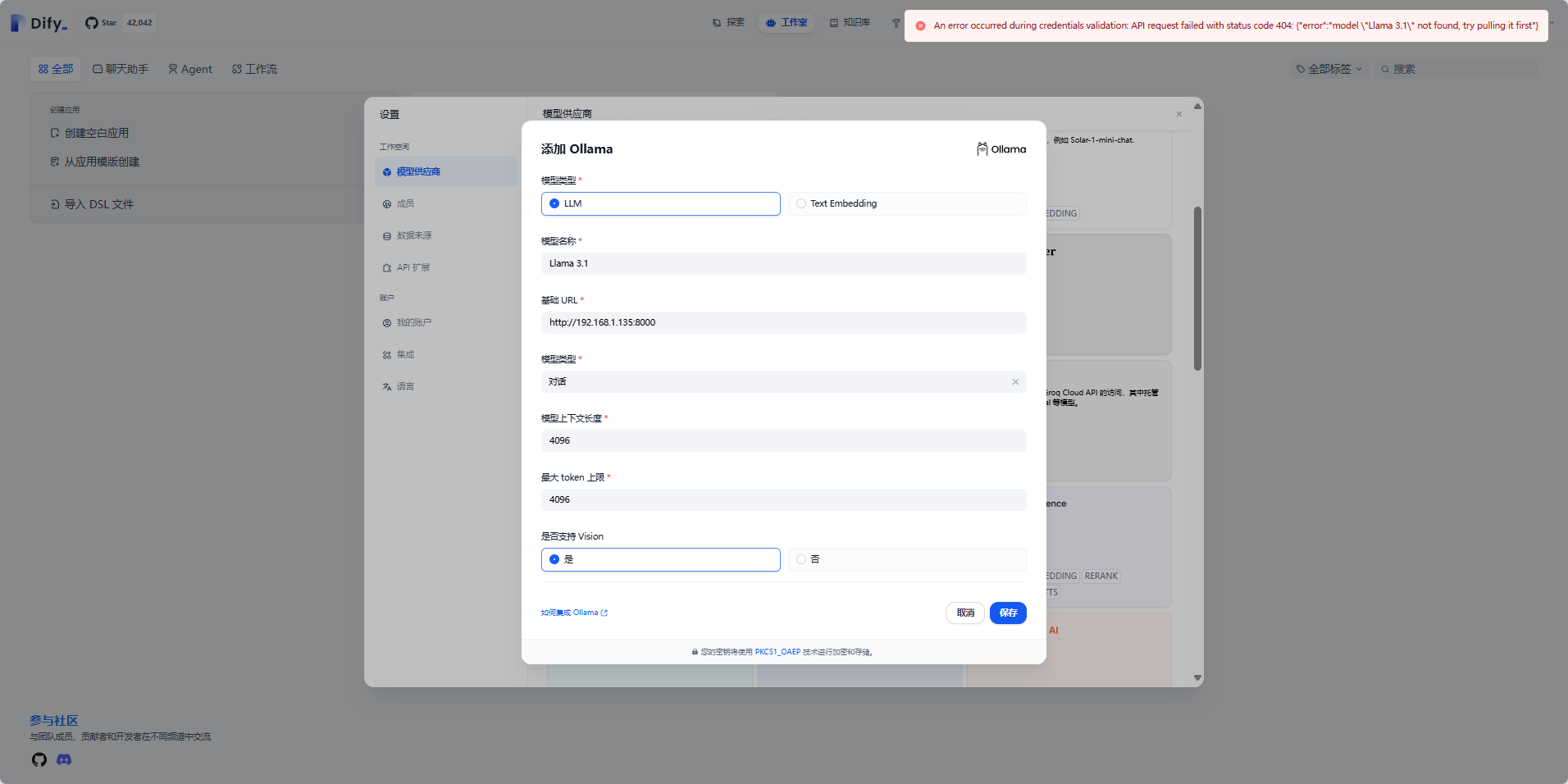

10. 集成本地部署的 Llama 3.1模型

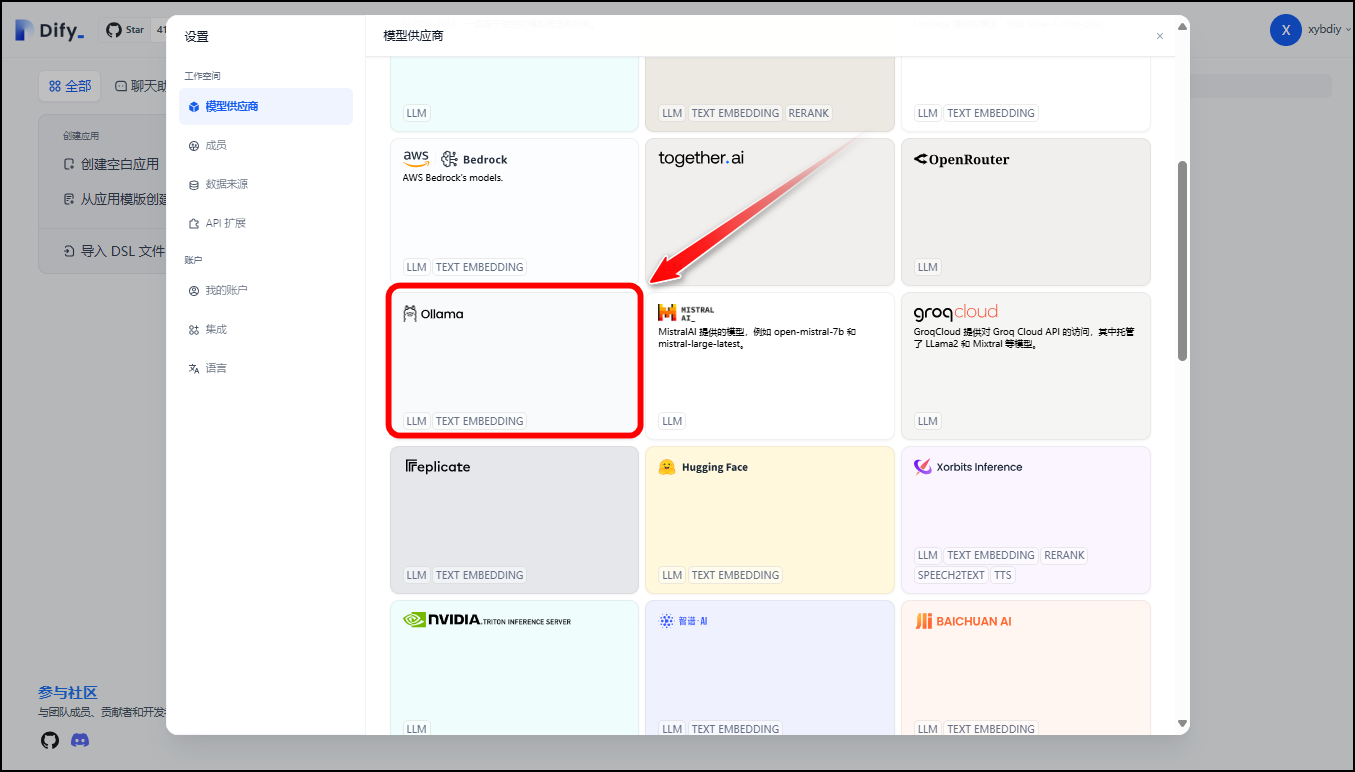

- 点击

设置。

- 选择模型提供商

Ollama

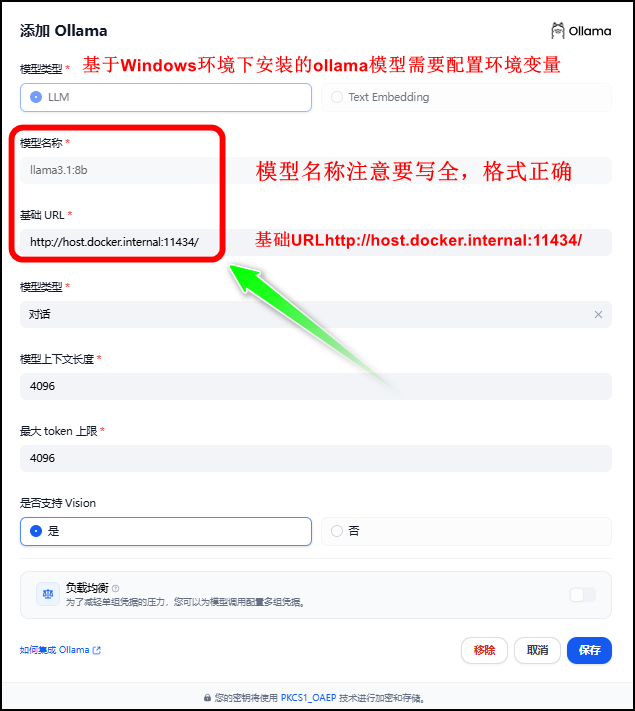

填写如下参数信息。

!!!注意!!!:模型名称和基础URL要填写正确,否则会添加失败报错。

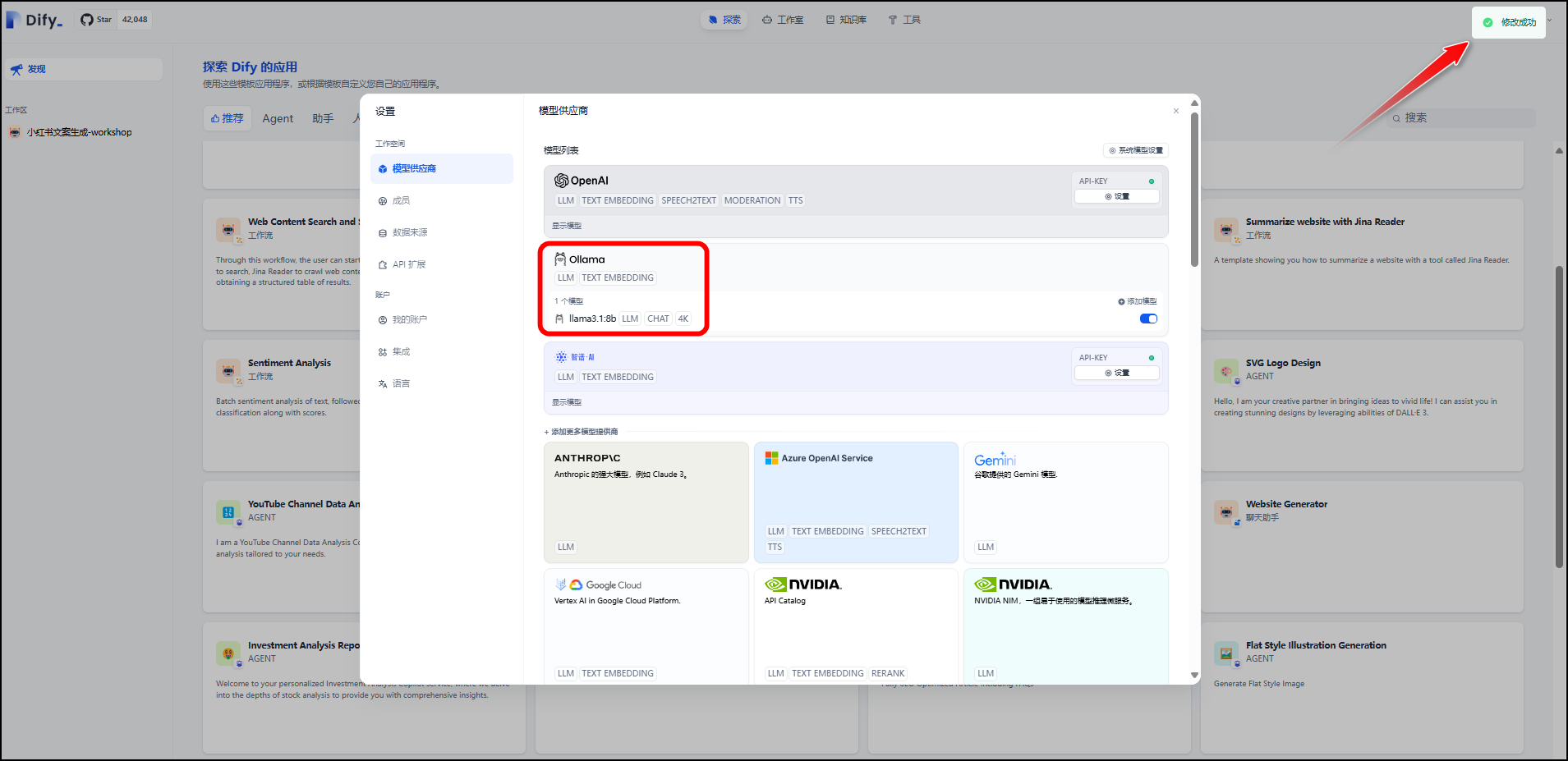

- 添加成功。

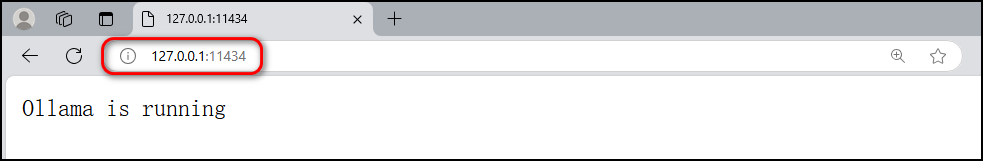

- 我们也可以输入以下地址,验证所添加的ollama模型是否已启动。

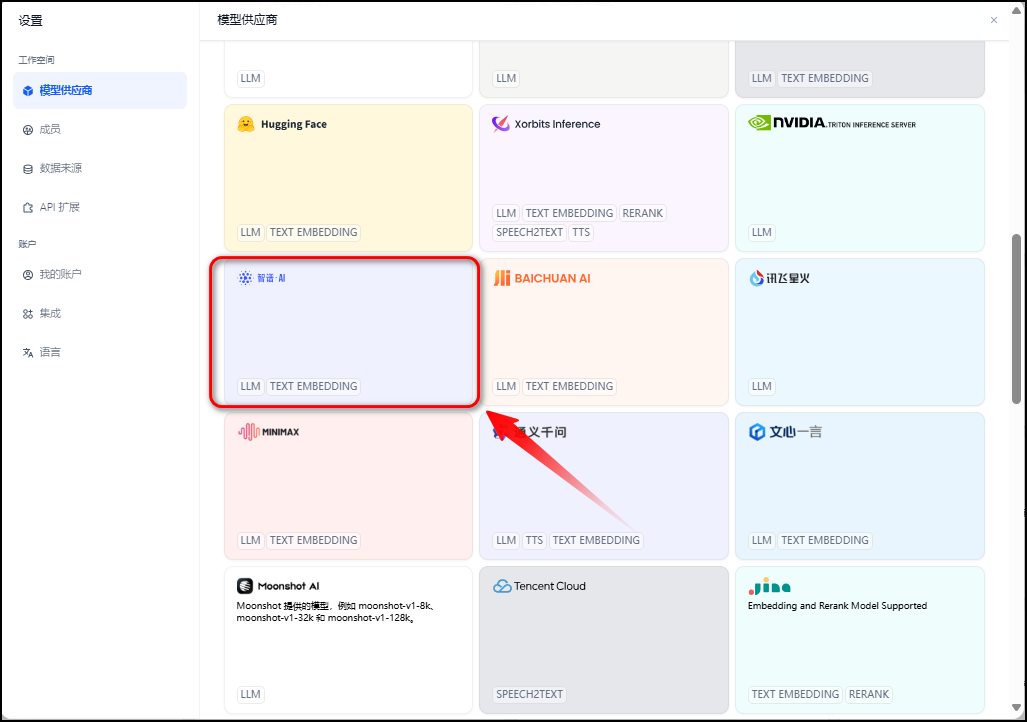

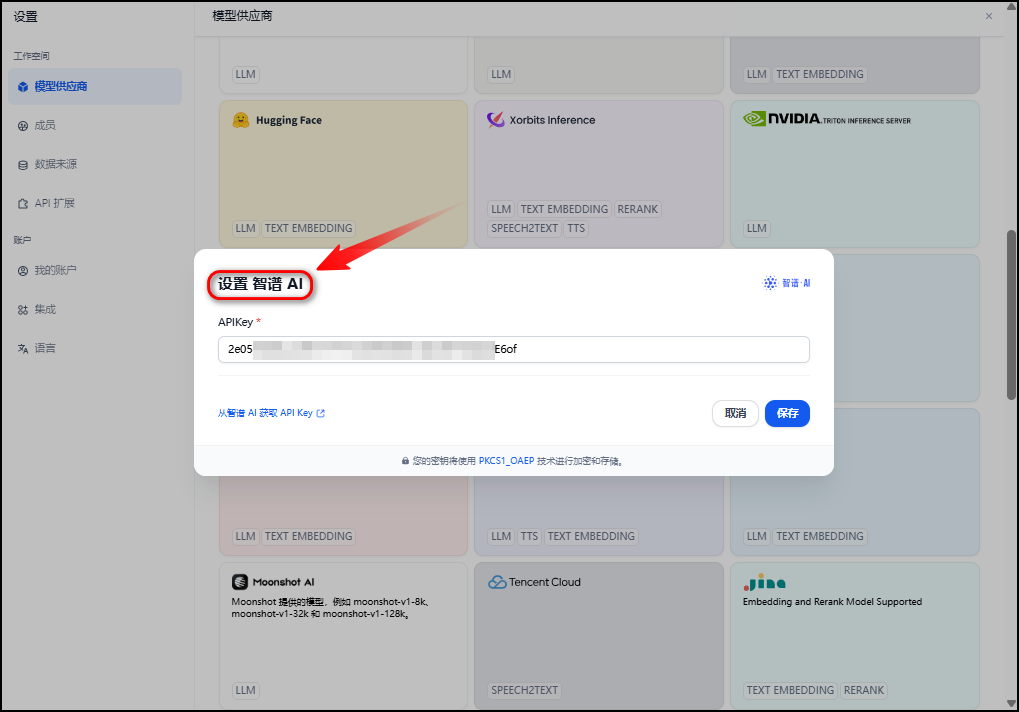

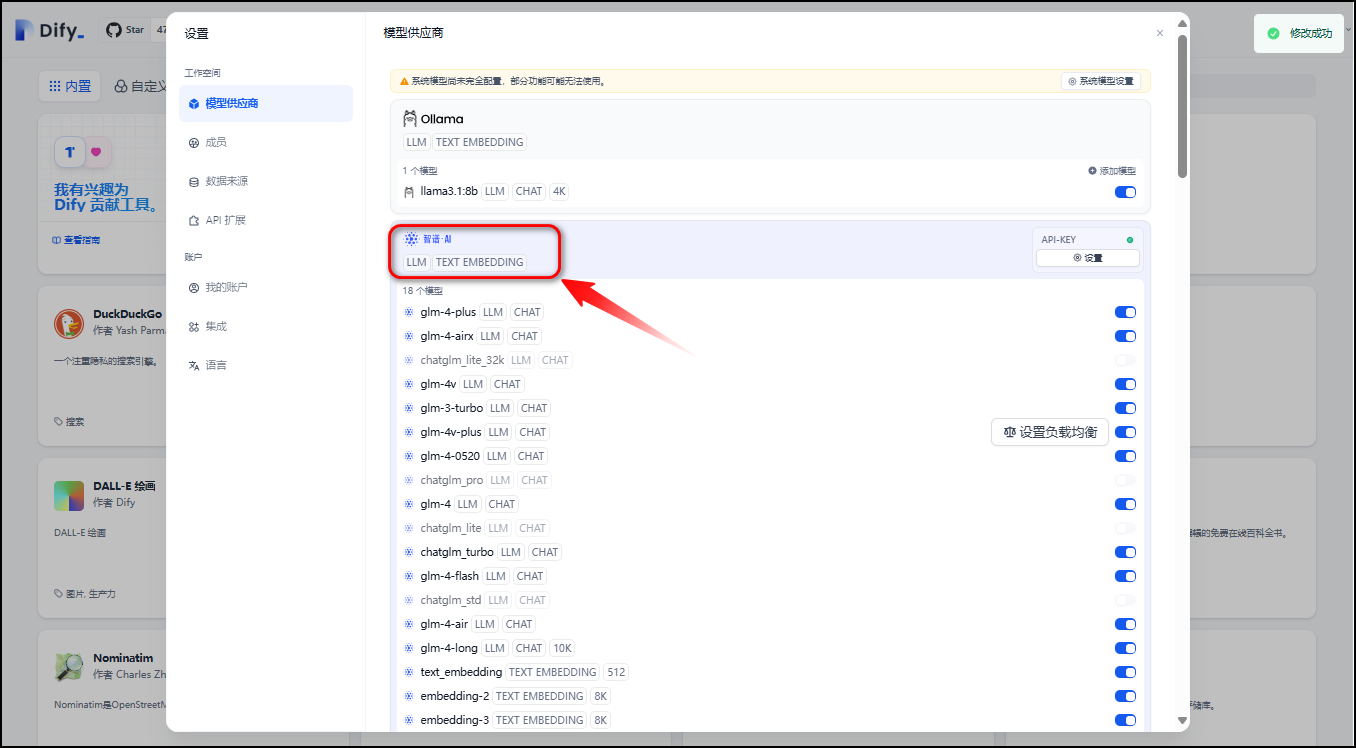

11. 集成智谱AI大模型

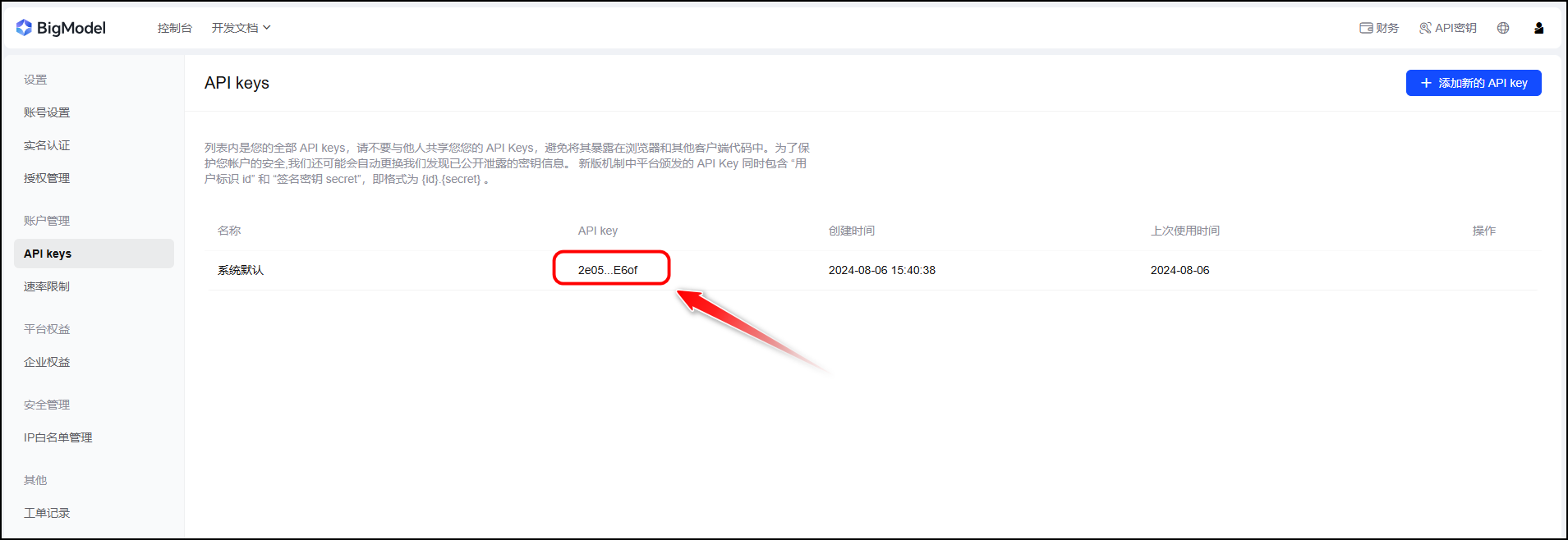

- 获取智谱 AI API Key

获取链接:智谱AI开放平台

2e0556xxxxxxxxxxxxxxxxxxxxxxxxxxxE6of

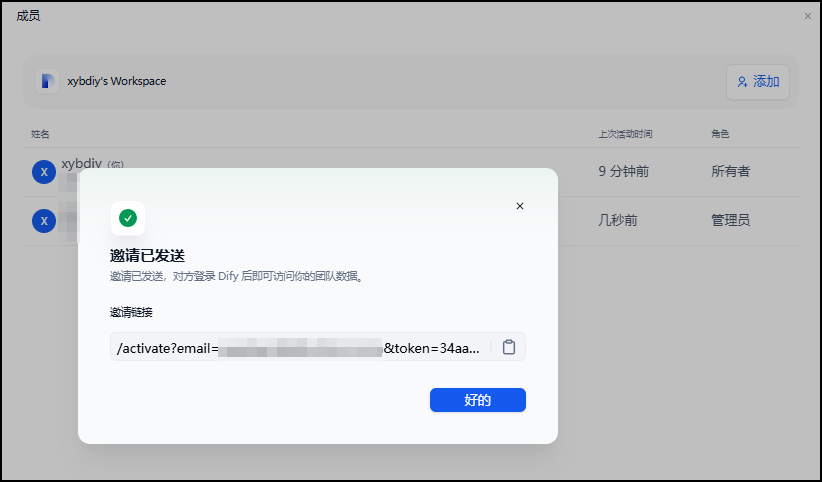

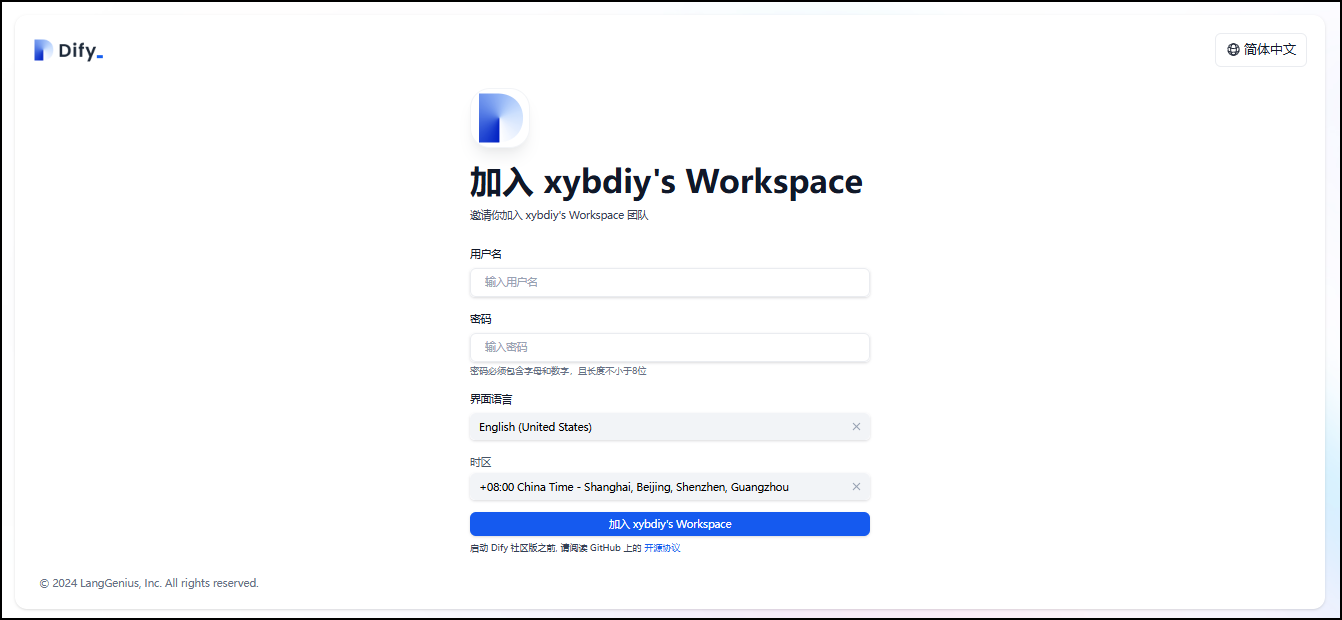

12. 添加Dify团队成员

http://127.0.0.1/activate?email=xxxxxxxx@outlook.com&token=34aa37d7-7d9a-4b64-9ed6-d0372380ad7f

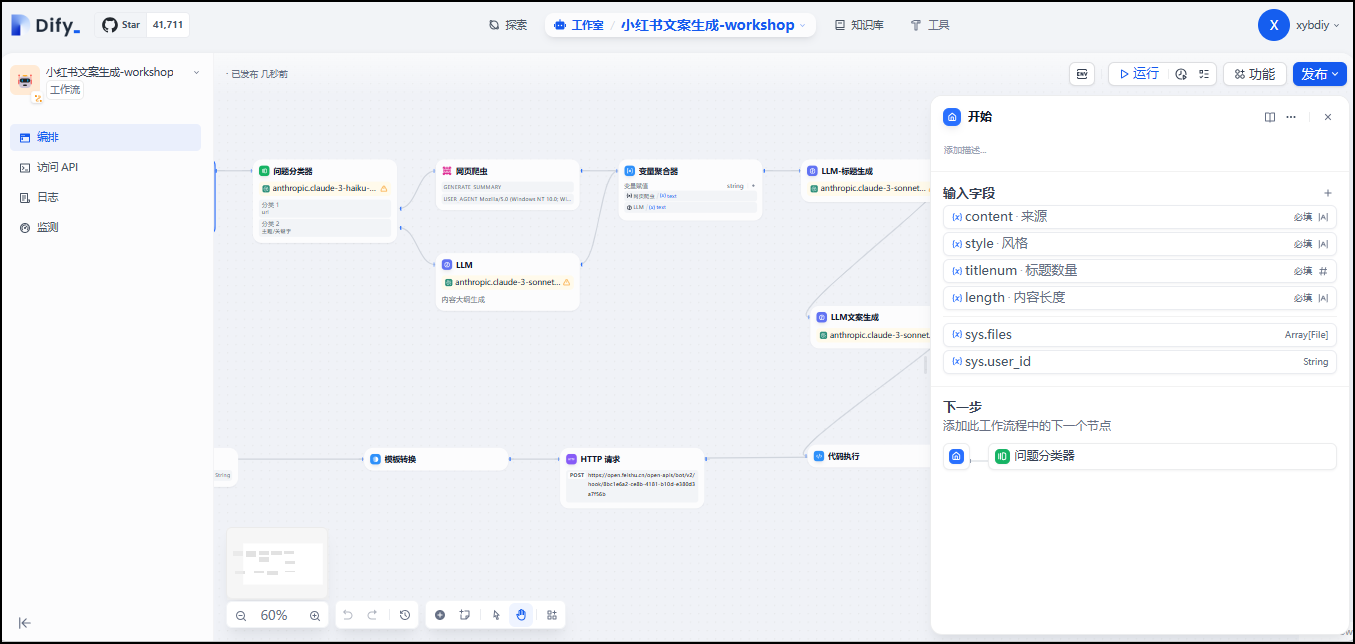

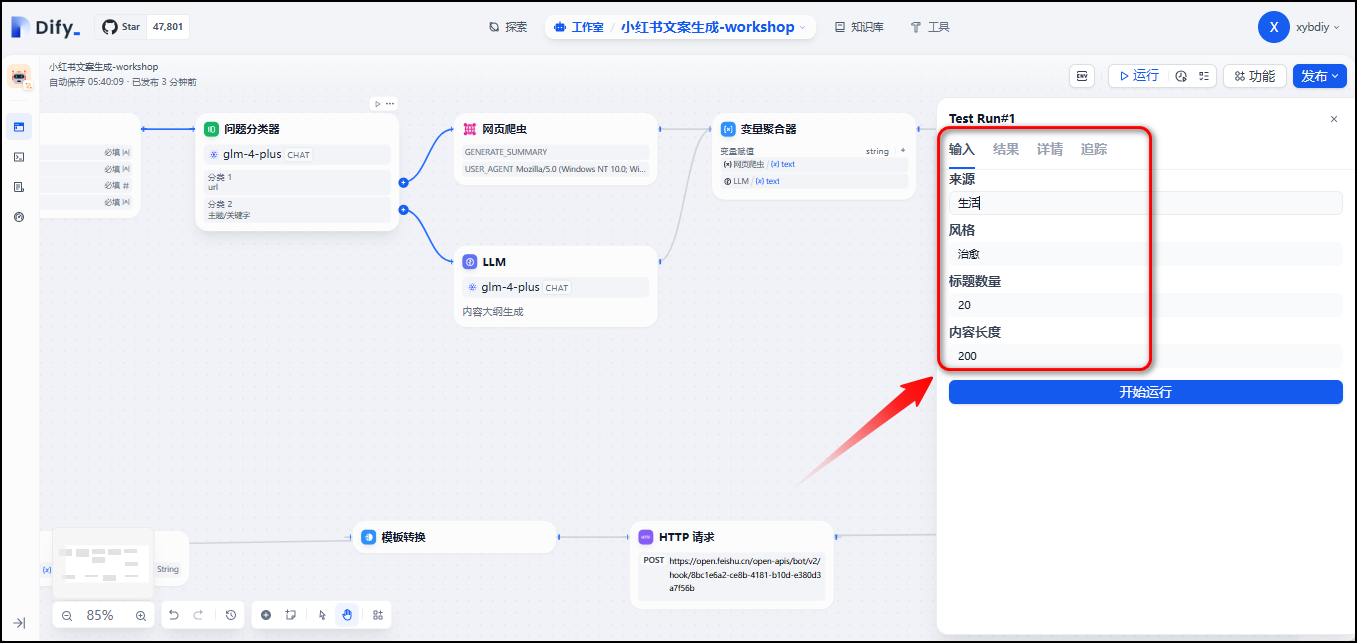

13. 导入DSL - 小红书文案生成脚本

- 导入DSL

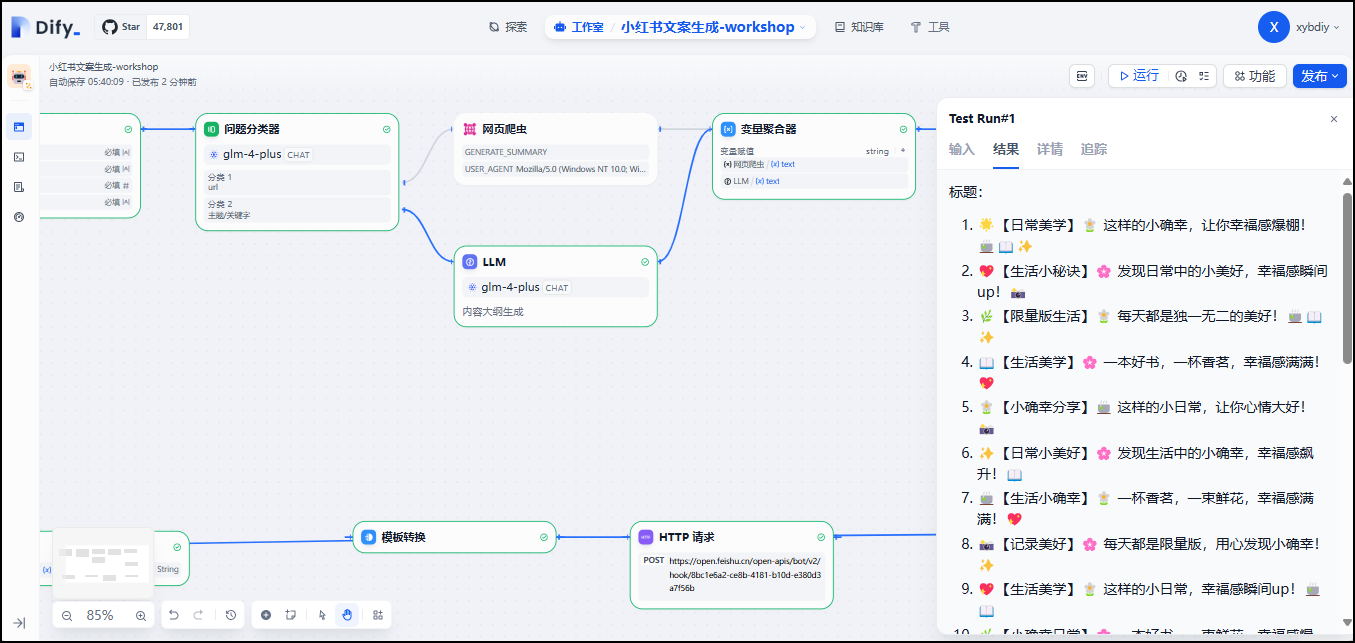

- 小红书文案生成脚本工作流如下:

- 输入关键字

- 输出结果

- 生成内容如下:

标题:

1. 🌟【日常美学】🌼 这样的小确幸,让你幸福感爆棚!🍵📖✨

2. 💖【生活小秘诀】🌸 发现日常中的小美好,幸福感瞬间up!📸

3. 🌿【限量版生活】🌼 每天都是独一无二的美好!🍵📖✨

4. 📖【生活美学】🌸 一本好书,一杯香茗,幸福感满满!💖

5. 🌼【小确幸分享】🍵 这样的小日常,让你心情大好!📸

6. ✨【日常小美好】🌸 发现生活中的小确幸,幸福感飙升!📖

7. 🍵【生活小确幸】🌼 一杯香茗,一束鲜花,幸福感满满!💖

8. 📸【记录美好】🌸 每天都是限量版,用心发现小确幸!✨

9. 💖【生活美学】🌼 这样的小日常,幸福感瞬间up!🍵📖

10. 🌿【小确幸日常】🌸 一本好书,一束鲜花,幸福感爆棚!✨

11. 🌼【日常小秘诀】🍵 发现生活中的小美好,幸福感大增!💖

12. 📖【限量版日常】🌸 每天都是独一无二的美好!📸✨

13. ✨【生活小确幸】🌼 一杯香茗,一本好书,幸福感满满!🍵

14. 🍵【日常美学】🌸 这样的小确幸,让你心情大好!💖

15. 📸【小确幸分享】🌼 发现日常中的小美好,幸福感飙升!📖

16. 💖【记录美好】🌸 每天都是限量版,用心发现小确幸!🌿✨

17. 🌿【生活小美好】🌼 一本好书,一束鲜花,幸福感满满!🍵

18. 🌼【日常小确幸】🍵 这样的小日常,幸福感瞬间up!📸💖

19. 📖【小确幸日常】🌸 发现生活中的小美好,幸福感大增!✨

20. ✨【限量版生活】🌼 每天都是独一无二的美好!🍵📖💖

文案:

🌿🌸【生活小确幸】🍵 每天都是限量版,用心发现生活中的小美好!📖 一杯香茗,🌼 一本好书,简单日常也能闪闪发光✨。分享我的生活小秘诀,幸福感瞬间up up!📸 记录每一刻,生活美学,从心开始💖。你也有这样的小确幸吗?快来评论区分享吧!🌟🌿#生活美学 #小确幸 #日常分享 #幸福感 #记录美好 #限量版生活

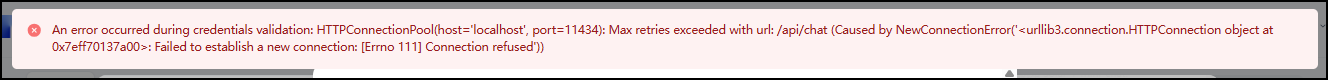

14. 所遇问题

C:\Users\xyb>ollama serve

Error: listen tcp :11434: bind: An attempt was made to access a socket in a way forbidden by its access permissions.C:\Users\xyb>ollama run llama3.1:8b

Error: could not connect to ollama app, is it running?

需要关闭本地环境中的代理。

An error occurred during credentials validation: HTTPConnectionPool(host='127.0.0.1', port=11434): Max retries exceeded with url: /api/chat (Caused by NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7eff701373d0>: Failed to establish a new connection: [Errno 111] Connection refused'))An error occurred during credentials validation: HTTPConnectionPool(host='localhost', port=11434): Max retries exceeded with url: /api/chat (Caused by NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7eff70136260>: Failed to establish a new connection: [Errno 111] Connection refused'))

填写Ollama模型名称和基础URL信息有误导致的。

An error occurred during credentials validation: API request failed with status code 404: {"error":"model \"Llama 3.1\" not found, try pulling it first"}

15. 参考链接

1️⃣https://mp.weixin.qq.com/s/jAX7uI_gjV4e7nzgb_rkrQ

2️⃣https://github.com/langgenius/dify

3️⃣Windows preview · Ollama Blog

4️⃣llama3.1:8b

5️⃣Download Ollama on Windows

6️⃣ollama/ollama: Get up and running with Llama 3.1, Mistral, Gemma 2, and other large language models.

Dify 教程二:使用本地大模型 | Coder 小站 (ihsxu.com)

github.com/langgenius/dify)

3️⃣Windows preview · Ollama Blog

4️⃣llama3.1:8b

5️⃣Download Ollama on Windows

6️⃣ollama/ollama: Get up and running with Llama 3.1, Mistral, Gemma 2, and other large language models.

,tensorflow和Alexnet)

: 安全架构设计考点梳理)

噪声信号的时域分析:均值、方差、与功率)

.)

)