1.Han异构图网络看不懂。。。正在看

https://zhuanlan.zhihu.com/p/346658317

https://www.bilibili.com/video/BV1fc411z7mx?p=19&vd_source=6fb54905ed1c5c332b7a606643d8525c

2.

阅读论文:Learning Long- and Short-Term User Literal-Preference with Multimodal Hierarchical Transformer Network for Personalized Image Caption (lupantech.github.io)

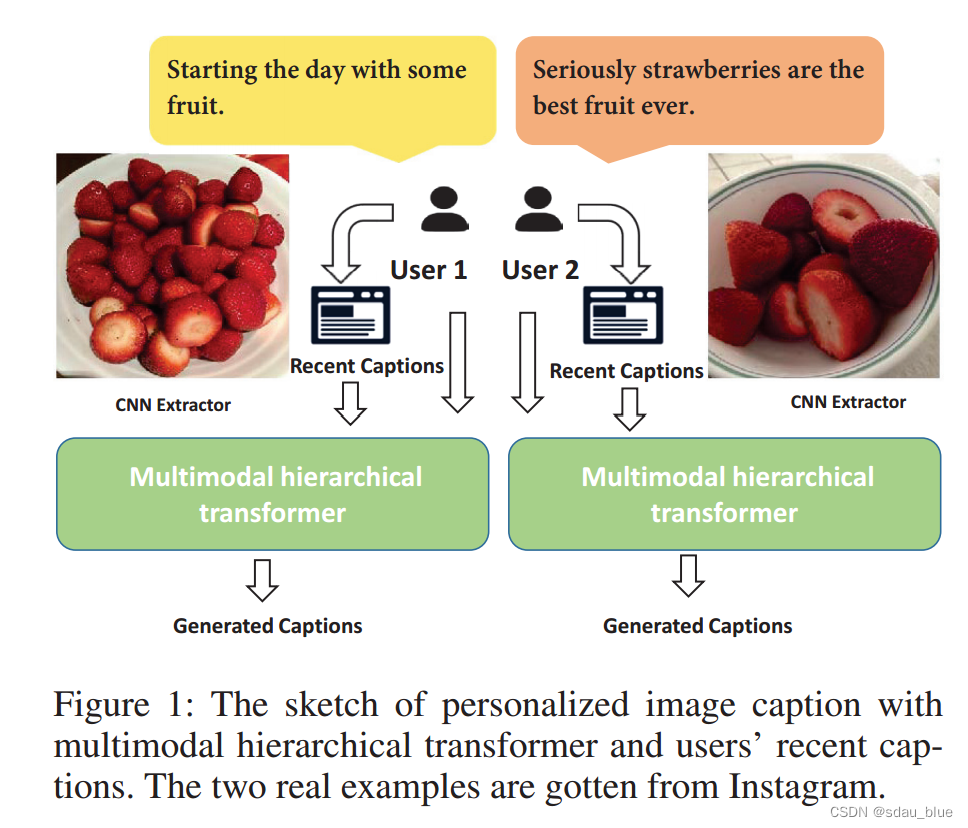

2.1 论文目的:长短期记忆进行个性化图片标题生成

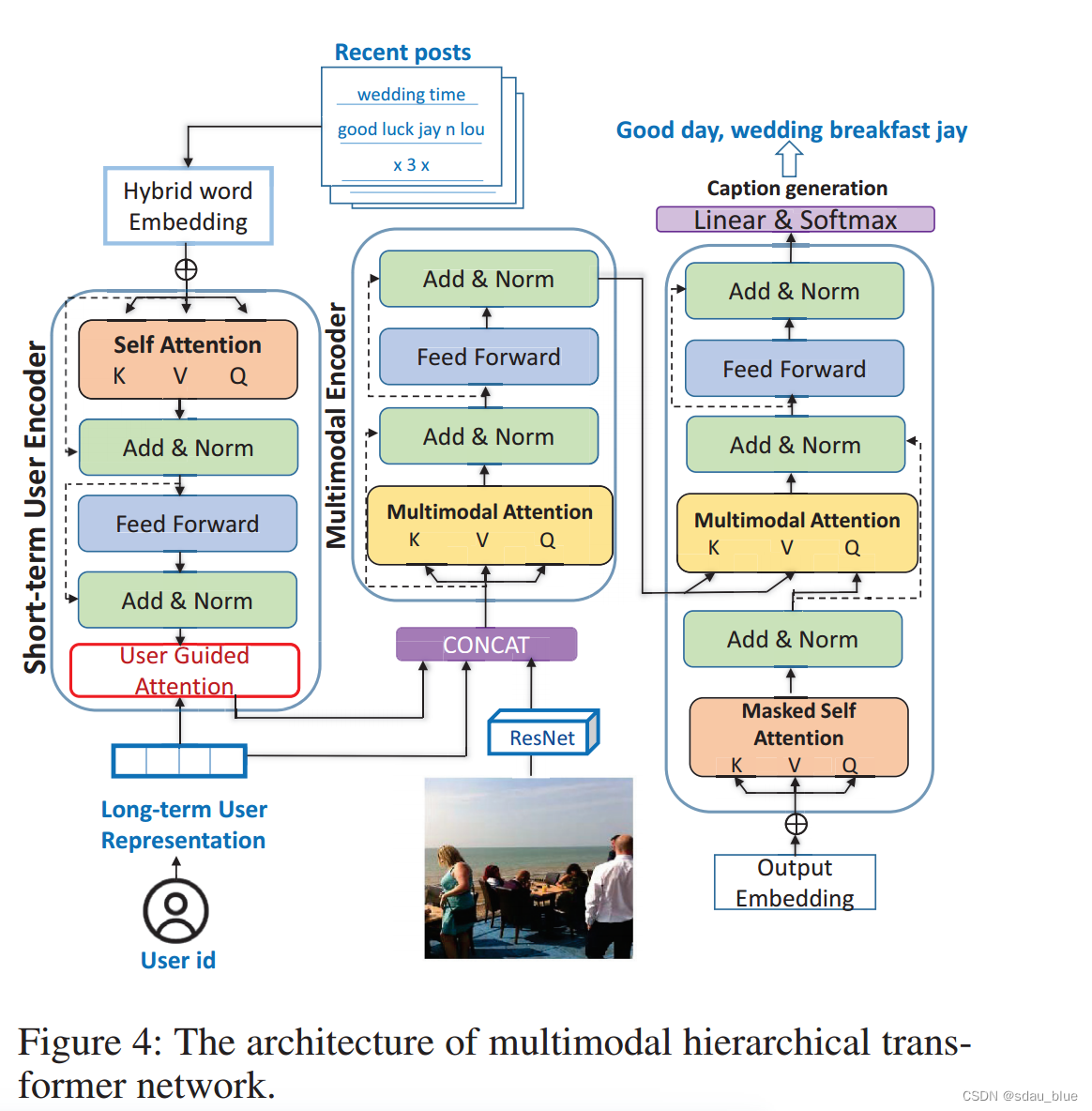

2.2 新型多模态分层变压器网络(MHTN)

个性化内容生成——

1.标题内容生成应该是动态的而非静态的。

2。−inverse document frequency反向文档频率

3.在每个用户标题集中,我们按时间顺序对标题进行排序,并进一步计算平均标题相似度w.r.t.两个标题之间的位置间隔数。本文通过在相似度计算中考虑时间信息对标题相似度进行了深入的分析。图1中的结果描述了一个有趣的现象,即随着位置间隔的增大,标题相似度变小,在前几个位置间隔中,标题相似度急剧下降。这两个数据集的一致观察表明,即使是相同的 Consequently, we can draw a conclusion that the

current caption of a user is more relevant to his recent captions, demonstrating the existence of short-term user literalpreference.用户的标题与他最近的标题更相关。

4.Specifically, user IDs are leveraged to learn

long-term user literal-preference and users’ recently generated captions are employed to encode short-term user literalpreference。

具体来说,利用用户id来学习长期用户文字偏好,使用用户最近生成的标题来编码短期用户文字偏好

5.multimodal hierarchical transformer network多模态分层变压器网络。

输入数据:目标图像、用户最近的标题中的单词和用户id的编码。(多模态的体现)

时间嵌入来表示时间间隔,表征最近使用过的单词

In particular, we empirically set a time interval threshold set as T = {10min, 30min, 2h, 6h, 1d, 3d, 6d, 10d, 1month, 3month, +∞}

长期数据(静态):长期用户表示在线发布其标题的用户通常与用户id相关联。我们的目标是利用id来学习静态用户表示,以捕获他们在图像标题中的长期文字偏好。

6.Hierarchical Transformer Encoder

Hierarchical transformer encoder is composed of a low-level short-term user encoder

and a high-level multimodal encoder.

分层编码器结构:低级短期编码器和高级多模态编码器

7.masked self-attention。细节,为了让学到的不受前后干扰,只受之前的影响

8.

)

)

开发的第四篇)

为Excel表格数据)