利用hadoop计算技术对采集的气象数据信息进行处理,主要分两个阶段:mapper阶段和reducer阶段,mapper阶段主要是对日志文件进行按行读取并进行字符串截取,reducer阶段对mapper阶段传过来的数据进行大小比较,最终获取每一年中的最高温度。

具体气象数据的格式可以参考:https://blog.csdn.net/lihuinihao/article/details/38315209

1. 首先将eclipse将MaxTemperature项目打成jar包,并将jar包和气象数据拖拽到虚拟机上。本文中分析的是1941-1950十年间的数据信息,分别存在10个文件中。

2. 在hdfs系统中新建一个名为/inputdata_t的安装目录

hdfs dfs -mkdir /inputdata_t

3. 将数据集上传到inputdata_t目录下

hdfs dfs -put ~/桌面/19* /inputdata_t

4. 切换到根目录并对数据进行分析

cd

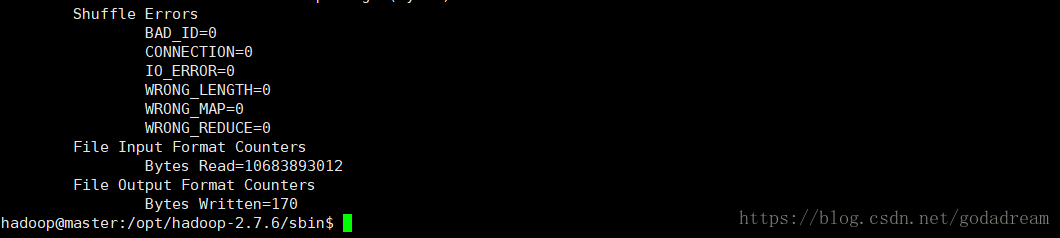

hadoop jar ~/桌面/MaxTemperature.jar MinTemperature /inputdata_t /output/mintemp

5. 查看结果

hdfs dfs -cat /output/mintemp/part-r-00000

6. 下载至本地

hadoop fs -get /output/mintemp/part-r-00000 /opt/hadoop-2.7.6/tmp/

ls ../tmp/

7. 删除文件

hdfs dfs -rm -r /output/mintemp

的用法)

)

和卷积神经网络(CNN))