文章目录

- 1. introduction

- 2.相关工作

- 3.Model

- 3.1 Joint learning as head selection

- 3.2 AT

- 4.实验设置

- 5.结果

- 6.总结

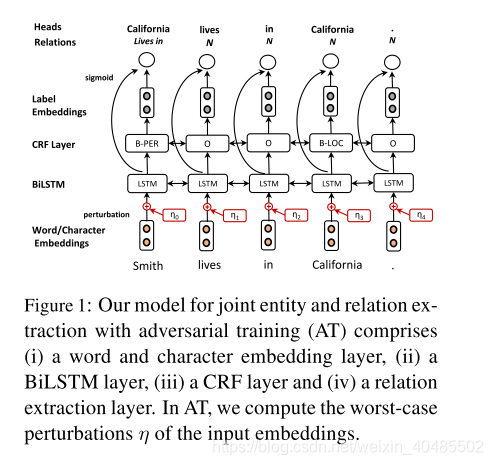

- 实体关系抽取模型

- 对抗学习.

论文链接

code

Bekoulis, G., et al. (2018). “Adversarial training for multi-context joint entity and relation extraction.” arXiv preprint arXiv:1808.06876.

1. introduction

- 稳定性差

- 许多神经网络方法最近被用于各种自然语言处理(NLP)任务,如解析(Zhang et al., 2017)、词性标注(Lample et al., 2016)、关系提取(dos Santos et al., 2015)、翻译(Bahdanau et al., 2015)和联合任务(Miwa and Bansal, 2016)。

- 然而,Szegedy等人(2014)观察到将小尺度扰动输入这样的模型可能会导致不正确的决策(并且有很高的可信度)。

- 使用对抗模型

- Goodfellow et al.(2015)提出了将对抗训练(AT)(用于图像识别)作为一种正则化方法,该方法使用干净的和对抗的混合实例来增强模型的鲁棒性。

- 尽管AT最近已被应用于NLP任务(如文本分类(Miyato et al., 2017)),但就我们所知,这篇论文是首次尝试研究AT在两个相关任务的联合设置下的正则化效果。

- 从基线联合模型开始

- 笔记:基线模型

- 论文:Joint entity recognition and relation extraction as a multi-head selection problem

- code:code

- 本文的核心贡献:在于将AT作为联合提取任务的训练过程的扩展(第3.2节)。

2.相关工作

-

联合实体和关系提取:

- 联合模型(Li and Ji, 2014;Miwa和Sasaki(2014)提出了一种基于手动提取特征的方法,用于同时执行命名实体识别(NER)和关系提取子任务。

- 缺点:这些方法依赖于NLP工具的可用性(例如,POS标记器)或手动设计的特性,从而导致额外的复杂性。

- 神经网络方法已经被用来克服这一特征设计问题,通常涉及到RNNs和CNNs (Miwa和Bansal,2016; Zheng et al., 2017).)

- 具体而言,Miwa和Bansal(2016)以及Li等人(2017)将双向树状结构的RNNs应用于不同的上下文(即捕获语法信息(使用外部依赖解析器)。

- Gupta等人(2016)提出使用各种手动提取的特征和RNNs。

- Adel和Sch utze(2017)解决了实体分类的简单问题(假设给出了实体边界EC),而不是NER,他们复制实体周围的上下文,将实体对提供给关系提取层。

- Katiyar和Cardie(2017)仔细研究了RNNs,但没有考虑到关系标签并不相互排斥。

- 最后,Bekoulis等人(2018a)在联合模型中使用LSTMs一次只提取一个关系,但增加了NER部分的复杂性。

- 我们的基线模型支持同时从相同的输入中提取多个关系。然后,我们使用对抗性训练进一步扩展这个强基线。

-

对抗性训练(AT)

- (Goodfellow等,(2015)提出了AT使分类器在图像识别环境下对输入扰动具有更强的鲁棒性。

- 在NLP的背景下,针对不同的任务提出了几个变体,如文本分类(Miyato et al., 2017)、关系提取(Wu et al., 2017)和词性标注(Yasunaga et al., 2018)。

- AT被认为是一种正则化方法。

- 不像其他的正则化方法。, dropout (Srivastava et al., 2014), word dropout (Iyyer et al., 2015)引入随机噪声,

- AT产生扰动,这些扰动是很容易被模型错误分类的例子的变体。

3.Model

3.1 Joint learning as head selection

- 基线模型(详见前文Joint entity recognition and relation extraction as a multi-head selection problem

3.2 AT

- 目的:对扰动更稳定

- 我们利用AT (Goodfellow et al., 2015)的思想作为正则化方法,使我们的模型对输入扰动具有鲁棒性。具体来说,

- 反例的生成:我们通过在连接词表示的层次上添加一些噪声来生成原示例的变体(Miyato et al., 2017)。这与Goodfellow等(2015)提出的提高图像识别分类器鲁棒性的概念类似。

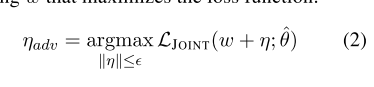

- 我们生成一个敌对的例子通过添加最坏扰动ηadv原嵌入w最大化损失函数

- 因为2很棘手,所以用近似定义ηadv=ϵg/∣∣g∣∣\eta_{adv}=\epsilon g/||g||ηadv=ϵg/∣∣g∣∣

- g=▽wLJOINT(w;θ^)g=▽_wL_{JOINT}(w;\hat{\theta})g=▽wLJOINT(w;θ^)

- ϵ=αD−−当超参数,D是词嵌入的维度\epsilon=\alpha\sqrt{D}--当超参数,D是词嵌入的维度ϵ=αD−−当超参数,D是词嵌入的维度.

- 最终损失函数为:原+反例

- LJOINT(w;θ^)+LJOINT(w+ηadv;θ^)L_{JOINT}(w;\hat{\theta})+L_{JOINT}(w+\eta_{adv};\hat{\theta})LJOINT(w;θ^)+LJOINT(w+ηadv;θ^)

4.实验设置

- 实验设置

- 交叉验证

- 早停

- 和以前工作相同的嵌入

- 相同的数据集下和以前工作相同的处理

- adam优化器

- α,dropout,best-epoch,学习率

- 超参数

- α:{5e−2,1e−2,1e−3,1e−45e^{-2},1e^{-2},1e^{-3},1e^{-4}5e−2,1e−2,1e−3,1e−4}–扰动

- 更大的α值(即。在我们的早期实验中,较大的扰动会导致一致性的性能下降。这可以从增加噪音会改变句子内容这一事实来解释,Wu et al.(2017)也报道了这一现象。

- α:{5e−2,1e−2,1e−3,1e−45e^{-2},1e^{-2},1e^{-3},1e^{-4}5e−2,1e−2,1e−3,1e−4}–扰动

- ACE04数据集:五折交叉验证 * 具体来说,我们遵循Miwa和Bansal(2016)为ACE04数据集定义的5倍交叉验证(Doddington et al., 2004)。

- 对于CoNLL04 (Roth和Yih, 2004) EC任务(假设给出了边界),我们使用与Gupta等人(2016)相同的分割;Adel和Sch¨utze(2017)。

- NER * 10折交叉验证

- 对于荷兰房地产分类,DREC (Bekoulis et al., 2017)数据集,我们使用训练-测试分割如在Bekoulis et al. (2018a)。

- 对于不良药物事件,ADE (Gurulingappa et al., 2012),我们进行了与Li et al.(2017)类似的10倍交叉验证。

- 为了获得不受输入嵌入影响的可比结果,我们使用了以前工作的嵌入。我们在所有的实验中都采用了提前停止的方法。我们使用Adam优化器(Kingma和Ba,2015)并修复超参数(即α,dropout,best-epoch,学习率)验证集。

- 三种类型的评估

- S(strict)

- 如果实体边界和实体类型都是正确的,我们就将实体评为正确的(ACE04, ADE, CoNLL04, DREC)

- B(边界)

- 如果实体边界是正确的,而没有考虑实体类型(DREC),则我们将实体视为正确的

- R(relaxed)

- 如果为组成实体的令牌分配了至少一个正确类型,则认为多令牌实体是正确的,假设边界是已知的(CoNLL04),以比较以前的作品。在所有情况下,当关系类型和参数实体都正确时,关系被认为是正确的。

- S(strict)

5.结果

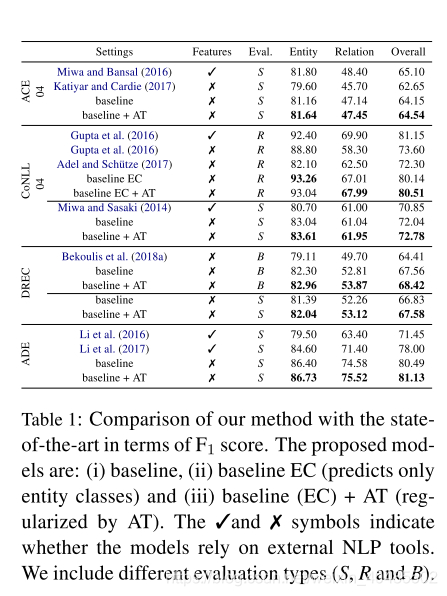

表1显示了我们的实验结果。数据集的名称在第一列中显示,而模型在第二列中列出。提出的模型如下:

(i)基线:图1所示的具有CRF层和sigmoid损失的基线模型, (ii)基线EC:具有用于EC的softmax层的模型,

(iii)基线(EC) + AT:使用AT的基线正则化。

最后三列显示两个子任务的F1结果及其平均性能。粗体值表示只使用自动提取的特征的模型的最佳结果。

- 这些自动提取的特征之所以表现出性能改进,主要是因为共享的LSTM层学会了在单个模型中自动生成实体及其对应关系的特征表示。

- 这种看似很小的性能提升主要是由于NER组件的性能收益有限,这与NER使用神经网络的最新进展相一致,神经网络也报告了类似的小收益

- 这可能表明在联合模型的上下文中,数据集的大小和对抗性训练的好处之间存在相关性,但这需要在未来的工作中进行进一步的研究。

6.总结

我们提出了将对抗性训练用于实体识别和关系提取的联合任务。

- 本研究的贡献有两方面:

- (i)研究AT作为一种多上下文基线联合模型的正则化方法的一致性有效性,以及

- (ii)大规模的实验评估。

- AT分别提高了每个任务的结果,以及基线联合模型的整体性能,同时在训练过程的第一个阶段就已经达到了高性能。

)

)

)

)

2017)

)