文章目录

- abstract

- 1.Introduction

- 2 背景

- 3.数据收集

- 4.Model

- 5.实验

- 6.result

- 7 Model Analysis and Timelines

Vashishtha, S., et al. (2019). Fine-Grained Temporal Relation Extraction. Proceedings ofthe 57th Annual Meeting ofthe Association for Computational Linguistics.

code

abstract

我们提出了一种新颖的语义框架,用于建模时间关系和事件持续时间,该事件框架将事件对映射到实际值尺度。我们使用这个框架来构造迄今为止最大的时间关系数据集,涵盖了通用依赖英语Web树库的全部。我们使用该数据集来训练模型,以共同预测细粒度的时间关系和事件持续时间。我们对我们的数据报告了强有力的结果,并显示了转移学习方法预测分类关系的有效性。

- 提出

- 语义框架

- 建模时间关系和事件持续时间

- 时间关系数据集

- 最大

- 用上述框架构造

- 涵盖了通用依赖英语web树库的全部

- 目标:联合预测细粒度的时间关系和事件持续时间

- 语义框架

1.Introduction

自然语言提供了无数形式和词汇手段来表达复杂事件的时间结构,例如时态,方面,助词,状语,协调者,从属等。但是,这些设备通常不足以确定这种事件的细粒度时间结构。考虑(1)中的叙述。

(1) At 3pm, a boy broke his neighbor’s window. He was running away, when the neighbor rushed out to confront him. His parents were called but couldn’t arrive for two hours because they were still at work.

大多数以英语为母语的人很难为这些事件制定时间表,很可能会产生如图1所示的结果。但是我们怎么知道破裂,逃跑,对抗和呼唤很短,而父母在工作呢?又为什么前四个应该依次排列,最后一个包含其他?

这些问题的答案可能一方面涉及语言信息与关于事件及其关系的常识之间的复杂相互作用(Minsky,1975; Schank和Abelson,1975; Lamport,1978; Allen和Hayes)。 ,1985; Hobbs等,1987; Hwang和Schubert,1994)。但这仍然是一个问题,如何最好地捕捉这种互动。

- 细粒度时间结构

- 一般事件的表达:形式和词汇手段(很多

- 但不足以描述细粒度的时间结构

- 涉及:常识与语言信息的互动

- 解决办法:

- 时间关系抽取任务

- 视作分类问题

- 标记成对的事件引用表达式(动作)和具有时效性的表达式(时间)

- 缺点:必须依靠时参表达式–来表达持续信息

- 时间持续信息可以隐式表达而不妨碍理解

- 映射到时间线上(本文)

- 时间关系抽取任务

- 一般事件的表达:形式和词汇手段(很多

- Duration,Vashishtha, S., et al. (2019)

- 用于:时间关系表示

- 特点:将事件持续时间放在首位或居中

- 参考:Allen(1983)关于时间间隔表示

- 改变:为绝对的时间关系标注文本—>

- 将事件映射到其可能的持续时间上,

- 并将事件对直接映射到实际值的相对时间线

- 由持续时间来预测关系ok

- 由关系来预测持续时间降低了性能

- 时间关系数据集

- 大多基于TimeML标准的

- TimeBank

- 是使用此标准构建的最早的大型语料库之一,

- 旨在捕获事件之间的“显着”时间关系(Pustejovsky等,2003)

- 稀疏

- TemEval比赛(有数据集

- covering relations between all the events and times in a sentence.

- 基于TimeBank

- TimeBank-Dense

- 这种稀疏性已通过语料库解决

- 其中注释器标记了所有本地边缘,而无歧义(Cassidy等,2014)。

- TimeBank-Dense不会捕获事件和时间关系上的完整图形,

- 而是试图通过捕获一个句子内以及相邻句子之间的所有关系来实现完整性。

- <—本文的灵感

- Hong et al. (2016) build a cross-document event corpus

- 涵盖了细粒度的事件-事件关系和具有更多事件类型和子类型的角色

- (另见Fokkens等人,2013)。

- TimeBank

- UDS-T数据集(本文)

- 结果数据集-通用分解语义时间(UDS-T)-是迄今为止最大的时间关系数据集,

- 比基于TimeML标准的好

- 涵盖了所有的通用依赖性(Silveira等人,2014; De Marneffe等人,2014; Nivre等人,2015 )English Web Treebank(Bies等,2012)。

- UD-EWT的优点:

- (i)涵盖了各种流派的文本;

- (ii)它包含黄金标准的通用依赖性解析;

- (iii)它与使用相同谓词提取标准的各种其他语义注释兼容

- (White等人,2016; Zhang等人,2017; Rudinger等人,2018; Govindarajan等人,2019)。

- UD-EWT的优点:

- 大多基于TimeML标准的

解决办法1:一条有希望的攻击路线在于时间关系提取的任务。该领域的先前工作已将该问题作为分类问题来解决,它会标记成对的事件引用表达式,例如在(1)中中断或正在工作-以及具有时效性的表达式-例如下午3点或两个小时-具有绝对的时间关系(Pustejovsky等人,2003; Styler IV等人,2014; Minard等人,2016)。这种方法的缺点是必须依靠时参考表达式来表达持续时间信息。但是,正如(1)所强调的那样,几乎所有时间持续时间信息都可以保留为隐式而不妨碍理解,这意味着这些方法仅在语言上实现时才对持续时间信息进行显式编码。

本文:在本文中,我们为时间关系表示开发了一个新颖的框架,该框架将事件持续时间放在首位和居中。就像使用TimeML标准的标准方法一样,我们从Allen(1983)关于时间间隔表示的开创性工作中汲取了灵感。但是,我们没有为类别的时间关系注释文本,而是将事件映射到其可能的持续时间,并将事件对直接映射到实际值的相对时间线。此更改不仅支持为事件持续时间提供更重要作用的目标,而且还使我们能够更好地推理整个文档所描述的复杂事件的时间结构。

我们首先讨论有关时间关系提取的先前工作(第2节),然后介绍我们的框架和数据收集方法(第3节)。结果数据集-通用分解语义时间(UDS-T)-是迄今为止最大的时间关系数据集,涵盖了所有的通用依赖性(Silveira等人,2014; De Marneffe等人,2014; Nivre等人,2015 )English Web Treebank(Bies等,2012)。我们使用该数据集来训练各种神经模型(第4节),以共同预测事件持续时间和细粒度(实值)时间关系(第5节),不仅对我们的数据集产生强结果,而且还产生了竞争表现基于TimeML的数据集(§6)

2 背景

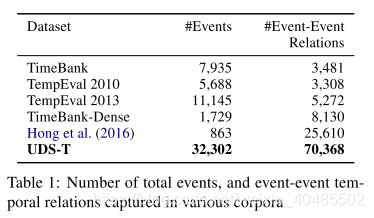

语料库大多数大型时间关系数据集都使用TimeML标准(Pustejovsky等人,2003; Styler IV等人,2014; Minard等人,2016)。TimeBank是使用此标准构建的最早的大型语料库之一,旨在捕获事件之间的“显着”时间关系(Pustejovsky等,2003)。TempEval竞赛建立在TimeBank上,涵盖了句子中所有事件和时间之间的关系。

- 模型早期的时间关系提取系统使用手动标记的特征,这些特征已通过多项逻辑回归和支持向量机建模(Mani等,2006; Bethard,2013; Lin等,2015)。

- 其他方法则结合使用基于规则和基于学习的方法(D’Souza和Ng,2013年)

- 基于筛子的架构,例如CAEVO(Chambers等人,2014)和CATENA(Mirza and Tonelli,2016)。

- 最近,宁等人。 (2017年)

- 使用结构化学习方法,

- 并在TempEval-3(UzZaman等人,2013)和TimeBank-Dense(Cassidy等人,2014)上均表现出显着改进。

- 宁等。 (2018)

- 通过使用约束条件模型联合建模因果关系和时间关系并将问题表述为Interger线性规划问题,

- 显示了对TimeBank-Dense的进一步改进。

- 神经网络

- 基于神经网络的方法

- 既使用了递归RNN(Tourille等,2017; Cheng和Miyao,2017; Leeuwenberg和Moens,2018)

- 又使用了CNN(Dligach等,2017)。

- 此类模型还被用于根据一组预测的时间关系来构建文档时间线(Leeuwenberg和Moens,2018)。

- 这种成对注释的使用可能导致时间图不一致

- 已经通过采用时间推理来努力避免这一问题

- (Chambers和Jurafsky,2008;

- Yoshikawa等,2009;

- Denis和Muller,2011;

- Do等, 2012年;

- Laokulrat等人,2016年;

- Ning等人,2017年;

- Leeuwenberg和Moens,2017年)。

- 已经通过采用时间推理来努力避免这一问题

- 这种成对注释的使用可能导致时间图不一致

- 基于神经网络的方法

- 对事件持续时间进行建模

- (Pan等人,2007;

- Gusev等人,2011;

- Williams和Katz,2012),

- 尽管这项工作并未将持续时间与时间关系联系在一起(另见Filatova和Hovy,2001)。 )。

3.数据收集

协议设计注释者从文档中获得两个连续的句子,并带有两个突出显示的事件引用表达式(谓词)。然后要求它们(i)为突出显示的谓词所指的事件对提供有界刻度的相对时间线; (ii)从以下列表中得出谓词所指事件的可能持续时间:瞬时,秒,分钟,小时,天,周,数月,数年,数十年,几个世纪,直到永远。另外,要求注释者对他们的关系注释和两个持续时间注释中的每一个以相同的五分制进行置信度评分-完全不信任(0),不是非常信任(1),有些确信(2),非常置信度(3),完全置信度(4)。

注释工具的示例如图2所示。此后,我们将谓词所指的情况以线性顺序排在第一(图2中的馈送),称为e1,而谓词所指的情况以线性顺序排第二(在图2中病倒),称为e2。

批注者我们从Amazon Mechanical Turk招募了765名批注者来批注五组谓词对。UD-EWT训练集中包含的每个谓词对都由单个注释者注释,而UD-EWT开发和测试集中的每个谓词对都使用三个注释。

谓词提取我们使用PredPatt从UD-EWT中提取谓词(White等人,2016; Zhang等人,2017),可从16,622个句子中识别出33,935个谓词。我们将UD-EWT中包含的文档中的所有相邻句子对连接起来,从而使我们能够捕获句子间的时间关系。考虑到相邻句子中所有可能的谓词对都是不可行的,因此我们使用启发式方法来捕获最有趣的对。 (有关详细信息,请参见附录A。)

**归一化:**我们通过从所有值中减去最小滑块值,然后将所有此类偏移值除以最大值(偏移后),标准化每个事件对的滑块响应。这样可以确保每个事件对的最早起点位于0,最右边的终点位于1,同时保留滑块所隐含的持续时间之间的比率。图3说明了三个假设注释器对同一事件和进行注释的过程。假设或的持续时间类别在注释器之间没有差异,则事件的相对时间顺序在每种情况下都相同。在绝对滑块位置上保持相对年代很重要,因为为了确定时间关系,注释者给出的绝对位置是没有意义的,并且我们不希望我们的模型被迫适应这种不相关的信息。

Inter-annotator agreement批注者之间的一致性我们通过计算在开发集中注解同一组五个谓词对的每对批注者的标准化滑块位置之间的等级(斯皮尔曼)相关性,来测量时间关系滑块的批注者一致性(IAA)。2开发集由724个注释器注释。等级相关性是一种有用的度量,因为它告诉我们每个滑块的相对位置有多少不同的注释器一致。注释器之间的平均等级相关性为0.665(95%CI = [0.661,0.669])。

- 对两个连续的句子(内含两个事件):

- 标注两个事件的相对时间

- 可能的持续时间

- 并对标注的置信度评级0-4

- PredPatt:从UD-EWT中提取谓词

- 句子间的时间关系:将所有的相邻句子对连接起来

- 启发式方法捕捉有兴趣的句子对,

- 归一化:

- 左0,右1,同时保留隐含的持续时间比率。

- Inter-annotator agreement:

- 评价标注的效果:一致性

- 提高滑块可解释性(新增的4个特征)

- 优先级:开始时间

- 包含:包含的多少

- 平等性:both e1 and e2 have the same temporal extents and smallest when they are most unequal时最大(接近程度)

- SHIFT:时间的平移(前后)

原始滑块位置本身很难直接解释。为了提高可解释性,我们旋转滑块位置空间以构造四个新维度:(i)优先级,当开始和/或结束早于时为正,否则为负。 (ii)包含,当包含更多时最有效; (iii)平等性,both e1 and e2 have the same temporal extents and smallest when they are most unequal

4.Model

- 目的:

- 对于句子中提到的每对事件,我们旨在一起预测这些事件的相对时间表及其持续时间。

- 然后,我们使用一个单独的模型从相对时间线中导出文档时间线

- Relative timelines

- The relative timeline model:

- 事件模型:

- 持续时间模型:

- 关系模型:

- 用于:

- 上下文嵌入:来自ELMO(Peters et al., 2018)的tune–>D维度

- embedding:三个M维上下文嵌入的concate

- 多层点积注意力:用于句子的embedding-H

- H=tanh(ELMo(s)WTUNE+bTUNE)WTUNE∈R3M×DbTUNE∈RN×DH=tanh(ELMo(s)W^{TUNE}+b^{TUNE}) \\W^{TUNE}\in \mathbb{R}^{3M\times D} \\b^{TUNE}\in \mathbb{R}^{N\times D}H=tanh(ELMo(s)WTUNE+bTUNE)WTUNE∈R3M×DbTUNE∈RN×D

- Event model

- 谓词k所指的事件表示为gpredk∈RDg_{pred_k}\in \mathbb{R}^Dgpredk∈RD–由点积注意力的变体建立

- 公式:apredkSPAN=tanh(AOREDSPANhROOT(predk)+bPREDSPAN)αpredk=softmax(HSPAN(predk)apredkSPANgpredk=[hROOT(predk);αpredkHSPAN(predk)]AOREDSPAN∈RD×DbPREDSPAN∈RDhROOT(predk)是隐层表达:第k个谓词的root的HSPAN(predk):stacking整个谓词的隐层表达a_{pred_k}^{SPAN}=tanh(A_{ORED}^{SPAN}h_{ROOT(pred_k)}+b_{PRED}^{SPAN})\\ \alpha_{pred_k}=softmax(H_{SPAN(pred_k)}a_{pred_k}^{SPAN}\\ g_{pred_k}=[h_{ROOT(pred_k)};\alpha_{pred_k}H_{SPAN(pred_k)}]\\ A_{ORED}^{SPAN}\in \mathbb{R}^{D\times D}\\ b_{PRED}^{SPAN}\in \mathbb{R}^{D}\\ h_{ROOT(pred_k)}是隐层表达:第k个谓词的root的\\ H_{SPAN(pred_k)}:stacking整个谓词的隐层表达apredkSPAN=tanh(AOREDSPANhROOT(predk)+bPREDSPAN)αpredk=softmax(HSPAN(predk)apredkSPANgpredk=[hROOT(predk);αpredkHSPAN(predk)]AOREDSPAN∈RD×DbPREDSPAN∈RDhROOT(predk)是隐层表达:第k个谓词的root的HSPAN(predk):stacking整个谓词的隐层表达

- eg:举例来说,

- my dog has been sick for about 3 days now

- 图2中目前sick的谓词以sick为根,因此我们将生病的隐藏表示形式表示为hROOT(predk)h_{ROOT(pred_k)}hROOT(predk)。

- 类似地,HSPAN(predk):H_{SPAN(pred_k)}:HSPAN(predk):等同于been sick for now的隐藏状态表示堆叠在一起。

- 然后,如果模型得知时态信息很重要,则been可能会引起注意。

- Duration model

- 谓词k所代表的事件的历时gdurkg_{dur_k}gdurk–与事件模型类似

- H:不是堆叠整个谓词的表达,而是堆叠整个句子的表达

- apredkSPAN=tanh(ADURSENTgpredk+bDURSENT)αdurk=softmax(HapredkSENT)gdurk=[gpredk;αdurkH]ADURSENT∈RD×size(gpredk)bDURSENT∈RDa_{pred_k}^{SPAN}=tanh(A_{DUR}^{SENT}g_{pred_k}+b_{DUR}^{SENT})\\ \alpha_{dur_k}=softmax(Ha_{pred_k}^{SENT})\\ g_{dur_k}=[g_{pred_k};\alpha_{dur_k}H]\\ A_{DUR}^{SENT}\in \mathbb{R}^{D\times size(g_{pred_k})}\\ b_{DUR}^{SENT}\in \mathbb{R}^{D}apredkSPAN=tanh(ADURSENTgpredk+bDURSENT)αdurk=softmax(HapredkSENT)gdurk=[gpredk;αdurkH]ADURSENT∈RD×size(gpredk)bDURSENT∈RD

- 绝对持续时间的两个model

- softmax model

- 无二项式模型的那个约束

- MLP:vdur+k=ReLU(WDUR(1)gdurk+bDUR(1))v_{dur+k}=ReLU(W_{DUR}^{(1)}g_{dur_k}+b_{DUR}^{(1)})vdur+k=ReLU(WDUR(1)gdurk+bDUR(1))

- 产生11个持续时间的概率:p=softmax(WDUR(2)vdurk+bDUR(2))p=softmax(W_{DUR}^{(2)}v_{dur_k}+b_{DUR}^{(2)})p=softmax(WDUR(2)vdurk+bDUR(2))

- 二项式model

- 二项式模型要求:11个持续时间值的概率pdurkp_{dur_k}pdurk在持续时间rank中是凹的

- RELu-MLP:π=σ(wDUR(2)vdurk+bDUR(2))\pi=\sigma(w_{DUR}^{(2)}v_{dur_k}+b_{DUR}^{(2)})π=σ(wDUR(2)vdurk+bDUR(2))–这是个值而不是向量

- 概率:pc=Cncπn(1−π)(n−c)p_c=C_n^c\pi^n(1-\pi)^{(n-c)}pc=Cncπn(1−π)(n−c)

- loss:Ldur(dk;p)=−logpdkL_{dur}(d_k;p)=-log p_{d_k}Ldur(dk;p)=−logpdk

- 11个持续时间rank

- stant (0), seconds (1), minutes (2), …, centuries (9), forever (10)

- – and n is the maximum class rank (10)

- softmax model

- Relation model

- 谓词i和谓词j所指事件的关系

- similar attention mechanism

- areli,jSENT=tanh(ARELSENT[gpredi;gpredj]+bRELSENT)αreli,j=softmax(Hareli,jSENT)greli,j=[gpredi;gpredj;αrelijH]ARELSENT∈RD×2size(gpredk)bRELSENT∈RDa_{rel_{i,j}}^{SENT}=tanh(A_{REL}^{SENT}[g_{pred_i};g_{pred_j}]+b_{REL}^{SENT})\\ \alpha_{rel_{i,j}}=softmax(Ha_{rel_{i,j}}^{SENT})\\ g_{rel_{i,j}}=[g_{pred_i};g_{pred_j};\alpha_{rel_{ij}}H]\\ A_{REL}^{SENT}\in \mathbb{R}^{D\times 2size(g_{pred_k})}\\ b_{REL}^{SENT}\in \mathbb{R}^Dareli,jSENT=tanh(ARELSENT[gpredi;gpredj]+bRELSENT)αreli,j=softmax(Hareli,jSENT)greli,j=[gpredi;gpredj;αrelijH]ARELSENT∈RD×2size(gpredk)bRELSENT∈RD

- 我们的时间模型背后的主要思想是将事件和状态直接映射到时间轴,我们通过参考间隔[0,1]表示该时间轴

- 对situation k,开始点b_k<=e_k

- MLP:[βi^,δi^,βj^,δj^]=ReLU(MLP(grelij))−−开始和持续时间[\hat{\beta_i},\hat{\delta_i},\hat{\beta_j},\hat{\delta_j}]=ReLU(MLP(g_{rel_{ij}}))--开始和持续时间[βi^,δi^,βj^,δj^]=ReLU(MLP(grelij))−−开始和持续时间

- sij^=[bi^,ei^,bj^,ej^][bk^,ek^]=[σ(βk^),σ(βk^+∣δk^∣)]−−开始和结束sij^=normalize(sij^)\hat{s_{ij}}=[\hat{b_i},\hat{e_i},\hat{b_j},\hat{e_j}]\\ [\hat{b_k},\hat{e_k}]=[\sigma(\hat{\beta_k}),\sigma(\hat{\beta_k}+|\hat{\delta_k}|)]--开始和结束\\ \hat{s_{ij}}=normalize(\hat{s_{ij}})sij^=[bi^,ei^,bj^,ej^][bk^,ek^]=[σ(βk^),σ(βk^+∣δk^∣)]−−开始和结束sij^=normalize(sij^)

- 损失函数:Lrel(sij;sij^)=∣(bi−bj)−(bi^−bj^)∣+∣(ei−bj)−(ei^−bj^)∣+∣(ej−bi)−(ej^−bi^)∣+∣(ei−ej)−(ei^−ej^)∣L_{rel}(s_{ij};\hat{s_{ij}})=|(b_i-b_j)-(\hat{b_i}-\hat{b_j})|+|(e_i-b_j)-(\hat{e_i}-\hat{b_j})|+|(e_j-b_i)-(\hat{e_j}-\hat{b_i})|+|(e_i-e_j)-(\hat{e_i}-\hat{e_j})|Lrel(sij;sij^)=∣(bi−bj)−(bi^−bj^)∣+∣(ei−bj)−(ei^−bj^)∣+∣(ej−bi)−(ej^−bi^)∣+∣(ei−ej)−(ei^−ej^)∣

- 对situation k,开始点b_k<=e_k

- final loss:L=Ldur(dk;p)+2Lrel(sij;sij^)=−logpdk+∣(bi−bj)−(bi^−bj^)∣+∣(ei−bj)−(ei^−bj^)∣+∣(ej−bi)−(ej^−bi^)∣+∣(ei−ej)−(ei^−ej^)∣L=L_{dur}(d_k;p)+2L_{rel}(s_{ij};\hat{s_{ij}})\\=-log p_{d_k}+|(b_i-b_j)-(\hat{b_i}-\hat{b_j})|+|(e_i-b_j)-(\hat{e_i}-\hat{b_j})|+|(e_j-b_i)-(\hat{e_j}-\hat{b_i})|+|(e_i-e_j)-(\hat{e_i}-\hat{e_j})|L=Ldur(dk;p)+2Lrel(sij;sij^)=−logpdk+∣(bi−bj)−(bi^−bj^)∣+∣(ei−bj)−(ei^−bj^)∣+∣(ej−bi)−(ej^−bi^)∣+∣(ei−ej)−(ei^−ej^)∣

- The relative timeline model:

- Duration-relation connections

- 我们还尝试了四种架构,其中持续时间模型和关系模型在Dur->Rel或Rel->Dur两个方向中相互连接

- Dur->Rel架构

- 2种方法

- (i)另外将谓词i和谓词j的二项式持续时间概率连接起来

- grelij=[gpredi;gpredj;αreli,jH;pi;pj]g_{rel_{ij}}=[g_{pred_i};g_{pred_j};\alpha_{rel_{i,j}}H;p_i;p_j]grelij=[gpredi;gpredj;αreli,jH;pi;pj]

- (ii)完全不使用关系表示模型。

- grelij=[pi;pj]g_{rel_{ij}}=[p_i;p_j]grelij=[pi;pj]

- (i)另外将谓词i和谓词j的二项式持续时间概率连接起来

- 2种方法

- Rel->Dur架构

- (i)通过连接关系模型中的bk^\hat{b_k}bk^和ek^\hat{e_k}ek^来修改gdurkg_{dur_k}gdurk

- gdurk=[gpredk;αdurkH;bk^;ek^]g_{dur_k}=[g_{pred_k};\alpha_{dur_k}H;\hat{b_k};\hat{e_k}]gdurk=[gpredk;αdurkH;bk^;ek^]

- (ii)我们完全不使用持续时间表示模型,而是使用预测的相对从关系模型获得的持续时间ek^−bk^\hat{e_k}-\hat{b_k}ek^−bk^,并通过二项分布模型。

- πdurk=ek^−bk^\pi_{dur_k}=\hat{e_k}-\hat{b_k}πdurk=ek^−bk^

- (i)通过连接关系模型中的bk^\hat{b_k}bk^和ek^\hat{e_k}ek^来修改gdurkg_{dur_k}gdurk

- Document timelines

- UDST开发集中的文档引入了隐藏的文档时间线,两个方法:

- (i)实际的成对滑块注释actual pairwise slider annotations

- (ii)由UDS-T开发集上性能最佳的模型预测的滑块值。

- 假设一个隐层时间线T∈R+nd×2,2−b和持续时间,nd:文档中谓词的总数T\in \mathbb{R}_+^{n_d\times 2},2-b和持续时间,n_d:文档中谓词的总数T∈R+nd×2,2−b和持续时间,nd:文档中谓词的总数

- 通过锚定所有谓词的起点,使这些潜在时间线与相对时间线相连,以使文档中始终存在以0为起点的谓词,并为每个事件i和j定义辅助变量

- τij=[ti1,ti1+ti2,tj1,tj1+tj2]sij^=τij−min(τij)max(τij−min(τij))(归一化)\tau_{ij}=[t_{i1},t_{i1}+t_{i2},t_{j1},t_{j1}+t_{j2}]\\ \hat{s_{ij}}=\frac{\tau_{ij}-min(\tau_{ij})}{max(\tau_{ij}-min(\tau_{ij}))}(归一化)τij=[ti1,ti1+ti2,tj1,tj1+tj2]sij^=max(τij−min(τij))τij−min(τij)(归一化)

- 根据关系损失为每一个文档学习T

- 进一步约束T:

- 二项式分布来预测持续时间

- πk=σ(clog(tk2))\pi_k=\sigma(clog(t_{k_2}))πk=σ(clog(tk2))

- UDST开发集中的文档引入了隐藏的文档时间线,两个方法:

5.实验

对于所有实验,我们使用批量大小为64的小批量梯度下降来训练嵌入调谐器(将ELMo减小为256维),注意力和MLP参数。关系MLP和持续时间MLP都具有一个具有128个节点的隐藏层,且dropout概率为0.5(有关更多详细信息,请参见附录D)。

- 为了预测TempEval3(TE3; UzZaman等人,2013,仅任务C关系)和TimeBank-Dense(TD; Cassidy等人,2014)中的TimeML关系,我们使用了转移学习方法。

- 我们首先在UDS-T开发集上使用性能最佳的模型,以获取TE3和TD中每对带注释的事件-事件关系的关系表示(grelijg_{rel_{ij}}grelij)(有关预处理的详细信息,请参阅附录E)。

- 然后,我们将此向量用作具有高斯核的SVM分类器的输入特征,以使用从我们的模型中获得的特征向量对这些数据集的训练集进行训练.

- duration的指标:

- Spearman correlation (ρ\rhoρ),

- mean rank difference (rank diff)

- proportion rank difference explained (R1)

- relation指标:

- Spearman correlation between the normalized values of actual beginning and end points and the predicted ones (absolute ρ\rhoρ)

- the Spearman correlation between the actual and predicted values in Lrel (relative ρ\rhoρ),

- the proportion of MAE explained (R1).

- R1=1−MAEmodelMAEbaselineR1=1-\frac{MAE_{model}}{MAE_{baseline}}R1=1−MAEbaselineMAEmodel

- R1=1−MAEmodelMAEbaselineR1=1-\frac{MAE_{model}}{MAE_{baseline}}R1=1−MAEbaselineMAEmodel

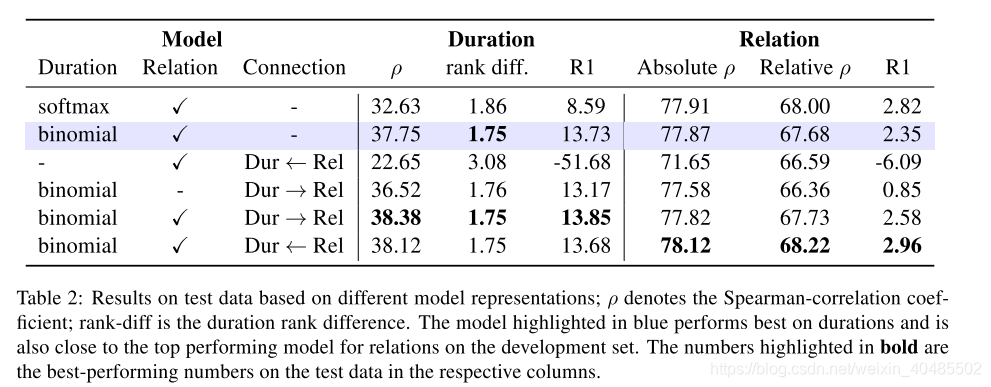

依据最近在事件事实性预测中使用连续标签进行的工作(Lee等。 ,2015年; Stanovsky等人,2017年; Rudinger等人,2018年; White等人,2018年)和通用性预测(Govindarajan等人,2019年),我们报告了持续时间预测的三个指标:Spearman相关性(⇢) ,平均等级差异(rank diff)和比例等级差异说明(R1)。我们报告了用于关系预测的三个度量标准:实际起点和终点的标准化值与预测值(绝对值between)之间的Spearman相关性,Lrel的实际值和预测值之间的Spearman相关性(相对⇢)以及MAE解释(R1)。

6.result

- UDS-T结果

- 我们的大多数模型都能够很好地预测事件开始和结束的相对位置(高关联ρ\rhoρ),并且事件的相对持续时间也能很好地预测(相对较低的持续时间ρ\rhoρ)

- 它们还有难以准确地预测关系

- 较容易准确地预测持续时间

- 持续时间模型

- duration:binominal>softmax

- relation:binominal=softmax

- connection:(下面的四个架构)

- 连接持续时间和关系模型通常不会提高性能。

- duration:

- 当持续时间是根据时间关系模型直接预测时,即如果不使用持续时间表示模型,则模型的性能会大幅下降,而Spearman相关系数会下降大约15个百分点。

- 这表明约束关系模型来预测持续时间是不够的,并且需要持续时间表示来很好地预测持续时间。

- relation:

- 另一方面,直接根据持续时间概率分布预测时间关系,

- 即不使用关系表示模型的情况,其结果与性能最高的模型相近。

- 这表明持续时间表示能够捕获句子的大多数关系特征。

- 分别使用持续时间表示和关系表示(模型以蓝色突出显示)可在UDS-T开发集中总体上获得最佳性能。

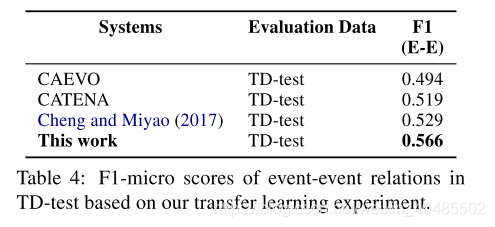

- 本文效果在TD-test上很好

7 Model Analysis and Timelines

- 我们在开发集上研究了表现最佳的模型的两个方面(表2中突出显示):

- (i)我们的持续时间和关系表示涉及什么;

- (ii)从模型的前4个构造的时间线记录得很好,

- 我们没有报告TE3-PT上其他系统的时间意识得分(F1),因为它们报告了所有关系的度量,包括timex-timex和event-timex关系,因此它们不能直接比较。

- 对于TD,仅报告那些报告F1-micro分数的系统。

- attention:

- 优点:我们通常可以通过分析关注权重来解释模型使用的语言信息。

- 我们从开发集上的最佳模型中提取持续时间表示和关系表示的注意力强度

- Duration

- 注意力权重高的为时间名词:对预测持续时间有帮助,所以不需要TimeML,因为这个模型自己能够检测时间

- Relation

- 注意力高的是:

- 连词–可以获取时间序列

- 时态信息的承担者(?)

- 注意力高的是:

- Document timelines

- 持续时间预测不佳的一个可能原因:可能是缺少持续时间信息的直接来源。

- 该模型当前仅尝试基于滑块值来确定持续时间,这导致性能下降,

- 持续时间预测不佳的一个可能原因:可能是缺少持续时间信息的直接来源。

我们发现单词表示某个时间段,例如在持续时间模型中,平均注意权重最高的单词包括月份,分钟,小时,年,天,周,其中前15个单词中的七个直接表示一种持续时间类别(表3)。这正是人们可能期望此模型严重依赖的东西,因为时间表达式可能对预测持续时间很有帮助。这也可能表明我们不需要像框架TimeML这样的注释标准那样,在我们的框架中直接编码事件引用和时间引用表达式之间的关系,因为我们的模型可以发现它们。

持续时间模型中头几个单词的其余部分是复数或整体名词(士兵,思想等)。这可能表明多个谓词的论点是表3所示事件可能持续时间的指示符:表3中具有最高平均持续时间注意的开发集中15个单词的平均注意权重,平均注意等级和频率(左)和关系注意(右)权重。对于持续时间,以粗体突出显示的单词直接对应于某个持续时间类别。为了联系,粗体字是连词或包含时态信息的字。

)