文章目录

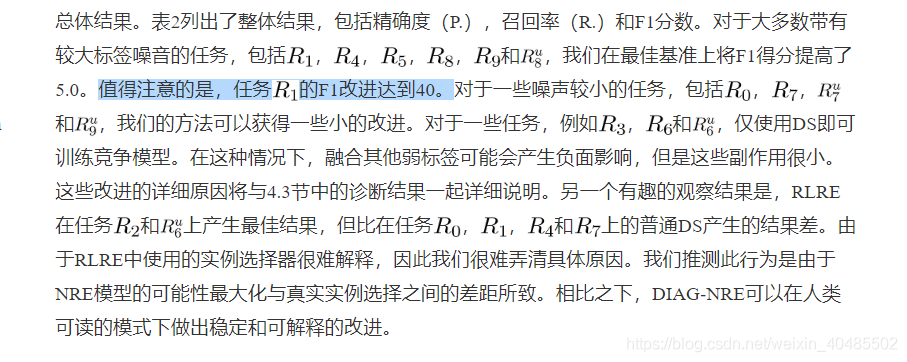

- abstract

- 1. Introduction

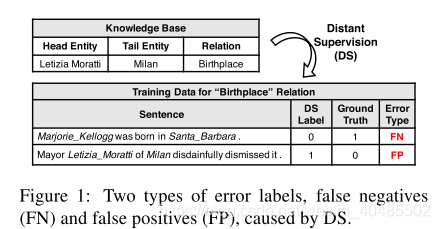

- 2.相关工作

- 3.方法

- 3.1 NRE Models

- 3.2 Pattern Extraction

- 3.3 Pattern Refinement

- 3.4 Weak Label Fusion(WLF)

- 4 Experiments

- 4.1 Experimental Setup

- 4.2 Performance Comparisons

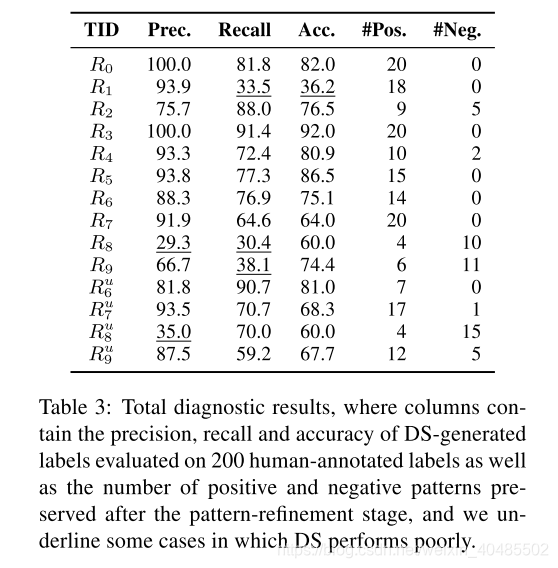

- 4.3 Pattern-based Diagnostic Results

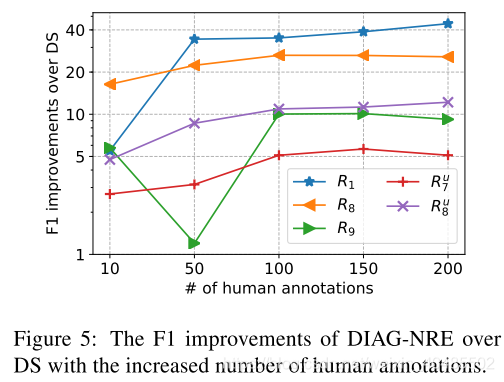

- 4.4 Incremental Diagnosis

- 4.5案例研究

- 参考文献

Zheng, S., et al. (2019). DIAG-NRE A Neural Pattern Diagnosis Framework for Distantly Supervised Neural Relation Extraction. Proceedings ofthe 57th Annual Meeting ofthe Association for Computational Linguistics.

code+data

abstract

基于模式的标记方法在减轻远距离监督神经关系提取中不可避免的标记噪声方面取得了可喜的成果。但是,这些方法需要大量的专家工作来编写关系特定的模式,这使得它们过于复杂而无法快速推广。为了减轻模式编写的劳动密集型工作量并快速将其推广到新的关系类型,我们提出了一种神经模式诊断框架DIAG-NRE,该框架可以与专家在回路中自动从噪声数据中总结和改进高质量的关系模式。 。为了证明DIAG-NRE的有效性,我们将其应用于两个真实世界的数据集,并提出了对现有技术方法的重大和可解释的改进。

- 远程监督神经网络关系抽取

- 基于模式的标注方法

- 去噪好

- 缺点

- 需要大量专家手动编写关系的特定模式

- 难以推广

- 本文:DIAG-NRE

- 目标:减轻模式编写的人工工作量

- 效果:可以和专家协同从噪声数据中总结和改进来得到高质量的关系模式(去噪)

- 基于模式的标注方法

1. Introduction

关系提取旨在从纯文本中提取关系事实,并可以为下游的知识驱动型应用带来好处。关系事实被定义为头部实体和尾部实体之间的关系,例如(Letizia Moratti,Birthplace,Milan)。传统方法通常将关系提取视为有监督的分类任务,该任务可预测句子中提到的两个检测到的实体之间的关系类型,包括统计模型(Zelenko等,2003; Zhou等,2005)和神经模型(Zeng等人,2014年; dos Santos等人,2015年)。

这些受监督的模型需要训练大量的人工注释数据,这些数据收集起来既昂贵又费时。因此,Craven等。 (1999); Mintz等。 (2009年)提出了远程监督(DS),该方法可以通过将知识库(KB)的相关事实与纯文本对齐,并假设提到两个实体的每个句子都可以在关系图中描述它们的关系,从而自动生成用于关系提取的大规模培训数据。 KB由于DS可以在无需人工注释的情况下获取大规模数据,因此已被最近的神经关系提取(NRE)模型广泛采用(Zeng等,2015; Lin等,2016)。

尽管DS在许多情况下既简单又有效,但不可避免地会引入无法忍受的标记噪音。如图1所示,错误标签有两种类型,误报和误报。否定否定的原因是,句子确实描述了有关目标关系的两个实体,但事实尚未被知识库所涵盖。对于误报,这是因为并非所有提及实体对的句子实际上都在KB中表达了它们之间的关系。当KB和文本不匹配时,噪声标记问题可能会变得更加严重,从而严重削弱模型的性能(Riedel等,2010)。

- 关系抽取

- 有监督分类任务

- 统计模型

- 神经模型

- 远程监督

- 文本与知识库中事实对齐

- 假设两个实体提及的每个句子都可以在关系图中描述他们的关系

- 问题:噪声

- 两种:

- FN:句子确实描述了有关目标关系的两个实体,但事实尚未被知识库所涵盖

- FP:并非所有提及实体对在句子中的关系是在KB中的关系。

- 当KB和句子不匹配的时候噪声更大

- 两种:

- 解决:适当采取人工措施

- 人标注的数据与DS的数据混合

- Zhang et al. (2012); Pershina et al. (2014); Angeli et al. (2014); Liu et al. (2016)

- 需要足够大的人工标注数据,才有用,因为DS数据要大得多

- 基于模式的标注

- 特定于关系的模式

- Ratner et al. (2016); Liu et al. (2017a)

- 关键思想:

- 弱监督源(DS+基于模式的启发式方法)

- 弱标签融合(WLF)模型

- –>生成去噪标签

- 缺点:

- 一个关系一个模式,来新的了需要重新编写

- 编写:高技能且劳动密集–需要专家(很复杂)

- 神经模式诊断框架DIAG-NRE

- 为常见的NRE模型在DS和WLF之间构建了桥梁(半自动化模式)

- 目标:减轻模式编写的人工工作量

- 效果:可以和专家协同从噪声数据中总结和改进来得到高质量的关系模式(去噪)

- 减少人类专家的工作量和难度

- 需要的人类注释也少

- 还给噪声的行为提炼出了模式

- 工作流:

- 模式提取:用强化学习从NRE模型中提取潜在的模式

- 模式提炼:人类专家注释一部分主动选择的示例(主动学习,会向人要吗?)

- DIAG-NRE->WLF->NRE Model

- 贡献:

- 通过自动生成模式来简化人类专家的模式编写工作;

- 通过只需要少量的人工注释就可以快速将其归纳为新的关系类型;

- 提出显着和可解释的性能改进以及直观的诊断分析。

- 对大量FN的噪声数据集处理效果好

- 与其他的关系模式挖掘的区别:

- 1)仅基于RL,

- 2)不依赖任何词法或句法注释

- 3)通过预测NRE模型可以了解模式的重要性

- 人标注的数据与DS的数据混合

- 有监督分类任务

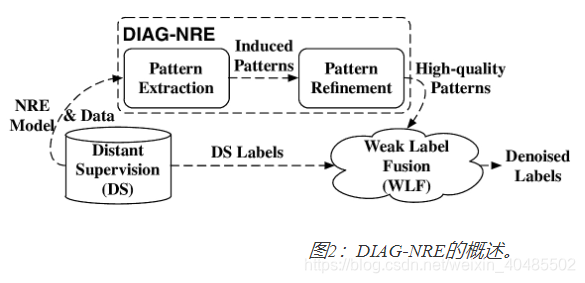

为了简化人类专家的模式编写工作并实现对新关系类型的快速概括,我们提出了一种神经模式诊断框架DIAG-NRE,它为常见的NRE模型在DS和WLF之间建立了桥梁。如图2所示,DIAG-NRE的一般工作流包含两个关键阶段:1)模式提取,通过采用强化学习(RL)从NRE模型中提取潜在模式,以及2)模式提炼,要求人类专家注释一小部分一组主动选择的示例。按照这些步骤,我们不仅可以通过自动生成模式来最大程度地减少人类专家的工作量和难度,而且还只需要少量的人类注释就可以实现快速概括。经过DIAG-NRE处理后,我们获得了具有高概率的支持或不支持目标关系的高质量模式,并且可以将它们馈入WLF阶段以获取去噪标签并重新训练更好的模型。为了证明DIAG-NRE的有效性,我们在两个真实的数据集上进行了广泛的实验,其中DIAG-NRE不仅在现有技术上取得了显着改善,而且还通过提炼为不同的噪声行为提供了深刻的诊断结果模式。

尽管DS在许多情况下既简单又有效,但不可避免地会引入无法忍受的标记噪音。如图1所示,错误标签有两种类型,FP和FN。FN的原因是,句子确实描述了有关目标关系的两个实体,但事实尚未被知识库所涵盖。对于FP,这是因为并非所有提及实体对的句子实际上都在KB中表达了它们之间的关系。当KB和文本不匹配时,噪声标记问题可能会变得更加严重,从而严重削弱模型的性能(Riedel等,2010)。

最近的研究已经认识到,采取适当的人工措施对于减少此类标签噪音至关重要。例如,Zhang等。 (2012); Pershina等。 (2014); Angeli等。 (2014);刘等。 (2016年)将一小部分人群注释标签与纯DS生成的噪声标签混合在一起。但是,他们发现只有足够大和高质量的人类标签才能带来显着的改进,因为噪声标签的数量大得多。

为了扩大人类努力的影响,Ratner等人。 (2016);刘等。 (2017a)建议纳入基于模式的标签,其关键思想是将DS和基于模式的启发式方法都视为弱监督源,并开发弱标签融合(WLF)模型以生成去噪标签。但是,WLF范式的主要局限性在于要求人类专家编写特定于关系的模式。不幸的是,编写好的模式既是一项高技能又是一项劳动密集型的任务,需要专家学习详细的模式编写说明,检查适当的示例,针对不同的极端情况调整模式等。例如,Ratner等人的配偶关系示例。 (2016年)使用11个函数以及20多个特定于关系的关键字1。更糟糕的是,当归纳为新的关系类型时,我们需要再次重复上述艰难的手动操作。

2.相关工作

为了减少DS的标签噪声,早期的工作尝试设计能够更好地容忍标签噪声的特定模型架构,例如多实例学习范式(Riedel等,2010; Hoffmann等,2011; Surdeanu等, 2012; Zeng等,2015; Lin等,2016; Wu等,2017)。这些模型通过将多个提及同一实体对的句子组合在一起作为一个包,然后假设该包中至少有一个句子表达了这种关系,从而放宽了DS的原始假设。这个较弱的假设可以在一定程度上缓解噪声标签问题,但是这个问题仍然存在于包装袋层面,Feng等人。 (2018)发现袋级模型难以进行句子级的预测。

后来的工作试图设计用于训练的动态标签调整策略(Liu等人,2017b; Luo等人,2017)。特别是,最近的工作(Feng等人,2018; Qin等人,2018)采用RL来训练与NRE模型进行交互的代理,以学习如何去除或更改噪声标签。通过利用DS生成的标签与模型预测的标签之间的一致性和差异,这些方法无需人工干预即可工作。但是,这样的方法既不能发现与模型预测一致的噪声标签,也不能解释去除或更改标签的原因。正如引言中所讨论的那样,引入人类的努力是一个有希望的方向,既可以做出重大的又可以解释的改进,这也是本文的重点。

- 远程监督-去噪

- MIL多实例学习

- (Riedel et al., 2010; Hoffmann et al., 2011; Surdeanu et al., 2012; Zeng et al., 2015; Lin et al., 2016; Wu et al., 2017)

- 句子包:同一实体对(可能有多个提及)的句子组合在一起–>包

- 假设:包中至少有一个句子表达了这种假设,放宽了DS的假设

- 效果:可以一定程度上缓解噪声问题

- 缺点:缓解,但在包级仍存在

- 难以进行句子级预测:Feng et al. (2018)发现

- 动态标签调整策略-用以训练

- (Liu et al., 2017b; Luo et al., 2017).

- RL强化学习

- 目标:训练一个与NRE模型交互的代理,以学习如何去除或更改噪声标签

- 通过利用DS的标签与模型预测标签的一致性和差异(RL会学到这个)

- 可自动化

- 缺点:发现不了与模型预测一致的噪声标签;不可解释性

- 补充:自动化去噪的研究

- ACL2018:DSGAN

- 以对抗网络,发现FP和TP的区别,从而剔除FP

- 是个单独的去噪处理器(DS)

- 句子级别

- ACL2018:DSGAN

- (人工+半自动化最好)

- 关系模式挖掘

- (Califf and Mooney, 1999; Carlson et al., 2010; Nakashole et al., 2012; Jiang et al., 2017).

- 反语义模式

- Takamatsu et al. (2012)

- 通过example-pattern-relation共存推断否定句法模式,并相应地删除了假阳性FP标签

- 本文与其他的区别:

- 1)仅基于RL,

- 2)不依赖任何词法或句法注释

- 3)通过预测NRE模型可以了解模式的重要性

- 与Takamatsu相反:

- 减少消极模式以减轻FP

- 增强了积极模式以解决FP

- 关系模式挖掘

- MIL多实例学习

- 模式提取(都是RL)

- vanilla LSTM(Hochreiter and Schmidhuber, 1997) :

- 利用RL发现结构化表示

- Zhang et al. (2018)

- 情感预测

- 使用RL来发现改变决策的短语(情感词吧?)

- Li et al. (2016)

- NRE模型

- NRE只关心句子中提到的实体的关系的语义–唯一的

- 本文是第一个用RL提取模式的(在NRE领域中)

- vanilla LSTM(Hochreiter and Schmidhuber, 1997) :

模式提取部分,我们注意到有些方法具有相似的见解,但目的不同。例如,Zhang等。 Li等(2018)通过利用RL发现结构化表示来改善了香草LSTM的性能(Hochreiter和Schmidhuber,1997)。 (2016)通过使用RL来发现决策改变的短语来解释神经模型的情感预测。但是,NRE模型是唯一的,因为我们只关心句子中提到的语义实体关系。据我们所知,我们是第一个通过RL从NRE模型中提取模式的公司。

我们还注意到关系模式挖掘已经得到了广泛的研究(Califf and Mooney,1999; Carlson等,2010; Nakashole等,2012; Jiang等,2017)。与那些研究不同,我们的模式提取方法1)仅基于RL,2)不依赖任何词法或句法注释,并且3)通过预测NRE模型可以了解模式的重要性。此外,高松等。 (2012)通过example-pattern-relation共存推断否定句法模式,并相应地删除了假阳性标签。相反,在现代神经模型的基础上,我们的方法不仅减少了消极模式以减轻误报,而且还增强了积极模式以同时解决误报。

3.方法

通过提供DS生成的数据和经过训练的NRE模型,DIAG-NRE可以为WLF台生成高质量的模式,以产生去噪的标签。如图2所示,DIAG-NRE通常包含两个关键阶段:模式提取(第3.2节)和模式优化(第3.3节)。此外,为了完整起见,我们在第3.4节中简要介绍了WLF范例。接下来,我们首先回顾一下现代NRE模型的通用输入输出模式。

- DIAG-NRE:

- DS生成的数据,经过训练的NRE模型(在DS上)–>WLF–>产生去噪的标签

3.1 NRE Models

- 输入:一个实例(句子,实体对)–>x=[word embedding;position embedding]

- 概率Pϕ(r∣x),ϕ是NRE的参数,r是关系P_{\phi}(r|x),\phi是NRE的参数,r是关系Pϕ(r∣x),ϕ是NRE的参数,r是关系

3.2 Pattern Extraction

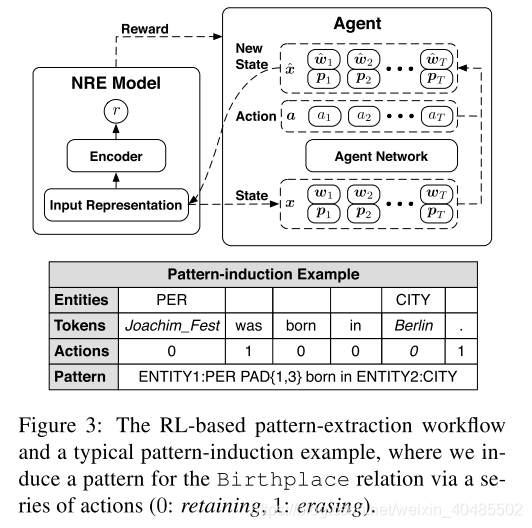

在这个阶段,我们构建一个模式提取代理,从具有上述输入输出模式的NRE模型中提取关系特定的模式。基本思想是擦除不相关的令牌并同时保留原始目标预测,可以将其建模为令牌擦除决策过程并由RL优化。图3以一般方式显示了这种基于RL的工作流以及一个直观的模式归纳示例。接下来,我们详细介绍此工作流程。

- 模式提取

- 构建一个模式提取代理

- 从上述的NRE模型–>提取特定于关系的模式

- 思想:在保证原始目标预测的前提下,擦除无关的token

- 建模:token擦除决策过程,以RL优化(如图3)

- 实例s,第i列(第i个嵌入)

- Action:对每个xi采取行动ai:xi=[wi;pi]−−>xi^=[w^i;pi]x_i=[w_i;p_i]-->\hat{x_i}=[\hat{w}_i;p_i]xi=[wi;pi]−−>xi^=[w^i;pi]

- 行动:0:retaining,1:erasing

- 擦除的i:hatwi=0hat{w}_i=0hatwi=0–删除语义

- 行动序列:a=[a1;a2;...;aT]a=[a_1;a_2;...;a_T]a=[a1;a2;...;aT]–保留下来的token数量为T^\hat{T}T^

- Reward:

- 目标:找到保留原始预测一致性的最简单序列(预测不变的前提下删除更多的token)

- R(a∣x)=log(Pϕ(r∣x^)Pϕ(r∣x))⏟+η(1−T^T)⏟=PredictionConfidence+SparsityR(a|x)={\underbrace{log(\frac{P_{\phi}(r|\hat{x})}{P_{\phi}(r|x)})}}+\underbrace{\eta(1-\frac{\hat{T}}{T})}\\={Prediction Confidence}+{Sparsity}R(a∣x)=log(Pϕ(r∣x)Pϕ(r∣x^))+η(1−TT^)=PredictionConfidence+Sparsity

- State:

- 要求:独立于NRE;应需要合并当前实例的完整信息

- 输入表示x用作状态

- Agent:

- 用基于策略的RL来训练基于神经网络的代理

- 并行计算πΘ(ai∣x):采取某个行动的概率\pi_\Theta(a_i|x):采取某个行动的概率πΘ(ai∣x):采取某个行动的概率

- 行动序列:πΘ(a∣x)=Πi=1TπΘ(ai∣x),Θ:agent网络的参数\pi_\Theta(a|x)=\Pi_{i=1}^T\pi_\Theta(a_i|x),\Theta:agent网络的参数πΘ(a∣x)=Πi=1TπΘ(ai∣x),Θ:agent网络的参数

- 网络:可在决策时丰富上下文信息,双向LSTM:x->h

- h→=[h→1,h→2,...,h→T]=Forward−LSTM(x)h←=[h←1,h←2,...,h←T]=Backward−LSTM(x)h=[h1,h2,...,hT]=Concatenate(h→,h←)\stackrel{\rightarrow}{h}=[\stackrel{\rightarrow}{h}_1,\stackrel{\rightarrow}{h}_2,...,\stackrel{\rightarrow}{h}_T]=Forward-LSTM(x)\\ \stackrel{\leftarrow}{h}=[\stackrel{\leftarrow}{h}_1,\stackrel{\leftarrow}{h}_2,...,\stackrel{\leftarrow}{h}_T]=Backward-LSTM(x)\\ h=[h_1,h_2,...,h_T]=Concatenate(\stackrel{\rightarrow}{h},\stackrel{\leftarrow}{h})h→=[h→1,h→2,...,h→T]=Forward−LSTM(x)h←=[h←1,h←2,...,h←T]=Backward−LSTM(x)h=[h1,h2,...,hT]=Concatenate(h→,h←)

- Attention:将h聚合为c

- ci=Σj=1Tαjihjαji=ejiΣk=1Tekieji=vαTtanh(Wxxi+Whhj)vα是个参数c_i=\Sigma_{j=1}^T\alpha_j^ih_j\\ \alpha_j^i=\frac{e_j^i}{\Sigma_{k=1}^Te_k^i}\\ e_j^i=v_\alpha^Ttanh(W_xx_i+W_hh_j)\\ v_\alpha是个参数ci=Σj=1Tαjihjαji=Σk=1Tekiejieji=vαTtanh(Wxxi+Whhj)vα是个参数

- 最终表示:z=[z1,...,zT],zi=[xi;ci]z=[z_1,...,z_T],z_i=[x_i;c_i]z=[z1,...,zT],zi=[xi;ci]

- 每个行动的概率:

- oi=sigmoid(WoTzi+bo)πΘ(ai∣x)=oiai(1−oi)(1−ai)o_i=sigmoid(W_o^Tz_i+b_o) \\\pi_\Theta(a_i|x)=o_i^{a_i}(1-o_i)^{(1-a_i)}oi=sigmoid(WoTzi+bo)πΘ(ai∣x)=oiai(1−oi)(1−ai)

- 优化

- 强化学习算法+策略梯度方法来优化参数

- 关键:梯度公式+BP

- 目标函数:L(Θ)=Es[EπΘ(a∣x)R(a∣x)]L(\Theta)=E_s[E_{\pi_\Theta(a|x)}R(a|x)]L(Θ)=Es[EπΘ(a∣x)R(a∣x)]

- 梯度:∇ΘL(Θ)\nabla_\Theta L(\Theta)∇ΘL(Θ)

- 平衡:利用ϵ贪婪技巧来平衡勘探和开发

- 模式归纳

- 给定实体和ai:

- 用相应实体类型替换原始实体对

- 评估代理–>保留了相对距离的保留token(如图3)

- 擦除的替换为PAD

- 为了启用通用位置只是,将两个保留token之间的相对距离分为四类

- 0距离

- 短距离(1-3)

- 中距离(4-9)

- 长距离(>10

- 这种格式,可以包含多种信息:(实体类型,关键token,相对距离)

- 给定实体和ai:

- 构建一个模式提取代理

奖励。我们的目的是找到保留原始预测一致性的最简单的序列。因此,给定原始输入表示形式x和相应的动作向量a,我们将奖励定义如下:

其中,总奖励由两部分组成:一个是追求高预测置信度的对数似然项,另一个是稀疏比率项,用于根据保留的令牌诱导稀疏性。我们通过超参数η平衡这两部分。

state:通常,提供给代理的状态应独立于NRE体系结构。此外,状态需要合并当前实例的完整信息。因此,在我们的设计中,代理直接将输入表示x用作状态。

优化:我们采用REINFORCE算法(Williams,1992)和策略梯度方法(Sutton等,2000)来优化代理网络的参数,关键步骤是重写梯度公式,然后应用反向传播算法(Rumelhart)。等人,1986)更新网络参数。具体来说,我们将目标定义为:

模式归纳。给定实例和相应的代理动作,我们采取以下步骤来生成紧凑模式。首先,一般来说,我们用相应的实体类型替换原始实体对。然后,我们评估代理以获取保留了相对距离的保留令牌。为了启用通用位置指示,我们将两个相邻保留令牌之间的相对距离分为四类:零(它们之间没有令牌),短(1-3个令牌),中(4-9个令牌)和长(10个或更多)令牌)距离。例如,图3显示了一个典型的模式归纳示例。具有这种格式的模式可以包含多种关键信息,例如实体类型,关键令牌以及它们之间的相对距离。

3.3 Pattern Refinement

- 模式优化

-

人类在循环之中,系统会向人类求助(主动学习)

-

模式层次结构Pattern Hierarchy.

- 模式提取:实例级别

- 数据集级别:聚合后存在冗余

- 使用模式层次结构合并冗余模式

- 层次结构:父模式涵盖了子模式匹配的所有实例

- 若父已经有了足够的关系支持信号,则可不用人工标注子模式

-

Human Annotation.

- 通过人类专家注释少量主动选择的实例

- 为了定量评估模式的质量

- 系统请求nr∗nan_r*n_anr∗na个模式的人类标注

- 代表性越高,模式涵盖的实例数越多–按模式的实例数选择最具代表性的nrn_rnr个模式

- 一个关系nrn_rnr个模式

- 每个模式,随机选出nan_ana个实例进行人类标注

- 代表性越高,模式涵盖的实例数越多–按模式的实例数选择最具代表性的nrn_rnr个模式

- 质量分类

- 正模式集合:精度>ph>p_h>ph

- 负模式集合:<pl<p_l<pl(和实例匹配不好的模式)

- 划分是为了WLF

- 超参数:(nr,na,ph,pl)(n_r,n_a,p_h,p_l)(nr,na,ph,pl)

-

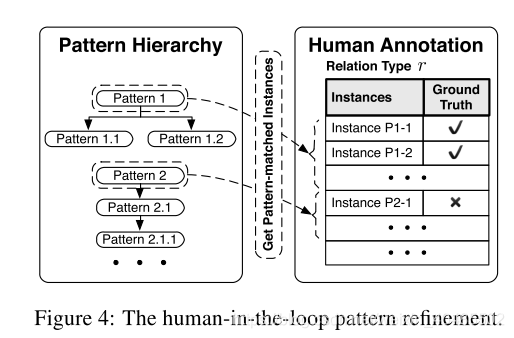

上述模式提取阶段通过为每个评估实例生成一个模式来在实例级别上进行操作。但是,在数据集级别聚合可用模式之后,不可避免地会存在冗余模式。因此,我们设计了一个模式层次结构来合并冗余模式。之后,我们可以通过要求人类专家注释少量主动选择的示例来将人类专家引入工作流程。图4显示了此阶段的一般工作流程。

模式层次结构。为了识别冗余模式,我们将具有相同模式的多个实例分组,并通过匹配的统计信息构建模式层次结构。在此层次结构中,父模式应涵盖与子模式匹配的所有实例。由于父模式已经具有足够的关系支持信号,因此我们可以省略子模式进行人工注释。此外,可以从中诱发出模式的实例数量与模式代表性密切相关。因此,我们按照该数字的降序选择用于人类注释的顶级最有代表性的模式。

3.4 Weak Label Fusion(WLF)

- 弱标签融合

- 目标:融合来自多个标签来源(包括DS和模式)的弱标签,以产生去噪标签。

- 本文WLF中采用data programing(DP)(Ratner et al。,2016)

- DP输入单元:标签函数

- 输入实例

- 输出标签:(+1:正,-1:负或0:未知)

- 本文中

- DS:+1,-1,0

- 正模式集合:+1,0

- 负模式集合:-1,0

- 训练:在少量人类标注的标签上训练

- 由此获得了去噪标签

WLF模型旨在融合来自多个标签来源(包括DS和图案)的弱标签,以产生去噪标签。在本文中,我们在WLF模型中采用数据编程(DP)(Ratner et al。,2016)。DP的输入单元称为标签功能(LF),它具有一个实例并发出标签(+1:正,-1:负或0:未知)。在我们的情况下,DS的LF生成+1或-1,正模式的LF生成+1或0,负模式的LF生成-1或0。我们用封闭形式的解决方案估算了一小组带有人类注释的标签上的DP参数(有关详细配方,请参见附录)。借助DP,我们获得了去噪标签,以重新训练更好的模型。请注意,设计更好的通用WLF模型仍然是一个热门的研究主题(Varma等,2016; Bach等,2017; Liu等,2017a),但超出了这项工作的范围,它会自动生成模式以缓解人类的工作。

4 Experiments

- 目标:证明其有效性

4.1 Experimental Setup

- 评估

- 不用Precision,Recall和F1分数–关系类型分类不平衡

- 微观平均评估–会忽略噪声标签问题

- 仅使用人类注释的测试数据来聘雇在噪声标签上训练的模型

- Ratner et al. (2016); Liu et al. (2016) did

- 原因:许多关系类型的严重标记噪音削弱了基于DS的held-out评估(Mintz等,2009)的可靠性

评估。为了清楚地显示各种关系类型的不同噪声行为,我们将每个关系预测任务视为单个二进制分类问题,即针对给定实例预测该关系的存在与否。与以前的研究不同,我们在数据集级别报告特定于关系的度量(Precision,Recall和F1分数,均采用百分比格式)和宏观平均的度量,因为关系类型的分布极不平衡,而微观平均评估不可避免地会忽略许多关系类型的嘈杂标签问题。此外,正如Ratner等人所述,我们仅利用人工注释的测试数据来评估在噪声标签上训练的模型。 (2016);刘等。 (2016)做到了。原因是许多关系类型的严重标记噪音严重削弱了基于DS的保持性评估的可靠性(Mintz等,2009),这无法准确地判断性能。

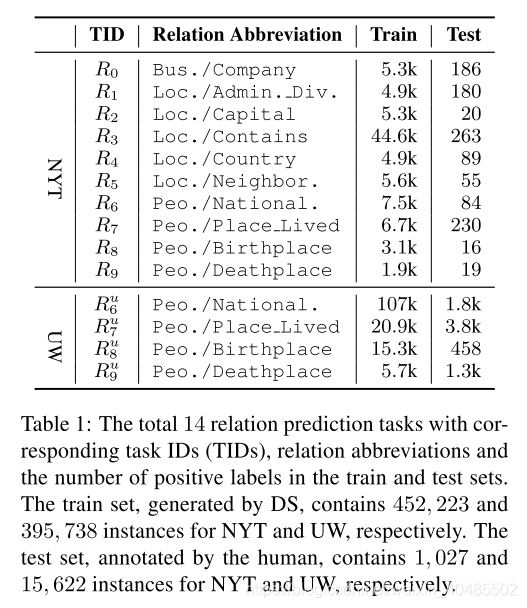

数据和任务。我们从NYT数据集(Riedel et al。,2010)3中选择了十个具有足够覆盖率(超过1,000个实例)的关系类型,并从UW数据集(Liu et al。,2016)4中选择所有四种关系类型。最初,NYT数据集包含一个训练集和一个测试集,它们都由DS分别使用522、611和172、448个实例生成; UW数据集包含由DS生成的火车集,带有人群注释的集和分别具有676、882、18、128和164个实例的最小人类注释测试集。为了实现基于人工注释的可靠评估,对于NYT数据集,我们从测试集中为每个关系(包括特殊的未知关系NA)随机选择了多达100个实例,并对其进行手动注释。而对于UW数据集,我们直接使用具有广泛覆盖范围和非常高质量的人群注释集(与火车集不相交)作为基本事实。表1总结了这14个任务的详细统计信息。

-

超参数

- pytorch

- LSTM(zhou,2016)

- agent网络

- lstm hidden size=200

- adam

- lr=0.001

- batch size=5

- epoch=10

- 模式提取阶段使用

- ϵ=0.1以η=0.05,0.1,0.5,1.0,1.5来训练不同粒度的多个代理,并组合所有代理的输出服务于模式改进阶段\epsilon=0.1\\以\eta={0.05,0.1,0.5,1.0,1.5}来训练不同粒度的多个代理,并组合所有代理的输出服务于模式改进阶段ϵ=0.1以η=0.05,0.1,0.5,1.0,1.5来训练不同粒度的多个代理,并组合所有代理的输出服务于模式改进阶段

- 加速:使用过滤后的实例(他预测概率高的前10000个)

- 模式优化:nr=20,na=10,ph=0.8,,pl=0.1n_r=20,n_a=10,p_h=0.8,,p_l=0.1nr=20,na=10,ph=0.8,,pl=0.1

- 对于每个任务只需要200个标注,并且WLF阶段最多可以有20个模式

- pytorch

-

数据集

- NYT

- UW

4.2 Performance Comparisons

- baseline

- 1)远程监督,Mintz等人描述的vanilla DS。 (2009),

- 2)Gold Label Mix(Liu等人,2016),

- 将带有人类注释的高质量标签与DS生成的噪声标签混合在一起

- 在模式优化阶段获得的200个标签与高质量标签相同

- 3)RLRE(Feng等人,2018)

- 对比试验

- 超参数一样

- 每种情况使用具有5个随机种子的NRE模型(范围从0到4)运行NRE模型,并给出平均分数。

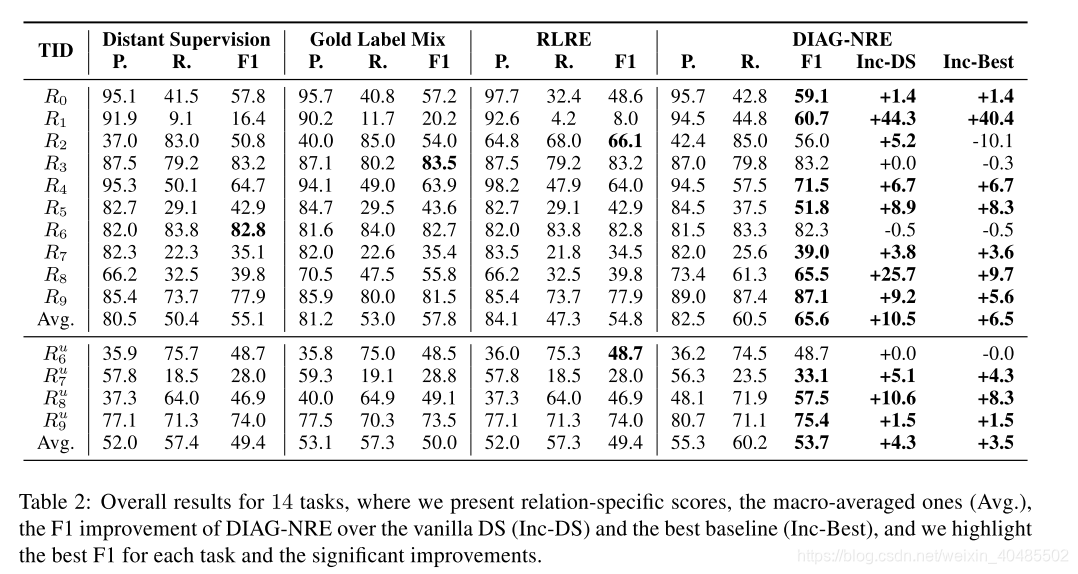

基线。我们采用以下基准:1)远程监督,Mintz等人描述的香草DS。 (2009),2)Gold Label Mix(Liu等人,2016),将带有人类注释的高质量标签与DS生成的噪声标签混合在一起,以及3)RLRE(Feng等人,2018),构建实例选择代理进行选择通过仅与在噪声标签上训练的NRE模型进行交互来正确标记标签。具体来说,对于金标混合,我们使用在图案修饰阶段获得的200个标签与高质量标签相同。为了专注于使用不同方法生成的训练标签的影响,除了要使所有超参数完全相同之外,我们针对每种情况使用具有5个随机种子的NRE模型(范围从0到4)运行NRE模型,并给出平均分数。

- 对比实验结果(提高性能方面)

- 在噪声大的数据集上使用DIAG-NRE提升大

- 在噪声小的任务上,也有一些小的改进

- 对于使用DS就足够了的任务,融合若标签会产生负面影响,但这个副作用小。

4.3 Pattern-based Diagnostic Results

除了提高提取性能外,DIAG-NRE还可以通过改进的模式来解释DS引起的不同噪声影响。接下来,我们从两个角度阐述这些诊断结果以及NRE模型的相应性能下降:假阴性(FN)和假阳性(FP)。

- 诊断效果

- 解释是FN还是FP造成的噪声影响

- FN

- R1,R8,R9

- 原因:语料中有,而KB中不存在此关系

- 精度高,召回率低

- 召回率低的问题引入了太多带有常见关系支持模式的否定实例,从而使NRE模型在捕获正确的特征时感到困惑。

- DIAG-NRE提升了其召回率

- 正模式可以修正FN错误

- FP:

- R8和R8uR_8^uR8u

- 原因:不是所有的出现这两个实体对的句子都表现出他俩在KB中的关系

- 造成精度低:导致NRE模型吸收了一些不相关的模式

- –DIAG-NRE获得了负面模式–以此减少了FP,实现了精度的提高

- 负模式可以修正FP错误

FN。 FN的一个典型示例是任务R1(管理部门),其中DS生成的标签的精度相当好,但召回率却很低。根本原因是,存储在知识库中的关系事实几乎覆盖了语料库实际包含的真实事实。这个召回率较低的问题引入了太多带有常见关系支持模式的否定实例,从而使NRE模型在捕获正确的特征时感到困惑。此问题还解释了表2中的结果,即基于DS生成的数据训练的NRE模型实现了高精度,但召回率较低,而具有增强的正模式的DIAG-NRE由于具有更高的召回率,因此可以获得显着的改进。对于任务R8(出生地)和R9(死亡地),我们观察到类似的低召回率问题。

FP。 FP错误主要由引言中介绍的DS假设引起。例如,DS为任务和生成的标签的精度太低。这种低精度意味着DS生成的阳性标签的大部分没有指示目标关系。因此,此问题不可避免地导致NRE模型吸收一些不相关的模式。这种解释还对应于我们获得了一些负面模式的事实。通过通过负图减少带有FP错误的标签,DIAG-NRE可以实现较大的精度提高。

对于其他任务,DS生成的标签相对来说比较好,但是除任务(包含)R3外,噪声问题(主要还是次要)仍然存在,无论该问题是由DS自动生成的标签都非常准确。我们推测这种高质量标签的原因是,对于任务R3,DS假设与书面语言约定一致:当在一个句子中提到两个包含关系的位置时,人们习惯于明确声明该关系。

4.4 Incremental Diagnosis

- 人类标注对于DIAG-NRE的提升

- 大多是提升后饱和

- R9:在全自动下产生了个错误的实例,后在人类标注下修复了此错误

除了基于200个人类注释实例的性能比较之外,我们还通过将人类注释的数量从10个逐渐增加到200个,显示了DIAG-NRE的增量诊断能力。如图5所示,在我们选择那些遭受较大标签噪音的任务(来自纽约市的三个任务和来自威斯康星州的两个任务)的情况下,大多数任务在DIAG-NRE自动生成的高质量模式的帮助下经历了快速改进阶段,然后进入饱和状态阶段,其中添加注释的贡献不大。这种饱和度符合直觉,即高质量的关系模式通常受到限制。唯一的例外是任务R9,它先丢失然后又增加,原因是DIAG-NRE的全自动模式修饰意外地产生了一个错误模式,而后来的模式减轻了该错误。实际上,实际上,用户可以进一步管理DIAG-NRE生成的模式以获得更好的结果,这比从头开始编写模式要容易和快捷得多。

4.5案例研究

表4显示了来自三个任务的五个模式示例。对于任务R1,正模式可以纠正由DS引起的极低覆盖率。对于任务R8和R9,除了借助肯定模式以外,否定模式还可以纠正由DS引起的许多FP标签。这些案例直观地说明了DIAG-NRE诊断DS生成的标签并对其去噪的能力。

参考文献

References

Gabor Angeli, Julie Tibshirani, Jean Wu, and Christopher D Manning. 2014. Combining distant and partial supervision for relation extraction. In EMNLP.

Stephen H. Bach, Bryan He, Alexander Ratner, and Christopher R´e. 2017. Learning the structure of generative models withut labeled data. In ICML.

Dzmitry Bahdanau, Kyunghyun Cho, and Yoshua Bengio. 2015. Neural machine translation by jointly learning to align and translate. In ICLR.

Mary Elaine Califf and Raymond J. Mooney. 1999. Relational learning of pattern-match rules for information extraction. In AAAI.

Andrew Carlson, Justin Betteridge, Bryan Kisiel, Burr Settles, Estevam R Hruschka Jr, and Tom M Mitchell. 2010. Toward an architecture for neverending language learning. In AAAI.

Yubo Chen, Shulin Liu, Xiang Zhang, Kang Liu, and Jun Zhao. 2017. Automatically labeled data generation for large scale event extraction. In ACL.

Mark Craven, Johan Kumlien, et al. 1999. Constructing biological knowledge bases by extracting information from text sources. In ISMB.

Jun Feng, Minlie Huang, Li Zhao, Yang Yang, and Xiaoyan Zhu. 2018. Reinforcement learning for relation classification from noisy data. In AAAI.

Sepp Hochreiter and J¨urgen Schmidhuber. 1997. Long short-term memory. Neural computation.

Raphael Hoffmann, Congle Zhang, Xiao Ling, Luke Zettlemoyer, and Daniel S Weld. 2011. Knowledgebased weak supervision for information extraction of overlapping relations. In ACL.

Meng Jiang, Jingbo Shang, Taylor Cassidy, Xiang Ren, Lance M Kaplan, Timothy P Hanratty, and Jiawei Han. 2017. Metapad: meta pattern discovery from massive text corpora. In KDD.

Diederik P Kingma and Jimmy Ba. 2014. Adam: A method for stochastic optimization. arXiv preprint arXiv:1412.6980.

Jiwei Li, Will Monroe, and Dan Jurafsky. 2016. Understanding neural networks through representation erasure. arXiv preprint arXiv:1612.08220.

Yankai Lin, Haozhe Ji, Zhiyuan Liu, and Maosong Sun. 2018. Denoising distantly supervised open-domain question answering. In ACL.

Yankai Lin, Shiqi Shen, Zhiyuan Liu, Huanbo Luan, and Maosong Sun. 2016. Neural relation extraction with selective attention over instances. In ACL.

Angli Liu, Stephen Soderland, Jonathan Bragg, Christopher H Lin, Xiao Ling, and Daniel S Weld. 2016. Effective crowd annotation for relation extraction. In NAACL-HLT.

Liyuan Liu, Xiang Ren, Qi Zhu, Shi Zhi, Huan Gui, Heng Ji, and Jiawei Han. 2017a. Heterogeneous supervision for relation extraction: a representation learning approach. In EMNLP.

Tianyu Liu, Kexiang Wang, Baobao Chang, and Zhifang Sui. 2017b. A soft-label method for noisetolerant distantly supervised relation extraction. In EMNLP.

Bingfeng Luo, Yansong Feng, Zheng Wang, Zhanxing Zhu, Songfang Huang, Rui Yan, and Dongyan Zhao. 2017. Learning with noise: enhance distantly supervised relation extraction with dynamic transition matrix. In ACL.

Mike Mintz, Steven Bills, Rion Snow, and Dan Jurafsky. 2009. Distant supervision for relation extraction without labeled data. In ACL.

Ndapandula Nakashole, Gerhard Weikum, and Fabian Suchanek. 2012. Patty: a taxonomy of relational patterns with semantic types. In EMNLP.

Jeffrey Pennington, Richard Socher, and Christopher Manning. 2014. Glove: global vectors for word representation. In EMNLP.

Maria Pershina, Bonan Min, Wei Xu, and Ralph Grishman. 2014. Infusion of labeled data into distant

supervision for relation extraction. In ACL.

Pengda Qin, Weiran Xu, and William Yang Wang. 2018. Robust distant supervision relation extraction via deep reinforcement learning. In ACL.

Alexander J Ratner, Christopher M De Sa, Sen Wu, Daniel Selsam, and Christopher R´e. 2016. Data programming: creating large training sets, quickly. In NIPS.

Sebastian Riedel, Limin Yao, and Andrew McCallum. 2010. Modeling relations and their mentions without labeled text. In ECML.

David E Rumelhart, Geoffrey E Hinton, and Ronald J Williams. 1986. Learning representations by backpropagating errors. Nature.

Cicero dos Santos, Bing Xiang, and Bowen Zhou. 2015. Classifying relations by ranking with convolutional neural networks. In ACL.

Mihai Surdeanu, Julie Tibshirani, Ramesh Nallapati, and Christopher D Manning. 2012. Multi-instance multi-label learning for relation extraction. In EMNLP.

Richard S Sutton, David A McAllester, Satinder P Singh, and Yishay Mansour. 2000. Policy gradient methods for reinforcement learning with function approximation. In NIPS.

Shingo Takamatsu, Issei Sato, and Hiroshi Nakagawa. 2012. Reducing wrong labels in distant supervision for relation extraction. In ACL.

Paroma Varma, Bryan He, Dan Iter, Peng Xu, Rose Yu, Christopher De Sa, and Christopher R´e. 2016. Socratic learning: augmenting generative models to incorporate latent subsets in training data. arXiv preprint arXiv:1610.08123.

Ronald J Williams. 1992. Simple statistical gradientfollowing algorithms for connectionist reinforcement learning. Machine learning.

Yi Wu, David Bamman, and Stuart Russell. 2017. Adversarial training for relation extraction. In EMNLP.

Dmitry Zelenko, Chinatsu Aone, and Anthony Richardella. 2003. Kernel methods for relation extraction. JMLR.

Daojian Zeng, Kang Liu, Yubo Chen, and Jun Zhao. 2015. Distant supervision for relation extraction via piecewise convolutional neural networks. In EMNLP.

1428

Daojian Zeng, Kang Liu, Siwei Lai, Guangyou Zhou, Jun Zhao, et al. 2014. Relation classification via convolutional deep neural network. In COLING.

Ce Zhang, Feng Niu, Christopher R´e, and Jude Shavlik. 2012. Big data versus the crowd: looking for relationships in all the right places. In ACL.

Tianyang Zhang, Minlie Huang, and Li Zhao. 2018. Learning structured representation for text classification via reinforcement learning. In AAAI.

Guodong Zhou, Jian Su, Jie Zhang, and Min Zhang. 2005. Exploring various knowledge in relation extraction. In ACL.

Peng Zhou, Wei Shi, Jun Tian, Zhenyu Qi, Bingchen Li, Hongwei Hao, and Bo Xu. 2016. Attentionbased bidirectional long short-term memory networks for relation classification. In ACL.

,考虑长距离的实体标签之间的关)