Cite: Koh P W, Liang P. Understanding black-box predictions via influence functions[J]. arXiv preprint arXiv:1703.04730, 2017.

链接:https://arxiv.org/pdf/1703.04730

GitHub项目地址:http://bit.ly/gt-influence

本文使用影响函数(Influence functions)这种工具来研究模型训练样本对模型预测结果的影响,并由此对黑盒模型的预测结果进行解释。

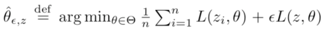

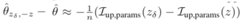

Influence functions由Cook以及Weisberg在鲁棒统计(statistics)中引入,它研究了estimator随着其输入分布变化而变化的方式。在模型训练过程中,假设修改一个训练样本的权重后,新的参数变为

其中z为(x,y),即一个样本

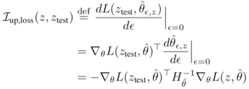

当损失函数L二阶可微且在原始参数附近为凸函数时,根据influence functions理论可得

其中

通过以上结论,可以得到移除一个训练样本对模型参数的影响为

而对一个训练样本进行轻微扰动对模型参数的影响为

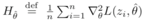

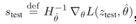

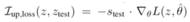

可以看到,在 I_(up,loss)(z, z_test) 中,需要求解Hessian矩阵的逆矩阵,直接计算的复杂度会很高,因此将其计算分解成两部分

这样可以使痛HVPs(Hessian-vector products)的方法进行计算第一部,然后再计算第二步。具体地,可以使用共轭梯度,直接优化得到H_θ ̂^(-1)v 。此外,还可以使用统计估计方法,计算得到 H_θ ̂^(-1)v 的无偏估计值。

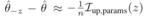

对于非凸函数,可以构造一个近似的二次凸函数进行拟合,然后再对这个凸函数应用influencefunctions进行分析处理。一种拟合方式为

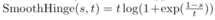

而对于一些非二次可微函数,例如Hingeloss,可以使用连续可微函数进行近似,例如Smooth Hinge

influence functions的结果可以应用到多个场景中对模型进行解释:

1. 理解模型的行为

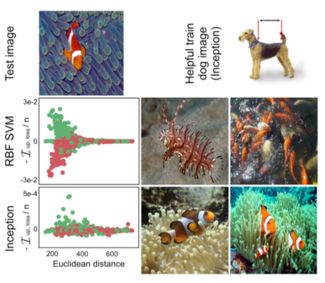

对比相同样本的修改对不同模型预测的影响可以对模型预测的行为进行解释,文中对比了Inception V3和SVM模型在dog-fish图片分类问题中的行为,结果如下

svm这种简单的模型依靠更浅层的特征(欧式距离),而Inception V3使用更深层的特征

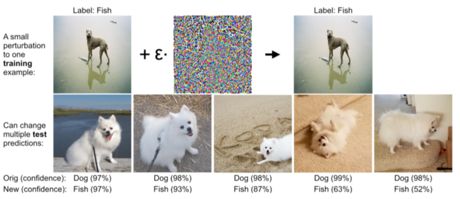

2. 产生对抗样本

通过不断的修改训练样本来提高预测的误差,可以产生得到对抗样本

。还是在dog-fish图片分类问题,可以得到以下的结果

除了以上的用法,influence还可以应用到检测训练集/测试集的一致性,修正错误标签的样本等场景中。

本文作者王旦龙,浙江大学,研究方向是自然语言处理,机器学习。

OpenKG.CN

中文开放知识图谱(简称OpenKG.CN)旨在促进中文知识图谱数据的开放与互联,促进知识图谱和语义技术的普及和广泛应用。

转载须知:转载需注明来源“OpenKG.CN”、作者及原文链接。如需修改标题,请注明原标题。

点击阅读原文,进入 OpenKG 博客。

终身学习项目-EventKGNELL(学迹))