文 | Qs.Zhang张拳石@知乎

可解释性研究一直有两副嘴脸,一副烈火烹油繁花似锦,一副如履薄冰零丁洋里叹零丁。

在2018年我开始发知乎是为了“活着”——被刷榜为王的风气屡屡打击之后,一朝中稿,倒过一口气来,终于可以跟大家说一声:看,在可视化之外,这也是可解释性,也是一个研究方向。

可我没想到,两年后我需要继续为了“活着”而继续发知乎——如果研究仅仅停留在自圆其说的直觉层面,如果每种解释都可以自圆其说,那么就不存在正确的解释了,而且据我观察这样的文章的中稿率是很低的。

在这方面只有个别的扎实的研究,比如Shapley value,它为“正确的归因热图”列出了看似不证自明但又很难实现的四大数学标准,它通过满足这些性质或标准,来体现其解释的严谨性。如果没有理论保证其严谨性和客观性,不把技术变成科学,那么解释性研究迟早进退失据,砸了牌子,覆巢之下无完卵。当然了,在各种学术邀请报告上,还是需要端着第一副嘴脸。

不要误会,这篇不是可解释性劝退文,相反我对其有一半的信心:有可能一事无成,到头来空发一些论文,也可能真正做出少许扎实的工作。这种半生半死的不成熟方向有时候是最精彩的,最有潜力的。可能因为我在学术方面还不够刻薄,所以在自信和自省的人肉对抗训练中,前者还没有败,还会坚持。

说到可解释性的“客观严谨性”,往往意味着“一般性”和“唯一性”,即“唯一标准的解释”。

“一般性” 比较容易理解,就是说算法的建模方法要看上去更加标准,与前人理论有更多的连接,而不是针对特定情景的ad-hoc技术。

相比之下解释的 “唯一性” 很少有人提及,或者有人不仅反问“凭什么是唯一的呢?”这里我们就要对“什么是好的解释”提出一些限定性的要求,比如好的解释必须满足怎样的条件,并对这些条件进行建模,这时“唯一性”就体现在满足这些条件下的唯一解。往小了说,对解释性的要求条件可以是Shapley value对应的四大公理;往大了说,对解释性的要求也可以是解释性指标的适用范围,比如同一个指标可以“即解释语义,又解释泛化,还解释迁移”。

跳出刚才的话题,现在让我们面对整个解释性领域。一个研究方向是否“活着”,或者是否“以后依然可持续活着”,不在于这个领域里面发表了多少篇论文,也不在于有多少引用,而是某个研究方向上还有多少本质的问题点没有被数学建模没有被解决(当然这里指的是扎实的建模,而不是刻意挂着某个新概念去炒作)。

归根到底,我还是绕不开老朱的前瞻和影响,战略科学家2015年一句“深度学习已经xx了”,足够我消化十几年——当一个人帮你把灌水的捷径全部都堵死的时候,你需要从泥巴里硬刨出一条路,这可能才是学术要走的——虽然很可能死在半道上,早有了“自己的笑话自己看”的心理准备了。

前段臭文艺了,现在回到解释性问题的原点。神经网络可解释性研究的初衷其实非常简单,就是让调参或炼丹式的神经网络训练和设计得到理论指导,让神经网络所建模的信息得到可靠性的检验。但是,这样的初衷所带来的研究难度也是非常大的,简要来说,一个可靠的可解释性研究需要同时满足以下几个要求。

需要对解释目标进行直接的理论建模,而不是基于直觉提出间接的解释算法。

需要定量的解释结果,而非定性的解释结果。

需要对解释结果的客观性(或严谨性)给出评测,或者证明。而不是仅仅要求解释结果从直觉上看上去好看。

对于很多新兴解释性问题,有时候我们无法给出直接的评测,或者神经网络的ground-truth。这时,需要通过更加扎实的理论体系来证明,数学建模的严谨性。

比如,Shapley value的严谨性是通过它满足四大公理来保证的。类似地,你的建模方法也需要满足大量的公理,或者展现出很好的性质,来体现此解释性建模方法的严谨性。

再比如,不同解释性算法或者解释性指标之间,如果可以做到相互印证,这样的解释往往是更加严谨的。

解释性理论需要有外延应用上的推导,需要在现实应用中,解释各种现象,或者可以直接反馈指导神经网络的设计和训练。

简单总结一下,可解释性不仅仅需要“实验评测”语义,更需要“理论解释并建模”语义背后的“信息处理机理”,打通“直觉上的语义”与“数学建模”的壁垒,打通“数学上的泛化边界”与“符号化语义/知识表达”间的壁垒。让解释性变成扎实一些的研究。不把基础打扎实了,领域的声誉就坏掉了。

“数学上的泛化边界”或叫“神经网络的表达能力”都是目前学界研究的新突破口,只可惜大部分研究没有把现有理论和语义解释统一构建在同一个体系。目前在可解释性领域中,各种算法理论往往都是零丁洋里一个个破碎零丁小点,没有连接起来,没有相互印证。没多少人叹零丁,更没多少人填海。

另一方面,上述要求都是让人崩溃的,需要从头学从头补,漫无边际拍脑袋。这两年失败了不知多少次。如果做不出来,我可以去工业界“不如回家卖红薯”,但是学生们都要发论文毕业的,我就没有后退的理由了。虽然常常被我批评,但是很多学生都是非常优秀的,很多自觉跟随的学生一直996,经历了很多失败的尝试,即使做出些东西也未必会被主流认可。这些不是他们的年纪必须承受的,我也无法补偿,所以希望大家关注一下他们的成果。我感觉几年后他们中一些人是可以成长起来的。

当然了,后面讲的一些研究都是学生们最近刚刚做的,理论还不牢固,证明中还是需要很多的近似假设,离真正的目标还差得很远。

总的来说,《神经网络的交互可解释性》主要介绍了我们课题组近期五篇论文中的研究内容,基于博弈论来定义、建模、量化神经网络所建模的变量交互效应,推导相应的定理体系,并基于此博弈交互作用来定量解释神经网络所建模的不同语义类型,在知识表达层面解释对抗攻击的效用和神经网络的泛化能力。

神经网络可解释性研究需要更多的数学工具和丰富的证明,需要新的体系,需要体系中不同研究间的相互印证,需要在数学层面将网络结构与知识表达关联起来,需要将知识表达与模型性能关联起来。以上种种,都是这些研究的初衷,但远远不是几篇文章可以解决的问题。

目前的成果只是前期的探索,还远远称不上什么体系。寄蜉蝣于天地,渺沧海之一粟。哀吾生之须臾,羡长江之无穷。独上高楼,望尽天涯路。

文章体系

文章体系

一、前言,漂在零丁洋里的体系

二、博弈交互概念、定义、定理、推论、与计算

动机:建模知识,连接性能

背景基础Shapley value

双变元博弈交互

多变元博弈交互,及其近似计算

多阶博弈交互

相关定理与推论

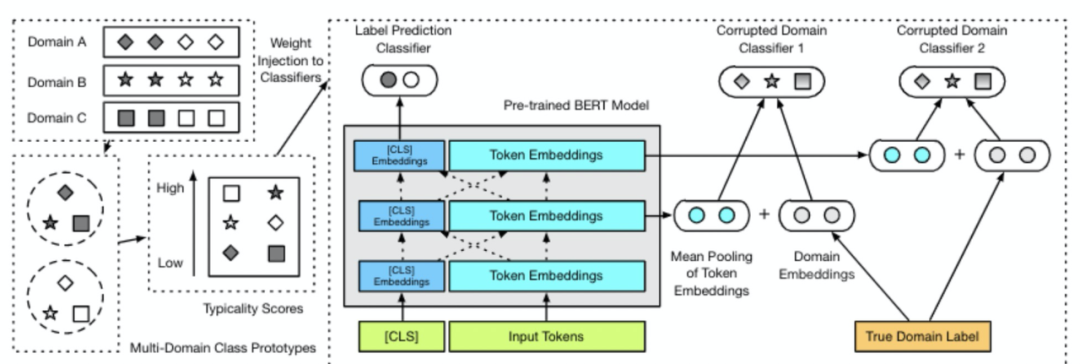

自然语言交互树

三、博弈交互与知识表达的关系

为何要对视觉语义进行建模

局部纹理特征、全局纹理特征、组成部分半信息特征,组成部分全信息特征的建模

语义特征的泛化性

四、博弈交互与对抗攻击的关系,推导证明与实验

证明博弈交互与对抗迁移性的负相关关系

推导证明多个前人迁移性增强算法可近似归纳解释为对博弈交互的抑制

交互损失函数与迁移性的增强

五、博弈交互与泛化能力的关系,推导证明与实验

探索交互强度与泛化能力的关系

证明Dropout对交互强度的抑制

交互强度损失函数与泛化能力的提升

下面仅介绍第四、第五两章

博弈交互与对抗攻击的关系

大家好,我们是王鑫和任洁,是张拳石老师@Qs.Zhang张拳石 的博二、博一的学生。“博弈交互与对抗攻击的关系”的研究是在张老师的指导下,我们共同牵头领导完成的。

对应论文 Xin Wang, Jie Ren(共一), Shuyun Lin, Xiangming Zhu, Yisen Wang, Quanshi Zhang, “A Unified Approach to Interpreting and Boosting Adversarial Transferability” in ICLR 2021

本研究包括以下三个方面。

我们提出并验证了对抗扰动单元间博弈交互与对抗迁移性的负相关关系。

我们推导证明了前人的多种迁移性增强算法可以近似归纳解释为对这种博弈交互的抑制。

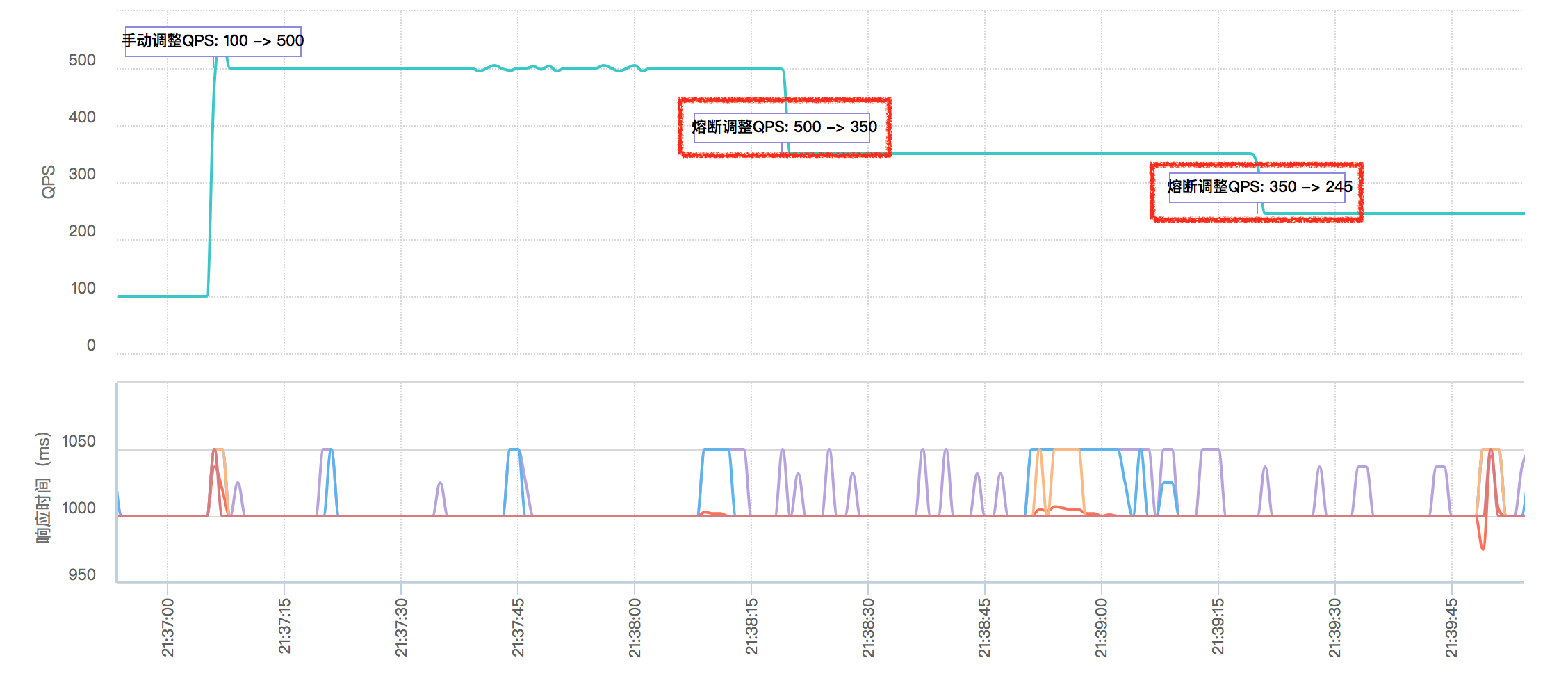

我们提出一个损失函数在攻击过程中直接抑制博弈交互,从而增强对抗迁移性。实验证明,该损失函数在各种设定下均能够显著提高对抗扰动的可迁移性。在大多数情况下,相对于对比组,加上抑制博弈交互损失函数后所产生的对抗样本的可迁移性提升一般都在10%以上。进一步地,我们将能降低博弈交互的攻击方法进行组合。在我们的实验中,该方法将所产生的对抗样本的可迁移性由48.9%~98.5%提升至了69.8%~99.1%。

博弈交互与对抗迁移性的负相关关系

近年来,深度神经网络的对抗训练越来越受到关注,很多研究使用在源DNN上生成的扰动攻击其他目标DNN,探讨了对抗扰动的可迁移性,并提出了许多方法增强对抗扰动的可迁移性。但是在前人研究中,这些方法提高迁移性的内在机理仍不清楚。

本研究从对抗扰动内部的博弈交互这一新的角度,解释对抗扰动的可迁移性,基本思路如下:

首先,我们定义了对抗扰动内部的博弈交互值。

其次,我们推导证明了多步对抗攻击得到的对抗扰动往往比单步攻击得到的对抗扰动显示出更强的博弈交互作用。根据文献[1],比起单步攻击的对抗扰动,多步攻击产生的对抗扰动往往更容易过拟合源DNN的参数,且可迁移性较低。我们认为复杂的博弈交互反映了对抗扰动对源DNN的过拟合,从而损伤了其在目标网络中的可迁移性。

因此,我们提出假设:对抗扰动的迁移性与其内部的博弈交互是负相关的。我们进一步通过理论(近似)证明和比较实验验证了这一假设。

交互值的定义:我们定义了对抗扰动内部的博弈交互,即基于Shapley Value量化对抗扰动不同单元间的博弈交互值。给定一个输入x,用δ表示对抗攻击在样本x上生成的扰动。δ往往通过优化下面的损失函数得到。

其中 表示分类损失函数。

对于扰动向量δ,我们用Ω={1,2, …, n}表示其中的元素全集,δi表示第个像素上的扰动值,称为扰动单元。对抗扰动δ的对抗效用被定义为:

我们基于博弈论中的沙普利值(Shapley value)定义两两对抗扰动单元之间的博弈交互作用(对博弈交互的详细的定义与讨论,请见第二章)。对于每个对抗扰动单元 ,基于Shapley Value计算其对对抗效用Transfer Utility的贡献度,表示为

。进一步,定义扰动单元

和

之间的博弈交互为:

其中第一项表示将i, j视为一个整体

时,对对抗效用的总贡献值, 这时,δi和δj总是同时存在,或同时不存在,因此可以认为此时共有n-1个对抗单元,即

。

第二项为对抗扰动 不存在时,对抗扰动单元

对对抗效用的总贡献值。

第三项为对抗扰动不存在时,对抗扰动单元

对对抗效用的总贡献值。

如果 ,说明i,j在一起能获得比各自单独贡献时更大的贡献值。这是一种1+1>2的效应,代表i,j之间存在正的交互作用。如果

,说明在一起能获得贡献值反而比各自单独贡献时更小。这是一种1+1<2的效应,代表i,j之间存在负的交互作用。

提出假设:基于上述定义,我们提出并(近似)证明了以下proposition。

Proposition 1 表明,一般情况下,与单步攻击相比,多步攻击产生的对抗扰动倾向于表现出更强的博弈交互。直观来看,较强的博弈交互意味着扰动单元之间的紧密联系,这表明扰动向量对源DNN存在明显的过拟合。文献[1]指出多步攻击往往使产生的对抗扰动更容易过拟合,从而导致可迁移性较低。因此,我们提出假设:对抗扰动的可迁移性与其内部的博弈交互呈负相关。

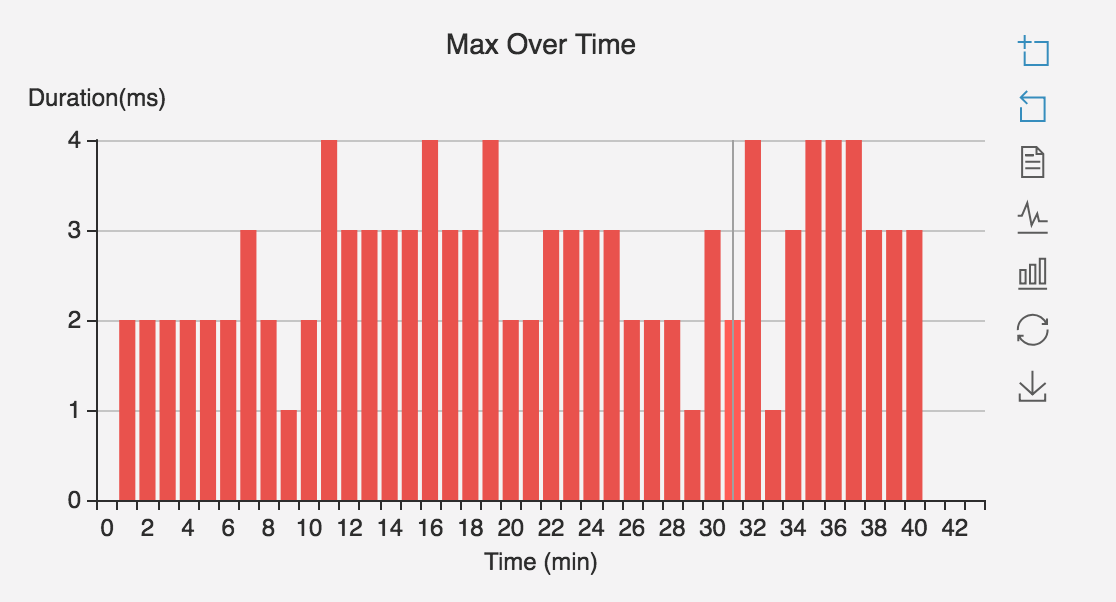

验证一: 我们通过实验比较了可迁移性较弱的对抗扰动和可迁移性较强的对抗扰动的博弈交互, 验证了这一负相关关系。基于ImageNet数据集,我们在ResNet-34/152(RN-34/152)和DenseNet-121/201(DN-121/201)上分别产生对抗扰动,并将ResNets上产生的扰动迁移到DenseNets中,将DenseNets上产生的扰动迁移到ResNets中。图1显示了对抗迁移性与博弈交互之间的负相关关系,其中横轴表示对抗扰动内部的博弈交互强度,纵轴表示该对抗扰动在目标DNN上的的对抗效用。

推导证明多个前人迁移性增强算法可近似归纳解释为对博弈交互的抑制

验证二: 对抗扰动的可迁移性与博弈交互之间的负相关性,可以视为一种统一的角度去解释目前的迁移性增强算法的内在机理。即,我们分析并(近似)证明了以下三种迁移性增强算法实质上降低了对抗扰动内的博弈交互。与此同时,这些研究也间接验证了对抗扰动的可迁移性与博弈交互之间的负相关性。

(1)Variance-Reduced Attack (VR Attack) [2]

详细内容和证明可见论文以及附加材料。

(2)Momentum Iterative Attack (MI Attack) [3]

详细内容和证明可见论文以及附加材料。

Proposition 2 和 Proposition 3 证明了一般情况下,VR Attack 和MI Attack 相较于普通的多步攻击,都能够降低对抗扰动的博弈交互。

(3)Skip Gradient Method (SGM Attack) [4]

SGM Attack利用ResNets中skip-connections的梯度信息来提高对抗扰动的可迁移性。SGM Attack修改了反向传播中的梯度,可以将其视为在反向传播中添加了Dropout操作。我们证明了Dropout操作可以降低博弈交互的显著度(详情见本文的第五章),从而降低DNN的过拟合。因此,这也证明SGM Attack降低了对抗扰动内的博弈交互。

除了以上理论证明,我们还设计了实验验证,比较了以上攻击方法产生的扰动与baseline攻击[5]产生的扰动,结果证明以上攻击方法显著降低了对抗扰动的博弈交互。

交互损失函数与迁移性的增强

验证三: 基于以上发现,我们提出了博弈交互损失函数,通过在攻击过程中降低扰动单元间的博弈交互,提高对抗扰动的可迁移性。基于以下公式,我们同时优化分类损失函数和博弈交互损失函数来生成对抗扰动,该方法被称为Interaction-Reduced Attack (IR Attack)。

实验结果表明,博弈交互损失函数可以显著提高对抗扰动的可迁移性,达到目前最优的迁移性能。在大多数情况下,相对于对比组,加上抑制博弈交互损失函数后所产生的对抗样本的可迁移性提升都在10%以上。进一步的,我们将能降低博弈交互的攻击方法进行组合。在我们的实验中,该方法将所产生的对抗样本的可迁移性由48.9%~98.5%提升至了69.8%~99.1%。

同时,交互损失函数对迁移性的提升也间接验证了对抗扰动的可迁移性与博弈交互之间的负相关性。

实验结果

实验结果

基于ImageNet数据集,在AlexNet,VGG-16等六种源DNN上,我们使用IR Attack生成对抗扰动并将其迁移到VGG-16,ResNet-152等7种目标DNN上。此外,我们还将IR Attack应用到ensemble-based attack中,如表1所示。与baseline attack [5]相比,IR Attack在各种源DNN和目标DNN上都显著提升了对抗扰动的可迁移性。

以上实验中的目标DNN都是未经过对抗训练的unsecured DNNs,我们还在经过对抗训练的secured DNNs上对IR Attack产生的对抗扰动的可迁移性进行了测试,其中Translation invariant attack (TI Attack) [6]是议中专门针对目标神经网络为对抗训练后的secured DNNs的攻击方法,我们在TI Attack的基础上加入博弈交互损失函数得到TI+IR Attack,结果如表2所示。博弈交互损失函数也提升了针对secured DNNs的可迁移性。

我们进一步将博弈交互损失函数和其他降低交互作用的攻击方法进行结合。如上文提到的,MI Attack,VR Attack,SGM Attack这三种方法都在降低扰动单元之间的博弈交互。并且,SGM Attack是目前迁移性能最好的攻击方法,我们将博弈交互损失函数作为一种降低博弈交互的工具,添加到SGM Attack中,以进一步提高对抗迁移性。

值得注意的是,interaction loss只是降低博弈交互的一种直接手段,我们可以将以上可以降低扰动间博弈交互的攻击方法结合到一起去共同降低扰动间的博弈交互,以进一步提高对抗迁移性。因此,我们提出了HybridIR Attack(MI+VR+SGM+IR Attack)。

此外,我们还测试了IR Attack中博弈交互损失函数的权重对可迁移性的影响,图3(a) 显示了对抗扰动的可迁移性随博弈交互损失函数的权重λ增加而增加。说明在一定范围内, 对抗扰动的可迁移性时随内部博弈交互的降低而增大的,这反映了对抗扰动的可迁移性与其内部的博弈交互的负相关性。

我们还发现一个现象,即使在不使用分类损失函数,即仅使用博弈交互损失函数,所产生的扰动也具有一定的迁移性。为了进一步研究博弈交互损失函数的影响,我们仅通过博弈交互损失函数来生成对抗扰动,而不使用分类损失函数。图3(b) 表明这样生成的对抗扰动仍然具有一定的可迁移性。这可能是由于这些对抗扰动会减少DNN中正常的博弈交互,从而破坏了用于推理的正常pattern。

【作者】

王鑫:上海交通大学博士二年级,师从张拳石副教授。xinwang98.github.io/

任洁:上海交通大学博士一年级,师从张拳石副教授。jie-ren.github.io/

林澍昀:上海交通大学大四本科生,现在张拳石实验室进行实习研究。

朱祥明:上海交通大学大三本科生,现在张拳石实验室进行实习研究。

王奕森:北京大学研究员/助理教授。http://www.cis.pku.edu.cn/info/1084/1637.htm

张拳石:上海交通大学副教授,博士生导师。http://qszhang.com

博弈交互与泛化能力的关系

对应论文:Hao Zhang, Sen Li, Yinchao Ma, Mingjie Li, Yichen Xie, Quanshi Zhang, “Interpreting and Boosting Dropout from a Game-Theoretic View” in ICLR 2021.

大家好,我叫张昊(https://haozhang37.github.io),是张拳石老师@Qs.Zhang张拳石 的学生,今年硕士一年级。“博弈交互与泛化能力的关系,证明与实验”的研究是在张老师的指导下,我跟课题组中李森、马银超、李明杰等同学共同完成的。

在本课题中,我们

(1)发现过拟合的样本中往往建模了更强的博弈交互;

(2)证明了dropout对于博弈交互强度的抑制;

(3)提出了博弈交互损失函数,能够进一步提升神经网络的泛化能力。

相比于传统的Dropout,交互损失函数能更加显式地控制对交互强度的惩罚,在网络训练过程中实现从过拟合到欠拟合的精确控制,并且克服了dropout和batch normalization的不兼容问题。

探索交互强度与泛化能力的关系——过拟合的样本往往包含了更多的博弈交互

在本课题中,我们将从博弈交互的角度对dropout的效用进行解释与建模,并提出了dropout的替代算法,能够更好地发挥dropout的效用。

首先,我们将研究神经网络的泛化能力与网络所建模的博弈交互之间的关系。在这里,我们使用的是第二章中所定义的双变元博弈交互。给定一个神经网络,ϕ(i)表示在博弈论中定义的某一个输入变量i的重要性(Shapley值)。两个输入变量i和j之间博弈交互值I(i,j)被定义为当变量j存在时和当变量j不存在时, 的变化量,即

。

博弈交互的具体计算方式请参考原论文或第二章。若变量j的存在能够让变量i的重要性增加,即二者可以达到1+1>2的效果,那么变量i、j之间的博弈交互为正。否则,二者会有1+1<2的效果,此时二者之间的博弈交互为负。博弈交互值的绝对值可视为博弈交互的强度。下图对神经网络所建模的双变元博弈交互的强度(交互值的绝对值)进行了可视化。人面部的格子往往与周边格子的博弈交互更大。

进一步地,I(i,j)能够被分解为不同阶的博弈交互分量,如下:

其中Δf(S,i,j)=f(S∪{i,j})-f(S∪{i})-f(S∪{j})+f(S)。s表示像素i、j之外的背景中像素的多少。当背景中有较多的像素时,s较大,此时i和j之间的博弈交互可以视作高阶的博弈交互,当背景中的像素数量较少时,s较小,i和j之间的博弈交互为低阶的博弈交互。关于上式的推导和多阶博弈交互的更多讨论,请参考原文或第二章。

我们通过实验发现,在分类任务中,过拟合的样本往往包含了更多的博弈交互,而正常的样本中博弈交互较小。

证明Dropout对交互强度的抑制

接下来,我们将证明dropout是一种能够有效降低网络建模的博弈交互的算法。

首先我们证明,输入变量i与j之间的第s阶的博弈交互可以拆分为不同子阶的交互分量。

然后,我们证明Dropout操作可以降低全部子阶分量的博弈交互强度,从而降低整体的交互强度。

同时,我们设计了一系列实验,证明了dropout能够有效降低神经网络所建模的博弈交互。我们分别在有dropout和没有dropout参与的情况下训练神经网络。如下图所示,未使用dropout的神经网络建模了更多的博弈交互。

交互强度损失函数与泛化能力的提升

基于上面的分析,我们设计了交互损失函数作为对dropout效用的提升。我们使用设计的交互损失函数训练深度神经网络,可以进一步提升网络性能。加上原有的分类损失函数,总的损失函数如下:

其中λ>0是交互损失函数的权重。

和dropout相比,我们提出的交互损失函数有如下优势:

第一,交互损失函数能通过调整权重λ,更加显式地控制对交互强度的惩罚。这样的显式控制能够在网络训练过程中平衡好过拟合和欠拟合。我们在实验中比较dropout和交互损失函数降低交互的强度,实验结果验证了我们的结论。

第二,由于dropout和batch normalization的不兼容性,一般不能在使用了bn的网络中使用dropout [1]。相较而言,交互损失函数和bn是兼容的。我们的实验结果也验证了交互损失函数和bn的兼容性。

在实验中,我们使用交互强度损失函数训练了多个神经网络进行分类任务,并尝试了不同的权重。

下表给出了使用不同权重的交互损失函数训练的网络的准确率和使用dropout训练的网络的准确率。

从表中可以看出,一开始随着权重的不断增大,准确率也不断增大,当权重增大到一定程度再继续增大的时候准确率开始下降。这可能是因为当权重比较小的时候,交互损失函数能消除过拟合的影响;当权重大到一定程度的时候,又会造成欠拟合。此外,当选取合适的权重的时候,使用交互损失函数训练的网络的准确率一般会超过使用dropout训练的网络。这表明交互损失函数能够提升dropout的效用。

下图展示了使用不同权重交互损失函数的网络在训练过程中交互强度和准确率的变化曲线。

首先,我们发现随着权重的增大,交互强度不断减小,这验证了交互损失函数的有效性。其次,当权重选择合理时,使用交互损失函数训练的网络的性能一般会超过使用dropout训练的网络的性能,可见,交互损失比dropout更能有效地降低交互强度和提升网络性能。

此外,我们还探究了神经网络中适合加入交互损失/dropout的位置。如下表所示,交互损失更适合加在低的卷积层。而dropout对于使用的位置并没有一个明显的倾向性。

综上所述,相比dropout,交互损失有两个优势。一方面,交互损失能够更有效地控制网络建模的过拟合/欠拟合程度,而dropout无法显式地控制。此外,和dropout不同,交互损失和bn兼容。相较而言,交互损失没有因bn的使用降低分类准确率。

【作者】

张昊:上海交通大学硕士一年级,师从张拳石副教授。https://haozhang37.github.io

李森:中山大学,2019年本科毕业,现在张拳石实验室进行实习研究。

马银超:华中科技大学大四本科生,现在张拳石实验室进行实习研究。

李明杰:上海交通大学大四本科生,现在张拳石实验室进行实习研究。

谢熠辰:上海交通大学大四本科生,现在张拳石实验室进行实习研究。

张拳石:上海交通大学副教授,博士生导师。qszhang.com

后台回复关键词【入群】

加入卖萌屋NLP/IR/Rec与求职讨论群

后台回复关键词【顶会】

获取ACL、CIKM等各大顶会论文集!

[1] Cihang Xie, Zhishuai Zhang, Yuyin Zhou, Song Bai, Jianyu Wang, Zhou Ren, and Alan L Yuille. Improving transferability of adversarial examples with input diversity. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp. 2730–2739, 2019.

[2] Lei Wu, Zhanxing Zhu, and Cheng Tai. Understanding and enhancing the transferability of adversarial examples. arXiv preprint arXiv:1802.09707, 2018.

[3] Yinpeng Dong, Fangzhou Liao, Tianyu Pang, Hang Su, Xiaolin Hu, Jianguo Li , and Jun Zhu. Boosting adversarial attacks with momentum. In CVPR, 2018.

[4] Dongxian Wu, Yisen Wang, Shu-Tao Xia, James Bailey, and Xingjun Ma. Skip connections matter: On the transferability of adversarial examples generated with resnets. In International Conference on Learning Representations, 2020.

[5] Aleksander Madry, Aleksandar Makelov, Ludwig Schmidt, Dimitris Tsipras, and Adrian Vladu. Towards deep learning models resistant to adversarial attacks. In ICLR, 2018.

[6] Yinpeng Dong, Tianyu Pang, Hang Su, and Jun Zhu. Evading defenses to transferable adversarial examples by translation-invariant attacks. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp. 4312–4321, 2019.

[7] Xiang Li, Shuo Chen, Xiaolin Hu, and Jian Yang. Understanding the disharmony between dropout and batch normalization by variance shift. In CVPR, pp. 2682–2690, 2019.