文 | Sheryc_王苏

机器学习真是越来越火了,这从各大会议逐年增加的投稿量上就可见一斑:AAAI'21收到了9034篇投稿,NeurIPS'20收到了9467篇投稿,一篇投稿至少要经过3位审稿人同行评议,耗费的人力可想而知。那么问题来了:

上哪找这么多有经验的审稿人来写评审意见呢?

这时,机器学习投稿大头兼业界翘楚CMU的研究者发表了自己的看法:同行评议本质上不就是从输入一篇论文,输出评审意见的Seq2Seq吗?让N宝多看点论文,它还写不出个审稿人意见?我们自己动手写个自动的论文评审系统来审稿不就好了?

由三位来自CMU的研究者抱着这样的想法真的开发出了一个这样的论文自动评审系统ReviewAdvisor(以下我们简称为小R),甚至还用小R自动生成了小R论文本身的评审意见、小R论文的摘要和小R的arXiv页面笔记。这套让论文作者预知缺陷,让论文读者秒懂内涵,让论文评审者黯然失色的神奇系统,不想来试试看么?

论文题目:

Can We Automate Scientific Reviewing?

论文链接:

https://arxiv.org/pdf/2102.00176.pdf

Arxiv访问慢的小伙伴也可以在【夕小瑶的卖萌屋】订阅号后台回复关键词【0223】下载论文PDF~

什么是好的评审意见?

对一个系统的评价指标需要反应其任务的特点。对于论文评审系统,其评价指标自然要评估自动生成的评审意见有多“好”。

什么是一个好的评审意见呢?文章的作者在仔细分析阅读了ICML、NeurIPS、ICLR、ACL和EMNLP等机器学习或NLP顶级会议的审稿人指南后,总结出了一篇好的审稿人意见需具有的5大要素:

决定性(Decisiveness):对论文的接受与否有较为明确的立场。

综合性(Comprehensiveness):多维度地对文章进行评价。从行文而言,评审意见中需要包含论文概述、主要贡献和优缺点等多个组成部分;从对文章的评价而言,同样需要包含不同角度的考量。

公正性(Justification):为评审意见中所提出的批评提供理由和证据,便于作者有针对性地对文章质量进行提升。

准确性(Accuracy):保证评审意见的正确性,不能包含事实错误的信息。

友好性(Kindness):在语言使用上需要保持友善和礼貌。

下文中,对于系统评价指标的设计也是遵循这5大要素的。

它是怎么做到的?

训练小R的过程可以分为两个部分:数据集生成和模型训练。

对于数据来源选取,小R是专注于机器学习领域的论文评审机器人,选择的评审数据来源应该满足:1)论文质量高;2)评审意见公开。作者于是爬取了2017-2020年共5192篇ICLR论文和2016-2019年共3685篇NeurIPS论文,以及它们的所有评审意见作为评审数据集。这些论文平均每篇都附有3篇以上评审意见,每篇评审意见平均超过400词。需要注意的是,ICLR所依托的OpenReview同样公开了所有被拒论文和其评审意见,而NeurIPS在网站中只能爬取到接受的论文,所以数据集中的所有标记为Reject的论文全部来自ICLR。

对于模型选取,本文开篇提到“同行评议本质上就是从输入一篇论文,输出评审意见的Seq2Seq”,小R的模型结构确实也反应了这一特性。小R的基础模型是BART[1],一个性能较为领先的进行Seq2Seq任务的预训练模型。

诶,不会就是爬了个数据再用了个预训练模型这么简单吧(゚Д゚≡゚д゚)?当然不会啦!既然目前已经获得了评审数据集和基础模型,接下来的就是向模型和训练过程中加入额外的结构和归纳偏置,使模型的训练变得可行,使低效的训练变得高效。

现有模型不可训练的原因在于,BART的预训练文本长度为1024,而一篇论文平均有将近7000个词,经过Tokenizer变为BPE编码后更是远超这个数字,所以解决输入序列长度是需首先考虑的问题。

怎么才能更好地缩短论文长度,保留对撰写评审意见最有用的那些论文句段呢?作者提出了3种将论文进行有用句段提取的方法。括号中的部分表示该提取方法在论文主结果表格中的标记:

Section Based(INTRO):只保留论文的Introduction部分。

Cross Entropy Based(CE):首先根据设定的一系列关键词提取文中包含重要信息的句子集合,再根据unigram信息熵最大化的原则将提取出的句子集合压缩至长度阈值以内。

Hybrid(ABSCE):将论文的摘要部分与Cross Entropy Based方法提取的结果拼接。

解决了输入长度的问题,接下来该解决模型训练低效的问题了。在上一节中,我们提到了好的评审意见需要满足的五要素,但现有的模型和训练方式好像和这五个要素并不沾边。在数据有限的情况下,一个行之有效的方法就是向模型中加入归纳偏置。在小R的论文中,我们见到的是对于“综合性”这一要素的增强。

让我们再次回顾一下综合性这一指标的要求:行文五脏俱全,评价角度多样。当这两点合二为一后,我们可以发现,一个合适的归纳偏置是给模型生成的不同文本范围所代表的行文部分、评价角度和评价的正负倾向增加额外的正则项,使自动生成的评审意见在行文思路、选取的评价角度和正负倾向上更贴近真人。这里,所谓的行文部分和评价角度在文中统称为“Aspect”,这也正是文章中提到的“Aspect-Based”的来源。为此,需要对数据标注和模型设计进行一些修改。

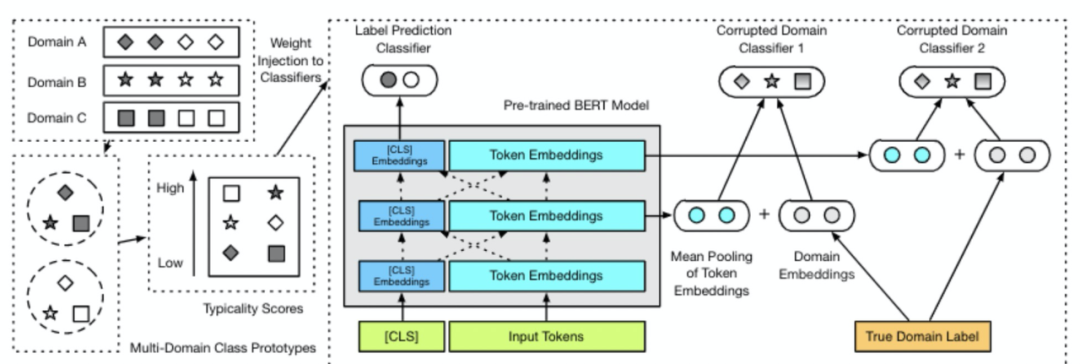

对于数据标注,需要标记出数据集里真人评审意见中不同文本范围代表的Aspect。作者借鉴了ACL对审稿人的指导,设计了8类14种区分正负倾向的Aspect标签对审稿意见的text span进行标注:概要(Summary),动机/影响(Motivation/Impact),原创性(POS/NEG Originality),可靠性/正确性(POS/NEG Soundness/Correctness),充实性(POS/NEG Substance),可复现性(POS/NEG Replicability),有意义的比较(POS/NEG Meaningful Comparison)和行文清晰性(POS/NEG Clarity)。这一标注过程首先进行人工标注1000条评审意见,利用其fine-tune一个BERT对其余数据进行标注,最终通过一些预定义的人工规则对BERT的标注结果进行修正,获得最终的标注数据。这一被标注了Aspect范围的数据集被称为“ASpect-enhAnced Peer Review Dataset(ASAP-Review)”。

对于模型设计,需要与数据集的标注进行对应。本文在BART的解码器输出部分平行地设置了两个MLP,其中一个进行BART原始的Token预测,另外一个同步地预测当前生成Token所属的Aspect标签。训练过程的损失函数即为Token预测与Aspect标签预测损失的加权求和,预测过程取Token预测结果序列作为输出。

它能完全代替人工吗?

先放结论:不能,但小R依然有可取之处。

我们首先来看看模型的性能。对于论文和对应的评审意见,设表示论文中稿与否的结果(中了=1,拒了=-1),表示评审意见的立场(推荐中=1,推荐拒=-1)。作者基于上述提出的好评审意见的5大要素提出了一系列评价指标:

决定性:推荐准确度(Recommendation Accuracy, RAcc)表示评审意见的立场与论文最终中稿结果是否一致:.

综合性:Aspect覆盖率(Aspect Coverage, ACov)表示中的Aspect标签数占总14种标签的比例;Aspect召回率(Aspect Recall, ARec)表示中的Aspect标签数与所对应的meta-review中的Aspect标签数的比例。

公正性:信息性(Informativeness, Info)表示在中负倾向标签对应文本范围中包含对应证据或理由的比例。

准确性:总结准确性(Summary Accuracy, SAcc)表示中的论文概括是否准确总结了论文;Aspect级建设性(Aspect-Level Constructiveness, ACon)表示中负倾向标签对应的包含证据的文本范围中证据是否真实准确。

友好性:作者未构建评价评审意见友好性的指标。这一部分在文中被作为Future Work。

其他:作者利用ROUGE和BERTScore两个衡量语义相似度的指标评价生成评审意见与真人评审意见的相似性。

以上评价指标除ACov、ARec、ROUGE和BERTScore外,均需要人工评价。对于一篇论文的多个真人评审意见,对各指标分别采用得分最高的一个。小R的性能如下:

相比于第一行真人评审意见的结果,小R的优势在于Aspect覆盖率(ACov)和信息性(INFO)两个指标,表示其能够生成比真人更加综合且公正的评审意见。与此同时,该系统在ABSCE组能够取得与人类接近的总结准确性(SAcc),表明其能够在评审意见中包含较为准确全面的论文总结。

不过,小R的缺点也十分明显。推荐准确度(RAcc)的集体负分表示小R无法对论文进行高层的整体性评价,而Aspect级建设性(ACon)的低下也说明文章对于负面倾向的细分评价给出的理由往往站不住脚。除此之外,小R还经常给出一些模仿性或重复性的评价,例如“The paper is well-written and easy to follow”这一句在多于90%的生成评审意见中都会出现,这是因为这一句竟原封不动的出现在了超过10%的训练数据中(Reviewer们夸文章写作好的时候真是敷衍呢)。最后,小R生成的评审意见很少对文章内容进行提问,尽管对文章内容的提问往往是评审意见中的关键部分。以上这些问题多多少少都可以在系统设计和数据集构建上看出潜在的原因。

小R还暴露出了对英语母语/非母语撰写者及匿名/非匿名投稿的偏向性。英语母语撰写者更容易在“原创性(Originality)”上获得更高评价,非英语母语撰写者更容易在“行文清晰性(Clarity)”上获得更高评价。对于匿名/非匿名投稿也存在一些评分上的不同,非匿名投稿倾向于得到更高的分数,这可能是数据集来源导致的结果,不过差距相比英语母语/非母语更小一些。先别急着批判小R,即使是真人评审也会对这两种情况产生或多或少的偏见,在下面对于真人/小R关于多个维度的评价分数的雷达图中,究竟哪一方才是更“Biased”的呢?(Reference reviews:真人评审;Generated reviews:小R评审)

对NLP的经典的论文评审意见如何?

NLP作为一个大研究领域,不同人必然有自己专精的小方向,所以“经典的NLP论文”实在是数不胜数。然而,大家心目中其实应该都有些能称之为“它改变了NLP”的超经典论文。可以预见,越多人知道小R,小R的服务器就越有压力。为了帮小R的作者分担些重复工作,我把自己很喜欢的一部分有足够影响力的论文选出来,看看小R能不能慧眼识珠。

近期,DeepMind提出了数据的“时间泛化”问题[2],指出训练和测试数据的时间来源不同可能导致预测性能下降。恰好,论文发表时间正是论文的一大重要特质,因此下面我们按照时间区间选取论文。由于篇幅有限,我们选取一篇早于训练数据年份的(Bahdanau et al.,注意力Seq2Seq),一篇理应包含在训练数据中的(Vaswani et al.,自注意力+Transformer),一篇在训练数据年份中但未包含在训练数据中的(Devlin et al.,BERT)和一篇领先于训练数据年份的(Radford et al.,CLIP)。

注意力机制Seq2Seq

出处:《Neural Machine Translation by Jointly Learning to Align and Translate》(ICLR '15)

前面标红色的文章总结应该是摘自摘要。后面的评价虽然列了很多点,不过很多都有些让人迷惑,这可能是因为文中的定量实验中表格的安排方式与一般文章不同。第3点中提到的Cho et al.和Sutskever et al.两篇提出的是基于RNN模型的Seq2Seq,Cho et al.这篇同时还提出了GRU结构,这样说的话这篇提出Attention的论文确实是在这两篇基础上的扩展工作。或许把表格的安排稍微改变一下,小R能为这篇论文生成一篇不错的评审意见出来。

自注意力机制+Transformer

出处:《Attention is All You Need》(NIPS '17)

这波是我比我自己,毕竟在训练过程中已经见过了Transformer,以为这篇文章是平行世界来的另一篇Transformer,说和Transformer像也无可厚非(和绕口令一样)。不过这个和CNN/RNN结合的点子倒是有点意思?

BERT

出处:《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》(NAACL '19)

虽然小R没见过BERT原文,但各种各样的BERT想来应该是见了不少。这篇评审意见说的也不能算错,BERT用的确实是来自Transformer的结构(虽然还是出现了自己比自己的问题),但这个说结果不够好的就有点过分了…刷GLUE这种综合性榜单和做单任务的完全不是一个量级的难度,或许小R并不能认识到任务和任务之间的横向比较吧。

CLIP

出处:《Learning Transferable Visual Models From Natural Language Supervision》(OpenAI,Jan 2021)

CLIP这篇文章是2021开年的重磅炸弹,直接引爆了图像-文本跨模态领域,甚至有成为下一个BERT级模型的潜力。小R对它的吐槽有些句子明显是从文中摘的(比如ImageNet Zero-shot那句),而且小R也认识不到zero-shot和传统方法横向相比较时所需要考虑的额外差距。不过和ConVIRT的比较或许算是合理,毕竟CLIP确实用的是简化版的ConVIRT,而且文中说到,CLIP的区别主要在于数据集大。

不感觉这和BERT/Transformer的对比很像么?或许看多了ICLR和NeurIPS之后就会对模型相近但从数据等其他方向进行探索的开创性论文有些买椟还珠吧。但这确实也意味着一篇文章对将来的影响力与其发表的会议影响因子并不一定成正比,真正闪光的论文即使挂在ArXiv上也可能成为一座里程碑。

我有个朋友最近要投稿,能不能让它审一审?

当然(=・ω・=)

立即进入 http://review.nlpedia.ai/ [3],点一下,玩一年,调戏小R不用一分钱(不)

首先浏览本地论文pdf文件,确认用户须知,点击Upload

等待上传完成后,点击Parse Paper

等待pdf解析完成后,点击Review Paper

需要注意的是,浏览器多开后多线程操作小R可能会有bug,还是给服务器减轻些负担比较好~

总结

对话系统一直以来都被认为是NLP领域皇冠上的明珠,因为一个理想的对话系统实际需要覆盖目前NLP领域各个细分任务的需求。但是,一个合格的论文评审系统同样也是如此:在阅读理解的基础上,还需要指正文中的内容错误,对值得批判的部分进行挑选,同时还需要与同时期、同领域的文章进行横向和纵向对比。由此所需要的不应该仅仅是单一文献的理解,而应该基于多篇文献对比得出论文贡献度和对比合理性,这需要对于文献实时维护一个类似知识图谱的结构;与此同时,对于除综合性以外的评审意见要素也同样应该在未来进行数据、模型和评价指标的革新。

虽然系统设计较为简单,但从小R生成的评审意见来看算是开了个好头,尽管包含错误,但我们能够从其详细分析中窥探到不足之处以便后续改进。此外,它提供的较为准确的论文总结和多维度的评价也能为真人评审提供重要参考。同行评议本身是需要相当智力水平才能完成的工作,但我们期待着能够真正可靠地发掘文章中闪光点和价值的NLP系统的出现,或许有一天,超级加强版小R的作者就会发出这样的感慨:“Reviewer 3给了我个超低分的评审意见,笑死,那评审意见还不如论文里提出的评审系统写得好”[4]。

萌屋作者:Sheryc_王苏

北航高等理工学院CS专业的市优秀毕业生,蒙特利尔大学/MILA博士生,资深ACG宅,目前作为实习生在腾讯天衍实验室进行NLP研究。虽主攻NLP,却对一切向更完善的智能迈进的系统和方向充满好奇。如果有一天N宝能真正理解我的文字,这个世界应该会被卖萌占领吧。(还没发过东西的)知乎ID:Sheryc

作品推荐:

NLP未来,路在何方?12位巨佬联名指路!

这几个模型不讲“模德”,我劝它们耗子尾汁

软硬兼施极限轻量BERT!能比ALBERT再轻13倍?!

后台回复关键词【入群】

加入卖萌屋NLP/IR/Rec与求职讨论群

后台回复关键词【顶会】

获取ACL、CIKM等各大顶会论文集!

[1]Lewis et al. BART: Denoising Sequence-to-Sequence Pre-training for Natural Language Generation, Translation, and Comprehension. In ACL'20. https://arxiv.org/pdf/1910.13461.pdf

[2]Lazaridou et al. Pitfalls of Static Language Modelling. In ArXiv. https://arxiv.org/pdf/2102.01951.pdf

[3]再放一下小R的链接:http://review.nlpedia.ai/

[4]如何写一篇好的评审意见:Resource about Writing a Good Review. http://review.nlpedia.ai/static/html/resource.html