代价函数

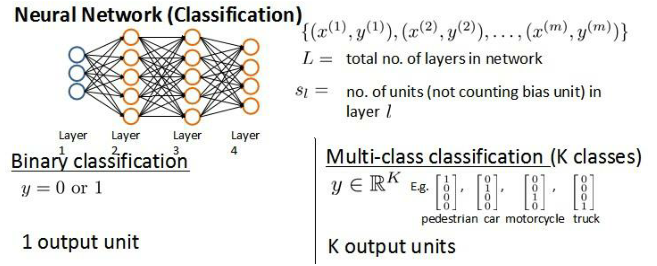

标记方法:

神经网络的训练样本有 m 个

每个包含一组输入 x 和一组输出信号 y

L 表示神经网络层数

Sl表示每层的 neuron 个数(SL 表示输出层神经元个数)

将神经网络的分类定义为两种情况:

二类分类:SL=1, y=0 or 1 表示哪一类;

K 类分类:SL=K, yi = 1 表示分到第 i 类;(K>2)

Cost Function:

归一化的那一项只是排除了每一层 θ0后,每一层的 θ 矩阵的和。

最里层的循环 j 循环所有的行(由 sl +1 层的激活单元数决定);

循环 i 则循环所有的列,由该层(sl 层)的激活单元数所决定。

—————————————————————————————————————————————————————————

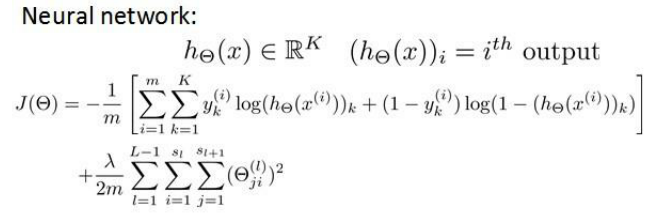

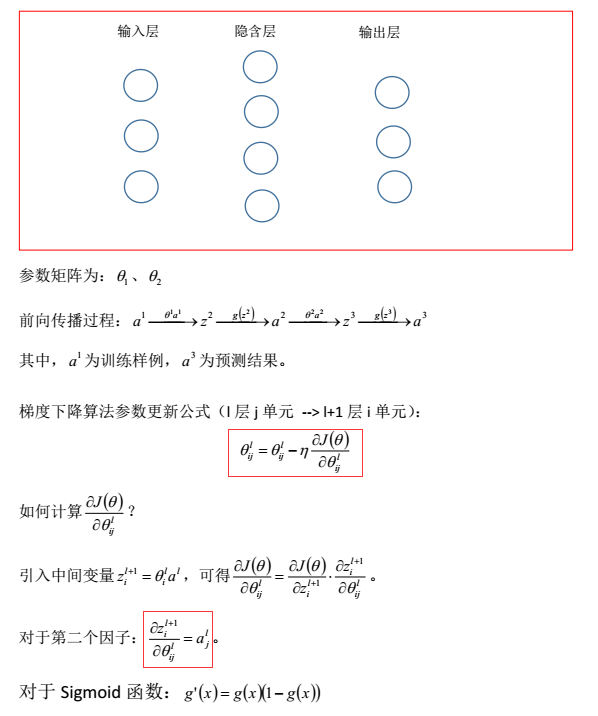

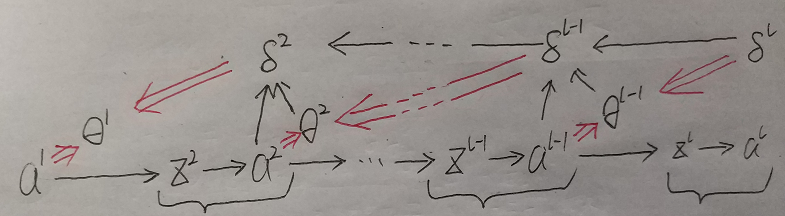

反向传播算法 (Backpropagation Algorithm)

为了计算代价函数的偏导数:

需要采用一种反向传播算法

也就是首先计算最后一层的误差, 然后再一层一层反向求出各层的误差, 直到倒数第二层。

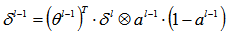

公式推导:

1、先计算输出层的误差:

2、再根据下述公式向前依次递推计算所有隐含层误差:(黑色单线箭头)

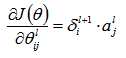

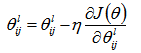

3、最后根据公式更新参数值:

总结:

首先用正向传播方法计算出每一层的激活单元, 利用训练集的结果与神经网络预测的结果求出最后一层的误差;

然后利用该误差运用反向传播法计算出直至第二层的所有误差;

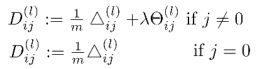

之后,我们便可以计算代价函数的偏导数了,计算方法如下:

——————————————————————————————————————————————————————————————————

随机初始化(Random Initialization)

任何优化算法都需要一些初始的参数。

通常初始参数为正负 ε 之间的随机值。

假设我们要随机初始一个尺寸为 10×11 的参数矩阵,代码如下:

Theta1 = rand(10, 11) * (2*eps) – eps

——————————————————————————————————————————————————————————————————

使用神经网络时的步骤:

网络结构: 首先要做的是选择网络结构, 即决定选择多少层以及每层分别有多少个单元。

第一层的单元数为训练集的特征数量。

最后一层的单元数是训练集结果的类标数量。

如果隐藏层数大于 1,确保每个隐藏层的单元个数相同,通常情况下隐藏层单元的个数越多越好。

我们真正要决定的是隐藏层的层数和每个中间层的单元数。

训练神经网络:

1. 参数的随机初始化

2. 利用正向传播方法计算所有的 hθ(x)

3. 计算输出层及隐含层的误差

4. 利用反向传播方法计算所有偏导数

5. 利用梯度数值检验方法检验这些偏导数

6. 使用优化算法来最小化代价函数

——————————————————————————————————————————————————————————————————

梯度检验(Gradient Checking)

当我们对一个较为复杂的模型(例如神经网络)使用梯度下降算法时,可能会存在一些不容易察觉的错误。

意味着, 虽然代价看上去在不断减小, 但最终的结果可能并不是最优解。

为了避免这样的问题, 我们采取梯度数值检验 (Numerical Gradient Checking) 方法。

这种方法的思想是通过估计梯度值来检验我们计算的导数值是否真的是我们要求的。

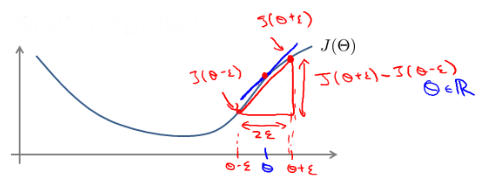

对梯度的估计采用的方法是在代价函数上沿着切线的方向选择离两个非常近的点,然后计算两个点的平均值用以估计梯度。

即对于某个特定的 θ,我们计算出在 θ-ε 处和 θ+ε 的代价值(ε 是一个非常小的值,通常选取 0.001),然后求两个代价的平均,用以估计在 θ 处

的代价值。

Octave 中代码如下: gradApprox = (J(theta + eps) – J(theta - eps)) / (2*eps)

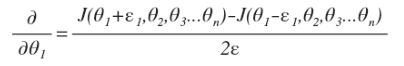

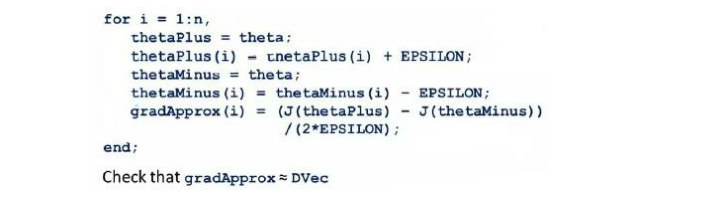

当 θ 是一个向量时, 我们则需要对偏导数进行检验。

因为代价函数的偏导数检验只针对一个参数的改变进行检验,下面是一个只针对 θ1进行检验的示例:

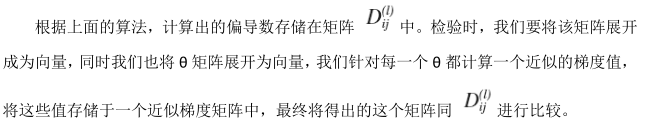

最后我们还需要对通过反向传播方法计算出的偏导数进行检验。

)

--接口测试工具介绍(详解))

)

)

用于数据可视化实验 -- Matlab版)

)

)