更多资料获取

📚 个人网站:ipengtao.com

在数据处理和分析领域,Python一直是一种强大的编程语言。然而,在处理大规模数据集和执行复杂操作时,有时候需要更高效的工具。在本文中,我们将深入探讨pydash库,这是一个专注于提高Python代码性能的工具。

什么是pydash库?

pydash是一个Python库,旨在提供高性能、函数式编程风格的工具集,以简化代码并提高执行效率。它提供了许多有用的函数,使得在数据处理、集合操作和函数式编程方面更加轻松。

安装pydash

在开始之前,首先需要安装pydash。可以使用以下命令来安装:

pip install pydash

pydash的核心功能

1. 函数式编程

pydash支持函数式编程风格,使得在处理数据时更加灵活。例如:

import pydash as _data = [1, 2, 3, 4, 5]# 使用pydash的map函数

squared_data = _.map(data, lambda x: x**2)print(squared_data)

2. 链式调用

pydash允许进行链式调用,使得代码更加简洁。例如:

import pydash as _data = [1, 2, 3, 4, 5]result = (_.chain(data).filter(lambda x: x % 2 == 0).map(lambda x: x**2).value()

)print(result)

3. 高性能集合操作

pydash提供了许多高性能的集合操作,例如uniq,intersection等。示例:

import pydash as _list1 = [1, 2, 3, 4, 5]

list2 = [3, 4, 5, 6, 7]common_elements = _.intersection(list1, list2)print(common_elements)

实际应用场景

在实际应用中,处理大型数据集是许多数据科学和分析任务的关键挑战之一。让我们看看pydash如何在这种场景中发挥作用,提高代码效率。

1. 数据预处理

假设您有一个包含大量数据的CSV文件,您需要对其进行预处理以进行后续的分析。使用pydash的函数式编程风格,您可以轻松地进行各种数据清洗和转换操作,使代码更加简洁易读。

import pydash as _# 读取大型CSV文件

data = read_large_csv("large_dataset.csv")# 数据清洗和转换

cleaned_data = (_.chain(data).filter(lambda row: row['age'] > 18).map(lambda row: {'name': row['name'], 'age': row['age']}).value()

)

2. 并行处理

处理大型数据集时,常常面临到需要并行处理以加速任务完成时间的情况。pydash提供了parallel函数,可以方便地在多个CPU核心上并行执行操作。

import pydash as _# 大型数据集

data = generate_large_dataset()# 并行处理数据

processed_data = _.parallel(_.map(data, expensive_operation))

3. 数据分组和聚合

当需要对大型数据集进行分组和聚合时,pydash的集合操作非常强大。考虑一个例子,需要按城市对用户进行分组,并计算每个城市的平均年龄。

import pydash as _# 大型用户数据集

user_data = get_large_user_dataset()# 按城市分组并计算平均年龄

average_age_by_city = (_.chain(user_data).group_by('city').map_values(lambda group: _.mean(_.pluck(group, 'age'))).value()

)

4. 多阶段数据流处理

在大数据处理中,常常需要构建多阶段的数据处理流程。pydash的链式调用使得构建这样的数据流程非常直观。

import pydash as _# 大型数据流处理

result = (_.chain(data).stage1_operation().stage2_operation().stage3_operation().value()

)

性能比较:pydash vs. 原生Python

为了评估pydash在性能上的优势,我们将对比一些常见操作的执行时间,与原生Python代码相比较。以下是一些基准测试的示例,旨在展示pydash在处理大型数据集时的潜在性能提升。

1. Map 操作

考虑一个简单的场景,对一个包含大量元素的列表进行平方运算。

原生Python代码:

import timedata = [i for i in range(1, 1000000)]start_time = time.time()squared_data = list(map(lambda x: x**2, data))end_time = time.time()

elapsed_time_native = end_time - start_time

print(f"原生Python代码执行时间: {elapsed_time_native} 秒")

pydash代码:

import time

import pydash as _data = [i for i in range(1, 1000000)]start_time = time.time()squared_data = _.map(data, lambda x: x**2)end_time = time.time()

elapsed_time_pydash = end_time - start_time

print(f"pydash代码执行时间: {elapsed_time_pydash} 秒")

2. Filter 操作

在这个示例中,将筛选出大于100的元素。

原生Python代码:

import timedata = [i for i in range(1, 1000000)]start_time = time.time()filtered_data = list(filter(lambda x: x > 100, data))end_time = time.time()

elapsed_time_native = end_time - start_time

print(f"原生Python代码执行时间: {elapsed_time_native} 秒")

pydash代码:

import time

import pydash as _data = [i for i in range(1, 1000000)]start_time = time.time()filtered_data = _.filter(data, lambda x: x > 100)end_time = time.time()

elapsed_time_pydash = end_time - start_time

print(f"pydash代码执行时间: {elapsed_time_pydash} 秒")

3. Reduce 操作

在这个示例中,将使用reduce计算一个大型列表的总和。

原生Python代码:

import timedata = [i for i in range(1, 1000000)]start_time = time.time()sum_native = sum(data)end_time = time.time()

elapsed_time_native = end_time - start_time

print(f"原生Python代码执行时间: {elapsed_time_native} 秒")

pydash代码:

import time

import pydash as _data = [i for i in range(1, 1000000)]start_time = time.time()sum_pydash = _.reduce(data, lambda acc, x: acc + x, 0)end_time = time.time()

elapsed_time_pydash = end_time - start_time

print(f"pydash代码执行时间: {elapsed_time_pydash} 秒")

通过这些性能比较示例,可以清晰地看到pydash在一些常见操作上的性能优势。在处理大规模数据时,pydash的高效实现使其能够在相同任务上显著缩短执行时间。然而,在实际应用中,具体的性能提升取决于任务的复杂性和数据的规模。读者可以根据实际需求选择是否使用pydash来提高代码的执行效率。

总结

在本文中,深入探讨了Python pydash库,并着重展示了其在实际应用场景和性能方面的优势。通过详细的示例代码,演示了pydash如何简化数据处理、提供函数式编程风格以及在大型数据集上显著提高代码效率。在实际应用场景中,pydash通过链式调用、并行处理、数据分组聚合等功能,为处理大规模数据提供了灵活而高效的解决方案。

进一步,进行了性能比较,对比了pydash与原生Python在常见操作上的执行时间。结果表明,在大数据处理任务中,pydash能够明显缩短代码执行时间,为开发者提供更高效的工具。然而,具体的性能提升仍取决于任务的特性和数据规模。

总体而言,pydash以其丰富的功能和高性能的特点,为Python开发者提供了一个强大的工具,特别适用于处理大规模数据和复杂操作的场景。通过优雅的函数式编程风格,链式调用和高性能的集合操作,pydash为数据科学家和分析师提供了一个有力的工具,能够在大数据背景下提高代码的可读性和执行效率。

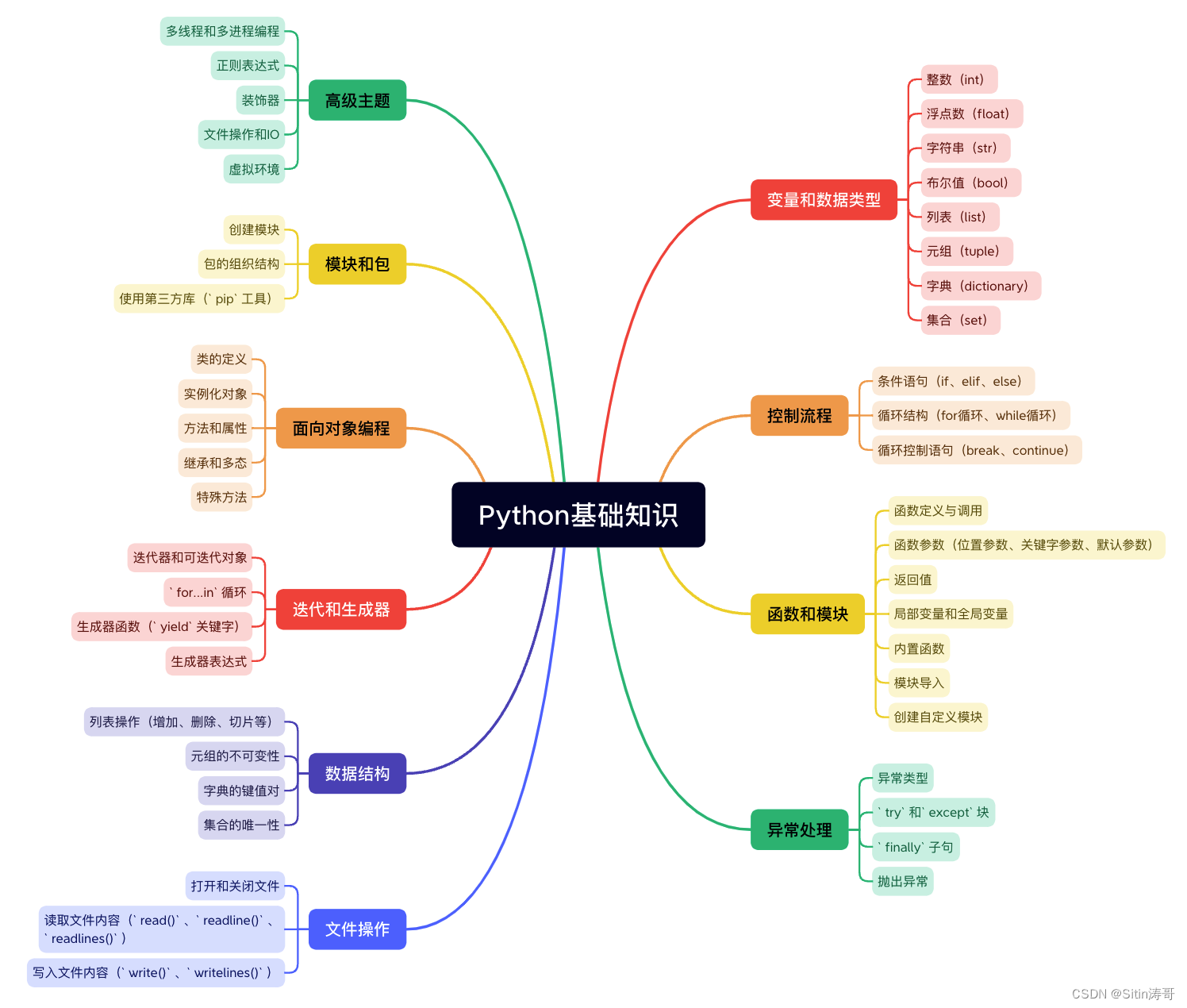

Python学习路线

更多资料获取

📚 个人网站:ipengtao.com

如果还想要领取更多更丰富的资料,可以点击文章下方名片,回复【优质资料】,即可获取 全方位学习资料包。

点击文章下方链接卡片,回复【优质资料】,可直接领取资料大礼包。

![[MySQL--进阶篇]存储引擎的体系结构、简介、特点、选择](http://pic.xiahunao.cn/[MySQL--进阶篇]存储引擎的体系结构、简介、特点、选择)

)

)