文章目录

- 一、下载安装包

- 二、上传压缩包

- 三、解压压缩包

- 四、配置环境变量

- 五、测试Hadoop

- 5.1 测试hadoop命令

- 5.2 测试wordcount案例

- 5.2.1 创建wordcount输入文本信息

- 5.2.2 执行程序

- 5.2.3 查看结果

- 六、分发压缩包到集群中其他机器

- 6.1 分发压缩包

- 6.2 解压压缩包

- 6.3 配置环境变量

- 七、配置集群

- 7.1 核心配置文件

- 7.2 HDFS配置文件

- 7.3 YARN配置文件

- 7.4 MapReduce配置文件

- 7.5 分发配置文件

- 八、启动集群

- 8.1 编辑workers文件确定数据节点

- 8.2 启动集群

- 步骤1: 格式化NameNode(首次启动集群时)

- 步骤2:启动HDFS

- 步骤3:启动YARN

- 步骤4:测试WEB访问

- (1)配置阿里云安全组

- (2)浏览器访问

- 九、测试集群

- 9.1 上传文件

- 9.2 查看文件

- 9.3 下载文件

- 9.4 执行程序

- 十、配置历史服务器

- 10.1 修改配置文件

- 10.2 分发配置文件

- 10.3 启动历史服务器

- 10.4 访问WEB

- 十一、配置日志的聚集

- 11.1 修改配置文件

- 11.2 分发配置文件

- 11.3 重启NM、RM、HistoryServer

- 11.4 测试

- (1)删除HDFS已经存在的输出文件

- (2)执行WordCount程序

- (3)查看日志

一、下载安装包

https://archive.apache.org/dist/hadoop/common/hadoop-3.1.3/

二、上传压缩包

使用普通账号,上传到/opt/software目录

三、解压压缩包

使用普通账号

[hadoop@hadoop102 software]$ tar -zxvf hadoop-3.1.3.tar.gz -C /opt/module/

四、配置环境变量

[hadoop@hadoop102 software]$ sudo vim /etc/profile.d/my_env.sh

新增内容:

#HADOOP_HOME

export HADOOP_HOME=/opt/module/hadoop-3.1.3

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

让新的环境变量PATH生效:

[hadoop@hadoop102 hadoop-3.1.3]$ source /etc/profile

五、测试Hadoop

5.1 测试hadoop命令

[hadoop@hadoop102 hadoop-3.1.3]$ hadoop version

5.2 测试wordcount案例

5.2.1 创建wordcount输入文本信息

[hadoop@hadoop102 hadoop-3.1.3]$ mkdir wcinput

[hadoop@hadoop102 hadoop-3.1.3]$ cd wcinput/

[hadoop@hadoop102 wcinput]$ vim word.txt

内容:

hadoop yarn

hadoop mapreduce

vimgo

jbl jbl jbl

5.2.2 执行程序

[hadoop@hadoop102 hadoop-3.1.3]$ cd /opt/module/hadoop-3.1.3

[hadoop@hadoop102 hadoop-3.1.3]$ hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar wordcount wcinput/ wcoutput/

5.2.3 查看结果

[hadoop@hadoop102 hadoop-3.1.3]$ cd wcoutput/

[hadoop@hadoop102 wcoutput]$ cat part-r-00000

hadoop 2

jbl 3

mapreduce 1

vimgo 1

yarn 1

六、分发压缩包到集群中其他机器

6.1 分发压缩包

[hadoop@hadoop102 module]$ cd /opt/software/

[hadoop@hadoop102 software]$ mytools_rsync hadoop-3.1.3.tar.gz

6.2 解压压缩包

同第三步骤

6.3 配置环境变量

同第四步骤

七、配置集群

有两种类型的配置文件:*-default.xml 和 *-site.xml。 *-site.xml 中的配置项覆盖 *-default.xml的相同配置项。

7.1 核心配置文件

core-default.xml:默认的核心Hadoop属性配置文件。该配置文件位于下面的JAR文件中:hadoop-common-x.x.x.jar

[hadoop@hadoop102 software]$ cd $HADOOP_HOME/etc/hadoop

[hadoop@hadoop102 hadoop]$ vim core-site.xml

新增内容:

<!-- 指定NameNode的地址 --><property><name>fs.defaultFS</name><value>hdfs://hadoop102:9820</value></property><!-- 指定hadoop数据的存储目录 --><property><name>hadoop.tmp.dir</name><value>/opt/module/hadoop-3.1.3/data</value></property><!-- 配置HDFS网页登录使用的静态用户为hadoop --><property><name>hadoop.http.staticuser.user</name><value>hadoop</value></property><!-- 配置该hadoop用户(superUser)允许通过代理访问的主机节点 --><property><name>hadoop.proxyuser.hadoop.hosts</name><value>*</value></property><!-- 配置该hadoop用户(superUser)允许通过代理用户所属组 --><property><name>hadoop.proxyuser.hadoop.groups</name><value>*</value></property><!-- 配置该hadoop用户(superUser)允许通过代理的用户--><property><name>hadoop.proxyuser.hadoop.users</name><value>*</value></property>

说明:

fs.defaultFS:文件系统地址。可以是HDFS,也可以是ViewFS等其他文件系统。

hadoop.tmp.dir:默认值为/tmp/hadoop-${user.name}。比如跑MR时生成的临时路径本质上其实就是生成在它的下面,当然如果你不想也可以去更改 mapred-site.xml 文件。再比如,如果你不配置namenode和datanode的数据存储路径,那么默认情况下,存储路径会放在hadoop.tmp.dir所指路径下的dfs路径中。

hadoop.http.staticuser.user:默认值是dr.who。需要调整为启动HDFS的用户(普通用户/root),才能访问(增删文件/文件夹)WEB HDFS。

代理配置:hadoop.proxyuser.hadoop.hosts必须配,hadoop.proxyuser.hadoop.groups和hadoop.proxyuser.hadoop.users至少配置一个。如果不配置代理会有什么问题?????

hadoop.proxyuser.hadoop.hosts和hadoop.proxyuser.hadoop.users:本案例配置表示允许用户hadoop,在任意主机节点,代理任意用户。

7.2 HDFS配置文件

hdfs-default.xml:默认的HDFS属性配置文件。该配置文件位于下面的JAR文件中:hadoop-hdfs-x.x.x.jar

[hadoop@hadoop102 hadoop]$ vim hdfs-site.xml

新增内容:

<!-- nn web端访问地址--><property><name>dfs.namenode.http-address</name><value>hadoop102:9870</value></property><!-- 2nn web端访问地址--><property><name>dfs.namenode.secondary.http-address</name><value>hadoop104:9868</value></property>

7.3 YARN配置文件

yarn-default.xml:默认的YARN属性配置文件。该配置文件位于下面的JAR文件中:hadoop-yarn-common-x.x.x.jar

[hadoop@hadoop102 hadoop]$ vim yarn-site.xml

新增内容:

<!-- 指定MR走shuffle --><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><!-- 指定ResourceManager的地址--><property><name>yarn.resourcemanager.hostname</name><value>hadoop103</value></property><!-- 环境变量的继承 --><property><name>yarn.nodemanager.env-whitelist</name><value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value></property><!-- yarn容器允许分配的最大最小内存 --><property><name>yarn.scheduler.minimum-allocation-mb</name><value>512</value></property><property><name>yarn.scheduler.maximum-allocation-mb</name><value>4096</value></property><!-- yarn容器允许管理的物理内存大小 --><property><name>yarn.nodemanager.resource.memory-mb</name><value>4096</value></property><!-- 关闭yarn对物理内存和虚拟内存的限制检查 --><property><name>yarn.nodemanager.pmem-check-enabled</name><value>false</value></property><property><name>yarn.nodemanager.vmem-check-enabled</name><value>false</value></property>

说明:

yarn.nodemanager.env-whitelist:默认JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_HOME,PATH,LANG,TZ

yarn.scheduler.minimum-allocation-mb:单位为MB

7.4 MapReduce配置文件

mapred-default.xml:默认的MapReduce属性配置文件。该配置文件位于下面的JAR文件中:hadoop-mapreduce-client-core-x.x.x.jar

[hadoop@hadoop102 hadoop]$ vim mapred-site.xml

新增内容:

<!-- 指定MapReduce程序运行在Yarn上 --><property><name>mapreduce.framework.name</name><value>yarn</value></property>

说明:

mapreduce.framework.name 默认值为 local,设置为 yarn,让 MapReduce 程序运行 在 YARN 框架上。

7.5 分发配置文件

[hadoop@hadoop102 hadoop]$ mytools_rsync /opt/module/hadoop-3.1.3/etc/hadoop/

八、启动集群

8.1 编辑workers文件确定数据节点

注意:该文件中添加的内容结尾不允许有空格,文件中不允许有空行。

[hadoop@hadoop102 hadoop]$ vim /opt/module/hadoop-3.1.3/etc/hadoop/workers

内容:

hadoop102

hadoop103

hadoop104

同步到所有节点:

[hadoop@hadoop102 hadoop]$ mytools_rsync /opt/module/hadoop-3.1.3/etc/

8.2 启动集群

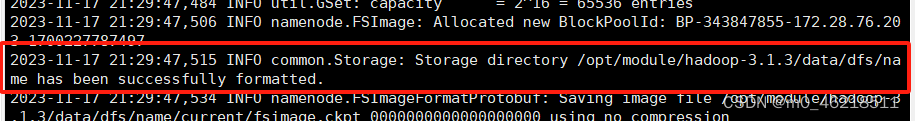

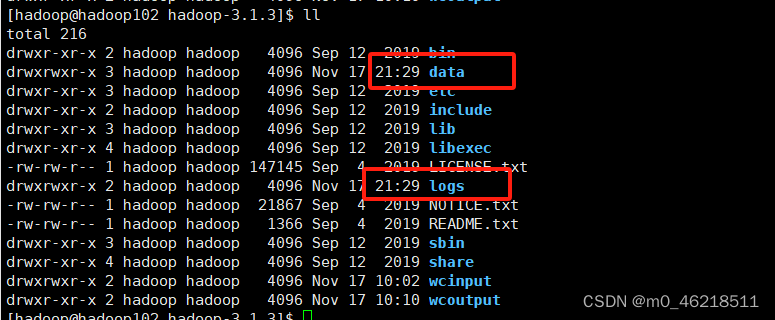

步骤1: 格式化NameNode(首次启动集群时)

注意:在NameNode所在节点(core-site.xml中配置的)执行命令

原因:先前在care_site.xml中配置了文件系统为HDFS,HDFS类似一块磁盘,初次使用硬盘需要格式化,让存储空间明白该按什么方式组织存储数据。

[hadoop@hadoop102 hadoop-3.1.3]$ hdfs namenode -format

看到下图样例代表格式化成功

步骤2:启动HDFS

注意:在NameNode所在节点执行命令

[hadoop@hadoop102 hadoop-3.1.3]$ sbin/start-dfs.sh

步骤3:启动YARN

注意:在ResourceManager所在节点(yarn-site.xml中配置的)执行命令

[hadoop@hadoop103 hadoop-3.1.3]$ sbin/start-yarn.sh

步骤4:测试WEB访问

(1)配置阿里云安全组

查看本机ip:百度搜索ip

配置阿里云安全组放开ip + 端口

配置本机hosts文件:用swichhosts配置

(2)浏览器访问

Web端查看HDFS的NameNode:http://hadoop102:9870

Web端查看YARN的ResourceManager:http://hadoop103:8088

九、测试集群

9.1 上传文件

上传小文件:

[hadoop@hadoop102 hadoop-3.1.3]$ hadoop fs -put /opt/module/hadoop-3.1.3/wcinput/word.txt /input

上传大文件:

[hadoop@hadoop102 hadoop-3.1.3]$ hadoop fs -put /opt/software/jdk-8u291-linux-x64.tar.gz /

9.2 查看文件

[hadoop@hadoop102 subdir0]$ cat /opt/module/hadoop-3.1.3/data/dfs/data/current/BP-343847855-172.28.76.203-1700227787497/current/finalized/subdir0/subdir0/blk_1073741825

9.3 下载文件

[hadoop@hadoop102 software]$ cd /opt/software/test_tmp

[hadoop@hadoop102 test_tmp]$ hadoop fs -get /input ./

9.4 执行程序

[hadoop@hadoop102 software]$ cd /opt/module/hadoop-3.1.3/

[hadoop@hadoop102 hadoop-3.1.3]$ hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar wordcount /input /output

查看执行结果(通过WEB页面下载执行结果文件):

配置安全组:放开9864端口

访问HDFS WEB下载文件

查看执行结果(在服务器上直接查看文件):

cat /opt/module/hadoop-3.1.3/data/xxx

十、配置历史服务器

10.1 修改配置文件

10.2 分发配置文件

10.3 启动历史服务器

10.4 访问WEB

十一、配置日志的聚集

注意:开启日志聚集功能,需要重新启动NodeManager 、ResourceManager和HistoryServer。

)

】稀疏 sparsearray 数组(1))

)