第二曲线由英国管理思想大师查尔斯·汉迪提出,讲的是在企业第一曲线达到巅峰的时候,找到驱动企业二次腾飞的第二曲线。而如果企业想实现基业长青,就需要通过主动式破局式创新,跨越到第二曲线中。对于当下的云智能产业以及基于云智能进行数字化转型的广大企业来说,LLM大模型和生成式AI就是开启第二曲线的机遇。

在AI加速计算领域,NVIDIA是市场领导者。早在2019年,NVIDIA就推出了Megatron-LM大语言模型加速软件框架以及一系列创新软件,与NVIDIA已有的人工智能软件一起,为破局第二曲线创新做好了准备。

在2023年11月初由阿里云举办的2023云栖大会上,面向LLM的NVIDIA AI软件“全家桶”吸引了大量开发者。PAI-Megatron-Patch、PAI-ChatLearn等NVIDIA与阿里云合作的大模型平台软件成果亮相,NVIDIA与蚂蚁集团、阿里云医疗与金融行业等合作的案例集中展示,充分显示了NVIDIA的软实力。

作为端到端的数据中心级全栈AI和加速计算解决方案创新者,NVIDIA与阿里云一起开创生成式AI新时代,为云智能产业和企业数字化转型全面打开第二曲线新机遇。

大模型PaaS平台的软底座

对于开发者和企业用户来说,如果想要尽快享受大模型的红利,第一选择就是由公有云服务商提供的自有大模型,以及托管了开源大模型的PaaS(又称为Model as a Service,MaaS)供开发者和企业选用。

例如阿里云既推出了自研通用大模型通义,也推出了MaaS平台灵积,托管了通义千问、Stable Diffusion、ChatGLM-v2、百川、姜子牙等开源大模型,而在阿里云大模型底层的是灵骏智算集群,可支持十万卡GPU规模、承载多个万亿参数大模型同时在线训练,此外阿里云人工智能平台PAI提供AI开发全流程的工程能力。

一方面,很多公有云的自有大模型和MaaS的底层,都采用了NVIDIA大模型软件技术;另一方面,除了公有云的自有大模型和MaaS外,还有一个通用大模型训练框架可选择,这就是由NVIDIA提供的Megatron-LM大模型分布式训练框架,该框架是由NVIDIA开发的一个开源的大模型加速训练框架,通过并行计算等优化方法可极大缩短大模型的训练时间。

2023年9月,阿里云人工智能平台PAI开源了业内较早投入业务应用的大模型训练一站式工具箱Pai-Megatron-Patch,该工具箱基于阿里云上的Megatron-LM最佳实践并补充了丰富的工具。2023云栖大会期间,阿里云和NVIDIA对Pai-Megatron-Patch进行了详细的技术介绍,该工具箱可快速帮助用户上手各种Megatron-LM大模型训练加速技术,以及基于Megatron-LM和阿里云灵骏集群,加速上手更多的HuggingFace开源大模型。

Pai-Megatron-Patch的设计理念是不对Megatron-LM源码进行侵入式修改,即不向Megatron-LM添加新的功能特性,而将需要扩充完善的部分以patch补丁的方式呈现,从而让Megatron-LM的升级不影响到用户LLM最佳实践体验。Pai-Megatron-Patch具有多种特色:支持Llama v1/v2、Code Llama、Baichuan v1/v2、通义千问、Falcon、GLM、StarCoder、BLOOM、ChatGLM等多款热门大模型;提供了HuggingFace模型权重和Megatron模型权重之间的双向转换;支持Flash Attention 2.0和Transformer Engine模式下的FP8训练加速且确保收敛;支持大模型预训练、微调、评估和推理,以及强化学习全流程最佳实践;提供了大模型汉化工具以及阿里云灵骏平台上的最佳实践等等。

PAI-ChatLearn是阿里云人工智能平台 PAI (Platform of AI) 团队自主研发,灵活易用、大规模模型 RLHF 高效训练框架。PAI-ChatLearn支持大模型进行 SFT(有监督指令微调)、RM(奖励模型)、RLHF(基于人类反馈的强化学习)完整训练流程。PAI-ChatLearn采用了多种并行计算技术,突破了已有框架只适用单模型训练/推理的局限,支持更大规模(例如175B + 175B)模型的RLHF训练,特别是支持混合框架训练/推理,例如训练采用Magnetron、推理采用vLLM等。

Pai-Megatron-Patch和PAI-ChatLearn的意义在于积累了阿里云大模型实践,基于NVIDIA Megatron-LM加速框架,能够最大化NVIDIA软件人才的复用率,同时还能减轻企业数字化转型的技术负担,只需要熟悉Megatron-LM框架即可在阿里云上进行大模型的选型、训练和部署应用及推理等全流程。

在Pai-Megatron-Patch和PAI-ChatLearn的示范下,相信将有更多的公有云将提供基于Megatron-LM的通用大模型PaaS,加速打开云智能第二曲线。

大模型平台软件“全家桶”

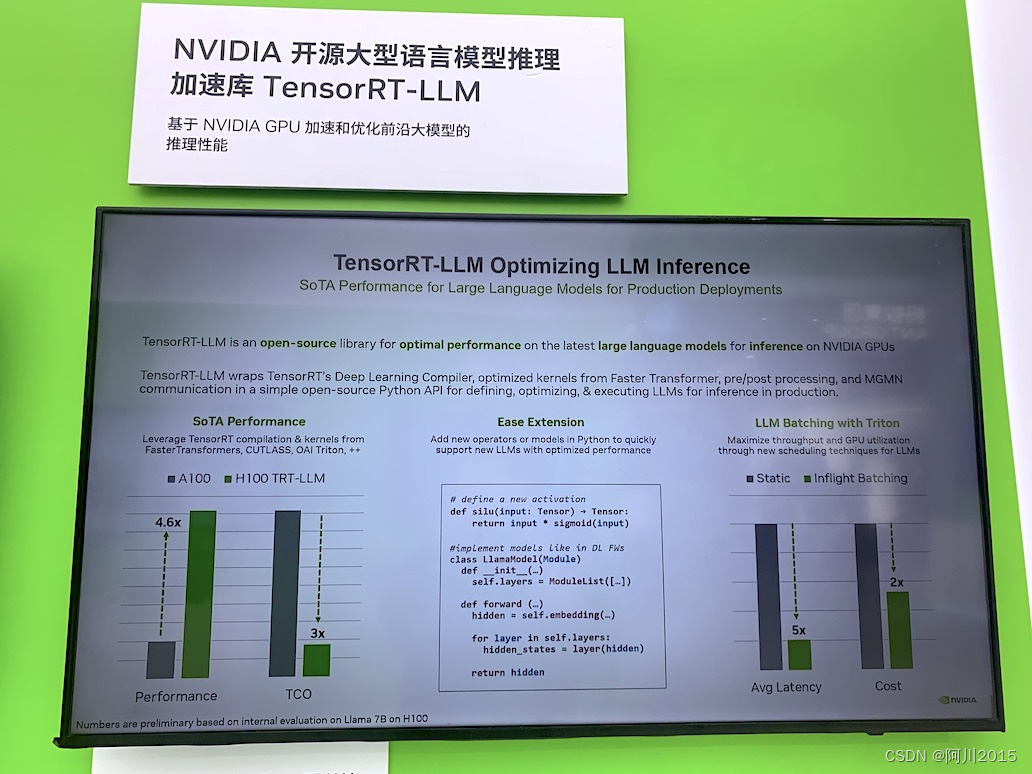

生成式AI应用的普及将带来大模型的多云与混合云部署,而这就需要跨多云与混合云的通用大模型平台软件。在2023云栖大会上,NVIDIA介绍了NeMo、TensorRT、TensorRT-LLM、Triton推理服务器、Megatron、Megatron Core等大模型平台软件和框架“全家桶”,能够极大加速大模型的训练、微调和推理部署等全链条,缩短大模型和生成式AI应用的研发周期、降低成本。

NVIDIA在几年前就推出了NVIDIA NGC (NVIDIA GPU Cloud),这是一款训练深度学习模型时需要的工具资源的集合,它提供了众多Docker容器允许用户在容器内直接使用GPU,无需安装GPU驱动和CUDA库,从而可以更好地利用GPU资源执行深度学习。NVIDIA在Docker容器的基础上,提供了PyTorch、TensorFlow等所有的主流深度学习框架。

NVIDIA NeMo是一个用于构建先进的对话式AI模型的框架,内置集成了自动语音识别(ASR)、自然语言处理(NLP)和语音合成(TTS)的模型及训练方案。作为一个端到端内置集成了自动语音识别的生产级别开源框架,用户可以基于NVIDIA NeMo直接开发对话式AI应用。NVIDIA NeMo既可以容器化部署,也可直接在裸金属服务器上使用,从而支持多云和混合云环境。

NVIDIA在NeMo的基础上推出了NeMo framework,这是一个端到端的容器化分布式框架,包含了数据处理、训练及优化部署,它允许开发人员高效地训练和部署具有数十亿和数万亿参数的大语言模型。采用NeMo framework,开发者可以进行大模型的训练,训练的模型可导出到TensorRT-LLM并在 NVIDIA Triton 推理服务器进行部署,从而在多个 GPU 和多个节点上运行大语言模型。

而Triton 推理服务器是NVIDIA发布的一款开源软件,可简化深度学习模型在生产环境中的部署。Triton支持所有 NVIDIA GPU、x86和ARM架构CPU以及AWS Inferentia,支持所有的主流云平台、本地AI平台以及MLOps平台。

TensorRT是NVIDIA提供的一款高性能深度学习推理SDK,该SDK包含深度学习推理优化器和运行环境,可为深度学习推理应用提供低延迟和高吞吐量,可用于超大规模数据中心、嵌入式平台或自动驾驶平台进行推理。

最新发布的 TensorRT-LLM,专门用于编译和优化大语言模型推理,可在NVIDIA GPU上加速和优化大语言模型的推理性能,该开源程序库现已作为 NVIDIA NeMo 框架的一部分,在GitHub资源库中免费提供。TensorRT-LLM包含了TensorRT,并采用了最新的优化内核,可在GPU上实现突破性的大语言模型推理性能。

而前面提到的Megatron-LM是一个开源的轻量级大模型训练加速框架,也是当前非常流行的大模型训练框架之一,特别是其中的4D并行计算技术已经成为大模型训练的标准范式之一,Megatron-DeepSpeed和Pai-Megatron-Patch等都是从Megatron-LM衍生出来的大模型训练方案。

如今,NVIDIA还将Megatron-LM的核心功能进一步抽取为Megatron Core。简单理解,如果将Megatron-LM、Megatron-DeepSpeed、Pai-Megatron-Patch、NeMo等视为各种“Linux发行版”的话,那么Megatron Core就相当于“Linux Kernel”内核。作为一个完整和独立的产品,NVIDIA为Megatron Core设计了独立的技术路线图、提供了完善的技术文档、定期发布更新版本以及通过完整的CICD测试确保版本的稳定性等。

随着Megatron Core的正式问世,NVIDIA对于大模型软件平台体系的愿景也浮出水面:要打造大模型平台软件的开源“内核”,成为所有大模型软件和生态式AI应用的“操作系统”。而这就是NVIDIA大模型“全家桶”的意义所在——打造大模型与生成式AI的“操作系统”,为云智能第二曲线提供产品化平台软件体系支撑。

推进大模型创新前沿

未来三年,我们将进入全民化生成式AI阶段。根据Gartner的预测,到 2026 年,超过80%的企业将使用生成式AI的API或模型,或在生产环境中部署支持生成式AI的应用,而在2023年初这一比例不到5%。毫无疑问,大模型和生成式AI将打开云智能与数字化转型的第二曲线,而NVIDIA还在不断推出大模型与生成式AI的创新前沿。

在2023云栖大会上,NVIDIA专家介绍了 NVIDIA Megatron Core 的技术路线图,特别提及当前版本的Megatron Core已经开始支持MoE预训练。MoE混合专家模型将多个模型(即“专家”)结合在一起,以获得更好的预测性能。MoE在文本、图像、搜索和多模态大模型等领域都取得了很多成果,可以说是下一代LLM大模型。

在Megatron Core的2023年11月版本中,已经包括了对于MoE的功能性支持、专家并行技术(Expert Parallelism,EP)、专家张量并行技术(Expert Tensor Parallelism,ETP)等,在2023年12月版本中还将提供MoE进一步的性能优化,以及在明年提供对于多模态的并行计算支持等。也就是说,NVIDIA将在Megatron Core中内置对下一代MoE大模型的全面支持。

在Megatron Core还集成了FP8计算。NVIDIA Hopper是最新的NVIDIA GPU架构,基于Hopper架构的GPU充分利用了最新的FP8张量核心(Tensor Core)技术,实现了速度更快的低精度AI训练方法。因为机器学习的研究人员发现,在很多神经网络计算中,不需要使用高精度的数据类型,神经网络依然能得出同样准确的答案,因此更低精度的FP8计算能够用更低成本与能耗实现更快的推理计算。Megatron Core将通过集成Transformer Engine API的方式,直接“开箱即用”式使用FP8计算。Transformer Engine是针对Transformer模型结构推出的加速库,包括在Hopper GPU上支持FP8精度计算。

大模型与生成式AI的另一个创新前沿是数据中心网络,面向AI的网络是数据中心的下一步优化方向。无论是新建或升级数据中心,大模型与生成式AI应用都对数据中心的网络提出了全新的要求,也就是比传统数据中心激增了数据中心内部的网络通信,NVIDIA为此推出下一代AI网络方案,包括NVIDIA BlueField-3 DPU、NVIDIA Quantum-2 InfiniBand 交换机、NVIDIA SHARP、NVIDIA Spectrum-4 交换机及NVIDIA DOCA等端到端网络解决方案核心产品及技术,这些都在2023云栖大会上集中亮相。

与领先大模型团队在一起

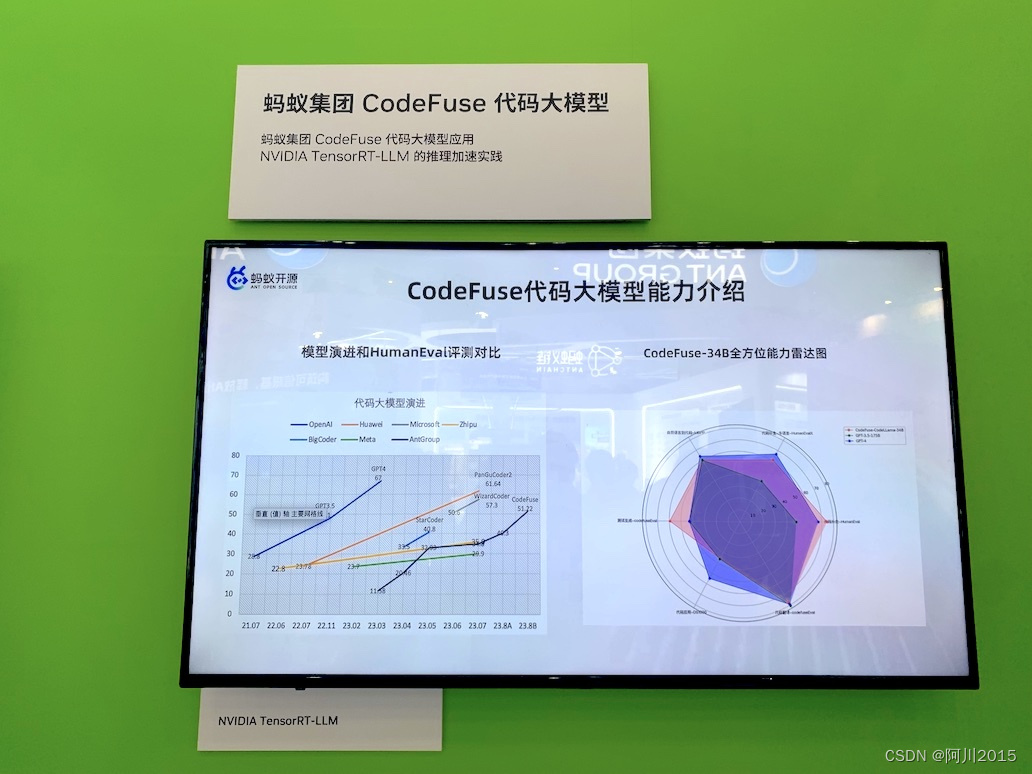

过去两年,NVIDIA一直与领先的大语言模型企业与团队开展密切合作,帮助云智能产业和企业数字化转型加速开启第二曲线。在2023云栖大会上,展示了NVIDIA与蚂蚁集团、阿里云行业团队等大模型深度优化加速最佳实践。

蚂蚁集团大模型团队开源的CodeFuse大模型是蚂蚁自研的代码生成专属大模型,是蚂蚁百灵大模型家族的一员。CodeFuse根据开发者的输入提供智能建议和实时支持,帮助开发者自动补全/生成代码、自动增加注释、自动生成测试用例、修复和优化代码等,以提升研发效率。CodeFuse采用了NVIDIA TensorRT-LLM,实现了对大模型推理的优化加速,甚至在推理端实现了FP4/INT4更低精度推理,极大降低了成本、提高了推理速度。

NVIDIA Clara Parabricks是由NVIDIA开发、基于GPU的基因测序分析加速软件,提供多种生物信息学工具和功能。阿里云基因分析平台是国内首个公有云的行业PaaS平台,以容器化的方式大规模处理基因组学分析数据,集成NVIDIA Clara Parabricks等行业软件和开源工具,形成完整的端到端解决方案。

在2023云栖大会前夕,淘天集团联合爱橙科技正式对外开源大模型训练框架——Megatron-LLaMA,旨在让技术开发者们能够更方便地提升大语言模型训练性能,降低训练成本,并保持和LLaMA社区的兼容性。测试显示,在32卡训练上,相比HuggingFace上直接获得的代码版本,Megatron-LLaMA能够取得176%的加速;在大规模的训练上,Megatron-LLaMA相比较32卡拥有几乎线性的扩展性,且对网络不稳定表现出高容忍度。

此外,NVIDIA还为开箱即用的魔搭开源模型和灵积模型服务高效 GPU 优化、Megatron 加速通义大模型训练等。

在2023云栖大会上,NVIDIA还展示了在持续推进大模型与AI技术生态、为业界广大开发者、初创企业、女性科技从业者提供丰富的学习资源和生态支持。只有构建更加丰富和开放的生态,才能真正推动生成式AI应用的繁荣,从长期拉升云智能第二曲线。

【全文总结】在2023云栖大会上,NVIDIA从多个维度展示其大模型平台软件的技术领先性。在大模型时代,NVIDIA的AI与大模型平台软件资产正在快速汇聚起来,形成 AI 操作系统和中间件等的一站式通用开发平台,从而成为云智能第二曲线的内核引擎。(文/宁川)

- 分布式测试插件之pytest-xdist的详细使用)