简介

机器学习通过使计算机能够从数据学习和做出预测来彻底改变了人工智能领域。机器学习的一个关键方面是数据的表示,因为表示形式的选择极大地影响了算法的性能和有效性。嵌入已成为机器学习中的一种强大技术,提供了一种捕获和编码数据点之间复杂关系的方法。本文[1]探讨了嵌入的概念,其意义及其在各个领域的应用。

了解嵌入

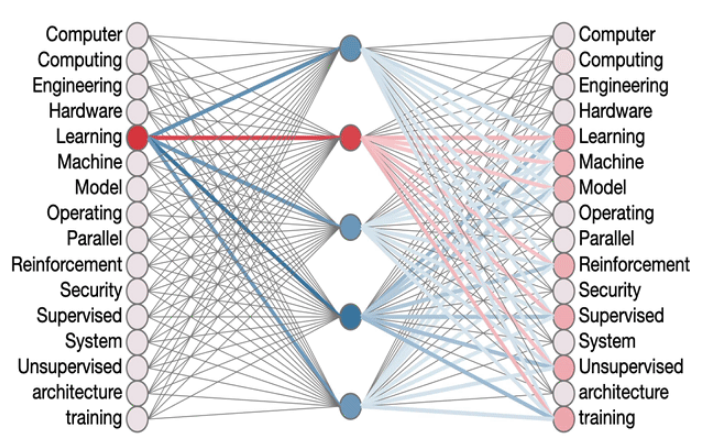

在机器学习中,嵌入是指高维物体的低维,密集的矢量表示。这些对象可以是从自然语言处理中的单词到计算机视觉中的图像。嵌入的目的是以更紧凑和有意义的形式捕获对象的固有属性和关系。

通过表示学习的过程来学习嵌入,其中训练模型以将高维数据映射到较低维的矢量空间。嵌入空间的设计方式使语义上相似的物体更靠近,而不同的对象则距离较远。这种基于接近度的安排使算法能够利用嵌入式中编码的关系来进行准确的预测并执行各种任务。

嵌入的应用

-

自然语言处理(NLP):在NLP中,嵌入引起了极大的关注。单词嵌入(例如Word2Vec和Glove)将单词表示为连续空间中的密集向量。通过捕获单词之间的语义和句法关系,这些嵌入使模型能够理解语言结构,执行情感分析,甚至可以生成连贯的文本。此外,上下文嵌入(例如Bert和GPT)在句子的上下文中捕获单词的含义,从而使高级语言理解任务。 -

计算机视觉:嵌入也已被广泛用于计算机视觉任务。图像嵌入,例如从卷积神经网络(CNN)获得的图像嵌入,在紧凑的表示中捕获图像的视觉特征。这些嵌入可以用于图像分类,对象检测和图像相似性搜索等任务。通过将图像映射到特征空间,模型可以根据其视觉内容比较和匹配图像。 -

推荐系统:嵌入在构建推荐系统中起着至关重要的作用。协作过滤技术利用嵌入来表示用户和项目。通过从历史用户项目交互中学习嵌入,推荐系统可以识别相似的用户或项目并提出个性化建议。嵌入捕获潜在的因素,这些因素可以推动用户偏好,从而推荐与单个口味相符的项目。 -

网络分析:嵌入在网络分析和基于图的机器学习中已证明有价值。图形嵌入表示图中的节点为低维向量,从而捕获结构信息和节点之间的关系。这些嵌入可以实现诸如链接预测,社区检测和节点分类之类的任务。通过将节点映射到嵌入空间,基于图的算法可以有效地分析大规模网络。

优点和挑战

使用嵌入为机器学习应用带来了一些好处。首先,嵌入提供紧凑而有益的表示形式,从而降低了数据的维度并提高了计算效率。其次,嵌入有助于探索语义关系,并使算法能够很好地概括到看不见的数据。此外,嵌入可以优雅地处理缺失的值和噪音,从而增强鲁棒性。

但是,嵌入学习中存在挑战。确定最佳的嵌入维度,处理稀有或不播放的术语以及解决嵌入中的偏见的最佳嵌入性。平衡表现力和嵌入性解释性之间的权衡也带来了挑战。

Code Example

在Python中,有几个库和框架可用于机器学习中的嵌入。让我们探索一些流行的选择:

-

Gensim:Gensim是专为主题建模和文档相似性分析而设计的Python库。它包括有效实现流行的嵌入算法,例如Word2Vec和doc2vec。 Gensim提供了易于使用的API,用于训练和使用嵌入。这是使用Gensim训练Word2Vec模型的示例:

from gensim.models import Word2Vec

# Prepare training data (a list of sentences)

sentences = [["I", "love", "machine", "learning"], ["Embeddings", "are", "powerful"]]

# Train Word2Vec model

model = Word2Vec(sentences, min_count=1)

# Get the embedding vector for a word

word_vector = model['machine']

-

TensorFlow:TensorFlow是一个受欢迎的深度学习库,为使用嵌入的工作提供了广泛的支持。它提供了诸如Word2Vec和Glove之类的预训练模型,以及使用神经网络训练自定义嵌入的灵活性。这是在TensorFlow中使用预训练的手套嵌入的示例:

import tensorflow as tf

from tensorflow.keras.preprocessing.text import Tokenizer

from tensorflow.keras.preprocessing.sequence import pad_sequences

# Create a Tokenizer

tokenizer = Tokenizer()

tokenizer.fit_on_texts(["I love machine learning", "Embeddings are powerful"])

# Convert text to sequences

sequences = tokenizer.texts_to_sequences(["I love embeddings"])

# Pad sequences to a fixed length

padded_sequences = pad_sequences(sequences, maxlen=10)

# Load pre-trained GloVe embeddings

embedding_matrix = tf.keras.preprocessing.text.embedding_matrix.load_glove("glove.6B.100d.txt")

# Define an embedding layer

embedding_layer = tf.keras.layers.Embedding(

input_dim=len(tokenizer.word_index) + 1,

output_dim=100,

weights=[embedding_matrix],

trainable=False

)

# Embed the padded sequences

embedded_sequences = embedding_layer(padded_sequences)

-

Pytorch:Pytorch是另一个流行的深度学习库,可提供用于嵌入的工具。它提供了Torch.nn.embedding模块,以在神经网络中创建和使用嵌入。这是使用Torch.nn.embedding模块的一个示例:

import torch

import torch.nn as nn

# Define an embedding layer

embedding_layer = nn.Embedding(10000, 300) # Vocabulary size: 10,000, Embedding dimension: 300

# Create input data

input_data = torch.LongTensor([[1, 2, 3], [4, 5, 6]]) # Shape: (2, 3)

# Embed the input data

embedded_data = embedding_layer(input_data)

# Access the embedding vectors

embedding_vectors = embedded_data[0] # Shape: (3, 300)

要在不使用库的情况下实现Python中的嵌入,您可以从头开始创建一个基本的嵌入框架。这是一个简化的例子:

import numpy as np

# Define a vocabulary

vocabulary = ["apple", "banana", "orange", "grape"]

# Initialize an empty embedding matrix

embedding_matrix = np.zeros((len(vocabulary), 100)) # Embedding dimension: 100

# Assign random vectors to each word in the vocabulary

for i, word in enumerate(vocabulary):

embedding_vector = np.random.uniform(-1, 1, (100,))

embedding_matrix[i] = embedding_vector

# Function to retrieve the embedding vector for a given word

def get_embedding(word):

if word in vocabulary:

index = vocabulary.index(word)

return embedding_matrix[index]

else:

return None

# Example usage

word_embedding = get_embedding("banana")

print(word_embedding)

在此示例中,我们使用numpy手动创建一个嵌入矩阵,其中每一行都对应于词汇中的一个单词,每个列代表特征维度。我们用随机向量初始化嵌入矩阵,但是您可以使用任何所需的初始化方法。

get_embedding()函数检索给定单词的嵌入向量。它检查该单词是否存在于词汇中,并从嵌入矩阵中返回相应的嵌入向量。

请注意,这是一个简单的演示,可以说明嵌入的概念而不依赖外部库。实际上,建议使用诸如Gensim,Tensorflow或Pytorch之类的库库,以更有效,更优化的嵌入在现实世界机器学习项目中。

总结

嵌入已成为现代机器学习的基本组成部分,提供了一种捕获和代表数据中复杂关系的方法。从NLP到计算机视觉和网络分析,它们的多功能性在各个领域都显而易见。通过利用嵌入,模型可以有效地推理,概括并做出准确的预测

Reference

Source: https://medium.com/@evertongomede/embeddings-in-machine-learning-unleashing-the-power-of-representation-2402bab526fe

本文由 mdnice 多平台发布

)

)

![[算法日志]图论: 广度优先搜索(BFS)](http://pic.xiahunao.cn/[算法日志]图论: 广度优先搜索(BFS))