注:该文章为视频课的笔记补充

视频课:转置卷积(transposed convolution)_哔哩哔哩_bilibili

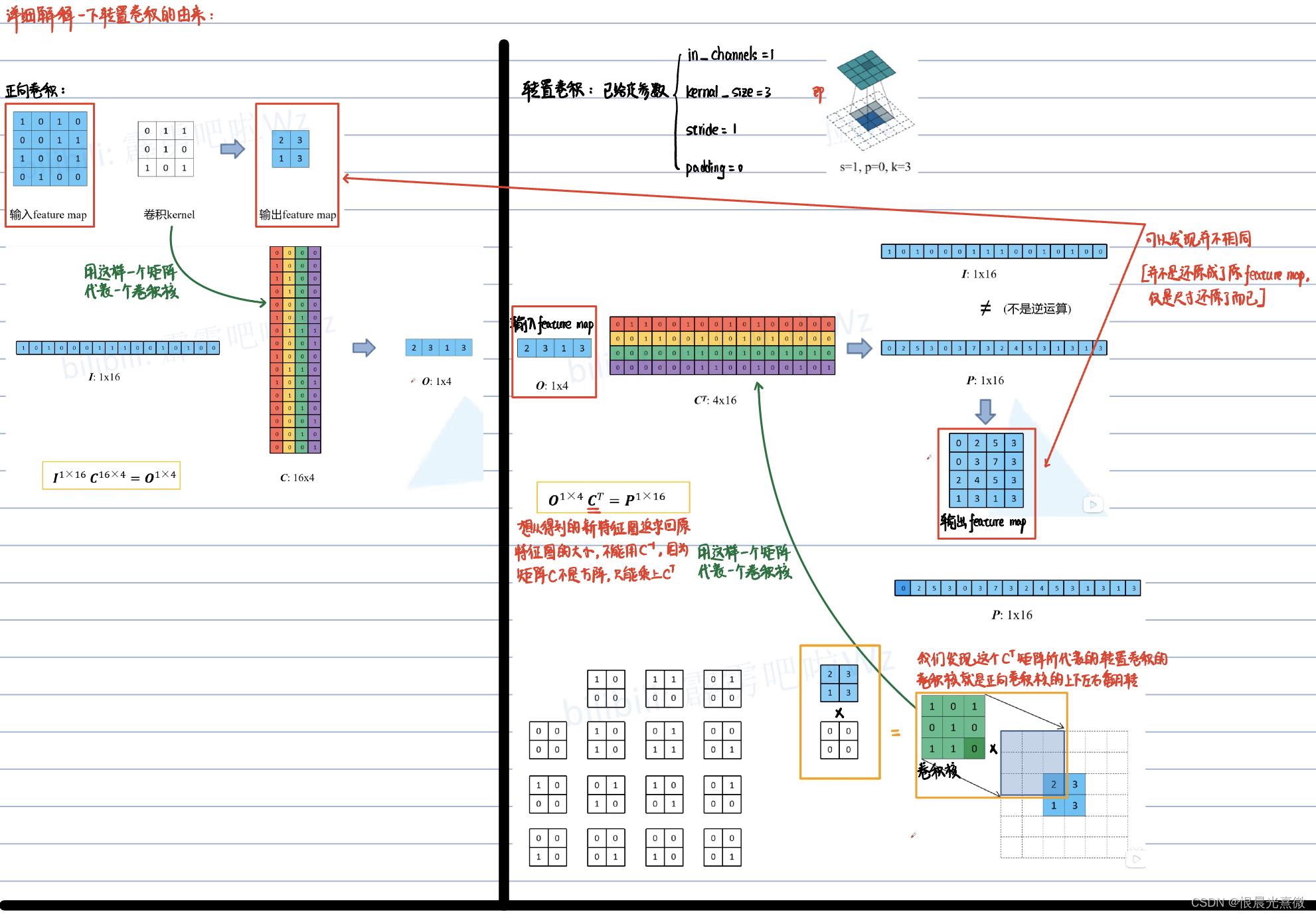

更详细的推导在:抽丝剥茧,带你理解转置卷积(反卷积)_逆卷积-CSDN博客

a

a

a

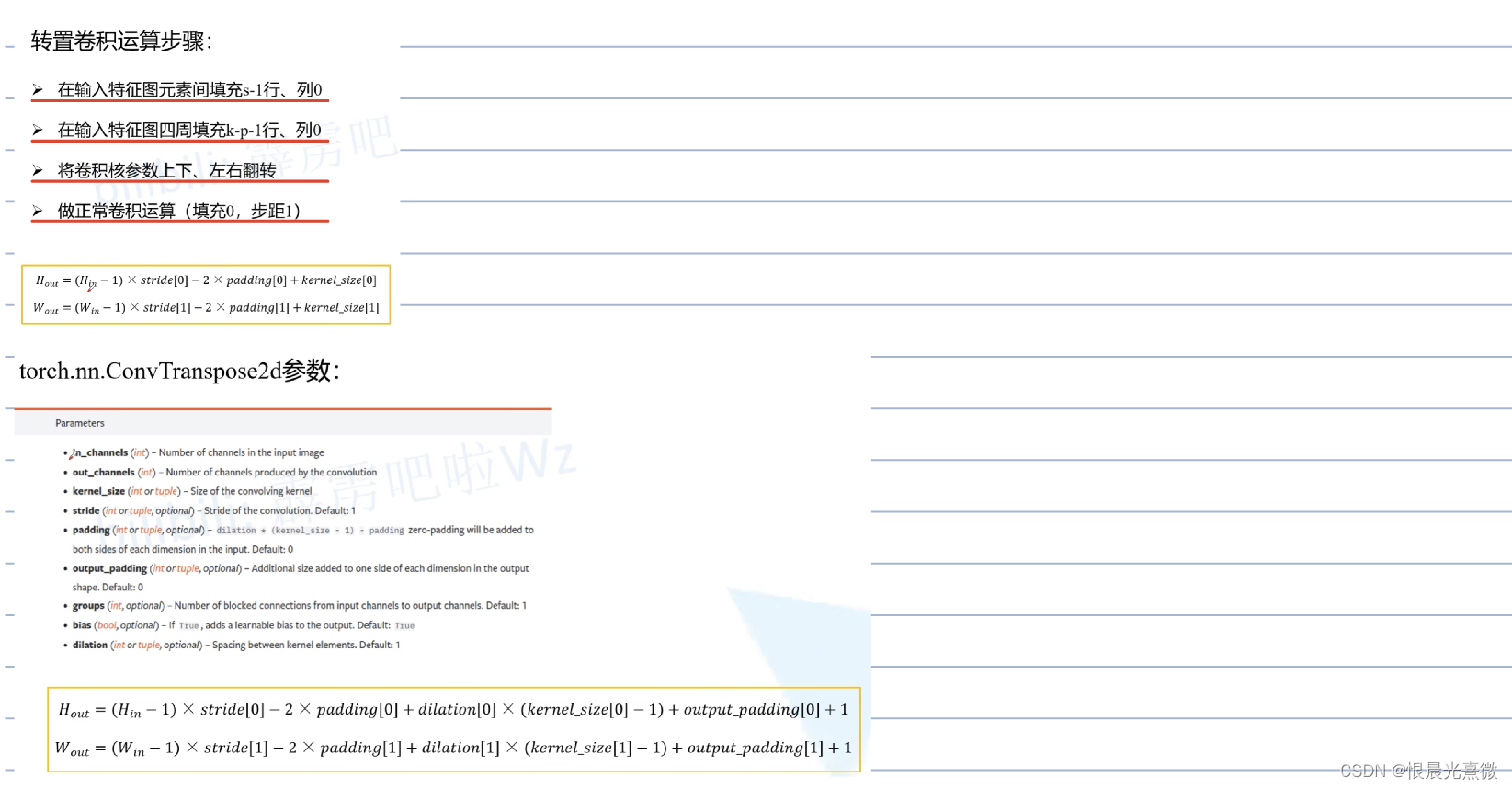

补充1:对 Pytorch 中的函数 ConvTranspose2d() 中参数 padding 和 out_padding 的理解

参数padding:是进行转置卷积之前对原始 feature_map 的填充(是在转置卷积进行之前起作用的,作用在输入端)

参数out_padding:是在转置卷积进行完成后,对新得到的 feature_map 进行的扩容(是在转置卷积完成之后才进行的,作用在输出端)

是文章的延伸:转置卷积(Transposed Convolution)_太阳花的小绿豆的博客-CSDN博客

a

a

a

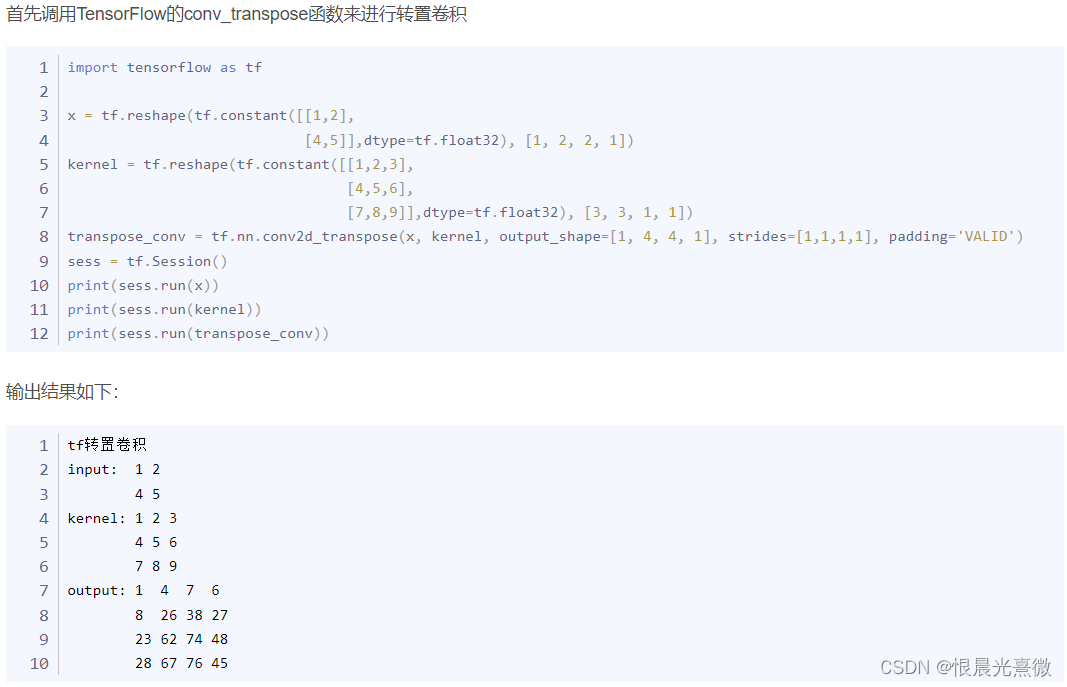

补充2:TensorFlow 中输入转置卷积层的卷积核应该是什么样的

这里使用的深度学习框架是TensorFlow,一定要注意他的转置卷积层的输入卷积核是什么,输入这个转置卷积层对应的转置卷积函数 tf.nn.conv2d_transpose() 的卷积核为:这个转置卷积对应的正向卷积过程所使用的卷积核!!!

这个转置卷积函数会在计算过程中自动将这个输入的卷积核反转,然后再进行正常的卷积操作!!!

是文章的延伸:抽丝剥茧,带你理解转置卷积(反卷积)_逆卷积-CSDN博客

a

a

a

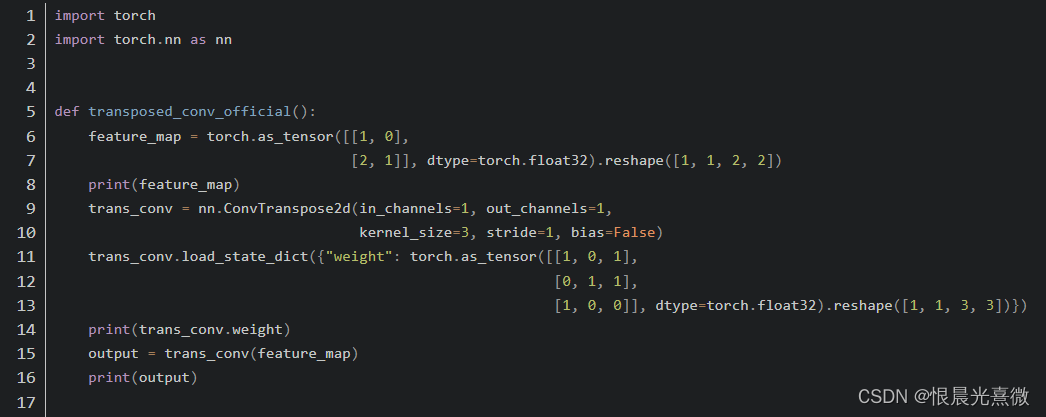

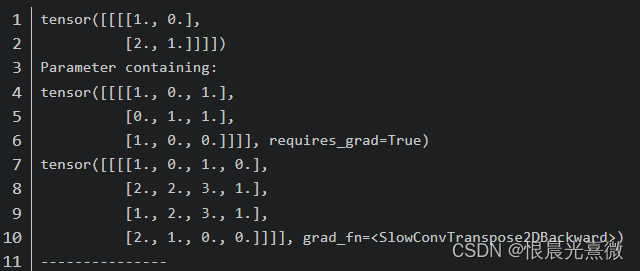

补充3:Pytorch 中输入转置卷积层的卷积核应该是什么样的

注:和框架TensorFlow一样,输入的都是转置卷积对应的正向卷积的卷积核(即并没有进行反转的卷积核)

是文章的延伸:转置卷积(Transposed Convolution)_太阳花的小绿豆的博客-CSDN博客

)

引用的用法总结)