引言

在分布式系统中,数据存储和访问的均匀性、高可用性及可扩展性至关重要。一致性哈希算法(Consistent Hashing)以其优秀的数据分布特性,广泛应用于缓存、负载均衡和数据库分片等领域,有效提升了系统的稳定性和灵活性。

一、一致性哈希是什么

一致性哈希(Consistent Hashing)是一种特殊的哈希算法,它主要用于解决分布式系统中数据的分布和负载均衡问题。一致性哈希的设计目标是在节点(如服务器或缓存设备)增加或移除时,能够最小化数据重新分布的次数,从而提高系统的稳定性和扩展性。

二、为什么提出一致性哈希

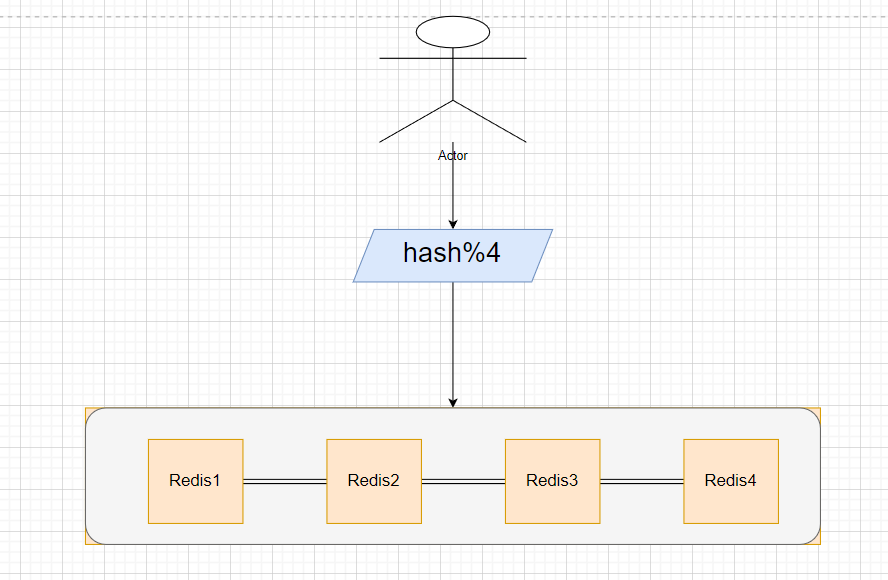

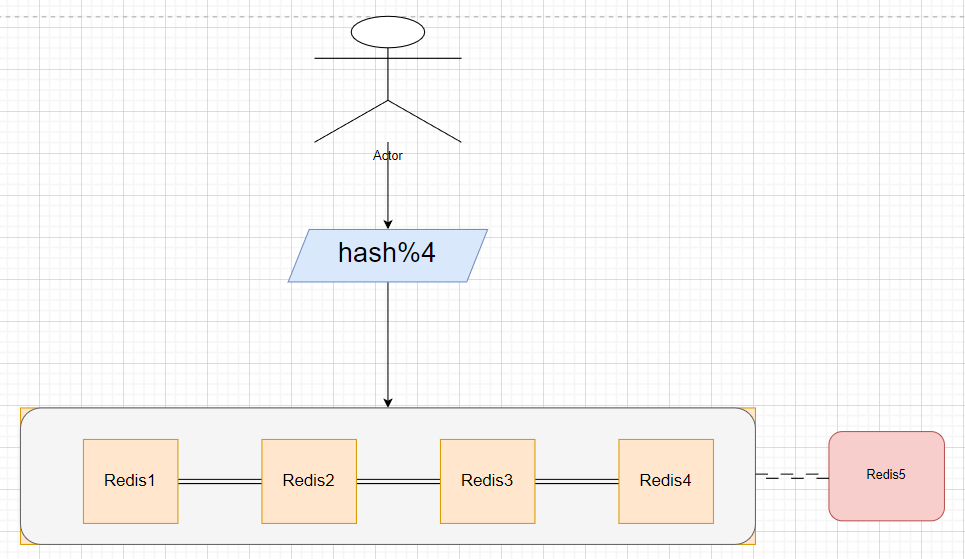

在讲解为什么提出一致性哈希算法之前,我们先来看看普通的哈希取模算法。以Redis分片集群为例,当用户需要查询某个数据时,首先会对查询的key进行哈希运算,然后通过对其总节点数量进行取模运算来确定访问哪一个Redis节点。例如:

在这种情况下,可能会出现所有访问和存储操作恰好都映射到同一个Redis节点上的情况,从而对该节点造成巨大的压力。此外,不仅是数据存储分布不均的问题,如果需要新增一个Redis节点,现有的所有数据都需要重新进行哈希运算(rehash),以确定新的映射关系,这会导致扩展性非常差。

因此,在面对上述问题的基础上,提出了一致性哈希算法来解决数据分布不均和扩展性差的问题

三、一致性哈希算法原理

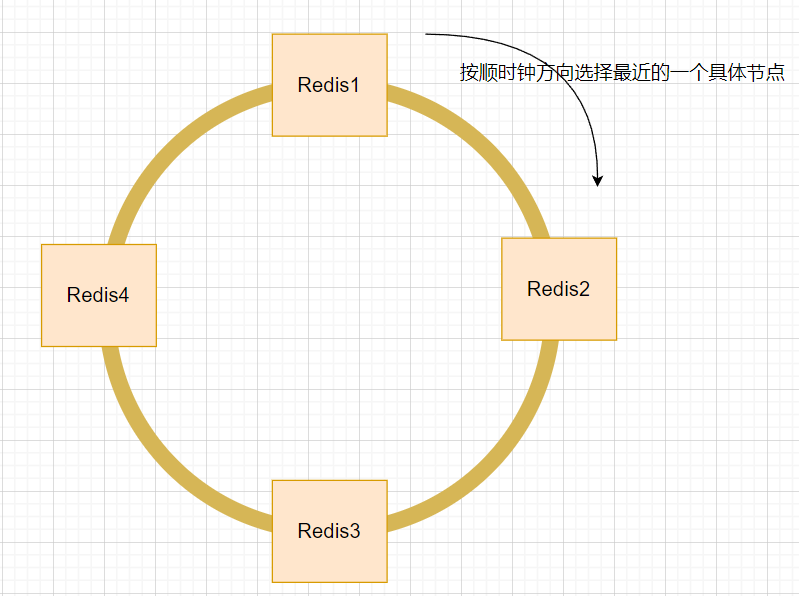

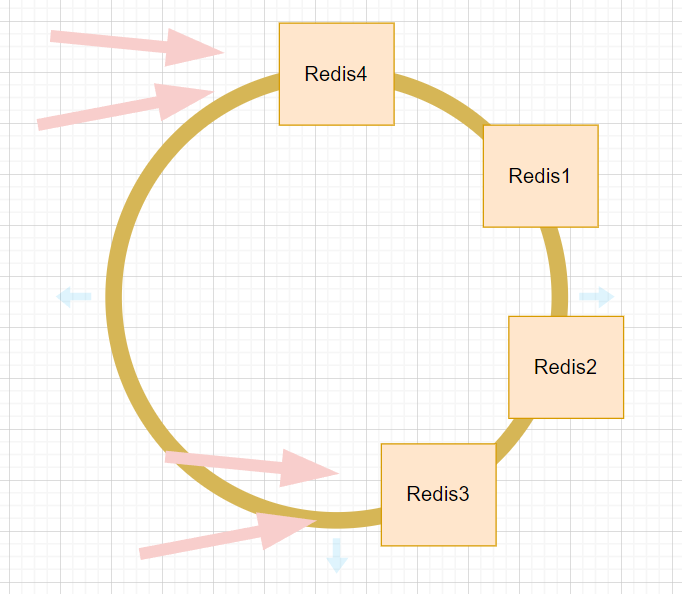

一致性哈希算法的核心思想是将数据映射到一个固定范围的哈希环(环大小为2^32-1个节点)上,服务器节点也同样映射到这个哈希环上。数据根据其哈希值顺时针查找距离最近的服务器节点,从而完成数据的存储和访问。

还是拿上述分片集群为例:当采用一致性哈希后,Redis分片集群便成为了下面的样子:

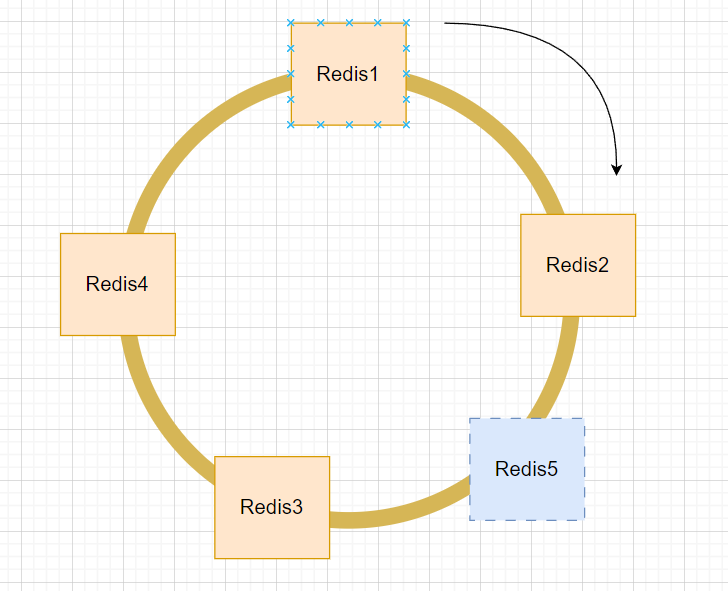

当需要在Redis节点2和Redis节点3之间添加一个新的Redis节点5时,只需要将原本属于Redis节点3的一部分数据迁移到新的Redis节点5上,仅影响到原Redis节点3的数据,并不需要额外影响其他节点。这样一来,实现了在扩容时的高扩展性。

然而,一致性哈希环也会遇到一些问题,例如节点哈希分配不均匀,导致大量的请求集中在某些节点上(如Redis节点3和4),给这些节点带来很大的压力。

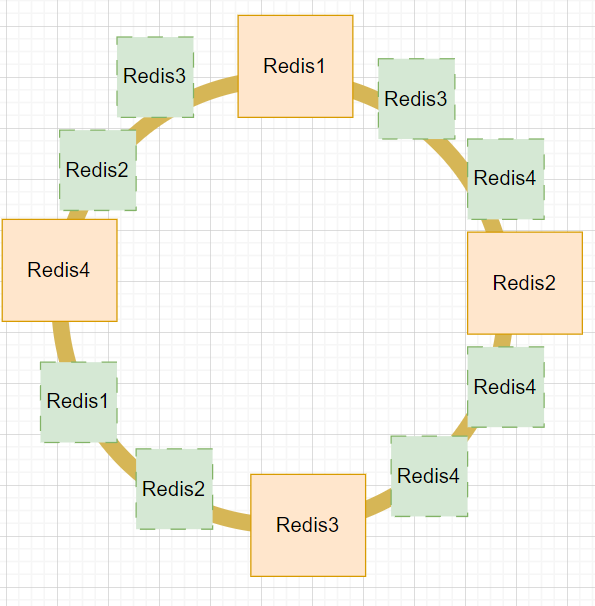

为了解决这一问题,我们引入了虚拟节点的概念。通过在哈希环上为每个实际节点引入多个虚拟节点,可以使数据分布更加均匀。理论上来说,引入的虚拟节点越多,每个实际节点所受到的请求就越分散,从而减轻单个节点的压力。

四、使用场景

一致性哈希算法的具体使用场景广泛存在于需要均匀接收请求并且能够实现高扩展性的分布式系统中。下面是一些典型的场景:

- 服务器的负载均衡

在Web服务器集群中,一致性哈希可以用来将请求均匀地分配到各个服务器上。当集群中的服务器数量发生变化时,只需重新分配受影响的数据,而不是重新哈希所有的请求。这减少了重新分配的开销,提高了系统的整体性能。

- Redis分片集群

在Redis集群中,一致性哈希算法用于将数据均匀地分布在多个Redis实例上。当集群需要扩展时(例如添加新的Redis节点),一致性哈希可以确保只有一小部分数据需要重新分布,从而降低了数据迁移的成本。

- 分布式文件系统

在分布式文件系统中,一致性哈希算法可以帮助将文件分布到多个存储节点上,确保数据的高可用性和负载均衡。当系统需要扩展或节点出现故障时,一致性哈希能够有效地重新分配数据,保证系统的稳定性。

- CDN(内容分发网络)

在内容分发网络中,一致性哈希可以用来将用户的请求路由到最近或最适合的服务节点上。这种方式不仅减少了网络延迟,还能提高系统的响应速度和服务质量。

实际上,一致性哈希算法还有许多其他应用场景,但由于篇幅限制,我们在这里不再一一展开详述。

五、Java实现

下面我们通过Java中的TreeMap类(红黑树)实现一个一致性哈希算法。

TreeMap是一种基于红黑树的数据结构,它可以对键进行排序,方便快速找到需要进行操作的节点。利用TreeMap的这一特性,我们可以高效地实现一致性哈希算法。

package com.example.provider.utils;import java.util.*;/*** 一致性哈希负载均衡器*/

public class ConsistentHashLoadBalancer {private final static SortedMap<Integer, String> hashRing = new TreeMap<>();private final int numberOfReplicas; // 每个物理节点的虚拟节点数/*** 构造函数** @param numberOfReplicas 每个物理节点的虚拟节点数* @param physicalNodes 物理节点列表*/public ConsistentHashLoadBalancer(int numberOfReplicas, Collection<String> physicalNodes) {this.numberOfReplicas = numberOfReplicas;for (String node : physicalNodes) {addNode(node);}}/*** 添加节点** @param node 要添加的节点*/public void addNode(String node) {for (int i = 0; i < numberOfReplicas; i++) {int hash = getHash(node + i);hashRing.put(hash, node);}}/*** 移除节点** @param node 要移除的节点*/public void removeNode(String node) {for (int i = 0; i < numberOfReplicas; i++) {int hash = getHash(node + i);hashRing.remove(hash);}}/*** 获取节点** @param key 数据的键* @return 负责该数据键的节点*/public String getNode(String key) {if (hashRing.isEmpty()) {return null;}int hash = getHash(key);if (!hashRing.containsKey(hash)) {SortedMap<Integer, String> tailMap = hashRing.tailMap(hash);hash = tailMap.isEmpty() ? hashRing.firstKey() : tailMap.firstKey();}return hashRing.get(hash);}/*** 获取哈希值** @param key 键* @return 哈希值*/static final int getHash(Object key) {int h;return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>> 16);}public static void main(String[] args) {List<String> physicalNodes = Arrays.asList("Node1", "Node2", "Node3");ConsistentHashLoadBalancer loadBalancer = new ConsistentHashLoadBalancer(2, physicalNodes);hashRing.forEach((k, v) -> System.out.println(k + " -> " + v));// 测试数据定位for (int i = 0; i < 6; i++) {String node = loadBalancer.getNode("Key" + i);System.out.println("Key" + i + " is mapped to " + node);}// 移除一个节点loadBalancer.removeNode("Node2");System.out.println("\n移除一个节点 Node2:");for (int i = 0; i < 6; i++) {String node = loadBalancer.getNode("Key" + i);System.out.println("Key" + i + " is mapped to " + node);}hashRing.forEach((k, v) -> System.out.println(k + " -> " + v));// 增加一个节点loadBalancer.addNode("Node4");System.out.println("\n增加一个节点 Node4:");for (int i = 0; i < 6; i++) {String node = loadBalancer.getNode("Key" + i);System.out.println("Key" + i + " is mapped to " + node);}hashRing.forEach((k, v) -> System.out.println(k + " -> " + v));// 移除一个节点loadBalancer.removeNode("Node4");System.out.println("\n移除一个节点 Node4:");for (int i = 0; i < 6; i++) {String node = loadBalancer.getNode("Key" + i);System.out.println("Key" + i + " is mapped to " + node);}hashRing.forEach((k, v) -> System.out.println(k + " -> " + v));}

}

测试结果如下:

-1956273307 -> Node3

-1956270972 -> Node2

-1956270971 -> Node2

-1956270950 -> Node3

-1956270940 -> Node1

-1956270937 -> Node1

Key0 is mapped to Node3

Key1 is mapped to Node3

Key2 is mapped to Node3

Key3 is mapped to Node3

Key4 is mapped to Node3

Key5 is mapped to Node3移除一个节点 Node2:

Key0 is mapped to Node3

Key1 is mapped to Node3

Key2 is mapped to Node3

Key3 is mapped to Node3

Key4 is mapped to Node3

Key5 is mapped to Node3

-1956273307 -> Node3

-1956270950 -> Node3

-1956270940 -> Node1

-1956270937 -> Node1增加一个节点 Node4:

Key0 is mapped to Node3

Key1 is mapped to Node3

Key2 is mapped to Node3

Key3 is mapped to Node3

Key4 is mapped to Node3

Key5 is mapped to Node3

-1956273307 -> Node3

-1956273286 -> Node4

-1956273285 -> Node4

-1956270950 -> Node3

-1956270940 -> Node1

-1956270937 -> Node1移除一个节点 Node4:

Key0 is mapped to Node3

Key1 is mapped to Node3

Key2 is mapped to Node3

Key3 is mapped to Node3

Key4 is mapped to Node3

Key5 is mapped to Node3

-1956273307 -> Node3

-1956270950 -> Node3

-1956270940 -> Node1

-1956270937 -> Node1

五、总结

通过本文的学习,我们了解到一致性哈希算法为分布式系统带来了一系列重要的优势:

- 高扩展性:一致性哈希允许系统在增加或移除节点时,仅需重新分配受影响的数据,大大降低了数据迁移的成本。

- 均匀分布:通过将数据均匀分布到多个节点上,一致性哈希能够有效地避免单点过载,提高系统的整体性能。

- 高可用性:即使在部分节点失效的情况下,一致性哈希也能通过虚拟节点或其他节点来继续服务,保证系统的稳定性。

- 灵活的应用场景:一致性哈希不仅适用于缓存、负载均衡、数据库分片等场景,还在CDN、P2P网络、分布式文件系统等多种领域有着广泛的应用。

反思一致性哈希算法,我们可以从中获得以下几点启示:

- 设计原则:在设计分布式系统时,考虑到系统的可扩展性和健壮性是非常重要的。一致性哈希算法给我们打了个样,展示了如何在不影响系统现有服务的前提下进行扩展。

- 问题导向:任何技术都有其适用场景和局限性。一致性哈希虽然解决了许多问题,但也存在数据分布不均等挑战,比如说如何来设置一个合适的虚拟节点大小,太大则会增加负担,太小则会导致数据分配不均衡,实际还需要看具体的业务场景。

通过本文的学习,我们不仅掌握了一致性哈希算法的基本原理及其应用场景,更重要的是,它为我们提供了一个看待分布式系统设计的新视角,提醒着我们在未来的开发过程中更加注重系统的可扩展性和健壮性。