算法效率的度量方法

事后统计方法

事后统计方法:这种方法主要是通过设计好的测试程序和数据,利用计算机计时器对不同算法编制的程序的运行时间进行比较,从而确定算法效率的高低。

但这种方法显然是有很大缺陷的:

- 必须依据算法事先编制好程序,这通常需要花费大量的时间和精力。如果编制出来发现它根本就是很糟糕的算法,不是竹篮打水一场空吗?

- 时间的比较依赖计算机硬件和软件等环境因素,有时会掩盖算法本身的优劣。要知道,现在的一台四核处理器的计算机,跟当年286、386、486等老爷爷辈的机器相比,在处理算法的运算速度上,是不能相提并论的;而所用的操作系统、编译器、运行框架等软件的不同,也可以影响它们的结果;就算是同一台机器,CPU使用率和内存占用情况不一样,也会造成细微的差异。

- 算法的测试数据设计困难,并且程序的运行时间往往还与测试数据的规模有很大关系,效率高的算法在小的测试数据面前往往得不到体现。比如10个数字的排序,不管用什么算法,差异几乎是零。而如果有一百万个随机数字排序,那不同算法的差异就非常大了,而随机的散乱程度有好有坏,会使得算法比较变得不够客观。那么我们为了比较算法,到底用多少数据来测试?测试多少次才算可以?这是很难判断的问题。

基于事后统计方法有这样那样的缺陷,我们考虑不予采纳。

事前分析估算方法

我们的计算机前辈们,为了对算法的评判更科学,研究出了一种叫做事前分析估算的方法。

事前分析估算方法:在计算机程序编制前,依据统计方法对算法进行估算。

经过分析,我们发现,一个用高级程序语言编写的程序在计算机上运行时所消耗的时间取决于下列因素:

- 算法采用的策略、方法

- 编译产生的代码质量。

- 问题的输入规模

- 机器执行指令的速度。

(1)条当然是算法好坏的根本,第(2)条要由软件来支持,第(4)条要看硬件性能。

也就是说,抛开这些与计算机硬件、软件有关的因素,一个程序的运行时间,依赖于算法的好坏和问题的输入规模。所谓问题输入规模是指输入量的多少.

我们来看看今天刚上课时举的例子;两种求和的算法;

第一种算法(注意for循环最后还要多执行一次条件判断)

int i,sum=0,n=100;//执行1次

for(i=1;i<=n;i++)//执行n+1次

{

sum=sum+i; //执行n次

}

printf("%d",sum);//执行1次第二种算法

int sum=0,n=100;//执行一次

sum=(1+n)*n/2;//执行一次

printf("%d",sum);//执行一次显然,第一种算法,执行了1+(n+1)+n+1次=2n+3次;而第二种算法,是1+1+1=3次。

事实上两个算法的第一条和最后一条语句是一样的,所以我们关注的代码其实是中间的那部分,我们把循环看作一个整体,忽略头尾循环判断的开销,那么这两个算法其实是n次与1次的差距。算法好坏显而易见。

我们再来延伸一下上面这个例子:

int i,j,x=0,sum=0,n=100;//执行一次

for(i=1;i<=n;i++)

{

for(j=1;j<=n;j++)

{

x++; //执行n*n次

sum=sum+x;

}

}

printf("%d",sum);//执行一次在这个例子中,i从1到100,每次都要让循环100次,而当中的x++和sum= sum+x:其实就是1+2+3+…+10000,也就是次,所以这个算法当中,循环部分的代码整体需要执行n²(忽略循环体头尾的开销)次。

显然这个算法的执行次数对于同样的输入规模n=100,要多于前面两种算法,这个算法的执行时间随着n的增加也将远远多于前面两个。

此时你会看到,测定运行时间最可靠的方法就是计算对运行时间有消耗的基本操作的执行次数。运行时间与这个计数成正比。

我们不关心编写程序所用的程序设计语言是什么,也不关心这些程序将跑在什么样的计算机中,我们只关心它所实现的算法。这样,不计那些循环索引的递增和循环终止条件、变量声明、打印结果等操作,最终,在分析程序的运行时间时,最重要的是把程序看成是独立于程序设计语言的算法或一系列步骤。

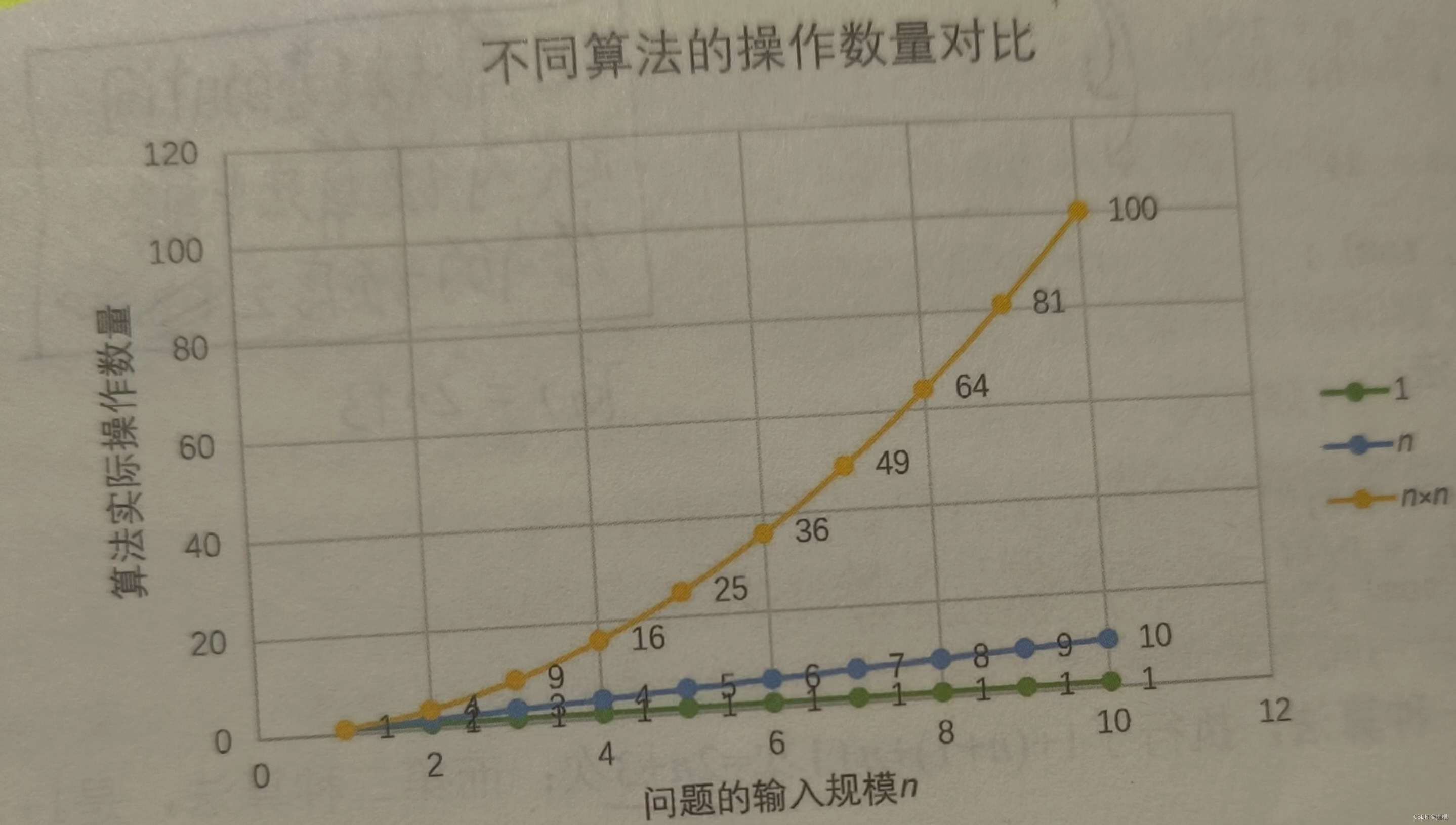

可以从问题描述中得到启示,同样问题的输入规模是n,求和算法的第一种,求1+2+…+n需要一段代码运行n次。那么这个问题的输入规模使得操作数量是f(n)=n,显然运行100次的同一段代码规模是运算10次的10倍。而第二种,无论n为多少,运行次数都为1,即f(n)=1;第三种,运算100次是运算10次的100倍,因为它是f(n)=n²。

我们在分析一个算法的运行时间时,重要的是把基本操作的数量与输入规模关联起来,即基本操作的数量必须表示成输入规模的函数(如下图所示)

我们可以这样认为,随着n值的越来越大,它们在时间效率上的差异也就越来越大。

好比你们当中有些人每天都在学习(我指有用的学习,而不是只为考试的死读书)每天都在进步,而另一些人,打打游戏,睡睡大觉。入校时大家都一样,但毕业时结果可能就大不一样,前者名企争抢着要,后者求职无门。

函数的渐近增长

我们现在来判断一下,以下两个算法A和B哪个更好。假设两个算法的入规模都是n,函教值为执行次数算法A要做2n+3次操作,你可以理解为先有一个n次的循环,执行完成后,再有一个n次循环,最后有三次赋值或运算,共2n+3次操作。算法B要做3n+1次操作。你觉得它们谁更快呢?

准确说来,答案是不一定的(如下表所示)。

| 次数(n) | 算法A(2n+3) | 算法A2(2n) | 算法B(3n+1) | 算法B2(3n) |

| 1 | 5 | 2 | 4 | 3 |

| 2 | 7 | 4 | 7 | 6 |

| 3 | 9 | 6 | 10 | 9 |

| 10 | 23 | 20 | 31 | 30 |

| 100 | 203 | 200 | 301 | 300 |

- 当n=1时,算法A效率不如算法B(次数比算法B要多一次)。

- 而当n=2时,两者效率相同;

- 当n>2时,算法A就开始优于算法B了,随着n的增加,算法A比算法B越来越好了(执行的次数比B要少)。

- 于是我们可以得出结论,算法A总体上要好过算法B。

此时我们给出这样的定义,输入规模n在没有限制的情况下,只要超过一个数值N,这个函数就总是大于另一个函数,我们称函数是渐近增长的。

函数的渐近增长:给定两个函数f(n)和g(n),如果存在一个整数N,使得对于所有的n>N,f(n)总是比g(n)大,那么,我们说f(n)的增长渐近快于g(n)

我们可以从中发现,随着n的增大,后面的+3还是+1其实是不影响最终的算法变化的,例如算法A2 和算法B2,所以我们可以忽略这些加法常数。后面的例子,这样的常数被被忽略的意义可能会更加明显。

我们来看第二个例子,算法C是4n+8,算法D是2+1。

| 次数(n) | 算法C(4n+8) | 算法C(n) | 算法D(2 | 算法D2( |

| 1 | 12 | 1 | 3 | 1 |

| 2 | 16 | 2 | 9 | 4 |

| 3 | 20 | 3 | 19 | 9 |

| 10 | 48 | 10 | 201 | 100 |

| 100 | 408 | 100 | 20001 | 10000 |

| 1000 | 4008 | 1000 | 2000001 | 10000000 |

当n≤3的时候,算法C要差于算法D(因为算法C次数比较多),但当n>3后,算法C就越来越优于算法D了,到后来更是远远胜过。而当后面的常数去掉后,我们发现其实结果没有改变。甚至我们再观察发现,哪怕去掉与n相乘的常数,这样的结果也没有改变,算法C2的次数随着n的增长,还是远远小于算法D2。

也就是说,与最高次项乘的常数并不重要。

我们再来看第三个例子。算法E是2n²+3n+1,算法F是2+3n+1。

| 次数 | 算法(2 | 算法E2( | 算法F(2 | 算法F2( |

| 1 | 6 | 1 | 6 | 1 |

| 2 | 15 | 4 | 23 | 8 |

| 3 | 28 | 9 | 64 | 27 |

| 10 | 231 | 100 | 2031 | 1000 |

| 100 | 20301 | 10000 | 2000301 | 1000000 |

当n=1的时候,算法E与算法F结果相同,但当n>1后,算法E的优势就要开始优于算法F,随着n的增大,差异越来越明显。通过观察发现(高次项的指数大的,函数随着n的增长,结果也会增长更快。

我们来看最后一个例子。算法G是2n²,算法H是3n+1,算法I是2n²+3n+1。

| 次数(n) | 算法G(2 | 算法H(3n+1) | 算法I(2 |

| 1 | 2 | 4 | 6 |

| 2 | 8 | 7 | 15 |

| 5 | 50 | 16 | 66 |

| 10 | 200 | 31 | 231 |

| 100 | 20000 | 301 | 20301 |

| 1000 | 2000000 | 3001 | 2003001 |

| 10000 | 200000000 | 30001 | 200030001 |

| 100000 | 20000000000 | 300001 | 20000300001 |

| 1000000 | 2000000000000 | 3000001 | 2000003000001 |

这组数据应该就看得很清楚。当n的值越来越大时,你会发现,3n+1已经没法和2n²的结果相比,最终几乎可以忽略不记。也就是说,随着n值变得非常大以后,算法G其实已经很趋近算法I。

于是我们可以得到这样一个结论,判断一个算法的效率时,函数中的常数和其他次要项常常可以忽略,而更应该关注主项(最高阶项)的阶数。

判断一个算法好不好,我们只通过少量的数据是不能做出准确判断的。

根据刚才的几个样例,我们发现,如果我们可以对比这几个算法的关键执行次数函数的渐近增长性,基本就可以分析出:某个算法,随着n的增大,它会越来越优于另一算法,或者越来越差于另一算法。这其实就是事前估算方法的理论依据,通过算法时间复杂度来估算算法时间效率。

算法时间复杂度

若某个算法的运行次数函数是T(n),若有某个辅助函数f(n),使当n趋近无穷大时,

的值为不等于0的常数,则称f(n)为T(n)的同量级函数,记作T(n)=O(f(n))

称O(f(n))为算法的渐近时间复杂度,简称时间复杂度

这样用大写O( )来体现算法时间复杂度的记法,我们称之为大O记法。

一般情况下,随着n的增大,T(n)增长最慢的算法为最优算法。

显然,由此算法时间复杂度的定义可知,我们的三个求和算法的时间复杂度分别为O(n),O(1),O(n²)。我们分别给它们取了非官方的名称,O(1)叫常数阶、O(n)叫线性阶、O(n²)叫平方阶,当然,还有其他的一些阶,我们之后会介绍。

推导大O阶方法

那么如何分析一个算法的时间复杂度呢?即如何推导大O阶呢?我们给出了下面的推导方法,基本上,这也就是总结前面我们举的例子。

推导大O阶:

(1)用常数数1取代运行时间中的所有加法常数。

(2)在修改后的运行次数函数中,只保留最高阶项

(3)如果最高阶项存在旦其系数不是1,则去除与这个项相乘的系数。

得到的结果就是大O阶。

哈,仿佛是得到了游戏攻略一样,我们好像已经得到了一个推导算法时间复杂度的万能公式。

可事实上,分析一个算法的时间复杂度,没有这么简单,我们还需要多看几个例子。

我们可以举个例子

就上面的算法H而言,T(n)=3n+1,f(n)=n,容易得到当n趋向无穷时,=3,容易得到算法H的时间复杂度为O(1)

常数阶

首先介绍顺序结构的时间复杂度。

下面这个算法,为什么时间复杂度不是O(3),而是O(1)。

int sum=0.n=100;//执行一次

sum=(1+n)*n/2;//执行一次

printf("%d",sum);//执行一次这个算法的运行次数函数是f(n)=3。根据我们推导大O阶的方法,第一步就是把常数项3改为1。在保留最高阶项时发现,它根本没有最高阶项,所以这个算法的时间复杂度就是O(1)。

另外,我们试想一下,如果这个算法当中的语句sum=(1+n)*n/2有10句,即:

int sum=0,n=100;

sum=(1+n)*n/2;

sum=(1+n)*n/2;

sum=(1+n)*n/2;

sum=(1+n)*n/2;

sum=(1+n)*n/2;

sum=(1+n)*n/2;

sum=(1+n)*n/2;

sum=(1+n)*n/2;

sum=(1+n)*n/2;

sum=(1+n)*n/2;

printf("%d",sum);事实上无论n为多少,上面的两段代码就是3次和12次执行的差异。这种与问题的大

小(n的大小)无关,执行时间恒定的算法,我们称之为具有O(1)的时间复杂度,又叫常

数阶。

注意:不管这个常数是多少,我们都记作0(1),而不能是O(3)、O(12)等其他任何数字,这是初学者常常犯的错误。

对于分支结构而言,无论是真,还是假,执行的次数都是恒定的,不会随着n的变大而发生变化,所以单纯的分支结构(不包含在循环结构中),其时间复杂度也是0(1)。

线性阶

线性阶的循环结构会复杂很多。

要确定某个算法的阶次,我们常常需要确定某个特定语句或某个语句集运行的次数。

因此,我们要分析算法的复杂度,关键就是要分析循环结构的运行情况。

下面这段代码,它的循环的时间复杂度为O(n),因为循环体中的代码需要执行n次。

inti;

for(i= 0;i < n;i++)

{

/*时间复杂度为0(1)的程序步骤序列 */

}对数阶

下面的这段代码,时间复杂度又是多少呢?

int count =1;

while(count < n)

{

count*=2;

/* 时间复杂度为O(1)的程序步骤序列 */

}由于每次count乘以2之后,就距离n更近了一分。

也就是说,有多少个2相乘后大于n,则会退出循环。

由=n得到x=

。所以这个循环的时间复杂度为O(logn)。

平方阶

下面例子是一个循环嵌套,它的内循环刚才我们已经分析过,时间复杂度为O(n)。

int i,j;

for(i=0;i<n;i++)

{

for (j = 0; j< n; j++)

{/* 时间复杂度为0(1)的程序步骤序列 */}}而对于外层的循环,不过是内部这个时间复杂度为O(n)的语句,再循环n次。所以这段代码的时间复杂度为O(n²)。

如果外循环的循环次数改为了m,时间复杂度就变为O(mxn)。

int i,j;

for(i=0;i<m;i++)

{

for (j = 0; j< n; j++)

{/* 时间复杂度为0(1)的程序步骤序列 */}}所以我们可以总结得出,循环的时间复杂度等于循环体的复杂度乘以该循环运行的次数。

那么下面这个循环嵌套,它的时间复杂度是多少呢?

int i,j;

for(i=0;i<n;i++)

for (j = i; j<n; j++) /*注意j = i而不是0*/

{

/*时间复杂度为O(1)的程序步骤序列 */

}由于当i=0时,内循环执行了n次,当i=1时,执行了n-1次,……当i=n-1时,执行了1次。所以总的执行次数为:n+(n-1)+(n-2)+……+1=

用我们推导大O阶的方法,

第一条,没有加法常数不予考虑

第二条,只保留最高阶项,因此保留n²/2;

第三条,去除与这个项相乘的常数,也就是去除1/2,最终这段代码的时间复杂度为0(n²)。

从这个例子,我们也可以得到一个经验,其实理解大O阶推导不算难,难的是对数列的一些相关运算,这更多的是考察你的数学知识和能力。

我们继续看例子,对于方法调用的时间复杂度又如何分析。

int i,j;

for(i=0;i<n;i++)

{

function(i);

}上面这段代码调用一个函数function()。

void function (int count)

{

print(count);

}函数体是打印count这个参数。其实这很好理解,function()函数的时间复杂度是O(1)。

所以整体的时间复杂度为O(n)。

假如function()是下面这样的:

void function (int count)

{

int j;

for(j=count;j < n; j++)

{

/*时间复杂度为O(1)的程序步骤序列*/

}

}事实上,这和刚才举的例子是一样的。只是因为把嵌套内循环放到了函数中,所以最终的时间复杂度为O()。

下面这段相对复杂的语句:

n++;

function(n);

int i,j;

for(i=0;i<n;i++)

{function(i);

}for(i=0;i<n;i++)

{for(j=i;j<n;j++){printf("hello");}

}

它的执行次数f(n)=1+n+n²+=

,根据推导大O阶的方法,最终这段代码的时间复杂度也是O(n)。

时间复杂度所耗费的时间比较

时间复杂度所耗费的时间比较从小到大依次是

最坏情况与平均情况

你早晨上班出门后突然想起来,手机忘记带了,这年头,钥匙、钱包、手机三大件,出门哪件也不能少呀。于是回家找。打开门一看,手机就在门口玄关的台子上,原来是出门穿鞋时忘记拿了。这当然是比较好,基本没花什么时间寻找。可如果不是放在那里,你就得进去到处找,找完客厅找卧室、找完卧室找厨房、找完厨房找卫生间,就是找不到,时间一分一秒地过去,你突然想起来,可以用家里座机打一下手机,循着手机铃声来找呀,真是笨。终于找到了,在床上枕头下面。你再去上班,迟到。见鬼,这一年的全勤奖,就因为找手机给黄了。

找东西有运气好的时候,也有怎么也找不到的时候。但在现实中,通常我们碰到的

绝大多数既不是最好的也不是最坏的,所以算下来是平均情况居多。

算法的分析也是类似,我们查找一个有n个随机数字数组中的某个数字,最好的情况是第一个数字就是,那么算法的时间复杂度为O(1),但也有可能这个数字就在最后一位置上待着,那么算法的时间复杂度就是O(n),这是最坏的一种情况了。

最坏情况运行时间是一种保证,那就是运行时间不会再坏了。在应用中,这是一种最重要的需求。通常,除非特别指定,我们提到的运行时间都是最坏情况的运行时间。

而平均运行时间也就是从概率的角度看,这个数字在每一个位置的可能性是相同的,所以平均的查找时间为(n+1)/2次后发现这个目标元素。

平均运行时间是所有情况中最有意义的,因为它是期望的运行时间。也就是说,我们运行一段程序代码时,是希望看到平均运行时间的。可现实中,平均运行时间很难通过分析得到,一般都是通过运行一定数量的实验数据后估算出来的。

对算法的分析,一种方法是计算所有情况的平均值,这种时间复杂度的计算方法称为平均时间复杂度。另一种方法是计算最坏情况下的时间复杂度,这种方法称为最坏时间复杂度。

一般在没有特殊说明的情况下,都是指最坏时间复杂度。

:2024.04.05-2024.04.10)

)

导致的机器重启)

)

)

助阵米粉节)

神经外科手术的定位与导航全过程文档及程序)