jieba库

一、概述

jieba 库的分词原理是利用一个中文词库,将待分词的内容与分词词库进行比对,通过图结构和动态规划方法找到最大概率的词组;除此之外,jieba 库还提供了增加自定义中文单词的功能。

支持三种分词模式

1、精确模式,试图将句子最精确地切开,适合文本分析;

result1 = jieba.cut(str2)

2、全模式,把句子中所有的可以成词的词语都扫描出来, 速度非常快,但是不能解决歧义;

result2 =jieba.cut(str1,cut_all = True)

3、搜索引擎模式,在精确模式的基础上,对长词再次切分,提高召回率,适合用于搜索引擎分词。

result3 = jieba.cut_for_search(str3)

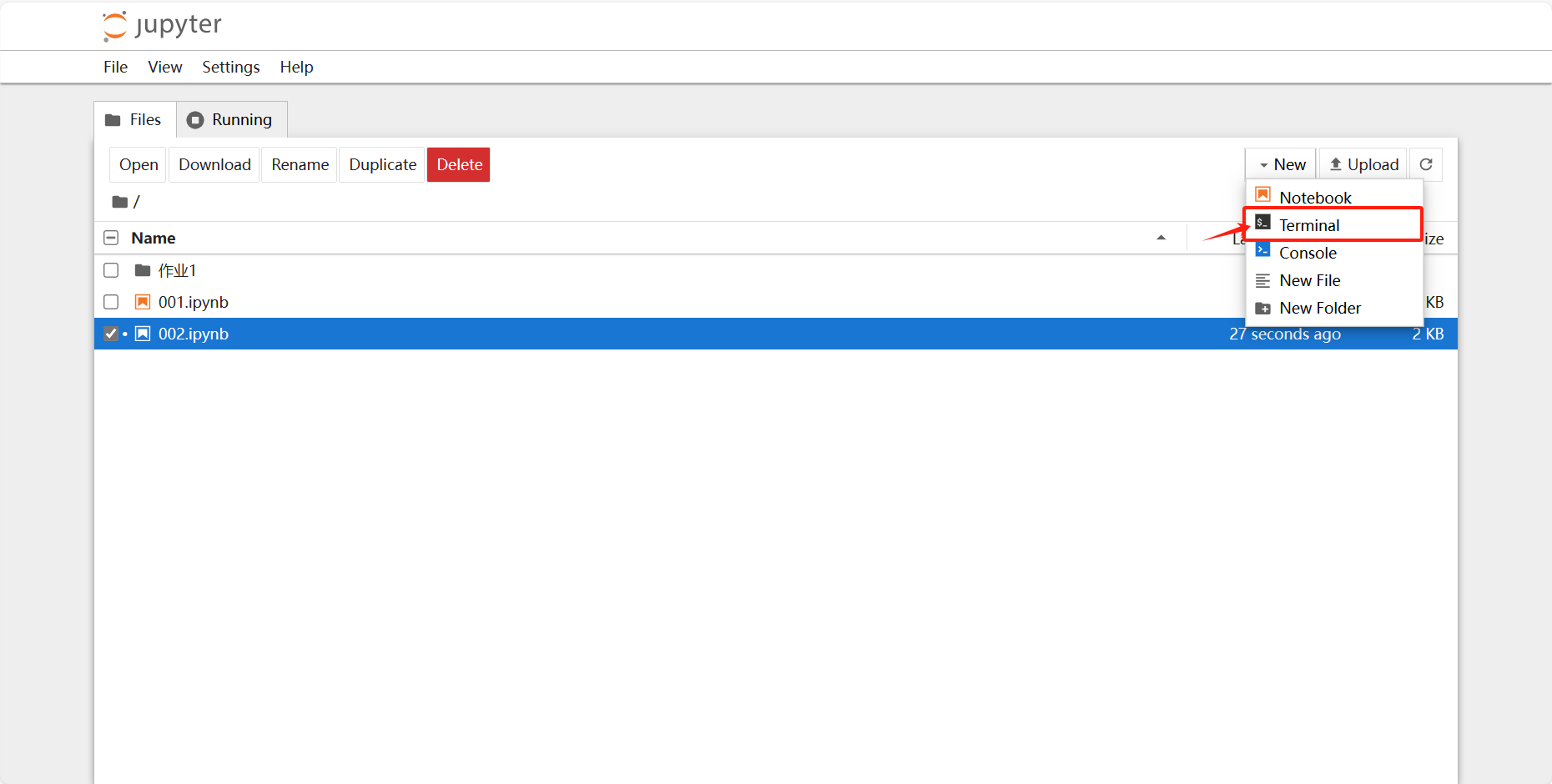

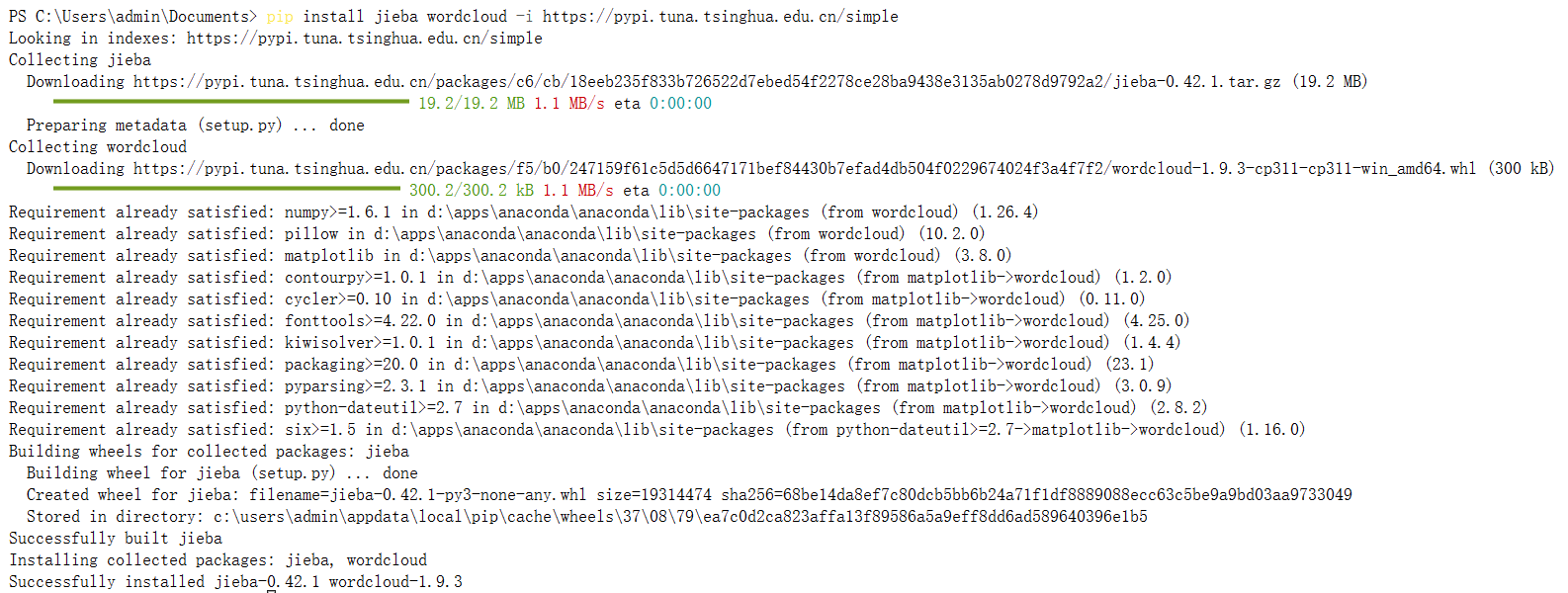

二、jupyter安装jieba库

输入pip install jieba wordcloud -i https://pypi.tuna.tsinghua.edu.cn/simple安装jieba和词云

安装完成!

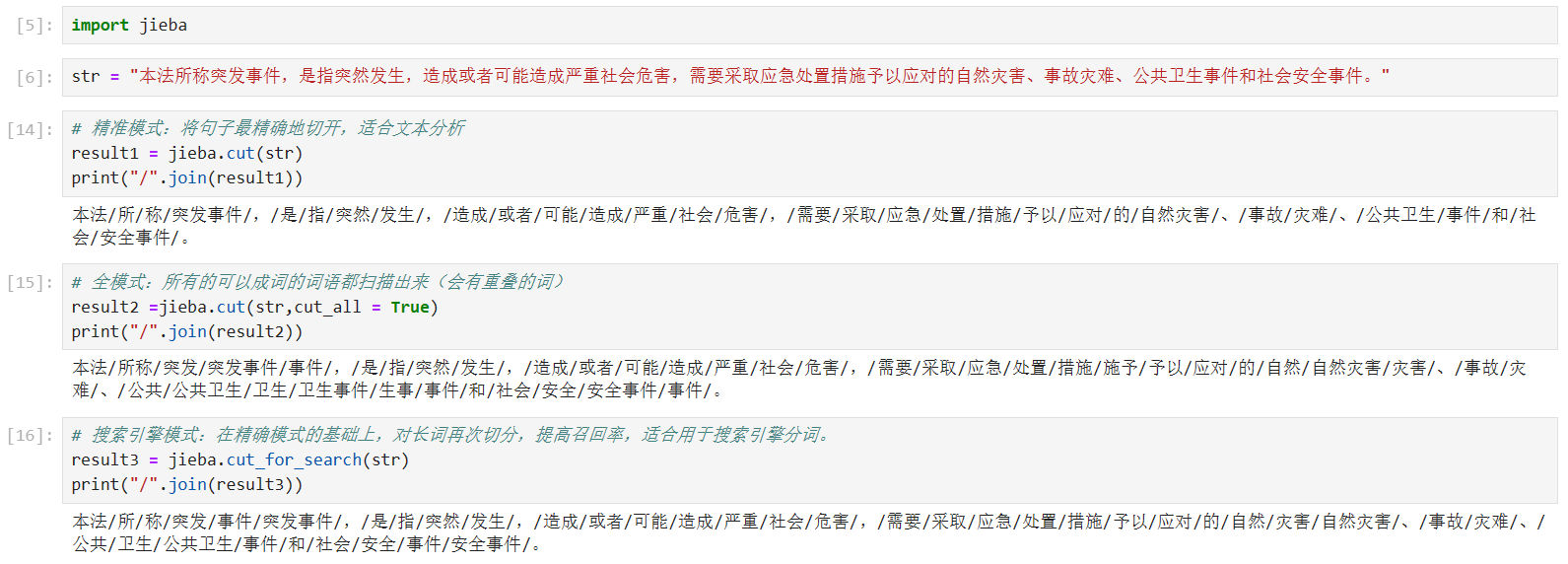

三、代码演示

代码与结果展示:

代码

import jiebastr = "本法所称突发事件,是指突然发生,造成或者可能造成严重社会危害,需要采取应急处置措施予以应对的自然灾害、事故灾难、公共卫生事件和社会安全事件。"# 精准模式:将句子最精确地切开,适合文本分析

result1 = jieba.cut(str)

print("/".join(result1))# 全模式:所有的可以成词的词语都扫描出来(会有重叠的词)

result2 =jieba.cut(str,cut_all = True)

print("/".join(result2))# 搜索引擎模式:在精确模式的基础上,对长词再次切分,提高召回率,适合用于搜索引擎分词。

result3 = jieba.cut_for_search(str)

print("/".join(result3))四、cut和lcut的区别

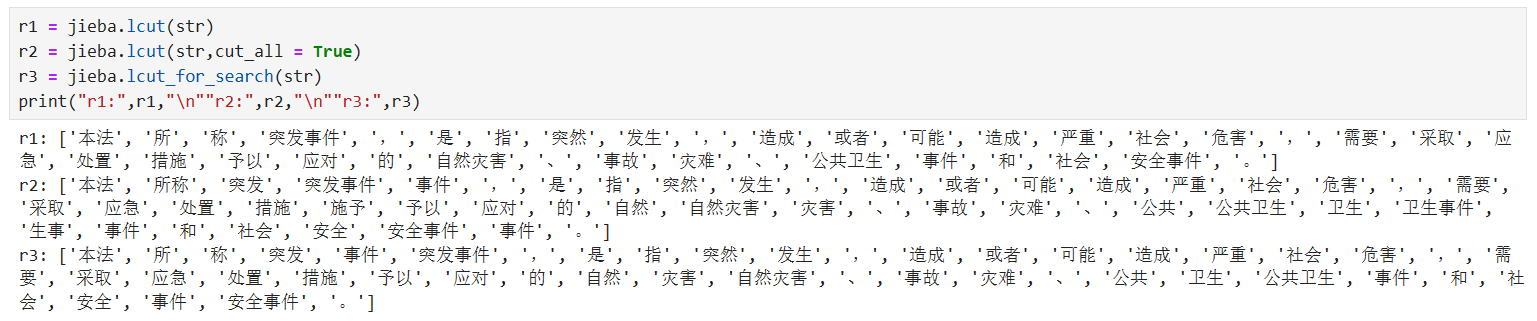

Jieba的cut和lcut分词:

(1)从效果看,二者没区别,区别在于结果的表示形式

(2)cut的结果是迭代器,需要进一步处理才能看到分词具体结果;lcut生成一个列表的形式,可以直接输出

部署 y-api 接口管理平台)

![[数据概念|方案实操]最新案例-七个数据资产化案例解析](http://pic.xiahunao.cn/[数据概念|方案实操]最新案例-七个数据资产化案例解析)

)

)

![hell 中各种括号的作用()、(())、[]、[[]]、{}](http://pic.xiahunao.cn/hell 中各种括号的作用()、(())、[]、[[]]、{})

)

)

】)

为分布式系统生成全局唯一ID)