一、Training-WWW-Robots

进入网站如图:

翻译:在这个小小的挑战训练中,你将学习Robots exclusion standard。网络爬虫使用robots.txt文件来检查它们是否被允许抓取和索引您的网站或只是其中的一部分。

有时这些文件会暴露目录结构,而不是保护内容不被抓取。

好好享受吧!

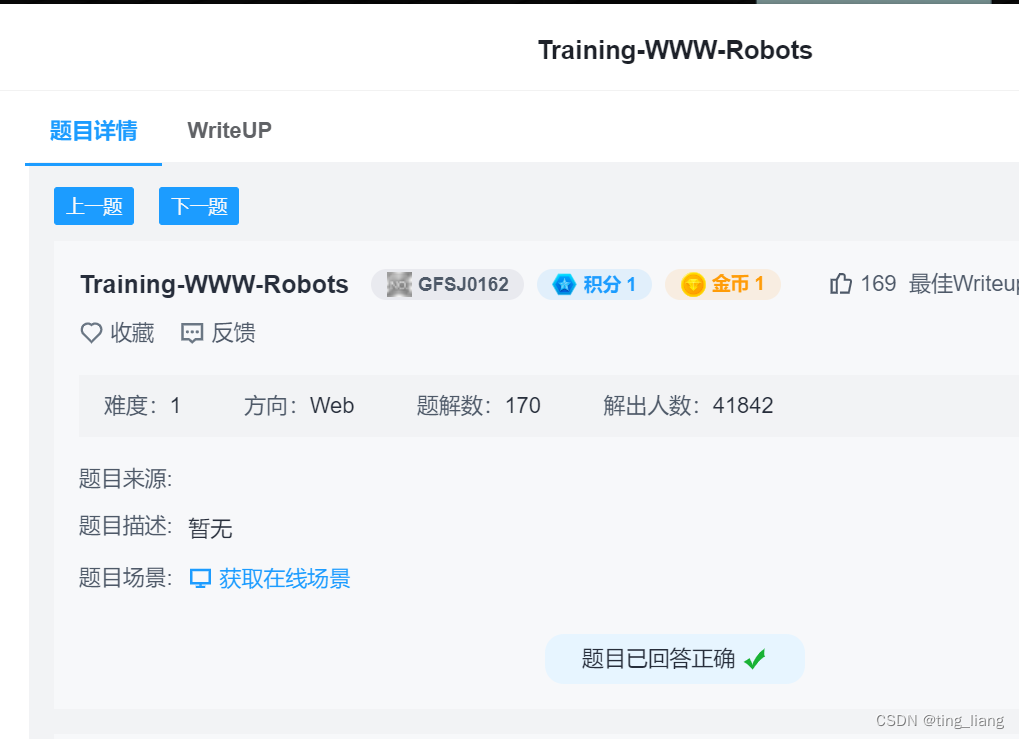

步骤一:进入robots.txt文件,如图:

步骤二:得到/f10g.php,在进入这里面得到flag

提交即可成功!!!

二、php2

步骤一:打开场景会发现什么都没有提示如图:

步骤二:注意看标题是php2,那么我们要从php下手,输入index.phps 那么为什么这是index.php

了,如下图所示:

phps 文件就是 php 的源代码文件,通常用于提供给用户(访问者)查看 php 代码,因为用 户无法直接通过 Web 浏览器看到 php 文件的来内容,所以需要用 phps 文件代替。其实,只 要不用 php 等已经在服务器中注册过的 MIME 类型为文件即可,但为源了国际通用,所以才 用了 phps 文件类型。

步骤三:分析代码分析用的是url编码,url 解码是% + ascii 的十六进制

url编码网站:http://www.jsons.cn/urlencode/

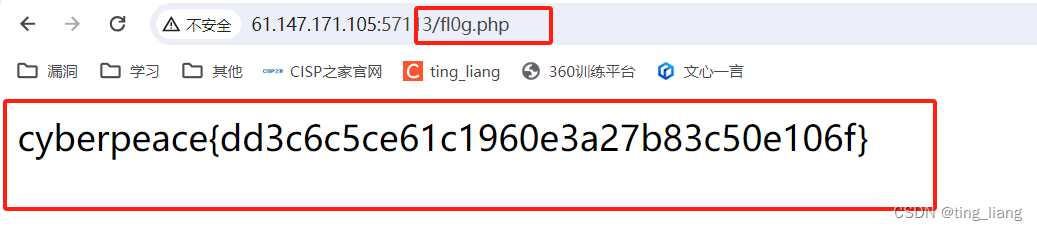

步骤四:admin一次编码为%61%64%6d%69%6e,如图所示输入得到:

步骤五:原因是系统自动解了一次码,所以我们要对admin进行二次编码如图:

步骤六:如图输入得到flag

提交即可成功!!!

三、unserialize3

步骤一:进入网站如图,这里是一个php序列化问题,以下是PHP学习序列的网站

PHP反序列化由浅入深 - 先知社区

步骤二:打开ps等可以进行php编写软件,如图所示

步骤三:运行就可以得到code=,如图所示

步骤四:如图所示得到flag

提交即可成功!!!

四、view_source

步骤一:打开网站发现说flag不在这里,结合标题说view_source视图源,则查看页面源代码

步骤二:有F12打开源代码(有一些电脑是Fn+F12才能打开),点查看器如图所示得到flag

提交即可成功!!!

五、robots

跟第一题一样

Robots协议,也被称为爬虫协议或网络蜘蛛协议,是网站和爬虫之间的一种约定。具体来说,网站可以通过建立一个robots.txt文件来告知搜索引擎爬虫哪些页面可以抓取,哪些页面不能抓取。搜索引擎爬虫在访问网站时会首先查看这个文件,以确定其访问的范围。如果robots.txt文件不存在,那么搜索引擎爬虫通常能够访问网站上所有没有被口令保护的页面。

然而,值得注意的是,Robots协议并不是防火墙,也没有强制执行力。尽管搜索引擎会尽量遵守robots.txt文件中的规则,但它们也可以选择忽视这些规则去抓取网页的快照。因此,Robots协议并不能完全保证网站的隐私。

总的来说,Robots协议的主要作用是指导网络爬虫如何访问和抓取网页,以确保网站访问的合法性和避免不必要的冲突。同时,它也提醒我们,尽管有这样的协议存在,但网站的隐私和安全仍需要依赖其他更为严格的措施来保障

步骤一:进入网站看见robots,就想到robots.txt

步骤二:得到上面,输入他得到flag

提交即可成功!!!

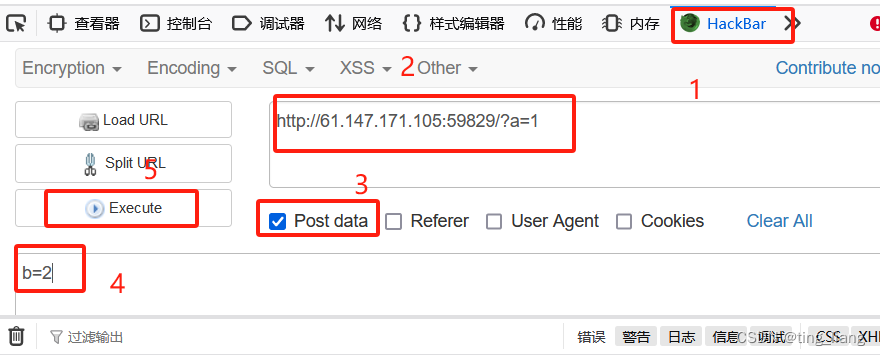

六、get_post

HTTP通常使用两种请求方法,get和post

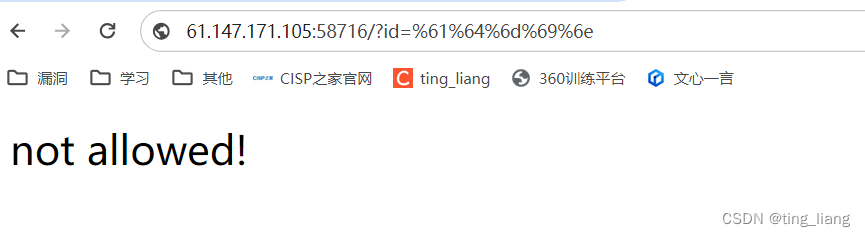

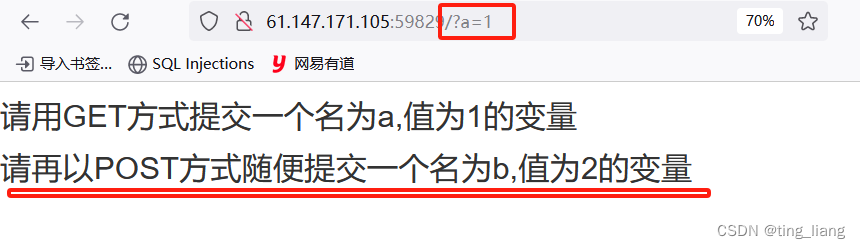

步骤一:先get方式提交一个a=1的变量如图所示:

步骤二:如上图所示,再输入post方式提交一个b=2,这里需要用HackBar(是一个插件)来进行输入。用F12打开源代码,如图所示输入

这样就完成了

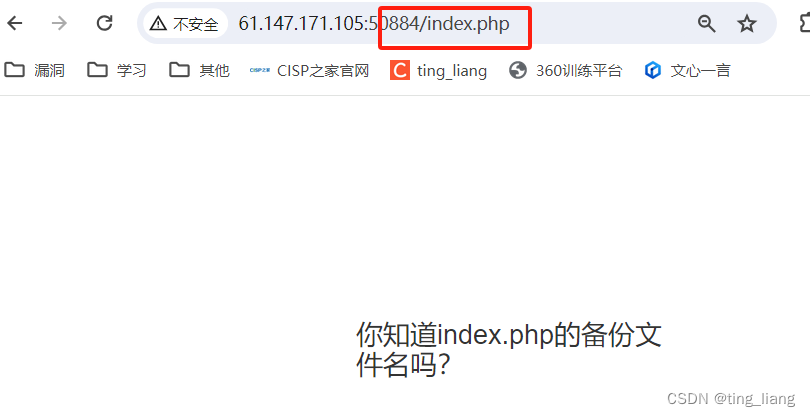

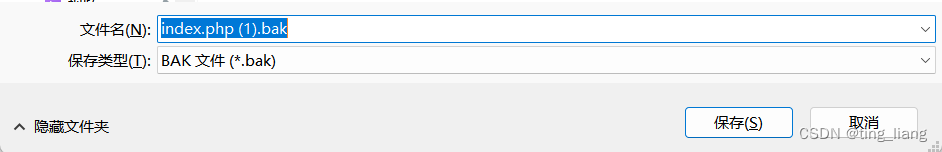

七、backup

步骤一:了解常见的备份文件后缀名有: .git .svn .swp .svn .~ .bak .bash_history

步骤二:一个个试验一下发现.bak是,叫你下载一个文本,下载

步骤三:打开文本发现flag

提交即可成功!!!

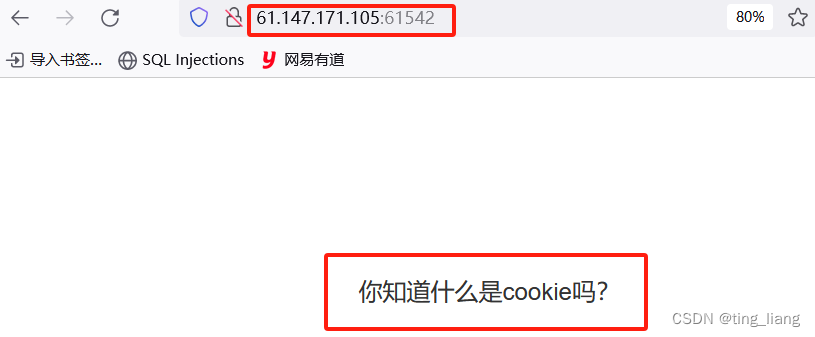

八、cookie

方法一

步骤一:打开网站只有这个信息

步骤二:F12打开源代码,发现cookie.php

步骤三:输入cookiep.php得到如图所示

步骤四:点击网络打开网络,找到cookie.php打开,得到flag

提交即可成功!!!

方法二:

步骤一:打开Burp Suite进行抓包,如图所示,得到cookie.php

步骤二:输入cookie.php,再进行抓包。

步骤三:得到如图所示的flag

)

)