文章目录

- 论文链接:[https://arxiv.org/pdf/2302.13540.pdf](https://arxiv.org/pdf/2302.13540.pdf)、

- 代码链接: [https://github.com/megvii-research/OccDepth](https://github.com/megvii-research/OccDepth)

- 网络结构:

- Stereo moudule 通过双目的深度预计来

- Correaltion weight

- OAD module

- 减轻过拟合的技巧(TMO)

论文链接:https://arxiv.org/pdf/2302.13540.pdf、

代码链接: https://github.com/megvii-research/OccDepth

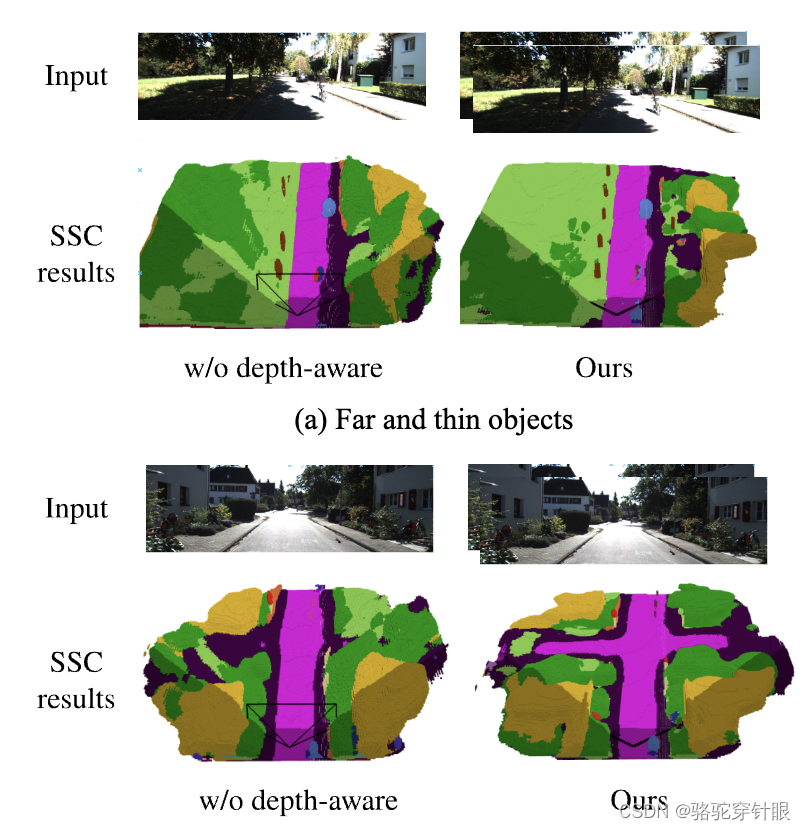

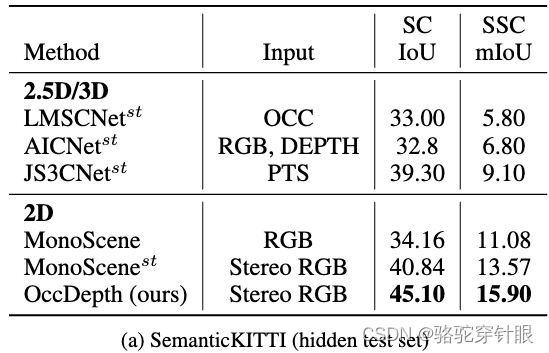

结果图如上,有没有深度信息真的差别很大

-

技术方法简介:该工作通过借鉴人类利用双眼感知3D世界中深度信息的能力,提出了一种名为OccDepth的语义场景补全方法。这种方法既显式也隐式地利用了图像中包含的深度信息,旨在帮助更好地恢复3D几何结构。

-

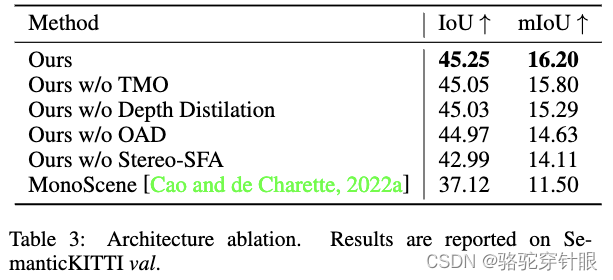

技术实现细节:OccDepth方法通过两种主要途径来利用深度信息:一是显式的深度蒸馏,二是隐式的深度优化。这两种方式共同作用,以期达到更精确的3D几何结构恢复。

-

实验结果与效果评估:在SemanticKITTI和NYUv2等公开数据集上进行的大量实验表明,OccDepth方法相比当前基于纯视觉的语义场景补全(SSC)方法有显著提升。具体来说,在SemanticKITTI数据集上,OccDepth方法实现了+4.82%的平均交并比(mIoU)提升,

-

+2.49%的提升归因于隐式深度优化,

-

+2.33%的提升来自于显式深度蒸馏。

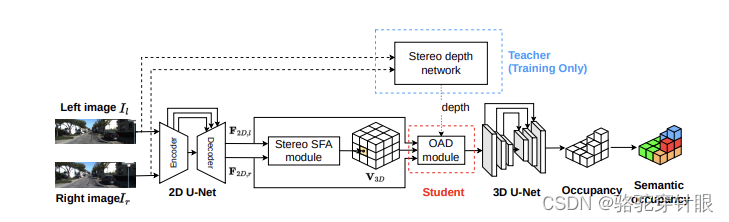

网络结构:

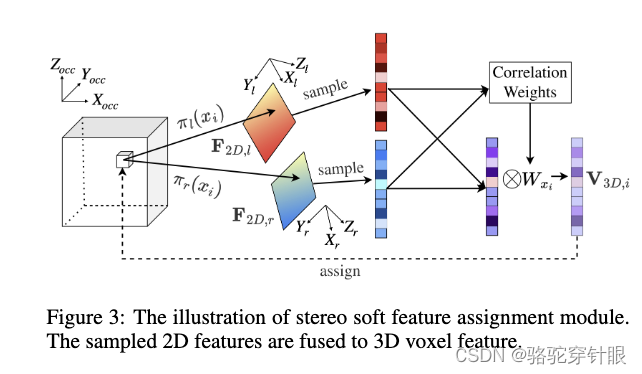

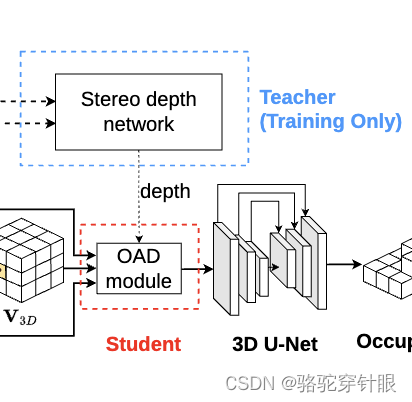

Stereo moudule 通过双目的深度预计来

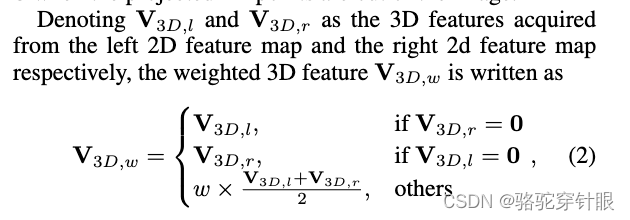

双目的关系

Correaltion weight

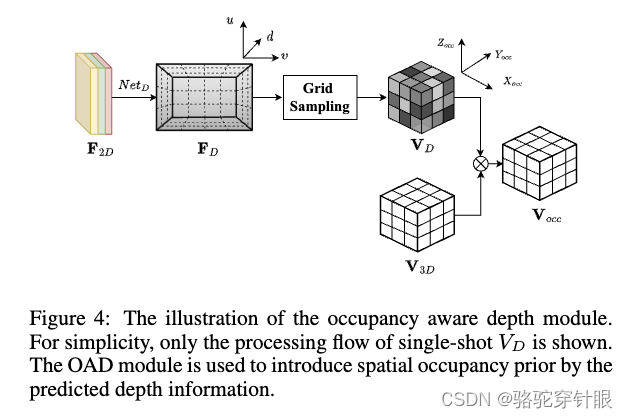

OAD module

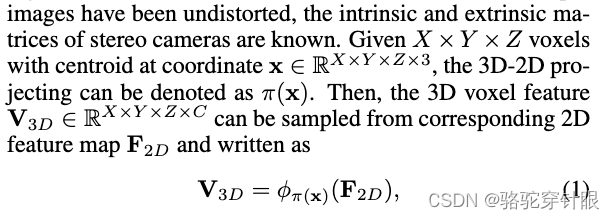

教师和学生网络

深度voxel 和 3D的voxel 关系

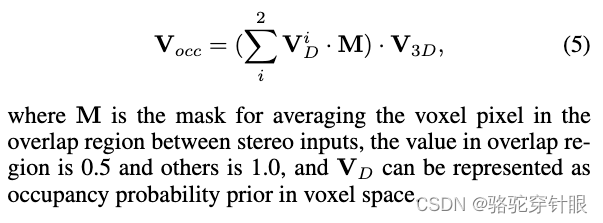

为了防止overlap,他们设置了参数是 0.5和1.0

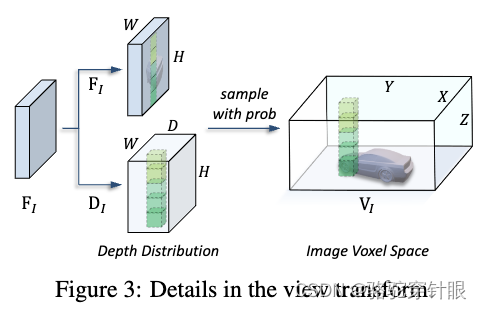

这个想法来自LSS的深度离散估计的方法。他们关注object,这篇是Occ,关注的是voxel

实验结果

减轻过拟合的技巧(TMO)

• 2D 预训练: OccDepth 中的2D 主干可以在大型实例分割数据集上进行预训练。这种预训练过程可以增强 2D 特征(F2D)中的语义信息。

• 数据增强:更强的数据增强可以缓解训练数据较少的问题。高斯模糊、灰度和色调调整是特别有用的增强方法。

• 损失权重调整:由于不同任务的损失规模不平衡,一些过拟合的损失会大大降低其他损失的优化效果。过拟合损失Lscal_sem会在训练过程中通过逐渐减小的权重γ来加权。 γ 计算如下:

γ = max(0.2, 1 − x/N)

其中 x 是当前训练步骤,N 是总训练步骤。

)

![解决: MAC ERROR [internal] load metadata for docker.io/library/openjdk:17](http://pic.xiahunao.cn/解决: MAC ERROR [internal] load metadata for docker.io/library/openjdk:17)

+Unreal(HTTP))

)