爬取知网论文数据

- 解决验证码

- 实现过程

- 代码

解决验证码

首先我们必须要识别出验证码,才能让进行下一步。

分享一个好用的网站

云码

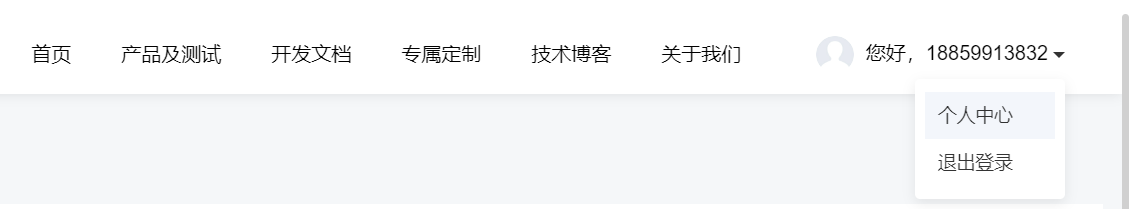

接着按照流程操作来得到积分,点击个人中心查看自己的token即可(会用到,一次大约10积分,初始有300免费积分,1元能有1000积分)

实现过程

我们使用的是DrissionPage这个简单又迅速的库

✨️ 概述

DrissionPage 是一个基于 python 的网页自动化工具。

它既能控制浏览器,也能收发数据包,还能把两者合而为一。

可兼顾浏览器自动化的便利性和 requests 的高效率。

它功能强大,内置无数人性化设计和便捷功能。

它的语法简洁而优雅,代码量少,对新手友好。

项目地址:gitee

🎇 强大的自研内核

本库采用全自研的内核,内置了 N 多实用功能,对常用功能作了整合和优化,对比 selenium,有以下优点:

无 webdriver 特征 无需为不同版本的浏览器下载不同的驱动 运行速度更快 可以跨 iframe 查找元素,无需切入切出 把

iframe 看作普通元素,获取后可直接在其中查找元素,逻辑更清晰 可以同时操作浏览器中的多个标签页,即使标签页为非激活状态,无需切换

可以直接读取浏览器缓存来保存图片,无需用 GUI 点击另存 可以对整个网页截图,包括视口外的部分(90以上版本浏览器支持)

可处理非open状态的 shadow-root

🎇 亮点功能

除了以上优点,本库还内置了无数人性化设计。

极简的语法规则。集成大量常用功能,代码更优雅 定位元素更加容易,功能更强大稳定

无处不在的等待和自动重试功能。使不稳定的网络变得易于控制,程序更稳定,编写更省心 提供强大的下载工具。操作浏览器时也能享受快捷可靠的下载功能

允许反复使用已经打开的浏览器。无需每次运行从头启动浏览器,调试超方便 使用 ini

文件保存常用配置,自动调用,提供便捷的设置,远离繁杂的配置项 内置 lxml 作为解析引擎,解析速度成几个数量级提升 使用 POM

模式封装,可直接用于测试,便于扩展 高度集成的便利功能,从每个细节中体现

实现流程:输入文献关键词+文献爬取页数+保存的文件名即可得到

代码

from DrissionPage import ChromiumPage

import time

from DrissionPage.common import Actions

import random

from tqdm import tqdm

from DrissionPage import WebPage

import csv

import base64

import requests,json#识别很难的验证码,但是使用有限制,别一直狂用,不然就会没了。

def get_vecode():url = "https://www.jfbym.com/api/YmServer/customApi"with open(r'验证码.png','rb') as f:im = base64.b64encode(f.read()).decode()data = {"token":" ", #输入自己的token"type":"10103",#效果不行就改成10103"image":im,}_headers = {'Content-Type': 'application/json'}response = requests.request![[AIGC] MySQL与PostgreSQL事务完整性的对比](http://pic.xiahunao.cn/[AIGC] MySQL与PostgreSQL事务完整性的对比)

—案例:实现线性回归》)

)

)

即将召开!)

环境)