目录

一、前言

二、requests 请求库

1、requests 安装

2、requests 的基本使用

三、Beautiful Soup

1、Beautiful Soup 安装

2、BeautifulSoup对象介绍与创建

3、BeautifulSoup对象的find方法

四、总结

一、前言

什么是爬虫?

网络爬虫(又被称为网页蜘蛛,网络机器人)就是模拟客户端发送网络请求,获取响应数据,一种按照一定的规则,自动地抓取万维网信息的程序或脚本。

他的作用是什么?

从万维网上获取, 我们需要的信息。

二、requests 请求库

requests 是一个基于 Python 的 HTTP 请求库,它简化了发送 HTTP 请求和处理响应的过程。使用 requests 库,开发者可以轻松地发送 GET、POST、PUT、DELETE 等类型的请求,并处理返回的数据。requests 库提供了简洁易用的 API 接口,使得进行 HTTP 请求变得非常方便。它支持 SSL、连接池、Cookie 持久化、代理、认证等功能,是 Python 中常用的 HTTP 请求库之一,广泛应用于网络爬虫、Web 开发等领域。

1、requests 安装

在终端(命令行工具) 运行这个简单命令即可 “pip install requests”。

注意:

如果你要安装Python虚拟环境中, 先进入虚拟机环境再执行上述命令

如果系统中既安装了Python2 又安装了 Python3, 需要安装Python3环境中: pip3 install requests

2、requests 的基本使用

导入模块、发送get请求, 获取响应: 、从响应中获取数据:

这串代码的作用是什么呢?常见属性又是什么呢?

response.text : 响应体 str类型

response.ecoding : 二进制转换字符使用的编码

respones.content: 响应体 bytes类型

三、Beautiful Soup

Beautiful Soup 是一个用于解析 HTML 和 XML 文档的 Python 库。它可以帮助开发者从网页中提取数据,进行信息检索和数据挖掘等操作。通过 Beautiful Soup,开发者可以方便地遍历文档树、搜索特定内容,并提取所需信息。这个库提供了简单又灵活的方式来处理复杂的 HTML 和 XML 结构,是 Python 爬虫和数据抓取中常用的工具之一。

1、Beautiful Soup 安装

# 安装 Beautiful Soup 4

pip install bs4

# 安装 lxml

pip install lxml

2、BeautifulSoup对象介绍与创建

BeautifulSoup对象: 代表要解析整个文档树,

它支持 遍历文档树 和 搜索文档树 中描述的大部分的方法.

创建 BeautifulSoup 对象

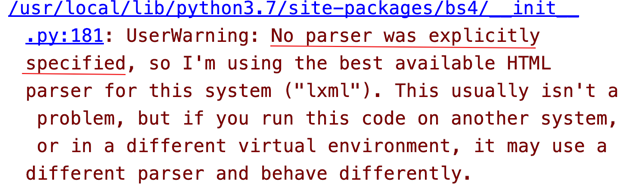

注意:可能存在警告问题

解决警告问题

3、BeautifulSoup对象的find方法

四、总结

利用Python爬虫获取xx数据前置环境要求完成,下一篇就开始正片了。

![[Linux] 进程间通信基础](http://pic.xiahunao.cn/[Linux] 进程间通信基础)

:T_Box)

)

)