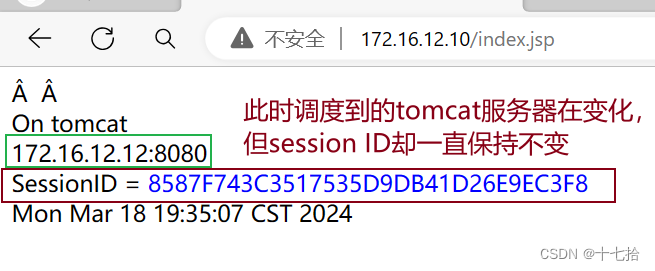

1、主流架构

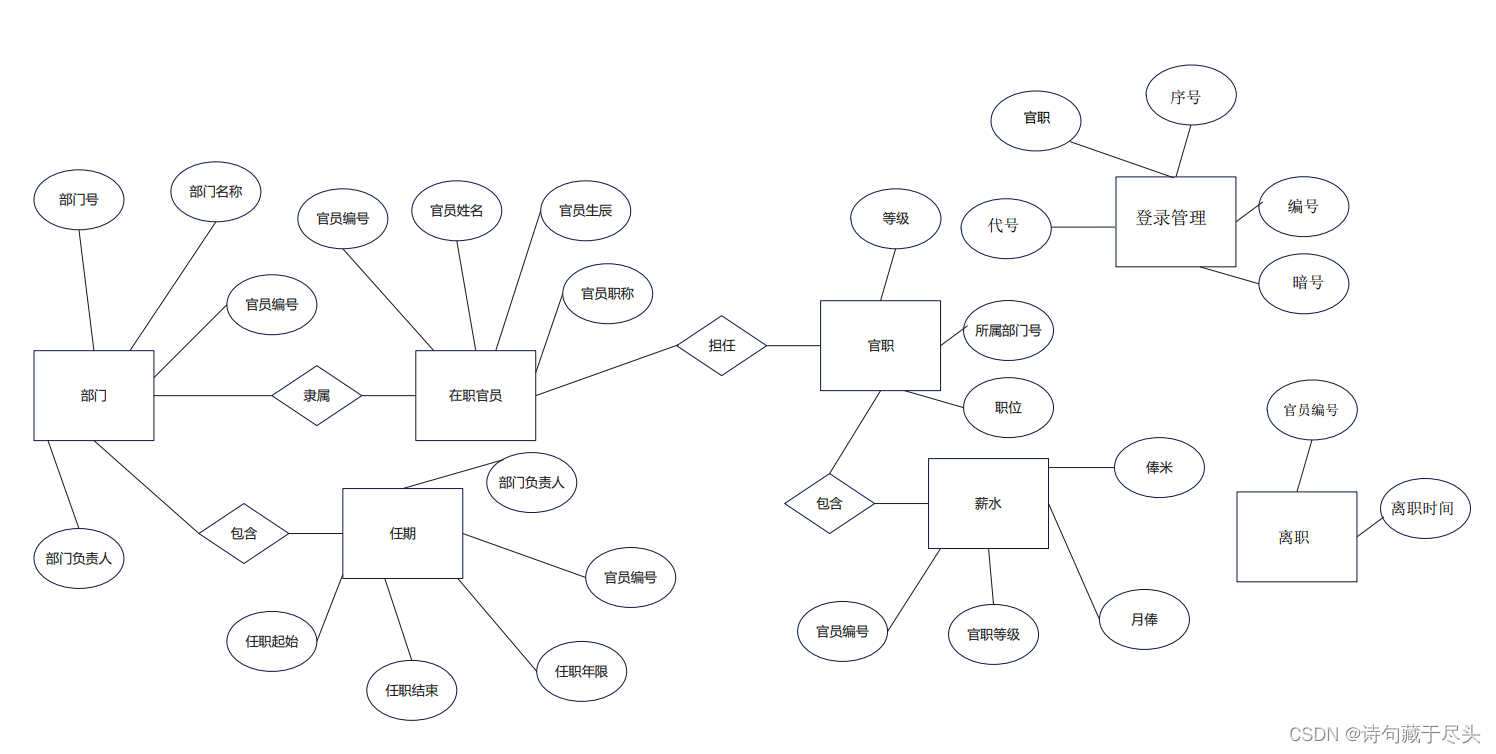

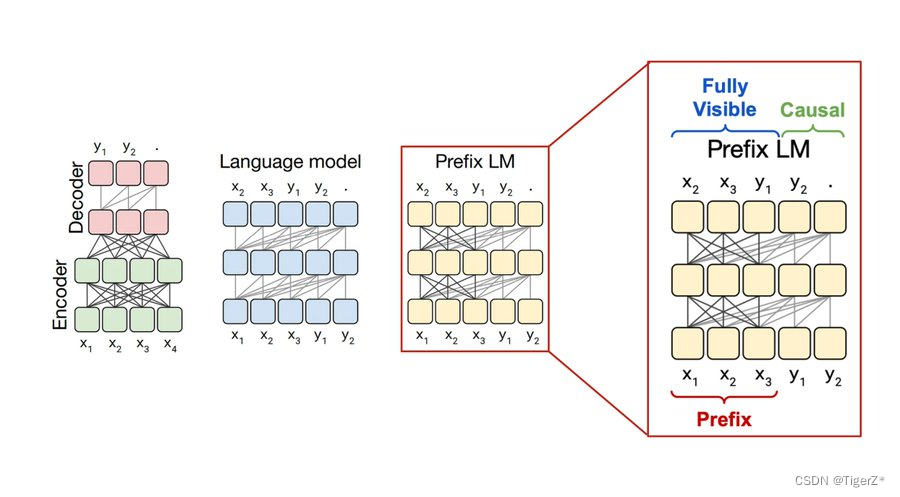

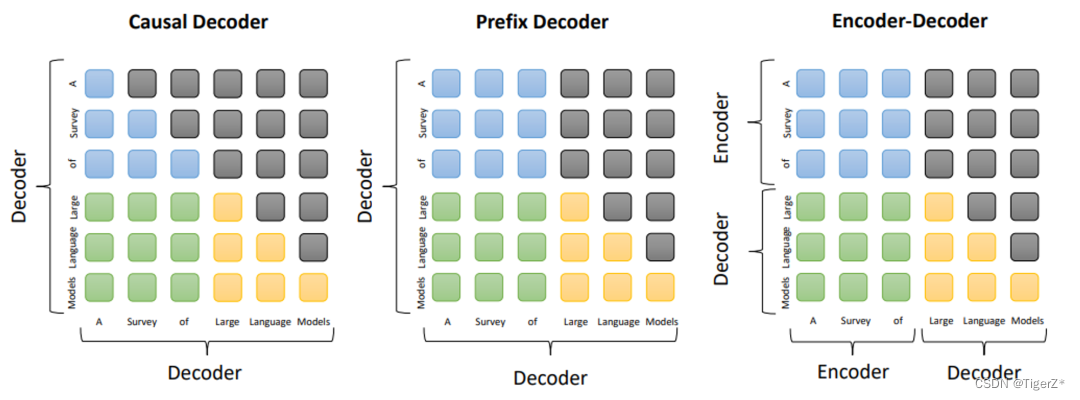

目前LLM(Large Language Model)主流结构包括三种范式,分别为Encoder-Decoder、Causal Decoder、Prefix Decode。对应的网络整体结构和Attention掩码如下图。

、

各自特点、优缺点如下:

1)Encoder-Decoder

结构特点:输入双向注意力,输出单向注意力。

代表模型:T5、Flan-T5、BART。

适用任务:在偏理解的 NLP 任务上效果好。

优点:在输入上采用双向注意力,对问题的编码理解更充分。

缺点:在长文本生成任务上效果差,训练效率低。

2)Causal Decoder

结构特点:从左到右的单向注意力。

代表模型:LLaMA1/2系列、LLaMA衍生物。