什么是大模型幻觉

在大语言模型的文本生成场景下,幻觉是指一本正经的胡说八道。逻辑连贯的自然表述中,有理论或者事实错误,捏造事实等问题。

幻觉问题的危害

LLM幻觉可能产生传播错误知识的后果。对于医疗应用中结果安全和可信AI尤为重要,幻觉影响了模型的可靠性和可信度。

幻觉一定有害吗

幻觉不在需要创造力的场景是有益处的,比如写电影剧本,图片创作,幻觉可以提升创作想象力,对于幻觉的容忍度取决于应用场景

为什么LLM会产生幻觉?

- 源和目标的差异:当我们在存在源与目标差异的数据集上训练模型时,模型产生的文本可能与原始的内容产生偏差。这种差异,有时可能是在数据收集过程中不经意产生的 ,也有可能是故意的,比如攻击。

- 无意识的源-目标差异:这种差异的原因可能有多种。例如数据可能事基于某种经验法则编制的,是的慕白哦信息并不总是完全依赖信息。e.g :如果两个不同网站获得 新闻时间作为目标和源,目标报道中可能包含源报道中没有的信息,从而导致二者的不同。

- 有意识的源-目标差异:某些任务在本质上并不追求源和目标的严格一直,尤其事在需要多样性输出的情景下。这种人为的设置更容易导致模型幻觉

- 训练数据重复:训练使用的数据如果存在大量重复,可能导致模型在生成时过于偏好某些高频词,权重增加,也可能导致偏好性幻觉

- 数据噪声的影响:使用有噪声或者脏数据进行训练,这是导致幻觉的关键因素之一。

- 解码过程中的随机性:增加输出多样性和生成能力扩展的解码策略,如top-k采样,top-p方法以及温度调节,有时会增加幻觉产生。着往往事因为模型在选择输出词时引入了随机性,没有始终选择最可能的词汇。

- 模型的参数知识偏向:模型在处理信息时,可能更依赖其在pretrain阶段所积累的知识,忽视了实时提供的上下文信息(prompt),从而偏离了正确的输出路径。

- 训练与实际应用中的解码差异:在一般训练场景下,模型会基于真实数据预测下一个词汇。但实际应用中。模型会根据先前生成内容进行后文预测。处理长文本的场景下更容易出现幻觉

幻觉类型和度量

幻觉不同类型

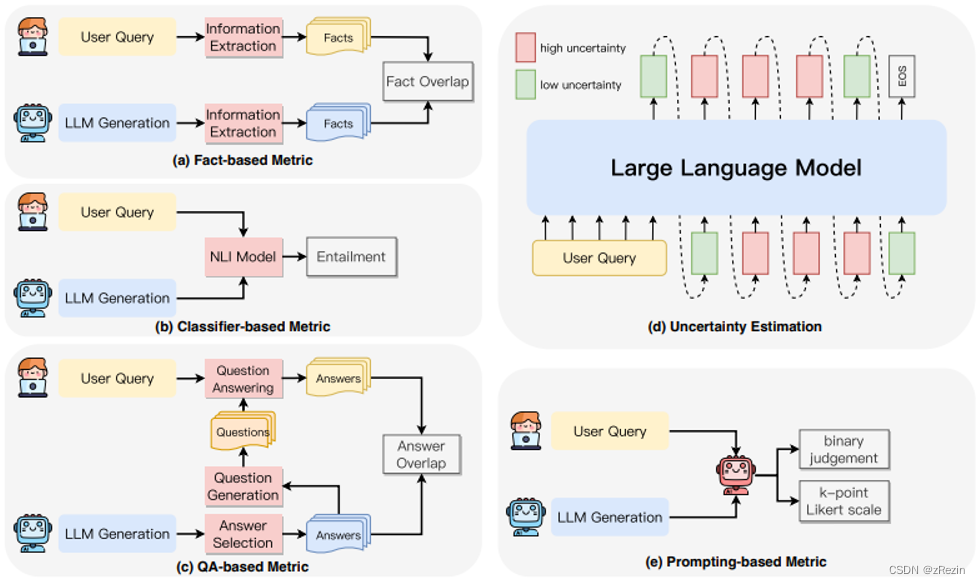

如何度量幻觉

何时最容易产生幻觉

幻觉解决方法

使用外部知识验证主动检测和缓解幻觉

事实核心采样

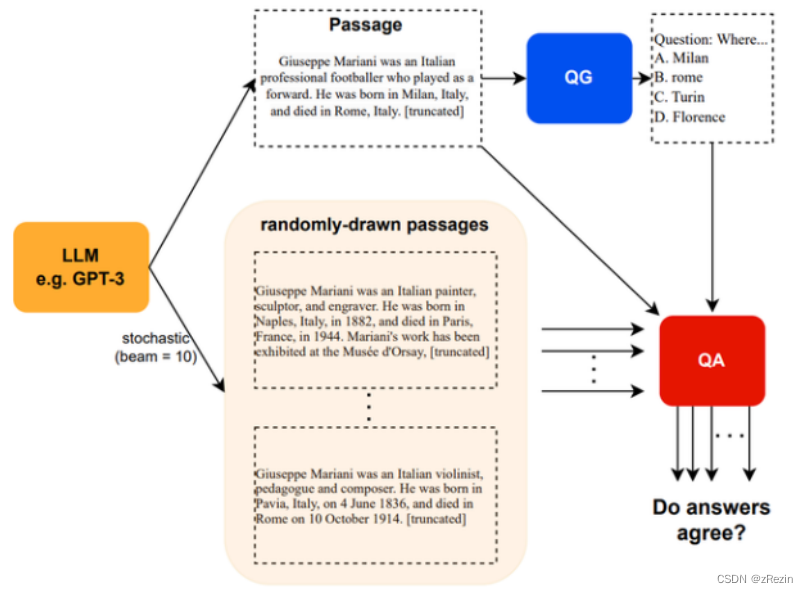

SelfCheckGPT

to be continued...

:DMS/OMS、CMS)

)

:柱状图(特点:渐变色、点击缩放、左右滑动、悬浮展示样式))