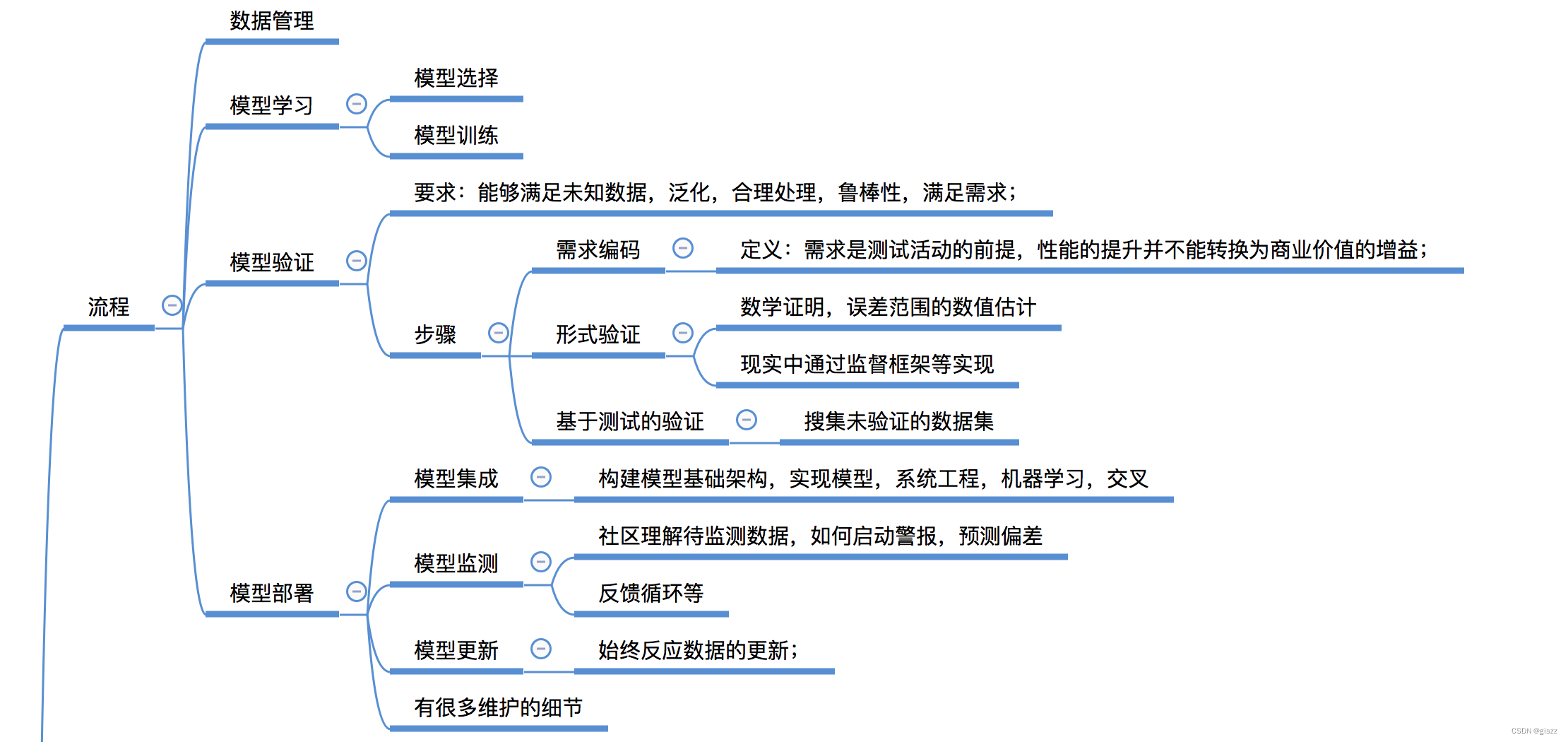

说是模型的维护,其实这堂课都是在讲“在工业环境中开发和部署机器学习模型的流程”。

上图来自于我的笔记思维脑图,已经上传,要链接的访问的主页查看资源。

一路走来,我们学习了数据管理、模型学习、模型验证、模型部署等重要的步骤。

其中模型学习,包括模型选择和模型训练。

模型验证,要求:能够满足未知数据,泛化,合理处理,鲁棒性,满足需求;

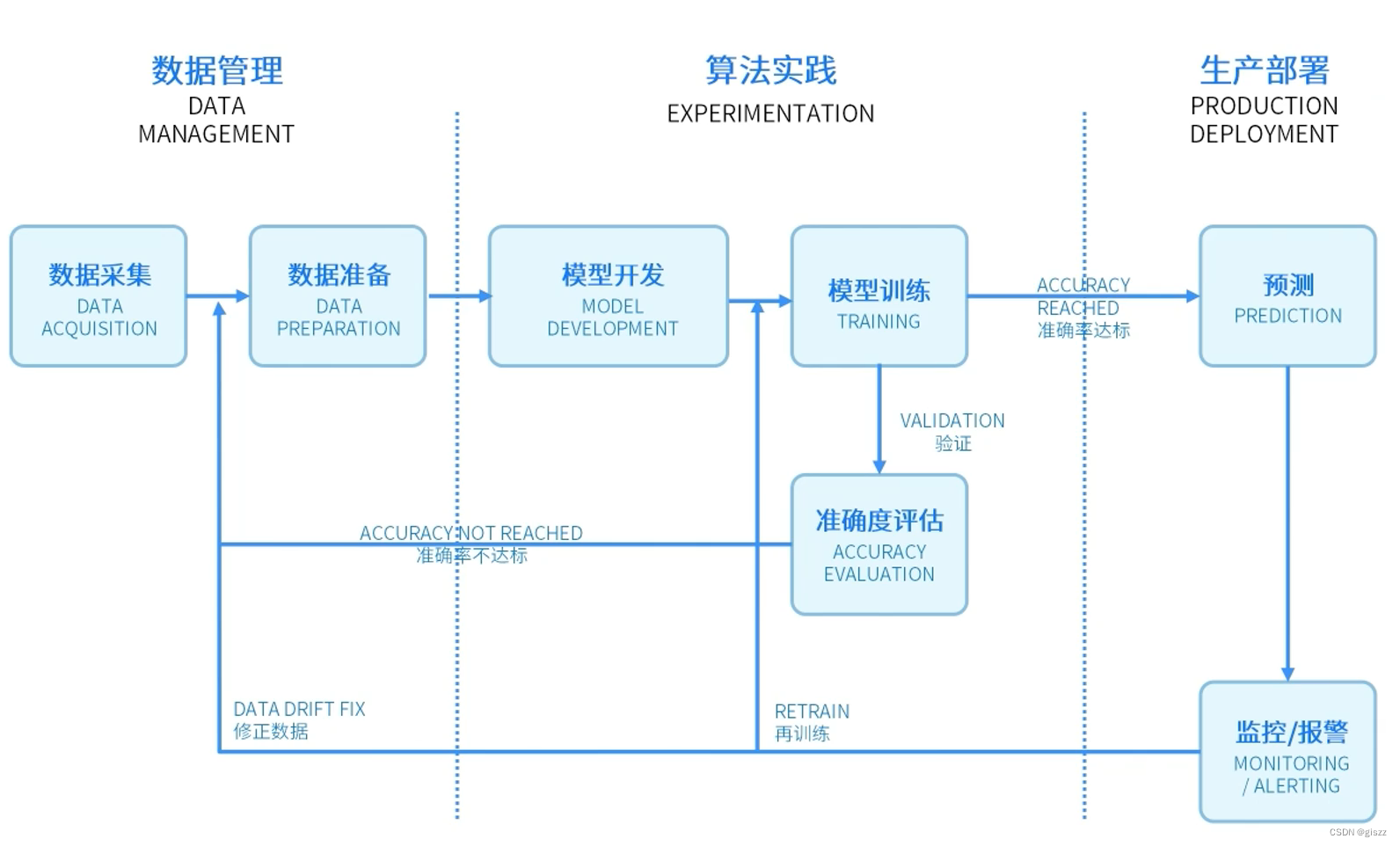

在人工智能项目中,数据管理、模型学习、模型验证和模型部署是构建和运营机器学习模型的核心步骤。每个步骤都有其独特的作用,包含一系列关键技术、细分步骤、理念和工具方法。以下是对这些步骤的详细阐述:

数据管理

关键技术:

- 数据清洗:去除重复、错误或不完整的数据。

- 数据转换:将数据转换成适合模型训练的格式。

- 数据标注:为监督学习提供标签。

- 数据存储:高效、安全地存储大量数据。

主要细分步骤:

- 数据收集:从各种来源(如数据库、API、文件等)获取原始数据。

- 数据预处理:清洗、转换、标准化数据,以准备训练数据集。

- 数据分割:通常将数据分割为训练集、验证集和测试集。

- 数据版本控制:跟踪数据的变化,以便能够重现实验结果。

理念:

- 数据质量至关重要:高质量的数据是训练出高性能模型的基础。

- 数据应代表实际场景:训练数据应尽可能反映模型将面对的真实世界情况。

工具和方法:

- 使用Pandas、SQL等工具进行数据清洗和转换。

- 利用DVC、Git LFS等进行数据版本控制。

- 应用数据湖、数据仓库等解决方案进行数据存储和管理。

模型学习

关键技术:

- 算法选择:根据问题类型(分类、回归、聚类等)选择合适的机器学习算法。

- 超参数调优:调整模型参数以优化性能。

- 损失函数:定义模型训练过程中的优化目标。

- 优化器:选择如梯度下降等算法来最小化损失函数。

主要细分步骤:

- 模型设计:基于业务理解和数据特征构建模型结构。

- 训练模型:使用训练数据集进行模型训练。

- 模型评估:在验证集上评估模型性能。

- 模型调整:根据评估结果调整模型结构或参数。

理念:

- 简洁性优先:在保持性能的同时,尽量简化模型以减少过拟合的风险和提高可解释性。

- 持续学习:随着新数据的到来,模型应能够适应新的知识和模式。

工具和方法:

- 利用TensorFlow、PyTorch等深度学习框架进行模型设计和训练。

- 使用Scikit-learn等机器学习库进行传统机器学习模型的构建。

- 应用网格搜索、随机搜索或贝叶斯优化等方法进行超参数调优。

模型验证

关键技术:

- 交叉验证:评估模型在不同数据集上的泛化能力。

- 性能指标:根据业务需求选择合适的评估指标(如准确率、召回率、F1分数等)。

- 模型稳定性:检查模型在不同运行或不同数据分割下的性能一致性。

- 偏差和方差分析:诊断模型性能不足的原因。

主要细分步骤:

- 性能度量:在独立的测试集上评估模型性能。

- 错误分析:检查模型预测错误的案例以理解其局限性。

- 对比实验:与其他模型或基线进行比较以验证优越性。

- 模型解释性:使用如SHAP、LIME等工具理解模型决策依据。

理念:

- 信任但验证:即使模型在训练数据上表现良好,也需要在未见过的数据上进行验证。

- 透明性和可解释性:模型应能够提供其决策的合理解释。

工具和方法:

- 使用模型评估库如MLflow、Neptune等进行实验跟踪和性能比较。

- 应用统计测试来验证模型性能的提升是否显著。

- 利用模型解释性工具进行模型决策的可视化和理解。

模型部署

关键技术:

- 模型序列化:将训练好的模型转换为可部署的格式。

- 模型服务:构建API或Web服务以提供模型预测功能。

- 容器化:使用Docker等技术将模型及其依赖项打包为容器。

- 自动化部署:通过CI/CD流程自动将模型部署到生产环境。

主要细分步骤:

- 模型导出:将模型从训练环境导出为可部署格式(如TensorFlow SavedModel、ONNX等)。

- 环境准备:设置生产环境的硬件和软件依赖。

- 部署模型:将模型部署到生产服务器或云平台上。

- 监控与维护:实时监控模型性能并进行必要的维护。

理念:

- 可靠性与稳定性至关重要:生产环境中的模型必须能够持续、稳定地提供服务。

- 快速响应和弹性扩展:模型应能够迅速适应流量变化并弹性扩展资源。

工具和方法:

- 利用TensorFlow Serving、TorchServe或自定义服务框架进行模型服务化。

- 使用Docker和Kubernetes进行容器化部署和管理。

- 应用监控工具如Prometheus、Grafana以及日志分析工具进行实时性能监控和故障排查。

以上内容,在前面的笔记中,都有提到,欢迎关注,到我的主页查看。

真题讲解每日一题:《字典字符查找》)

![[项目设计] 从零实现的高并发内存池(一)](http://pic.xiahunao.cn/[项目设计] 从零实现的高并发内存池(一))

)

)

)

:Geometry函数)