Gemini 1.5具有100万token的上下文理解能力,是目前最强!具有跨模态理解和推理:能够对文本、代码、图像、音频和视频进行高度复杂的理解和推理。允许分析1小时视频、11小时音频、超过30,000行代码或超过700,000字的文本。不过谷歌这个Gemini 1.5和OpenAI的Sora比简直弱爆了啊。

Gemini 1.5详细介绍链接:

Introducing Gemini 1.5, Google's next-generation AI model

AIGC专区:

aigc

AI工具专区:

+AI工具-喜好儿aigc

Gemini 1.5版本更新内容:

- 性能优化显著:Gemini 1.5在多个维度上都展现出了卓越的性能提升,特别是在处理冗长上下文信息方面取得了显著突破。它能够连续处理高达100万个标记(tokens),这一能力使其成为迄今为止所有大型基础模型中拥有最长上下文窗口的佼佼者。

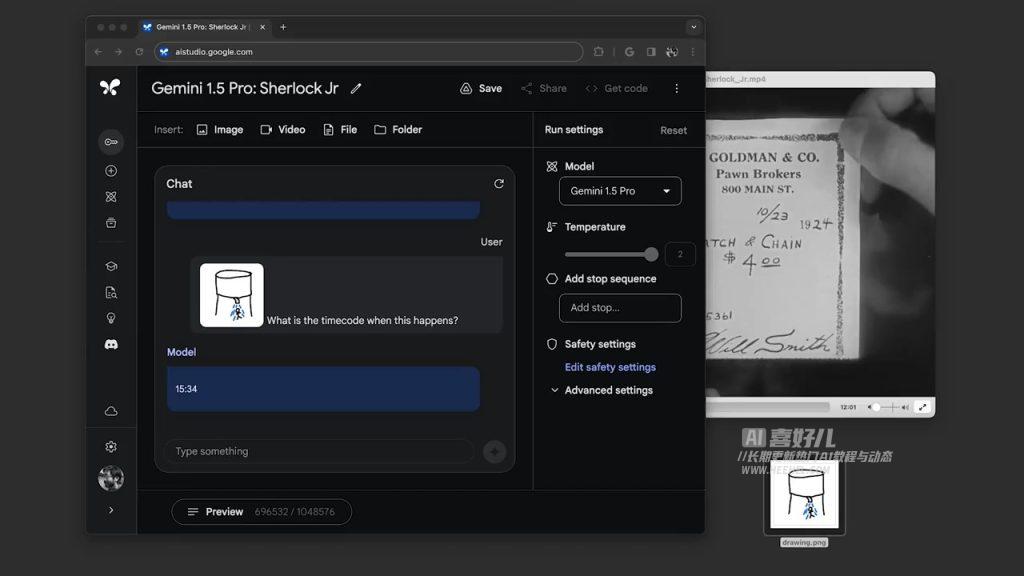

- 高效模型架构:Gemini 1.5采纳了全新的Mixture-of-Experts(MoE)架构,使模型在训练和提供服务时更加高效。与此同时,该模型在维持与1.0 Ultra模型相当的质量水平的同时,显著降低了计算需求。

- 强大的长上下文处理能力:Gemini 1.5的长上下文窗口特性使其能够轻松应对大量信息的处理和分析挑战。无论是1小时的视频、11小时的音频、超过30,000行代码的代码库,还是超过700,000字的文本,Gemini 1.5都能游刃有余地处理。

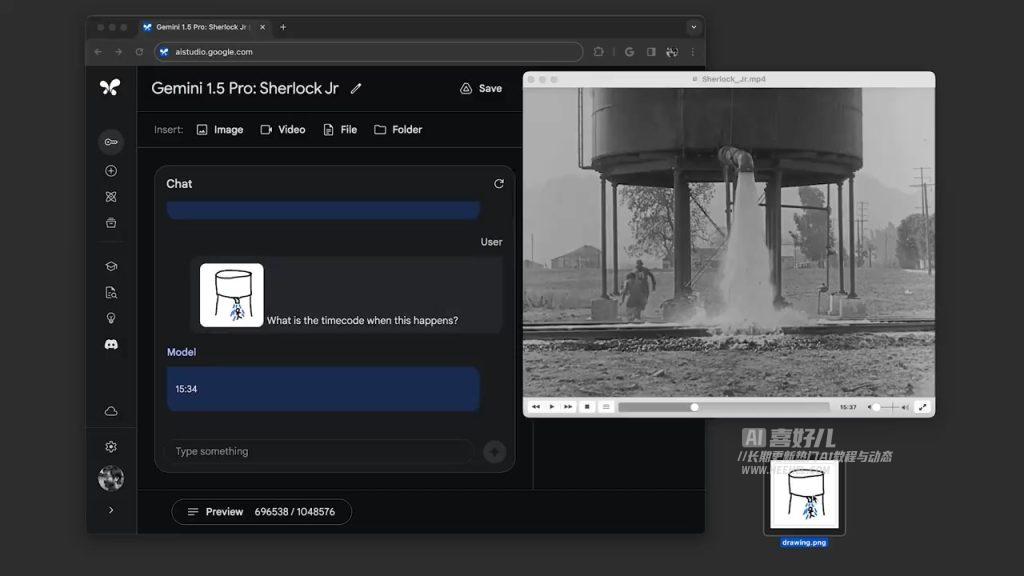

- 跨模态理解和推理能力:Gemini 1.5展现了卓越的多模态内容理解和推理能力,能够处理和分析不同模态的内容,包括文本、代码、图像、音频和视频等。例如,它能够分析长达44分钟的默片,并精准捕捉情节要点和细节。

- 性能卓越:在综合评估面板上,Gemini 1.5 Pro在87%的基准测试中表现出色,超越了1.0 Pro的表现。与1.0 Ultra相比,Gemini 1.5 Pro在相同的基准测试中展现出了相当的性能水平,充分证明了其卓越的增强性能。

工作原理:

- MoE技术:Gemini 1.5采用MoE技术,将模型分解为小型“专家”网络。这种分解允许模型根据输入类型选择性地激活相关专家,从而提高效率。

- 强大处理能力:Gemini 1.5通过机器学习创新,能处理大量信息,为开发者和企业提供新能力。其长上下文窗口特别适用于深度文档分析、视频理解、代码分析和多模态数据融合等复杂场景。

(A B C))

)

Java 之 String 类)

)

)