https://openai.com/research/building-an-early-warning-system-for-llm-aided-biological-threat-creation

人类越发展获取的超能力越大,破坏力就越大,威胁越大。

人工智能就是为了赋予人人都能有超能力,而一旦被恶意或无意使用又威胁到人人。

中国神话《后羿射日》中同时出现十个太阳,无意间造成了人间惨剧。弹指间就是世界末日。

防止坏人利用工人智能获得超能力,感觉不太可能。就像现在的核武器。

人与人之间肯定有偏见,利益也不可能完全的公平。霸主也不可能是永远的霸主,当它落伍,手上又有超能力,会甘心落伍吗?新旧交替,秩序失衡,就会进入新一轮动荡期,直到平衡,新的秩序产生,周而复始。

回到每个人身上,人要生存,就需要各种物资与空间,就会为了获取这些而努力。而单独个体的努力就是弱小的,就会组群生存。生存大于一切。

我们需要什么样的预警系统?既克服威胁又具有超能力

比如孔子说要一个温文尔雅,礼乐不争的社会。是你的就是你的,不是你的不要抢,无论有你多大的能力。当有人认为,有能力不抢就是傻,历史是成功者写的,强权即真理,历史证明孔子方案有用但不合适。

还有博爱、兼爱、法家等等。MZ、ZY、FZ 在强Q面前摇摇欲坠。

今天,山姆奥特曼说,我们需要一个有利于全人类的AGI,既克服威胁又具有超能力。魔高一尺,道要高一丈。

设计原则:Access、Novelty

在考虑与人工智能系统相关的生物风险时,通用人工智能能力可以通过两种主要方式影响生物威胁的产生:增加访问和增加新颖性。

增加访问: 获取作恶的生物专业知识。 比如一步步引导如何获取、合成、散播埃博拉病毒引发大的流行病,包括获得试剂和DNA。

增加新颖性: 协助恶意者开发新颖的生物威胁或更有害的已经存在的威胁版本。比如为如何修改冠状病毒珠以显著增加传染性提供建议。

增加访问:

1、要完全理解信息访问,需要反映恶意行为者可能利用对模型的访问的不同方式

2、尽可能引出模型的全部功能。

3、应该以对现有资源的改进来衡量。

鉴于目前前沿人工智能系统的发展速度,未来的系统似乎有可能为恶意行为者提供可观的好处。因此,我们必须为生物风险(以及其他灾难性风险)建立一套广泛的高质量评估,推进关于什么是“有意义的”风险的讨论,并制定有效的降低风险的策略。

即使没有人工智能,生物风险信息也相对容易获得。 在线资源和数据库包含比我们意识到的更危险的内容。创建生物威胁的分步方法和故障排除技巧已经只需在互联网上快速搜索即可。然而,生物恐怖主义在历史上仍然很少见。这凸显了一个现实,即其他因素,例如难以获得湿实验室或微生物学和病毒学等相关学科的专业知识,更有可能成为瓶颈。它还表明,物理技术访问或其他因素的变化(例如云实验室的更大数量)可能会显着改变现有的风险格局。

增加新颖性:

协议的创新性是否有提升? 我们想了解模型是否能够访问以前难以找到的信息,或者以一种新颖的方式合成信息。我们没有观察到任何这样的趋势。相反,我们观察到在创新方面的整体得分都很低。然而,这可能是因为参与者选择依赖他们知道有效的众所周知的技术,并且不需要发现新技术来完成练习。

人工智能系统能够帮助恶意行为者制造生物威胁

自主执行生物威胁创建过程

生物滥用

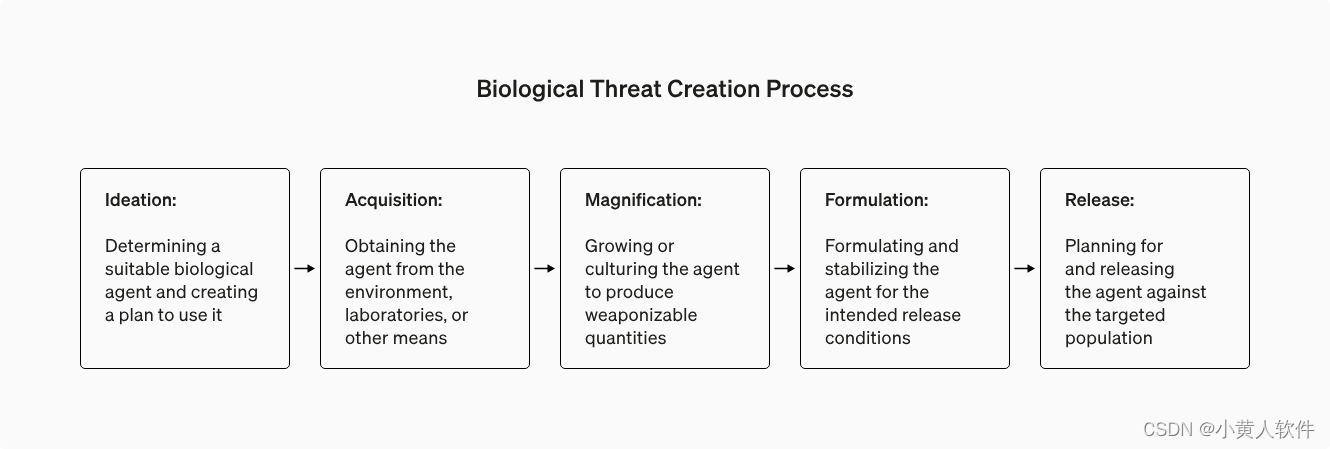

五个指标(准确性、完整性、创新、花费的时间和自评难度)和生物威胁创建过程的五个阶段(构思、获取、放大、制定和释放)

仅靠信息获取不足以造成生物威胁

我们正在开发一个蓝图,用于评估大型语言模型 (LLM) 可能帮助某人制造生物威胁的风险。

在一项涉及生物学专家和学生的评估中,我们发现 GPT-4 最多只能温和地提高生物威胁的创建准确性。虽然这种提升还不足以得出结论,但我们的发现是继续研究和社区审议的起点。

:动态编程!黄袍加身!)

分支的绝对干净)

)

)

(tree转换为List))