在写论文时,设计高效、创新的卷积块可以显著提升模型的性能,保障工作的有效性和先进性。另外,合理利用卷积块还可以帮助我们提升实验结果、拓展研究的视野和应用场景,增加论文的创新点。因此,对于论文er来说,掌握卷积块的设计和应用,对于撰写高质量的学术论文必不可少。

今天学姐就来分享涨点必备的9个卷积块,包含2024年最新,这些卷积块的来源文章以及代码学姐都整理了,还帮同学们罗列了创新点,更详细的工作细节还是建议各位仔细阅读原文。

论文和模块代码需要的同学看文末

1.Efficient Deformable ConvNets: Rethinking Dynamic and Sparse Operator for Vision Applications

涨点神器!DCNv4:新一代高效的可变形卷积

方法:DCNv4是一种高效的动态和稀疏操作符。通过重新思考可变形卷积的动态特性并简化内存访问,DCNv4比其前身DCNv3更快、更有效。DCNv4配备的FlashInternImage骨干网络不仅提高了速度,还改善了各种视觉任务的性能。作者还展示了DCNv4作为通用操作符的多功能性和有效性,将其集成到ConvNeXt和ViT等最先进的架构中,提高了吞吐量和准确性;它在潜在扩散模型中也表现良好,显示出增强生成模型的潜力。

创新点:

-

DCNv4是一种高效的动态和稀疏操作符,通过重新思考可变卷积的动态特性和简化内存访问,比其前身DCNv3更快更有效。

-

DCNv4在FlashInternImage骨干网络中的应用不仅提高了速度,还改善了各种视觉任务的性能。

-

DCNv4通过将其集成到ConvNeXt和ViT等先进架构中,提高了吞吐量和准确性,同时在潜在扩散模型中也表现良好,展示了其增强生成模型的潜力。

2.CoordGate: Efficiently Computing Spatially-Varying Convolutions in Convolutional Neural Networks

CNN涨点神器!CoordGate:计算空间变化卷积

方法:CoordConv在卷积之前将坐标附加到数据上,而CoordGate则通过一个编码器网络将坐标传递,并通过乘法门应用于卷积后的数据,类似于通道注意机制中的门控。这种技术能够根据空间位置选择性地放大或衰减滤波器,并且相比现有的CNNs,它提供了大幅度的效率提升。

创新点:

-

CoordGate是一种新颖的轻量级模块,通过使用乘法门和坐标编码网络,实现了在CNN中高效计算空间变化卷积的功能。

-

CoordGate可以根据空间位置选择性地放大或衰减滤波器,有效地像本地连接的神经网络一样工作。

-

CoordGate在U-Net中的应用表明,它在图像去模糊等各种计算机视觉应用中优于传统方法,提供了更强大和空间感知的解决方案。

3.Run, Don't Walk: Chasing Higher FLOPS for Faster Neural Networks(cvpr2023)

即插即用:部分卷积,减少冗余计算和内存访问,更有效地提取空间特征

方法:论文介绍了PConv和FasterNet这两种快速有效的神经网络模型。PConv是一种设计用于仅对部分输入通道应用常规卷积的方法,而保持其余通道不变。而FasterNet则是基于卷积算子构建的网络模型,其感受野可能有限。论文还提到了这两种模型的一些技术限制,如PConv的部分卷积步长必须为1,以保持卷积输出和未触及通道的空间分辨率一致。

创新点:

-

作者提出了一种简单而快速有效的算子PConv,可以解决DWConv的内存访问频繁的问题,并且可以轻松地插入到许多现有的网络中。

-

作者引入了FasterNet,它在GPU、CPU和ARM处理器等各种设备上都能运行得非常快速和普遍。

-

作者的PConv和FasterNet在速度和准确性方面与现有的算子和网络相比具有竞争力,但仍有一些技术上的限制,可以通过扩大感受野和与其他算子结合来追求更高的准确性。

4.SCConv: Spatial and Channel Reconstruction Convolution for Feature Redundancy

涨点神器!SCConv:即插即用的空间和通道重建卷积

方法:本文研究了深度神经网络中存在的冗余问题,并提出了一种新的CNN压缩方法,称为SCConv(Spatial and Channel reconstruction Convolution),旨在减少参数和计算量而不损失性能。SCConv模块由两个单元组成,即空间重构单元(SRU)和通道重构单元(CRU),可以嵌入到各种架构中。

创新点:

-

提出了一种通道重构单元,称为CRU,它利用分割-变换-融合策略来减少通道维度中的冗余以及计算成本和存储。

-

设计了一个两步骤的过程来利用中间特征图的冗余,目的是减少参数和计算量而不损失性能。为此,作者提出了一种新颖的CNN压缩方法,即SCConv(空间和通道重构卷积),它由两个单元组成,即空间重构单元(SRU)和通道重构单元(CRU)。

5.Omni-Dimensional Dynamic Convolution

即插即用的动态卷积ODConv

方法:作者介绍了一种名为Omni-dimensional Dynamic Convolution(ODConv)的新型动态卷积设计,旨在提升深度卷积神经网络(CNN)的表示能力。ODConv利用多维注意机制,在卷积核空间的四个维度上学习四种类型的注意力,并以并行方式逐步应用这些注意力到相应的卷积核上,从而显著增强CNN的基本卷积操作的特征提取能力。

创新点:

-

作者的首要创新贡献是一种更加通用且优雅的动态卷积设计,称为全维动态卷积(ODConv)。

-

ODConv利用一种多维注意机制,在卷积核空间的四个维度上学习四种类型的注意力,并以并行方式逐渐应用于相应的卷积核,从而大大增强了CNN基本卷积操作的特征提取能力。

-

ODConv即使只使用一个单一的卷积核,也能与现有的具有多个卷积核的动态卷积方法竞争或超越,从而大大减少了额外的参数。

6.KernelWarehouse: Towards Parameter-EffcientDynamic Convolution

让ResNet/MobileNet/ConvNeXt等Backbone一起涨点

方法:本文介绍了KernelWarehouse,一种改进现代ConvNets性能的动态卷积方法。研究结果表明,在KernelWarehouse中增强更多核心单元之间的仓库共享通常会导致更好的性能。

创新点:

-

不同维度的卷积核之间的仓库共享。作者在主流的卷积神经网络设计中,一个卷积块通常包含多个具有不同维度(k × k × c × f)的卷积核。作者通过对ResNet50骨干网络进行实验,探索了在卷积块中不同维度的卷积核之间进行仓库共享的效果。

-

ConvNeXt-Tiny中KernelWarehouse的设计细节。对于ConvNeXt骨干网络,作者将KernelWarehouse应用于所有的卷积层。在每个阶段中,相应的三个仓库分别共享给逐点卷积层、深度卷积层和下采样层。作者使用最大公约数维度除数作为静态卷积核的统一核单元维度进行核分区。

7.REFCONV: RE-PARAMETERIZED REFOCUSING CONVOLUTION FOR POWERFUL CONVNETS

重参数化重聚焦卷积替代常规卷积,无额外推理成本下涨点明显

方法:论文介绍了一种名为Re-parameterized Refocusing Convolution(RefConv)的重新参数化方法,通过在卷积核参数之间建立额外的连接来增强现有模型结构的先验知识。RefConv作为一种插拔式模块,可以在不改变原始模型结构或引入额外推理成本的情况下显著提高各种CNN在多个任务上的性能。此外,通过展示RefConv减少通道冗余和平滑损失函数的能力,论文解释了RefConv的有效性,这可能会激发进一步的训练动态理论研究。

创新点:

-

提出了Re-parameterized Refocusing,通过与学习的卷积核建立连接来增强现有结构的先验。因此,重新参数化的卷积核可以学习更多样化的表示,从而进一步提高训练的CNN的表示能力。

-

证明了RefConv可以减少通道冗余和平滑损失函数,从而解释了其有效性。

8.UniRepLKNet: A Universal Perception Large-Kernel ConvNet for Audio, Video, Point Cloud, Time-Series and Image Recognition

ImageNet88%,顺手统一多模态SOTA大核卷积江湖

方法:本文探讨了大卷积核ConvNet架构,重新思考了传统模型设计中使用深度堆叠小卷积核的方法。通过将3×3卷积添加到小卷积核ConvNet中,我们期望同时产生三个效果:1)扩大感受野,2)增加空间模式的抽象层次(例如从角度和纹理到物体形状),3)通过增加深度改进模型的一般表示能力,引入更多可学习的参数和非线性。

本文还介绍了一种基于块设计的架构指导原则,即使用既能进行通道间通信又能进行空间聚合的高效结构来增加深度。通过在模型中插入一些结构来普遍提升模型的表示能力,包括非线性和高效的可训练变换。

创新点:

-

作者通过调整深度和宽度来构建UniRepLKNet模型,该模型在速度和准确性方面都表现出色。

-

经过ImageNet-22K预训练后,UniRepLKNet-S的准确性甚至接近RepLKNet-31L,并且比后者运行速度快3倍。

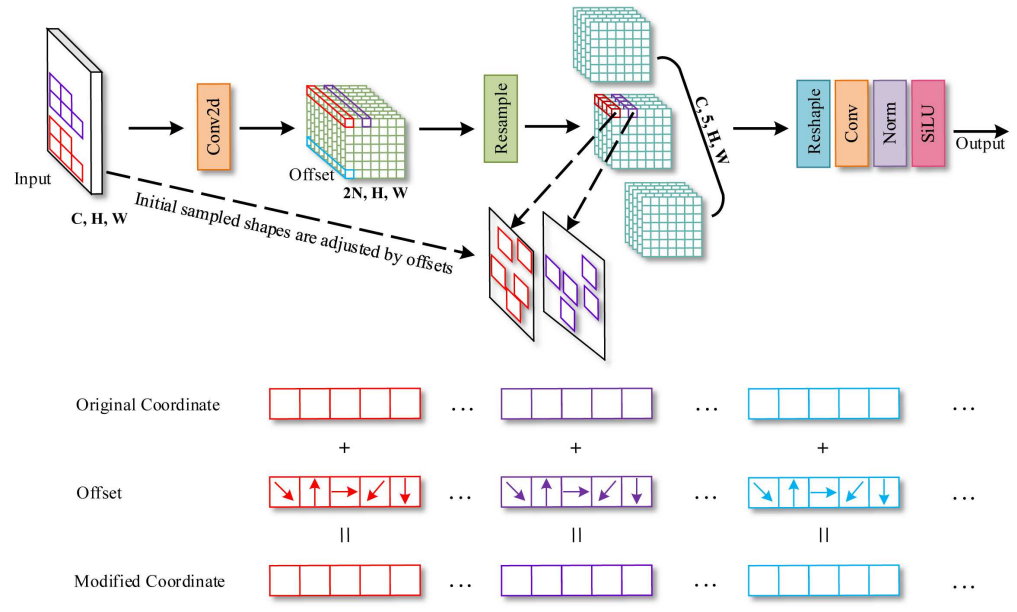

9.AKConv: Convolutional Kernel with Arbitrary Sampled Shapes andArbitrary Number of Parameters

即插即用的卷积操作来替代常规卷积操作以提高网络性能

方法:本文提出了一种名为AKConv的卷积操作,可以实现任意样本形状和大小的卷积核,从而提供了卷积核选择的多样性。通过在YOLOv5、YOLOv7和YOLOv8等模型上进行目标检测实验,验证了AKConv的优势。

创新点:

-

为不同大小的卷积核提供了一种生成初始采样坐标的算法。

-

通过调整不规则卷积核的采样位置,适应目标的不同变化。

-

AKConv设计了多种初始采样形状,可以实现任意采样形状的卷积核操作。

关注下方《学姐带你玩AI》🚀🚀🚀

回复“卷积块”获取论文+模块代码

码字不易,欢迎大家点赞评论收藏

)

)