2023年真是文生图大放异彩的一年,给数字艺术界和创意圈注入了新鲜血液。从起初的基础图像创作跃进到现在的超逼真效果,这些先进的模型彻底变革了我们制作和享受数字作品的途径。

最近,一些大公司比如华为、谷歌、还有Stability AI等人工智能巨头也没闲着,纷纷推出了自己的最新文生图模型。

今天就给大家盘点一下近期新推出的文生图模型,为了让各位更全面地理解这些技术,我还特别准备了相关的研究论文和代码分享!

1、PanGu-Draw(华为)

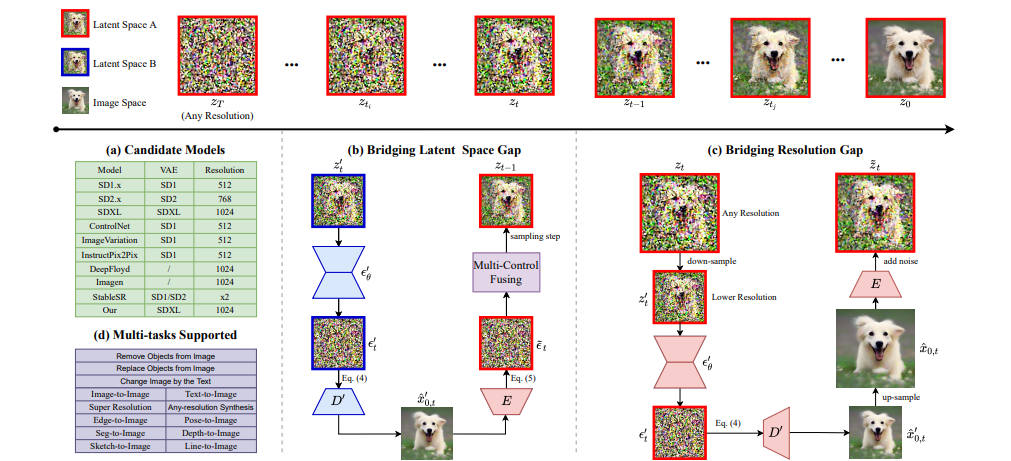

论文:PanGu-Draw: Advancing Resource-Efficient Text-to-Image Synthesis with Time-Decoupled Training and Reusable Coop-Diffusion

PanGu-Draw:通过时间解耦训练和可重用 Coop-Diffusion 推进资源节约型文本到图像合成

简述:本文提出了PanGu-Draw,一种高效的文本到图像潜在扩散模型,能适应多控制信号。该模型采用时间解耦训练策略,分为结构器和纹理器,大幅提升数据和计算效率。同时,研究人员引入Coop-Diffusion算法,允许不同潜在空间和分辨率的模型协同工作,无需额外数据或重新训练。PanGu-Draw在文本到图像和多控制图像生成上表现出色,指向了训练效率和生成多功能性的新方向。

2、Imagen & Imagen 2(谷歌)

论文:Photorealistic Text-to-Image Diffusion Models with Deep Language Understanding

具有深度语言理解的逼真文本到图像扩散模型

简述:本文提出了Imagen,一款新型的文本到图像扩散模型,实现了极高的真实感和深度语言理解。该模型结合了大型Transformer语言模型和扩散模型的技术,优化了语言模型的大小以提高图像质量和文本对齐。在COCO数据集上,Imagen取得了领先的FID分数,且其样本的图像-文本对齐得到了人类评分者的好评。研究人员还引入了DrawBench基准测试,比较了Imagen与其他最新方法,发现其在样本质量和图像文本对齐方面更优秀。

3、SDXL Turbo(Stability AI)

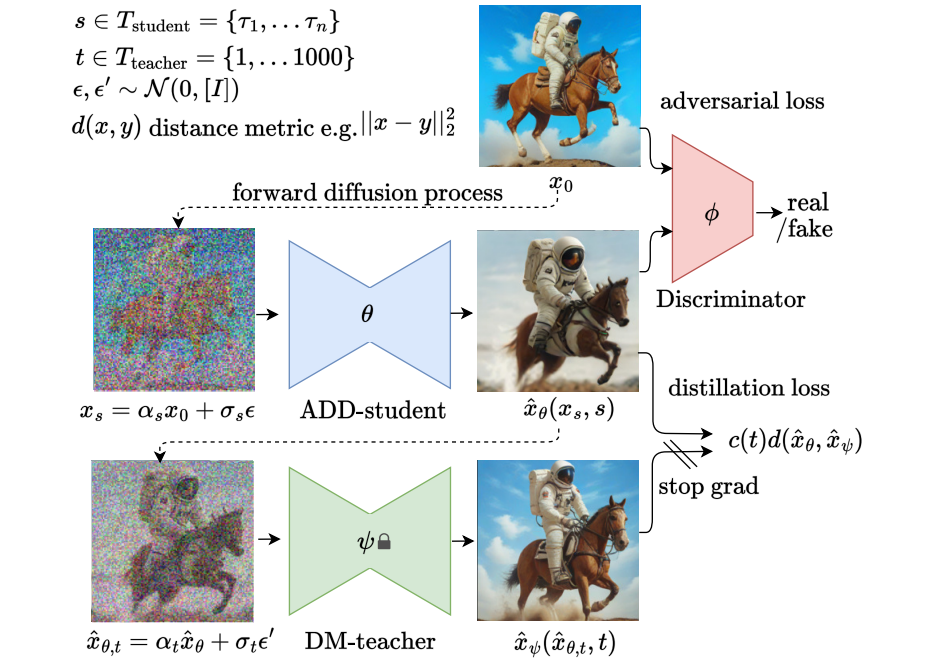

论文:Adversarial Diffusion Distillation

对抗性扩散蒸馏

简述:本文提出了SDXL Turbo,它在 SDXL 1.0 的基础上进行迭代,并为文本到图像模型实现了一种新的蒸馏技术:对抗扩散蒸馏(ADD),能够高效地从大规模基础图像扩散模型中采样,同时保持高质量图像。该模型在一步中明显优于现有几步方法,并在四步内达到最先进扩散模型的性能。ADD 是首个使用基础模型实现单步实时图像合成的方法。

4、CM3Leon(Meta)

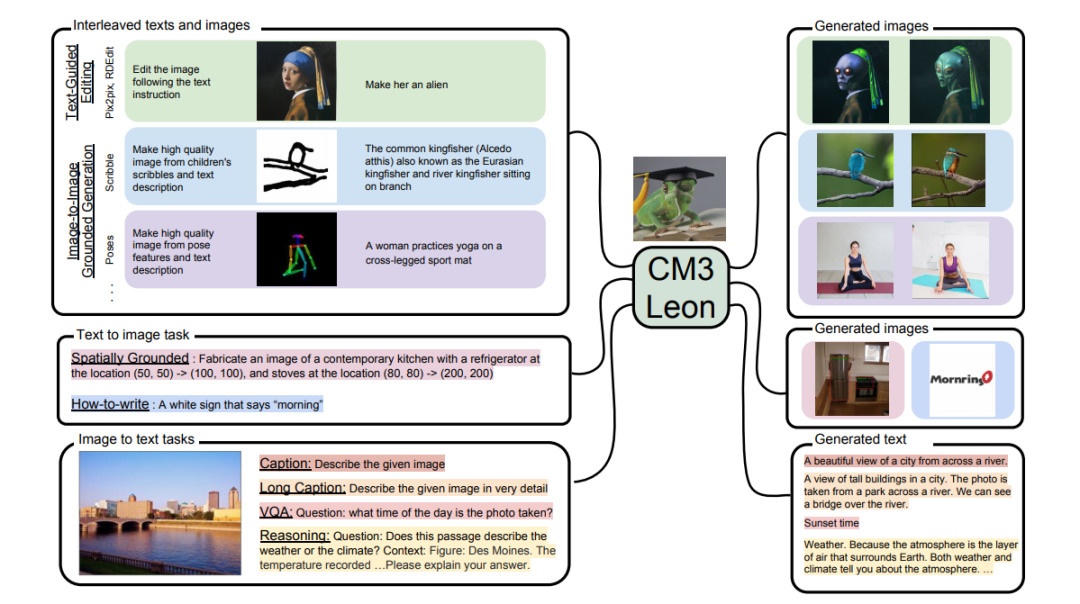

论文:Scaling Autoregressive Multi-Modal Models: Pretraining and Instruction Tuning

扩展自回归多模态模型:预训练和指令调优

简述:本文提出了CM3Leon,一种多模态语言模型,擅长生成和填充文本和图像。它是首个采用纯文本语言模型训练方法的多模态模型,包括大规模检索增强预训练和多任务监督微调阶段。CM3Leon在文本到图像生成上实现了领先性能,计算量比同类方法少5倍。此外,CM3Leon在图像编辑和控制生成等任务中展现出前所未有的可控性。

5、PixArt-α(华为诺亚方舟实验室联合大连理工大学、香港大学、香港科技大学等机构)

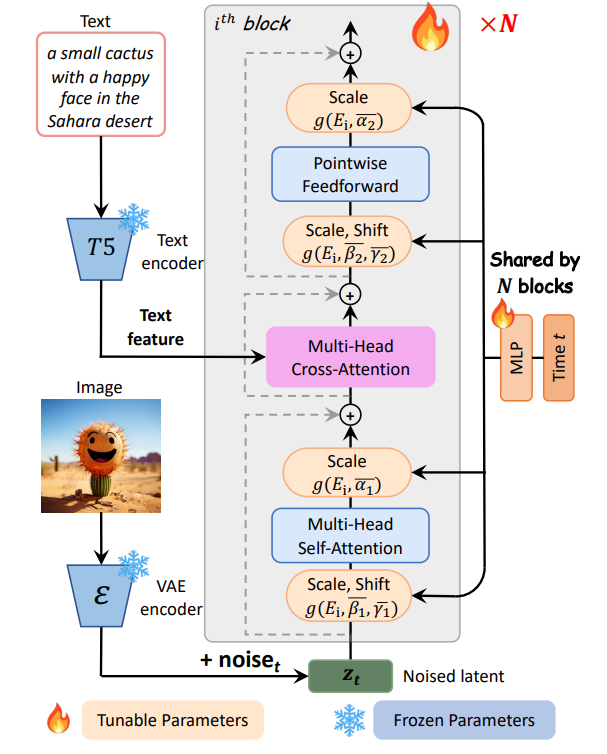

论文:PixArt-α: Fast Training of Diffusion Transformer for Photorealistic Text-to-Image Synthesis

PixArt-α:快速训练扩散变压器,实现逼真的文本到图像合成

简述:本文提出了PixArt-α,一种高效的基于Transformer的文本转图像模型,它能以较少的训练资源生成与最先进模型相媲美的商业级图像。PixArt-α采用三种策略:优化的训练步骤、高效的Transformer架构和增强的数据处理,实现了快速、低成本且环保的训练过程。实验结果显示,PixArt-α在多个方面表现出色,为AIGC领域提供了新的创新方向。

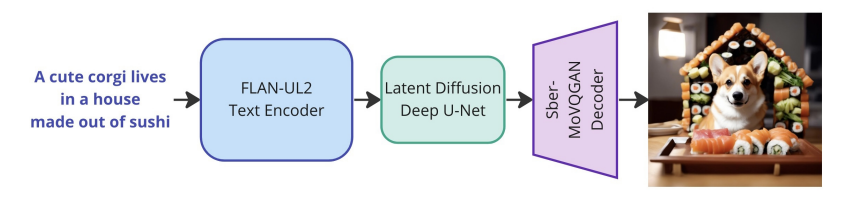

6、Kandinsky 3.0(俄罗斯AI Forever研究团队)

论文:Kandinsky 3.0 Technical Report

Kandinsky 3.0 技术报告

简述:本文提出了Kandinsky 3.0,一个基于潜在扩散的大规模文本到图像生成模型,旨在提高图像生成的质量和真实性。该模型通过使用更大的U-Net主干网和文本编码器以及去除扩散映射进行改进。文中详细介绍了模型的架构、训练过程和生产系统,并强调了关键组件对提升模型质量的重要性。实验表明,Kandinsky 3.0在文本理解和特定领域表现上有所提升。

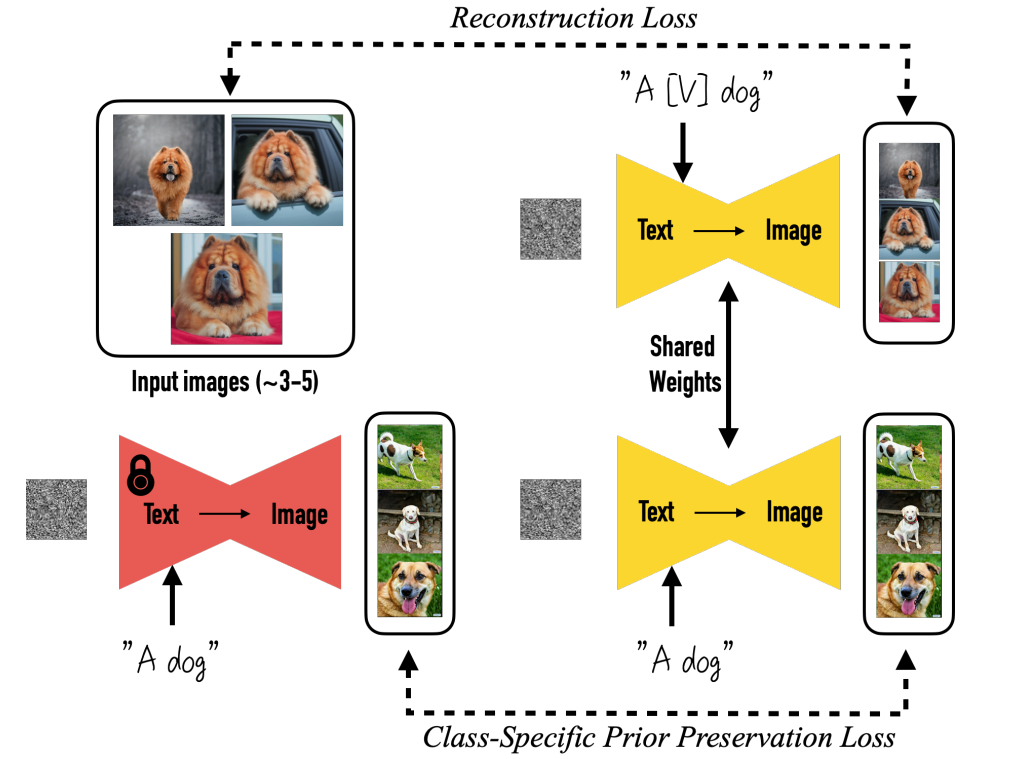

7、DreamBooth(谷歌)

论文:DreamBooth: Fine Tuning Text-to-Image Diffusion Models for Subject-Driven Generation

DreamBooth:微调文本到图像扩散模型,用于主题驱动的生成

简述:本文提出了DreamBooth,一种个性化文生图模型,它通过微调预训练的文生图模型,如Imagen,将一个独特的标识符与某个物体绑定,这样模型就可以在含有该标识符的prompt下,在不同场景中生成包含该物体的新颖图片。这种技术利用模型的语义先验和新的特定类先验保留损失,实现了在多样化条件下合成主体的能力。研究人员将此技术应用于多种任务,并提出了新的数据集和评估标准,以推动主题驱动的图像生成的发展。

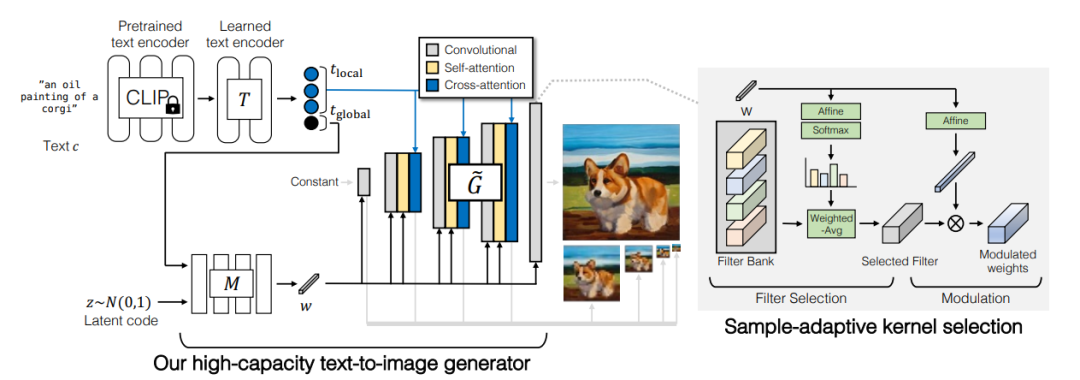

8、GigaGAN(POSTECH、卡内基梅隆大学和 Adobe 研究院的研究人员)

论文:Scaling up GANs for Text-to-Image Synthesis

扩展 GAN 以进行文本到图像合成

简述:本文提出了GigaGAN,一种改进的 GAN 架构,它被设计用于提高文本到图像合成的效率和质量,它具有三大优势:首先,它在推理时间快几个数量级,合成 512px 的图像只需 0.13 秒;其次,它可以合成高分辨率图像,例如,在 16 秒内合成 3.66 像素的图像;最后,GigaGAN支持各种潜在空间编辑应用,如潜在插值、样式混合和向量算术运算。

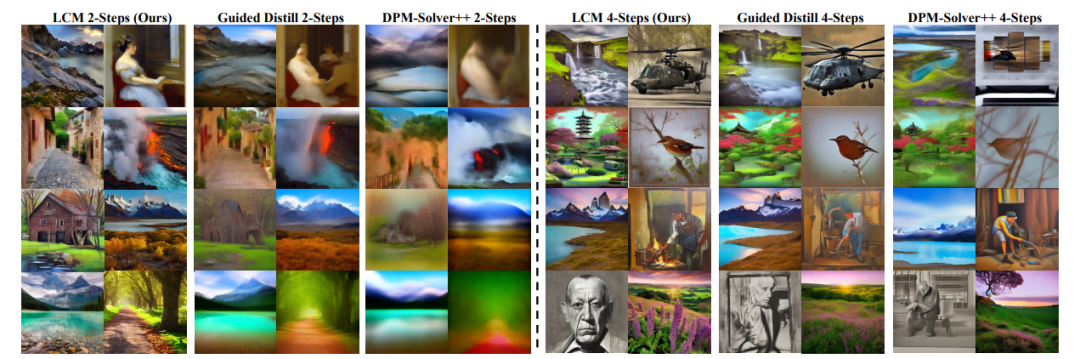

9、LCM (清华大学交叉信息研究院的研究者们)

论文:Latent Consistency Models: Synthesizing High-Resolution Images with Few-Step Inference

潜在一致性模型:通过少步推理合成高分辨率图像

简述:本文提出了LCM,一种在预训练LDM上快速推理的新模型,通过预测常微分方程的解减少迭代,实现快速、高保真的图像采样。LCM在预训练的无分类器引导扩散模型上表现出色,只需少量步骤即可生成高质量的图像,训练仅需少量计算资源。研究人员还提出了LCF,用于在自定义图像数据集上微调LCM。在LAION-5B-Aesthetics数据集上的评估显示,LCM实现了最先进的文本到图像生成性能。

码字不易,欢迎大家点赞评论收藏!

关注下方《享享学AI》

回复【文生图模型】获取完整论文和代码

👇

)

)

——前缀和)

)

)

)