总览:大模型技术的快速演进

自2023年7月6日“书生·浦语”(InternLM)在世界人工智能大会上正式开源以来,其在社区和业界的影响力日益扩大。在过去半年中,大模型技术体系经历了快速的演进,特别是100K级别的长上下文、代码解释、智能体等新技术的不断迭代。伴随技术水平的不断提升,大模型在应用边界的拓展也愈发显著。在这一背景下,上海人工智能实验室联合商汤科技、香港中文大学和复旦大学,共同推出了全新一代的语言模型——“书生·浦语2.0”(InternLM2)。

-

Huggingface模型下载:https://huggingface.co/internlm

-

AI快站模型免费加速下载:https://aifasthub.com/models/internlm

回归语言建模的本质

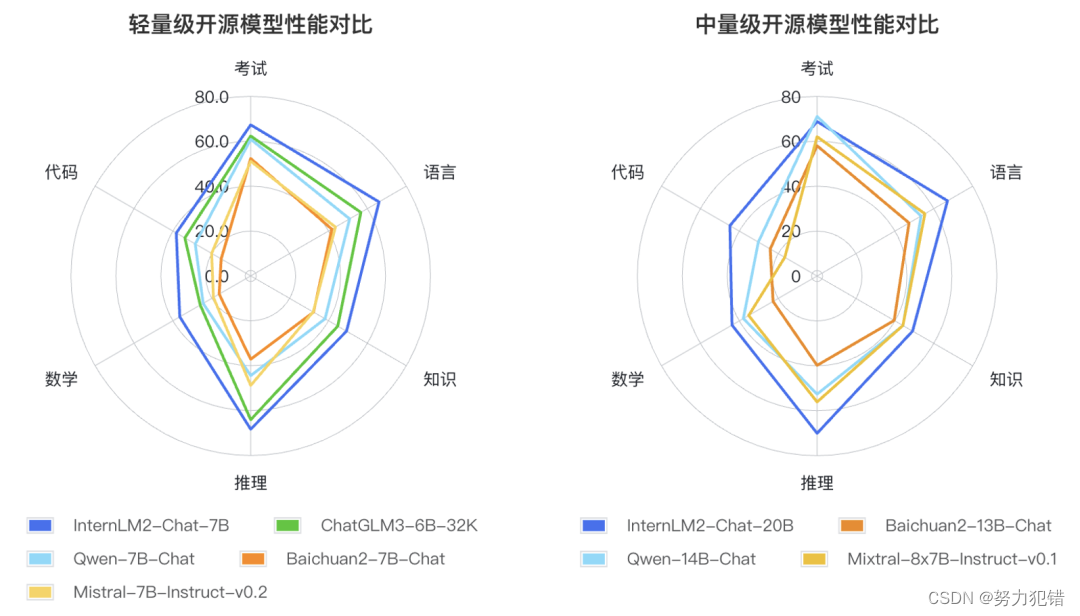

“书生·浦语2.0”(InternLM2)的核心理念在于回归语言建模的本质。团队通过提高语料质量和信息密度,旨在实现模型基座语言建模能力的质的提升。这一举措对于模型在各方面能力的提升至关重要,尤其是在数理、代码、对话和创作等方面。相比于第一代“书生·浦语”和其他主流开源模型,InternLM2在这些方面的综合性能已达到领先水平。

200K超长上下文的创新突破

一个显著的创新是“书生·浦语2.0”的超长上下文支持能力,达到了惊人的200K tokens。这一突破为模型处理大型文档、复杂推理演算和实际场景中的工具调用等应用场景提供了坚实的技术基础。在实际测试中,InternLM2展示了其在处理长文本时准确提取关键信息的能力,这在“大海捞针”试验中得到了充分验证。

全面提升的综合性能

在性能方面,InternLM2在语言理解、知识获取、推理判断、数理运算和代码生成等多个维度上均有显著提升。这得益于其在基础语言建模能力上的实质性增强,使得下游任务的表现也随之提高。尤其值得一提的是,它在一些对推理能力要求较高的评测集上的表现,甚至超过了业界的标杆模型ChatGPT。

对话和创作的新体验

“书生·浦语2.0”在对话和创作方面同样展现出卓越的能力。它不仅能够精准地理解和遵循用户意图,还具备较强的共情能力和丰富的结构化创作能力。这一点在最新公布的AlpacaEval2英文主观对话榜单上得到了体现,InternLM2-Chat-20B在其中的表现超越了GPT-3.5等竞争对手。

智能工具调用与数理推理能力的提升

在工具调用和数理推理能力方面,InternLM2也展现出显著的进步。它能够更精准地选择和多轮调用工具,完成复杂任务。在数学能力上,InternLM2不依赖外部工具就能进行复杂数学题的运算和求解,展示了其内生的计算能力。

开放和合作的开源精神

“书生·浦语2.0”秉承开放合作的精神,全面开源并支持免费商用。这一举措在推动AI技术民主化方面具有重要意义。它不仅为研究人员和开发者提供了一个强大的工具,同时也为AI领域的教育和实践提供了更多的可能性。项目的GitHub、HuggingFace等平台上已经提供了完整的模型权重和相关资源,使得广大用户能够轻松接入和应用这一领先的AI技术。

数据清洗过滤技术的革新

InternLM2的另一大特点是其新一代的数据清洗过滤技术。通过多维度数据价值评估、高质量语料驱动的数据富集以及有针对性的数据补齐,模型在语言建模能力上实现了显著增强。这不仅提高了模型训练效率,还确保了模型在实际应用中的高效和准确性。

面向未来的应用场景

随着AI技术的不断进步,“书生·浦语2.0”预示着未来语言模型的发展方向。它的超长上下文处理能力、多方面综合性能的提升以及对话和创作的新体验,为AI在各行各业的应用提供了新的可能性。从企业文档管理到创意写作,从智能对话助手到复杂数据分析,InternLM2都展现出了其强大的应用潜力。

结论:开启AI技术新篇章

“书生·浦语2.0”的发布不仅是技术的一次更新升级,更是中国AI领域在全球技术竞赛中的重要一步。它的强大功能和开源精神预示着AI技术的广泛应用和发展,同时也体现了国内AI技术的快速成长和创新能力。随着更多的应用案例和创新实践,我们有理由相信,“书生·浦语2.0”将在AI的新时代中发挥重要的作用。

模型下载

Huggingface模型下载

https://huggingface.co/internlm

AI快站模型免费加速下载

https://aifasthub.com/models/internlm

(01背包))

,推荐bitget钱包)

)

)

、322.零钱兑换、279.完全平方数)