前提条件

请确保以下工作已经完成:

开通阿里云账号。

购买MaxCompute。

创建要使用的项目空间,详情请参见创建空间。如果要使用的项目空间已存在,请确保已被添加至此项目空间并被赋予建表等权限。

完成客户端安装配置。

导入数据

Tunnel命令导入数据

1.准备数据 。将测试数据下载至本地备用

2.创建MaxCompute表。

3.执行Tunnel命令。

4.结果验证。

实际上整个过程有点像hive的数据导入,但是maxcomputer主要用通道来完成,而hive可以基于hdfs完成

其他导入方式:

除了通过客户端导入数据,您也可以使用MaxCompute Studio、Tunnel SDK、数据集成、开源的Sqoop、Fluentd、Flume、LogStash 等工具将数据导入到MaxCompute

后续步骤

当数据导入到MaxCompute后,可以在MaxCompute上运行SQL来处理数据。

sql运行以及导出数据

MaxCompute支持以下方式运行SQL语句:

客户端

DataWorks、Dataphin

背景信息:

MaxCompute目前支持的SQL语法如下:

各类运算符。

通过DDL语句对表、分区以及视图进行管理。

通过SELECT语句查询表中的记录,通过WHERE语句过滤表中的记录。

通过INSERT语句插入数据、更新数据。

通过等值连接JOIN操作,支持两张表的关联,并支持多张小表的MapJOIN。(maxcomputer的建表好像没有mysql那样的依赖操作,建表时主要考虑优化问题)

通过内置函数和自定义函数来进行计算。

正则表达式。

MaxCompute SQL不支持事务、索引、UPDATE以及DELETE等操作,同时MaxCompute的SQL语法与Oracle、MySQL有一定差别,您无法将其他数据库中的SQL语句无缝迁移到MaxCompute上来。

MaxCompute上作业提交后会有几十秒到数分钟不等的排队调度,所以MaxCompute适合一次批量处理海量数据的跑批作业,不适合直接对接需要每秒处理几千至数万笔事务的前台业务系统。

提取和分析数据

INSERT OVERWRITE TABLE result_table

SELECT education,COUNT(marital) AS num

FROM bank_data

WHERE housing = ‘yes’ AND marital = ‘single’

GROUP BY education;

上述过程仅仅是一个最简单的数据加工举例,您在实际应用的过程中,可能需要使用多个SQL对多个表进行加工操作。推荐您使用DataWorks完成复杂的数据加工业务流程。

导出数据

tunnel download result_table D:\result.txt;

MapReduce编程

操作步骤

1.安装并配置好客户端后,运行bin目录下的MaxCompute客户端(Linux系统下运行./bin/odpscmd,Windows下运行./bin/odpscmd.bat),进入相应项目空间中。

2.使用Tunnel命令上传数据。

3.在表中插入数据。

4.开发MapReduce程序并上传MaxCompute。

5.在MaxCompute客户端,添加Jar包到project资源(例如,此处的Jar包名为word-count-1.0.jar)。

6.在MaxCompute客户端运行Jar命令。

7.在MaxCompute客户端查看结果。

开发Java UDF

1.准备工具环境并创建Java Module。

您需要完成准备工作,包括安装Studio并在Studio上创建MaxCompute项目链接以及创建MaxCompute Java Module。

2.编写代码(maven注入依赖)

3.注册MaxCompute UDF。

4.试用UDF。

编写Graph

略

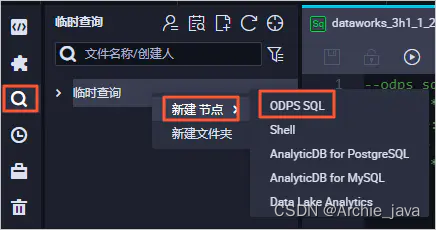

临时查询

进入DataWorks控制台工作空间列表页面,单击相应工作空间后的进入数据开发。

创建ODPS SQL节点。

填写新建节点对话框中的节点名称,单击提交完成节点的创建。

在创建的临时查询节点中输入SQL语句,单击按钮。

您可以查看本次运行的费用预估,决定是否继续进行本次操作。单击运行,继续SQL语句运行。

在下方的日志窗口,查看运行情况和最终结果。如果本次运行成功,结果为OK。

方法及使用注意事项)