来源:筑土为坛

梅剑华,男,1980年生,湖北秭归人,山西大学哲学社会学院教授,博士生导师,先后赴美国罗格斯大学、匹兹堡大学、奥地利萨尔茨堡大学等访学,研究方向是语言哲学与心灵哲学、实验哲学与认知科学、儒家哲学与比较哲学等。

电影《机械姬》剧照,讨论了人工智能可能带来的影响。

理解与理论:人工智能基础问题的悲观与乐观

☟

人工智能的基础问题遇到两种类型的问题:第一种类型的问题是理解上的,计算机能否思考?强人工智能是否实现?奇点能否来临?这些取决于我们对相关问题、论证及其概念的反思;第二种类型的问题是理论上的,人工智能需要相关性的推理模型还是因果性的推理模型;人工智能可否建立一种反映真实世界的四维符号系统。这取决于科学家的理论工作。在理解问题上,一旦澄清相关的概念和论证,会消除对人工智能的悲观。在理论问题上,一旦深入理解了相关数学的、技术的难题,会消除对人工智能的乐观心态。

1.导论

人工智能在最近几年成为各个学科、各个阶层、各个国家竞相关注的话题。它在最基本的层面推动我们对人之为人、人与机器之异同诸多哲学-科学论题的理解,这包括了大量哲学、认知科学、计算机科学之间的交叉研究。人工智能也在最现实的层面推动社会的发展,人工智能技术的应用极大改变了人类的生活,重塑了各种行业的生存状态。

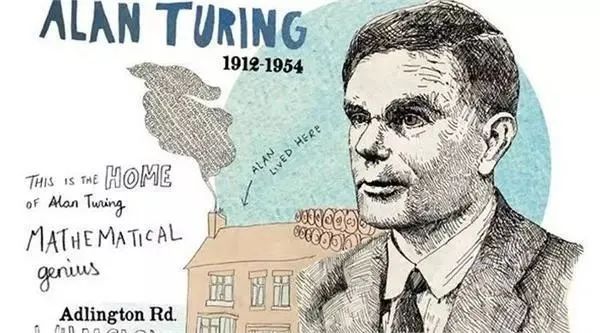

在人工智能的基本层面,一些乐观的哲学家、科学家认为人类能够制造出和人一样具有智能的机器人;另一些悲观的哲学家、科学家,认为人类乃万物之最灵者,不能(无法)造出具有人类智能的机器人。自1950年图灵在哲学杂志《心灵》上发表《计算机与人工智能》至今,围绕图灵测试、中文屋这些论题的讨论从未停歇。(据谷歌学术,这篇文章到目前的引用次数为10010)一些具有人文主义情怀的哲学家试图通过反对强人工智能,试图为人类留以最后的尊严。一些具有自然主义倾向的哲学家则试图对强人工智能展开论证,表明人不过是自然世界中的一个复杂智能体而已。

在人工智能的应用层面,一大批务实的企业家和科技工作者希望用人工智能去解决一个个社会难题,而另外一批具有批判意识的知识人则担忧,人工智能技术可能催生新的伦理、政治问题。阿法尔狗、阿尔法元争论未止,京东已开始利用人工智能技术探索物流新路径,马云则使用人工智能进军农产领域。过于强盛的人工智能技术会不会剥夺人类的工作机会,从而引发巨大的社会动荡呢?乐观派似乎暂时占了上风,而一大波没有发言权的基层劳动者(如送货员、超市销售员、农民工)则在铺天盖地的媒体新闻里到了自己的失业前景,产生了巨大的焦虑。杜威曾说:“哲学家不处理哲学家的问题,哲学家处理我们的问题。” 人工智能问题不再仅仅是书斋或实验室里的问题,而是我们每个人必须面对的问题。

人们对人工智能的种种乐观或焦虑,很大程度上源于对人工智能问题的误解和偏见。这些问题大致可以分为两类,第一类是理解性的,第二类是理论性的。理解性的问题需要澄清,理论性的问题需要解决。机器能否思考?奇点能够来临?机器是否会统治人类?这属于理解层面的。机器人能否运用因果推断知识,人工智能能够建立一个真实反映世界的四维符号系统。这属于理论层面的。对于理解层面的问题,我的态度是乐观的。即使奇点来临,我们也会与机器人和平共处。对于理论方面的问题,我的态度是悲观的。除非发生巨大的科学革命,我们很难让机器人具有和人完全一样高的推理系统。本文第2节对相关概念进行辨析。第3节就机器能否思考,机器能否进行因果推断,机器能否建立真正的符号系统给出分析。第4节就奇点能否来临、强人工智能可否实现给出我的论证。

2.人工智能概念的误解与澄清

人工智能的发展大致可分为三个阶段:逻辑推理-概率推理-因果推理。1956年开始人工智能推理以命题逻辑、谓词演算等知识表达、启发式搜索算法为代表。二十世纪八十年代盛行的专家系统就是其典型 。随着研究的深入,科学家发现逻辑推理不能完全模拟人类思维。人类思维是一种随机过程,人工智能应该建立在概率推理的基础之上。这就形成了二十世纪八九十年代以来的视觉识别、语音识别、机器学习等研究领域。2000年以后以加州大学洛杉矶分校计算机系的珀尔(Judea Pearl)教授,卡耐基梅隆大学哲学系的格利穆尔(Clark Glymour)教授等人为代表的因果推理派也逐渐进入了人工智能学界的视野,珀尔教授在人工智能领域引入因果推断方法。目前发展火热的仍是基于概率的机器学习及其分支深度学习等领域。

人工智能的一些基本概念在传播过程中,不免发生混淆。[1] 尤其是弱人工智能、强人工智能、通用人工智能和超级人工智能这四个概念之间的区别和联系。例如通用人工智可以等同于强人工智能吗。[2]

——————————————

[1] 徐英瑾.“强人工智能、弱人工智能及语义落地问题”.《社会科学战线》微信公众号, 2018.

[2] 李开复、王永刚. 人工智能[M]. 北京:文化发展出版社, 2017, 113.

让我们逐一进行分析,弱人工智能/强人工智能(在后面的讨论中,视其语境,将人工智能简写为AI)这个区分是塞尔在《心灵、大脑与程序》(1980)一文开头提出来的[3] ,塞尔指出弱人工智能不过断言计算机是研究智能的一个有用的工具。

——————————————

[3] 这里有必要引用塞尔的相关论述:“我们应当怎样评价计算机在模拟人类认知能力方面的成果所具有的心理学和哲学意义呢?在回答这个问题时,我发现,将我称之为强AI的东西与‘弱’AI或者审慎的AI加以区别是有益的。就弱AI而言,计算机在心灵研究中的主要价值是为我们提供一个强有力的工具。例如,它能使我们以更严格、更精确的方式对一些假设进行系统阐述和检验。但是就强AI而言,计算机不只是研究心灵的工作,更确切地说带有正确程序的计算机缺失可被认为具有理解和其它认知状态,在这个意义上恰当编程的计算机其实就是一个心灵。在强AI中,由于编程的计算机具有认知状态,这些程序不仅使我们可用来检验心理解释的工具,而且本身就是一种状态。” 玛格丽特·博登编. 人工智能哲学[M]. 刘西瑞、王汉琦译, 上海:上海译文出版社, 2001, 92.

一个弱意义上的人工智能程序只是对认知过程的模拟,程序自身并不是一个认知过程。强人工智能断言一个计算机的运行在原则上就是一个心智,它具有智力、理解、感知、信念和其它通常归属给人类的认知状态。通用人工智能(AGI):指计算机在各个方面具有和人类同样的智能。它们能够执行与人类相同水平、相同类型的智力任务。苹果公司的创始人之一史蒂夫·沃兹尼亚克将咖啡测试作为AGI的一项指标。在测试过程中,机器人必须进入普通家庭并尝试制作咖啡。这意味着要找到所有的工具,找出它们如何运作,然后执行任务。能够完成这个测试的机器人将被认为是AGI的一个例子。根据如上理解,我们可以说一个弱AI可能就是通用人工智能,因为弱AI虽然只是工具,但它可以实现对人类所有智能模块的模拟。强AI则不仅仅是通用人工智能,而是要和人类心灵在性能上完全一样。如果我们做一些强行划分,弱人工智能分成两个部分,弱AI(a)第一部分,在某个方面对人类智能的模拟,这也是一般人对弱AI的理解。计算机不过是人的工具。就像我们所接触到的各种机械系统一样。弱AI(b)的第二部分,可以是通用人工智能。它是对人类智能的全面模仿。机器人进入普通家庭制作咖啡。这个任务,就如同图灵测试中的计算机一样,只要计算机能成功的回答提问者的问题,就可以表明计算机能够思考。同样,我们可以把机器人制作咖啡,做任务分解,机器人如果能完成这项复杂的任务,这也表明它具有和人一样的推理能力。按照塞尔的理解机器人制作咖啡也是弱AI。所谓强,就意味着机器人知道自己在制作咖啡,或者更深入一些,套用托马斯·内格尔的术语,机器人必须知道what it is like to be a Coffee waitress(成为一名咖啡制作者是怎样的)。显然目前所理解的通用人工智能做不到这一点。强AI 既包括老百姓的一般理解,计算机要像人一样做所有的事情,它还必须具有人类也有的意识:情感、感受性,甚至伦理道德等等。而这几乎回到了心灵哲学中关于意识问题的物理主义和二元论的永恒争论上来了。

至于超级智能:作为人工智能领域的领军人物之一,尼克·博斯特罗(Nick Bostrom) 将超智能定义“在几乎所有领域,包括科学创造力,一般智能和社交技能方面,都比人类最优秀的智能更聪明”。从哲学的角度来看,这也是一个比较含混的表达,如果要根据塞尔的两分法,超级人工智能在类型上既可以是弱的也可以是强的人工智能。在塞尔看来,机器是否具有理解、意识(自我意识),是衡量机器是否具有人工智能的唯一标准。因此人工智能按照徐英瑾的说法只有真假之别(也就是强弱之分),而无程度(宽窄)之别。颇为吊诡的是,不管是大众还是人工智能领域的专家,都有意无意的忽略了塞尔最早提出强弱两分的标准,而是代之以新的标准:弱的人工智能就是对人的局部模仿,强的人工智智能就是对人的全部模仿。大众更从实用、后果的层面理解人工智能。在这里为哲学家津津乐道的what it is like to be 问题处在了边缘。不难看出,哲学家、科学家、大众对何谓人工智能的理解并不是一致的,这里面存在系统的差异,对这种差异的检测或许会成为新的研究的起点。

3.人工智能基础问题反思

3.1机器能否思考的实验哲学考察

图灵在《计算机与人工智能》一开头就抛出了人工智能的根本之问:计算机能思考吗?他认为不能通过考察“机器”和“思维”的实际用法,来获得机器能够思考的答案,尤其是不能通过对大众意见的统计调查来获得答案:

我建议来考虑这个问题:“机器能够思维吗?”这可以从定义“机器”和“思维”这两个词条的涵义开始,定义应尽可能反映这两个词的常规用法,然而这种态度是危险的。如果通过检验它们通常是怎样使用的,从而找出“机器”和“思维”的词义,就很难避免这样的结论:这些词义和对“机器能够思维吗?”这个问题的回答可以用类似盖洛普民意测验那样的统计学调查来寻找。但这是荒唐的。与这种寻求定义的做法不同,我将用另一个问题来替代这个问题,用做替代的问题与它密切相关,并且是用没有歧义的语言来表达。[4]

——————————————

[4] 玛格丽特·博登编. 人工智能哲学[M]. 刘西瑞、王汉琦译, 上海:上海译文出版社, 2001, 56.

统计调查的办法是荒唐的,图灵变换策略,建立了图灵测试,通过他制定的标准来建立计算机是否能思维的标准。半个世纪之后,实验哲学家重新拾起这个被图灵有意忽略的问题:大众实际上是如何理解计算机能否思考这个问题的?这并非老调重弹,而是具有重要的价值。如前所论,人们对机器是否具有人类智能依然众说纷纭。在科学未能给出终极解决之前,大众常识的看法是值得考量的。21世纪之初兴起的实验哲学方法运用科学的工具去处理哲学的问题。在实验哲学家看来:认识到语言如何工作这个任务具有经验蕴含。语言不仅仅会误导专家,也同样误导大众。人类的语言实践会对人类关于机器、思维这些基本议题产生影响。实验哲学就在试图探测这种影响的细节。

我们在谈到计算机能否思考这个问题的时候,实际上经常涉及到的是三个意义相近,但又彼此不同的概念:计算机(computer),机器(machine),机器人(Robot)。对机器能够思考吗?表面看来,我们可以迅速对计算机能否思考给出确定的答案。如果细致区分,应该是三个问题。计算机能够思考吗?机器能够思考吗?机器人能够思考吗?对这一问题的统计调查[5]显示:26.2% 的人认为机器能够思考、36.0%的人认为计算机能够思考,48.2%的人认为机器人能够思考。同时测试者针对同一群体做了一组术语测试:1.计算机是机器吗?2.机器人是机器吗?结果98.6%的人相信计算机是机器;所有人相信机器人就是机器。这个测试很有意思,当这一组语词(计算机、机器、机器人)没有和其它语词产生语义学关联的时候,它们之间的差异被忽视掉了。而将这些语词置于一定的语境之中就导致人们的看法发生变化。通过对调查人群的教育背景的分析,会发现受教育程度越高,人们越倾向于认为机器能够思考。关于机器能否思考这个问题的大众答案,和大众对语词的使用有密切的关联,也和大众的教育背景有紧密联系。这里有两点需要注意:实验测试是英语语境,如果是中文语境,可能对于机器人能否思考这个问题,给出肯定回答的比例更高一些。因为中文语境中“机器人”和“人”的语义关联度要远远高于“robot” 和 “person”。其次,受试者的教育背景会影响其对这个问题的回答。

(心灵哲学中的物理主义和二元论之争,我们也会发现受到自然科学教育越多的人越倾向于接受物理主义立场,而受到传统哲学和宗教影响的人则青睐二元论。)

——————————————

[5]Jonathan Livengood and Justin Sytsma. 'Empirical Investigations: Reflecting on Turing and Wittgenstein on Thinking Machines.' [E], Jonathan Livengood and Justin Sytsma, in D. Proudfoot (Ed.), Turing and Wittgenstein on Mind and Mathematics, OUP. (forthcoming)

当我们在思考人工智能是否能够超越人类智能的时候,对于“什么是人类智能”的理解也会直接影响到“人类智能是否能够超越”这个实质问题。而哲学家对于智能的理解并不能完全摆脱大众对智能的理解。专家和大众会对智能的看法有细节差异,但实质则一。实验哲学在这个层面提醒研究者,在回答任何关于人工智能问题之前,用实验调查的办法考察人工智能中广泛使用的概念是极有裨益的。

3.2机器人能具有因果推理能力吗?

人工智能的一个核心要求是机器人要在每一个方面都像人一样,比如机器人应该具有意识、具有道德等。不过在此之前,有一个更基础的问题,机器人首先应该像人一样行动。它可以通过周围环境的改变,调整自己的行动,建立行为范式。早期的人工智能运用符号推理和概率推理模拟人的推理系统,取得了巨大的成就。但是建立在强大的数据和推理手段之上的智能系统却不能像小孩一样进行常识判断和因果推断。它可以做出专家不能做的事情,却无法做出小孩能做的事情。原因在于小孩通过对外界环境的刺激进行反应,因果学习。他们可以通过因果学习,建立因果推断模式。正加州大学计算机系计算机视觉研究专家朱松莼[6]提出的:人工智能不是大数据、小任务;而是小数据、大任务。环境中的智能体应该根据环境中的有限信息(小数据),通过观察,建立信息和行为之间的因果关联,从而做出复杂的行为(大任务)。朱松莼做了一个对比:大数据小任务的典范是鹦鹉学舌,通过給鹦鹉输入固定的语音信息,使得鹦鹉学会相应的语句。但鹦鹉和聊天机器人都不懂得真正的话语,不能在语句之间建立真正的联系(中文屋的再现)!小数据大任务的典范是乌鸦喝水。乌鸦比鹦鹉聪明“它们能够制造工具,懂得各种物理的常识和人的活动的社会常识。” 乌鸦进城觅食,它找到了坚果,面临一个任务:它需要把坚果砸碎。通过在马路边观察它发现,路过的车辆可以把坚果压碎。但是它也发现了如果它在坚果压碎之后去吃,很可能会被车辆轧死。怎么办?乌鸦既需要车辆把坚果压碎,又需要避免被车辆压到自己。乌鸦把最初的任务分解成了两个问题,1.让车辆压碎坚果, 2.避免车辆压到自己。通过进一步观察,它认识到需要找到车辆停止的情况可以避免自己被压死。它发现有红绿灯的路口就是这样一个合理的场景。它发现了,红绿灯和人行横道、车辆之间的因果关联。因此它选择在红灯车辆等待的时候去捡坚果。在这个过程中,乌鸦获取的数据是少的,但任务是大的。问题的关键不是它获取了多少数据,而是它有效提取了数据之间的因果关联,根据这个因果联系制定了解决方案。

——————————————

[6]朱松莼. 浅谈人工智能:现状、任务、构架与统一, 见朱松莼在加州大学洛杉矶分校的个人主页:

http://www.stat.ucla.edu/%7Esczhu/research_blog.html#VisionHistory.

如果人工智能要能成为真正的人类智能,就必须对人类的因果认知、推理模式有深入的了解。目前人工智能研究领域并未重视这一问题。珀尔教授以《因果性》[7]一书获得了2011年计算机图灵奖,他在八十年代率先在人工智能领域提出贝耶斯推理,九十年代又转入因果推理领域,两次居于科学革命的中心。从概率推理转到因果推理,珀尔认识到,只有让机器人建立了真正的因果推理模式,机器人才具有真正的智能。在珀尔看来,当前人工智能领域盛行的机器学习模型在棋类博弈、图像识别、语音识别等方面卓有成效,但这个技术已面临瓶颈。之所以机器学习导向是错误的,是因为它是以数据为导向,⽽不是以⼈的推理特征为导向。机器学习的倡导者认为数据⾥⾯有真经,只要具有巧妙的数据挖掘技术,学习机器通过优化参数来改进其表现就可以了。学习机器通过⼤量的数据输⼊来实现其表现的改进,但是强⼈⼯智能之为强⼈⼯智能,是希望机器拥有像⼈⼀样的能⼒。数据是盲⽬的,数据能够告诉我们谁服药可以恢复的⽐其他⼈更快,但是不能告诉我们为什么[8],⽽⼈的优越性在于他能够回答为什么的问题,⽐如干涉问题:服⽤这个药物对⾝体的康复有效吗?⽐如反事实问题:这个没有接受过⼤学教育的⼈,如果他接受⼤学教育,那么会怎么样?⼈的⼤脑是处理因果关系最为先进的⼯具,在与环境互动的过程中,大脑建立了系统的因果推理模式,回答各式各样的因果问题。这是⼈⼯智能要努⼒了解⼈之为⼈的卓越能⼒。并通过计算机来模拟这样⼀种能⼒,最终实现真正的⼈⼯智能:探究未知的现象,解释已有的现实,从周围环境中发现因果关系。让机器⼈拥有理解和处理因果关系的能⼒,是通向强⼈⼯智能中的最⼤困难之⼀。

——————————————

[7]Pearl, Judea, Causality[M]. Cambridge: Cambridge Univ. Press, . 2009.

[8]Judea Pearl and Dana Mackenzie, The Book of Why: The new science of cause and effect [M]. New York: Basic Books, Forthcoming May 2018.

在技术上让机器⼈具备因果推断能⼒,必须解决两个最实际的问题:第⼀、机器⼈如何与环境互动来获取因果信息?第二个、机器⼈怎么处理从它的创造者那⾥所获取的因果信息?珀尔的⼯作主要试图解决第 ⼆个问题。在他看来图模型(有向无环图)和结构方程模型的最新进展已经使得第⼆个问题的解决成为可能,⽽且也为第⼀个问题的解决提供了解决的契机。但这一切依赖于一套完整系统的因果语言。珀尔为因果推断提供了一套完整的形式化语言,为人工智能中的因果推断打下了坚实的基础。但如何在技术上实现这一点,等待科学家的仍然是“雄关漫道坚如铁”。

银翼杀手剧照,被称为人工智能带来的末世。

3.3人工智能可否建立真实的符号表征系统?

我们已经说过人工智能必须发展一套因果推理的语言,比如这些语言中包括:do算子,干涉、反事实、混杂共因、内生变元、外生变元、噪声等等。但这里存在一个基本的困难:人工智能中的智能体是在四维时空中行动,而我们的语言是一维的。一维的语言如何表现四维的时空中的事物呢?从语言来理解人工智能,构成了人工智能的困境。在叶峰[9]看来,二十世纪人工智能研究对语言(不管是日常语言分析还是逻辑语言分析)的盲目崇拜是人工智能陷入泥潭的主要原因。人类语言是一维符号系统,而世界是四维的,这使得人类语言不能有效表征世界。我们所具有的形式化语言,都是一维的。比如我们直接用谓词逻辑语言来描述物体及部分的时空位置关系,或者设立射孔坐标,把时空切割成方块。将目标对象看作时空小方块的集合,然后用一维语言描述时空的特征。这两种办法都会丢失四维时空中物体的一些特征,套用“言有尽而意无穷”的说法,我们可以说一维语言的表述能力是有限的,但需要表述对象的特征却是无穷的。表述能力的缺失,就会导致数据的重复和增加。如果运用高级手段就能很清楚的表述对象之间的时空关系。但是手段粗糙,只能靠大量的抓取数据来获取有效信息,而这显然不是智能的做法。语言并非和大脑的思维状态同构。人类大脑对世界的认知很有可能的是多维的。比如视觉认知,大脑直接保存了所见物体的空间位置特征,大脑的记录是多维的而非一维的。我们可以合理假设:大脑并非像语言一样通过一维来重建多维,大脑可以直接表证纪录物体的四维结构 。不然大脑需要处理的信息就太复杂了,以至于不能在极短的时间内完成识别任务。回过头来考虑语言-心灵/大脑-世界之间的关联。通常我们认为语言表达世界(见维特根斯坦《逻辑哲学论》),心灵表达世界,语言也在这个意义上表达了思想。语言、心灵、世界建立了稳定的三角关系。这是一种稍加反思就能达致的形而上学观念,但这并非科学所揭示的真相,认知科学的大量证据表明人类对世界的认知要先于语言的发明(让我们忽略哲学上塞拉斯-麦肯道威尔-布兰顿一系的匹兹堡学派的概念论立场)。人类和动物对外部世界的视觉表征要早于语言。“简单的人类语言之所以能够传递大脑中极其复杂的表征,是因为人类大脑之间的相似性。这种相似性使得两个大脑对同样的物体或场景产生的内部表征(如看见一个物体所产生的视觉图像)大致是相同的。”[10] 语言的抽象概念是怎么建立的呢?我们理解”婚姻“这个概念,依据的是与这个词相关联的大量视觉、触觉、嗅觉、记忆等知觉表征。比如阅读一个婚姻故事、参加一场婚礼、为离婚打官司等等。“婚姻”这个概念并不仅仅是因为坐落在一堆与之相关的概念家族中而得到规定。而是使用这个词的主体通过社会实践(各种知觉活动),建立了这个概念和其他概念所关涉的生活之间的联系。因此,如果大脑在表征世界的时候,是将世界的场景如其所是的反映在大脑之中,那就表明大脑的神经元结构足以表征世界的四维图景。而一维的语言则在把四维图景反映到语言中时,丢失了一些重要的结构和细节。基于一维语言符号系统的计算机必然不能像真正的人一样对世界进行表征、预测和行动。放弃一维的语言也许是走出困境的一条道路。但是如何发明建构一套四维的符号系统呢?这个困难甚至比制造具有因果推断的智能体这个困难更大,不仅仅是“雄关漫道真如铁”,而且根本无法“迈步从头越”。

——————————————

[9] 叶峰. 论语言在认知中的作用[J]. 世界哲学, 2016(5),72-82. 应当指出叶峰关于当前人工智能路径的批评是非常有创见的,虽然他并没有提出一种可以改进的方案。

[10] 叶峰. 论语言在认知中的作用[J]. 世界哲学, 2016(5),78.

4.强人工智能、超级智能时代会到来吗?

强人工智能可以实现吗?[11] 这可以算人工智能的终极之问。大部分人认为它是不可实现的。比如曾任微软亚洲研究院首席研究员的李世鹏认为所有的人工智能都只有一个高级搜索功能。它依靠大数据训练这些模型。一些它没遇到的情况,它解决不了,没有智能,没有推理功能。学习机器的训练集大于测试集,就表明了这一点。[12] 李世鹏的结论很简单,我们目前还没有真正的人工智能。机器学习专家周志华则对目前没有强人工智能做了全面的论述:目前人工智能的主要技术源于弱人工智能,主流人工智能学界的努力并非朝向强人工智能。即使想要研究强AI,也不知道路在何方。甚至,即便强AI是可能的,也不应该去研究它。[13]周志华在原理上、技术上、伦理上都反对强人工智能。

——————————————

[11]王晓阳. 人工智能能否超越人类智能[J]. 自然辩证法研究, 2015(7), 104-110.

[12] 李世鹏. 今天的人工智能只是一个高级搜索功能载[J]. 289艺术风尚, 2018/01-02.

[13] 周志华. 关于强人工智能[J]. 中国计算机学会通讯, 2018(1)《专栏》.

另外一拨反驳强人工智能的产生于思辨的忧虑:如果强人工智能是可能的,那么制造出来具有人类智慧水平甚至比人类更强的机器人就会奴役人,产生一个新的奴隶时代。哈佛大学心理学家斯蒂芬·平克新近撰文[14] 批判了这一观点,他指出假定机器人具有了强人工智能,但“复杂系统理论中没有任何定律认为,有智力的行为主体必定会成为残忍的征服者。”但他也和周志华、李世鹏具有类似的观点“根本没有任何机构正在研究通用人工智能”、“AI的进步不是来自对于智力机制的理解,而是来自于处理速度更快、能力更强的芯片和丰富的大数据。”的确目前大数据的流行、深度学习方法的深入,都极大的推进了目前的人工智能技术。如纽约大学教授马库斯(Gary Marcus)在2018年1月发文批评目前占据主流未知的深度学习:我们必须走出深度学习,才能迎来真正的通用人工智能。 [15]

——————————————

[14] 斯蒂芬 ·平克. 马斯克和霍金错了吗?平克犀利驳斥AI威胁论[M]. 王培译, 改编自平克的新书Enlightenment Now: The Case for Reason, Science, Humanism, and Progress , 首发于popular Science, 2018年春季智能专刊( the spring 2018 intelligence issue).

[15] Gary Marcus, Deep Learning: A Critical Appraisal[J]. arXiv:1801.00631 [cs.AI]. 2018.

目前大量的人工智能技术被应用于现实生活:机器翻译、图像识别(人脸识别)、语音识别、棋类博弈、无人驾驶、AI金融等等。2018年2月4日,《中共中央国务院关于实施乡村振兴战略的意见》发布。两天后,马云正式发力AI养猪项目,利用人工智能技术养猪,计划到2020年,猪的数量将会达到1000万头。马云养猪全过程将使用人工智能技术,依靠通过视频图像分析、人脸识别、语音识别、物流算法等高效准确的完成各项工作。例如,为每一头猪建立自己的成长档案,其中视频图像分析技术可以记录猪的体重、进食情况、运动强度、频率和轨迹,检测是否怀孕等等。ET大脑通过红外测温技术和语音识别技术,监测猪的体温和咳嗽的声音,随时关注猪的身体健康, 对猪的生长有了更全面更精细的照料。人工智能技术提高猪的产量,降低了人工成本。类似的还有京东的无人运行的物流技术,提高了精准性,降低了人工成本。在可以利用机器的地方,让人退出从事更有创造力的工作,这种对于社会行业结构的改变,应该是良性的。千百年来,技术的进步,解放了人类的双手和双脚,产生了越来越多的新职业。在这个意义上,目前社会上大批人工智能技术并没有对人类社会造成威胁。可以说弱AI在原理开发和技术运用上都得到了极大的运用产生了良好的效果。

但人工智能最为焦虑的问题还是强人工智能:第一、我们能否实现强人工智能,第二、我们如何实现强人工智能;第三、如果我们实现了强人工智能,人类的命运会怎样?根据第二节的分析,强人工智能可以在两个层面理解。第一个层面是高级复杂的通用人工智能;第二个层面是具有人一样的感受性(意识)。对这两个问题的回答各有不同。如果在第一个层面理解,珀尔所提倡的让智能体具有因果推断能力,就是迈向强人工智能的重要一步。智能体既可以对环境的因果信息进行抽取,又可以运用从它创造者那里获取的因果信息,那么就造成了通用的人工智能体。这样意义上的强人工智能在技术上是可能达到的(可以记为强AI(a))。遗憾的是,目前为止,将人工智能转向因果推断研究的研究者还非常少。深度学习的成功使得目前的人工智能研究者忽视了这一进路。如果在第二个层面理解强人工智能,机器人要具有意识,成为一个有意识的心灵(可以记为强AI(b))。这就不单单是技术推进可以解决的问题。这背后是也哲学观较量的问题。就如在第三节所谈,人们对机器能否思考的问题,具有系统的差异。最近的实验心灵哲学[16] 也对人们关于现象意识、机器意识做了大量的经验调查。大众对机器是否具有意识意见并不一致。这都表明,这一个层次的强人工智能是一个理解问题。即使针对人类心灵,物理主义者会断言心灵不过就是大脑,所谓的现象意识如丹尼特所言不过是幻觉,真实存在的是神经元网络的活动。但二元论者反对心灵的大脑解释。物理主义和二元论者对待心灵的态度,会影响哲学家对人工智能的理解。只要接受物理主义立场,强AI(b)就是可能的,它也不过是机器人的幻觉而已。一个物理主义者可以承认强AI(b)是可能的,但未必认为强AI(a)是可能的。如果人类的视觉识别在根本上是四维的,而一维的语言又不能完全刻画这些信息的话,那么强强AI(a)就是不可能的。但这并不妨碍像叶峰这样的物理主义者接受第二种含义上的强人工智能。

——————————————

[16] Justin Sytsma. Advances in Experimental Philosophy of Mind[J]. Bloomsbury. 2014.

现在来看第二个问题,如果我们认为强人工智能是可能的,如何去实现它。第一种意义上的人工智能就是建立因果推断的数学模型。第二种意义上的人工智能不是一个如何实现的问题,而是牵扯到如何理解心灵的问题。只要你是一个物理主义者,就会认为这样的强人工智能是可以实现的。对于一个接受因果推断的物理主义者来说,强人工智能是一个迟早都会到来的时代。我们会造出机器人作为我们的帮手和朋友,就如同现实生活中我们的帮手和朋友可能会祸害我们一样,机器人也可能会祸害我们。但人类能够制造出类人机器人,就能够与他和谐相处。父母生儿育女属于生活的常态,弑父弑母属于生活的反常情形。与此相似,反人类的机器人也是属于异类。

有人相信存在超级人类智能。如果有一天制造存出在智能上超越人的机器, 这就是所谓的奇点来临。[17] 这在逻辑上是可能的。人类能造出比人智力更强的机器人是什么意思呢?我们制造了比自己聪明的机器人,他们就可以独立生存自我繁殖演化吗?这就需要我们人类所制造的机器人能够自己制造或者生育自己的机器人。查尔莫斯在关于奇点的哲学分析中,坦承他的分析纯粹是思辨的,但他的结论是比较乐观的:他认为奇点是可能存在,目前存在的障碍可能是动机的障碍,而并非在能力上不够。如果奇点来临,机器也可以建立合适的价值观,可以在虚拟世界中构建第一个AI和AI +系统。[18] 此处不展开对查尔莫斯奇点观的分析。笔者基本认同查尔莫斯的立场 。如果人类能制造出来更加聪明的机器人,则那些制造者的智力程度也大大提高了。虽然未来的机器人可能比现在人的智力水平高,但只要人能制造出机器人,未来的人就不会完全受到未来的机器人的控制,也不太可能被自己找造的机器人击败。看似是一个经验问题,实则一种概念反思。即使强人工智能时代到来,那并不意味着人类将面临最大的危险。一句老话说得好:风险与机遇共存。我们可以想象:无人驾驶、餐厅里有机器人服务员、老年人看护、危险场所的机器人等等。不管他/她们是什么类型的人工智能,总之他/她们与人友好相处,有时也会像人类一样伤害同类。如果人类互相伤害的历史是可以接受的,我们没有理由不接受机器人像人一样的行为。况且机器人可以帮助人类从事务性的工作中解脱出来,投身到更具创造性、更自由的活动中去。就像马克思在《德意志意识形态》所讲的那样:“……在共产主义社会里,任何人都没有特殊的活动范围,而是都可以在任何部门内发展,社会调节整个生产,因而使我有可能随自己的兴趣今天干这事,明天干那事,上午打猎,下午捕鱼,傍晚从事畜牧,晚饭后从事批判,这样就不会使我老是一个猎人、渔夫、牧人或批判者。”人工智能技术消除了强制性的、固定性的分工,让每个人作为个人参加共同体,个人的存在摆脱了对人与对物的依赖,成为独立的、有个性的个体,成为全面发展的自觉自由的个人。那不是一个更具有美好生活的时代吗?

未来智能实验室的主要工作包括:建立AI智能系统智商评测体系,开展世界人工智能智商评测;开展互联网(城市)云脑研究计划,构建互联网(城市)云脑技术和企业图谱,为提升企业,行业与城市的智能水平服务。

如果您对实验室的研究感兴趣,欢迎加入未来智能实验室线上平台。扫描以下二维码或点击本文左下角“阅读原文”

:平均值法、双峰法、大津算法(OTSU))

)

](http://pic.xiahunao.cn/拉普拉斯锐化[原理及Python实现](含拉氏标定、拉普拉斯标定))

![[bzoj4994][Usaco2017 Feb]Why Did the Cow Cross the Road III_树状数组](http://pic.xiahunao.cn/[bzoj4994][Usaco2017 Feb]Why Did the Cow Cross the Road III_树状数组)