来源:集智俱乐部

作者:Alex Davies, Petar Veličković, Lars Buesing等

译者:赵雨亭

审校:潘佳栋

编辑:邓一雪

导语

我们通常认为,数学家的世界充满了直觉和想象力,他们发现模型、提出猜想、证明定理;而计算机只不过是擅长机械的计算。但能够从大量数据中学习的 AI,是否能够像数学家一样,从数据中发现模式?是否可以辅助数学家做出新发现呢?12月1日,DeepMind 团队在 Nature 杂志上发表的一项最新研究中,人们成功让 AI 与人类数学家进行了合作,利用机器学习从大规模数据中探测模式,然后数学家尝试据此提出猜想,精确表述猜想并给出严格证明。他们解决了纯数学领域的两个问题:得到了纽结理论中代数和几何不变量之间的关系,提出了表示论中组合不变性猜想的可能证明方法。这次成功意味着未来机器学习可能会被引入数学家的工作中,AI 和数学家之间将展开更深入的合作。有数学家认为,这就像是伽利略有了望远镜,能够凝视数据宇宙的深处,看到之前从未探测到的东西。以下是这篇论文的翻译。

研究领域:人工智能,机器学习,纽结理论,表示论

论文题目:

Advancing mathematics by guiding human intuition with AI

论文链接:

https://www.nature.com/articles/s41586-021-04086-x

1. 摘要

数学的实践包括发现模型、使用它们来提出和证明猜想,得出定理。自 19 世纪 60 年代以来,数学家一直使用计算机来协助构建模型和提出猜想[1] ,最著名的是贝赫和斯维讷通-戴尔猜想(the Birch and Swinnerton-Dyer conjecture)[2] ,这是一个千禧年大奖难题[3] 。在这里,我们给出了在机器学习的帮助下发现基础数学新基本结果的例子,展示了机器学习可以帮助数学家发现新猜想和定理。我们提出了一个使用机器学习的过程来发现数学对象之间的潜在模式和关系,通过归因技术(attribution techniques)理解它们,并使用这些观察来指导直觉和提出猜想。我们概述了机器学习引导提出数学定理的框架,并展示了它在基础数学中不同领域的当前研究问题中的成功应用,在每种情况下都展示了它如何对重要的开放问题做出有意义的数学贡献:代数和几何结构之间的新联系,以及由对称群的组合不变性猜想预测的候选算法[4]。我们的工作可以作为数学和人工智能 (AI) 领域之间合作的模型,通过利用数学家和机器学习各自的优势,可以取得令人惊讶的成就。

2. 引入

数学进步的核心驱动力之一是发现模型和形成有用的猜想(被猜测为真但尚未被证明在所有情况下都成立的陈述)。数学家一直使用数据来辅助这个过程——从高斯和其他人使用的早期手工计算的素数表引导素数定理的发现[5],到现代计算机生成的数据[1,5],例如证明贝赫和斯维讷通-戴尔猜想[2]时的情况。用于生成数据和测试猜想的计算机的引入使数学家对以前无法解决的问题有了新的理解[6]。虽然计算机技术在过程的其他部分是有用的 [7,8] ,但是人工智能 (AI) 系统还没有取得类似的地位。先前用于生成猜想的系统要么通过不容易推广到其他数学领域的方法[9]贡献了真正有用的研究猜想[10] ,要么已经展示了新的、通用的方法来寻找尚未产生数学价值的猜想[11]。

人工智能,尤其是机器学习领域[12-14],提供了一系列可以有效检测数据模式的技术,并且越来越多地证明其在科学学科中的实用性[15]。在数学中,我们已经表明人工智能可以作为一种有价值的工具,通过寻找现有猜想的反例[16]、加速计算[17]、生成符号解[18]和检测数学对象中结构的存在[19]。在这项工作中,我们证明人工智能也可用于协助发现数学研究前沿的定理和猜想。通过专注于使数学家能够理解机器学习得到的函数并获得有用的数学洞察力,人工智能扩展了可以使用监督学习来发现模型[20-24]的工作。我们提出了一个框架,用来使用机器学习的强大模式识别能力和解释方法来增强标准数学工具包,并通过展示它如何引导我们获得两个基本的新发现——一个是拓扑学,另一个是表示论——来证明它的价值和普遍性。我们的贡献展示了成熟的机器学习方法如何适应并集成到现有的数学工作流程中以获得新颖的结果。

3. 使用AI引导数学直觉

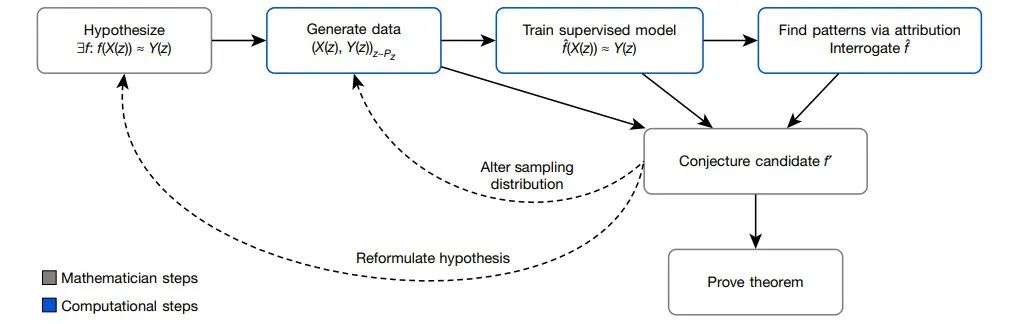

数学家的直觉在数学发现中起着极其重要的作用——“只有将严谨的形式主义和良好的直觉结合起来,才能解决复杂的数学问题”[25]。下面的框架(如图1所示)描述了一种通用方法,通过该方法,数学家可以使用机器学习中的工具来指导他们对复杂数学对象的直觉,验证他们关于关系可能存在的假设并帮助理解这些关系。我们认为,这是一种自然且富有成效的方式,可以将统计学和机器学习中这些广为人知的技术做为数学家工作的一部分。

图1. 框架流程图。通过训练机器学习模型来估计特定数据P(Z)分布上的函数,该过程有助于引导数学家对猜想的函数f的直觉。来自学习函数 的准确性的见解和应用于它的归因技术,可以帮助理解问题和构建封闭形式的 f′。该过程是迭代和交互的,而不是一系列的顺序执行的步骤。

的准确性的见解和应用于它的归因技术,可以帮助理解问题和构建封闭形式的 f′。该过程是迭代和交互的,而不是一系列的顺序执行的步骤。

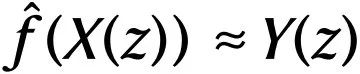

具体而言,它可以帮助数学家获得直觉,了解由 z 联系起来的两个数学对象 X(z) 和Y(z) 之间的关系,该过程通过找到满足 的学习函数

的学习函数 ,并分析它以了解这种关系的性质。举个例子:设 z 是凸多面体,

,并分析它以了解这种关系的性质。举个例子:设 z 是凸多面体, 是 z 的顶点和边的数量,以及体积和表面积,Y(z)∈ℤ 是 z 的面。欧拉公式表明,在这种情况下,X(z)和Y(z)之间存在精确的关系:X(z)·(−1, 1, 0, 0)+2=Y(z)。* 在这个简单的例子中,使用许多其他方法,都可以通过数据驱动猜想生成的传统方法重新发现这种关系[1]。然而,对于高维空间中的X(z)和Y(z),或更复杂的数据,例如图,以及更复杂的非线性的

是 z 的顶点和边的数量,以及体积和表面积,Y(z)∈ℤ 是 z 的面。欧拉公式表明,在这种情况下,X(z)和Y(z)之间存在精确的关系:X(z)·(−1, 1, 0, 0)+2=Y(z)。* 在这个简单的例子中,使用许多其他方法,都可以通过数据驱动猜想生成的传统方法重新发现这种关系[1]。然而,对于高维空间中的X(z)和Y(z),或更复杂的数据,例如图,以及更复杂的非线性的 ,这种方法要么不太管用,要么完全不可行。

,这种方法要么不太管用,要么完全不可行。

*注:例如,我们常见的欧拉公式形式为F-E+V=2,即 -V+E+2=F,V、E、F分别表示顶点、边、面的数量。

该框架以两种方式帮助引导数学家的直觉:(1)通过使用监督机器学习验证数学对象猜想的结构/模式存在;(2)使用归因技术帮助理解这些模式。

在监督学习阶段,数学家猜测 X(z) 和Y(z)之间存在关系。通过生成X(z)和Y(z)的数据集,我们可以使用监督学习,仅使用X(z)作为输入来训练预测Y(z)的函数 。机器学习在这个回归过程中的关键贡献是,在给定足够数量数据的情况下可以学习广泛的可能的非线性函数。如果

。机器学习在这个回归过程中的关键贡献是,在给定足够数量数据的情况下可以学习广泛的可能的非线性函数。如果 给出的结果偶然比预期的结果更准确,则表明可能存在这样的关系需要探索。如果是这样,归因技术可以帮助理解学习函数

给出的结果偶然比预期的结果更准确,则表明可能存在这样的关系需要探索。如果是这样,归因技术可以帮助理解学习函数 ,这足以让数学家猜测候选函数f'。归因技术可用于了解

,这足以让数学家猜测候选函数f'。归因技术可用于了解 的哪些方面与Y(z)的预测相关。例如,许多归因技术旨在量化函数

的哪些方面与Y(z)的预测相关。例如,许多归因技术旨在量化函数 对X(z)的哪个分量敏感。我们在工作中使用的归因技术——梯度显著性(Gradient Saliency),是通过计算

对X(z)的哪个分量敏感。我们在工作中使用的归因技术——梯度显著性(Gradient Saliency),是通过计算 的输出关于输入的导数来实现的。这允许数学家识别问题中最有可能与X(z)和Y(z)关系相关的方面,并对其进行优先级排序。在解决一个可行的猜想之前,这个迭代过程可能需要重复几次。在这个过程中,数学家可以指导猜想的选择,这些猜想不仅能拟合数据,而且看起来很有趣,似乎是真实的。在理想情况下,这个过程暗示了证明策略。

的输出关于输入的导数来实现的。这允许数学家识别问题中最有可能与X(z)和Y(z)关系相关的方面,并对其进行优先级排序。在解决一个可行的猜想之前,这个迭代过程可能需要重复几次。在这个过程中,数学家可以指导猜想的选择,这些猜想不仅能拟合数据,而且看起来很有趣,似乎是真实的。在理想情况下,这个过程暗示了证明策略。

从概念上讲,这个框架提供了一个“直觉试验台”——快速验证我们关于两个量之间关系的直觉是否值得追求。如果是,该框架可以指导两个量之间如何相关。我们已经使用上述框架帮助数学家在两种情况下获得了有影响力的数学结果——发现和证明了纽结理论中代数和几何不变量之间的关系,并推测出对称群组合不变性猜想的证明方案[4] ,这是表示论中的一个著名猜想。在每个领域,我们都展示了该框架如何成功地帮助指导数学家得到结果。在每种情况下,都可以使用具有单个图形处理单元(GPU)的机器,在几个小时内训练必要的模型。

4. 拓扑学:

纽结理论中代数与几何不变量的关系

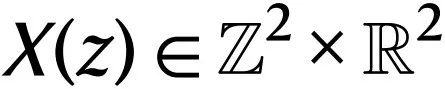

低维拓扑是数学中一个活跃且有影响的领域。纽结是R3空间中的简单闭合曲线,是研究的重点对象之一。课题的一些主要目标是对它们进行分类,了解它们的特性并建立与其他领域的联系。实现这一点的主要方法之一是通过不变量,即对于任何两个等价纽结都相同的代数、几何或数值量。这些不变量以许多不同的方式推导出来,但我们关注两个主要类别:双曲不变量和代数不变量。这两种类型的不变量源自完全不同的数学领域,因此在它们之间建立联系非常有趣。图2显示了纽结不变量的一些例子。推测连接的一个显著例子是体积猜想(volume conjecture) [26],该猜想提出,纽结的双曲体积(几何不变量)应该编码在着色琼斯多项式(coloured Jones polynomials)(代数不变量)的渐进行为中。

图2. 三个双曲纽结的不变量示例。我们假设几何和代数不变量之间存在先前未发现的关系。

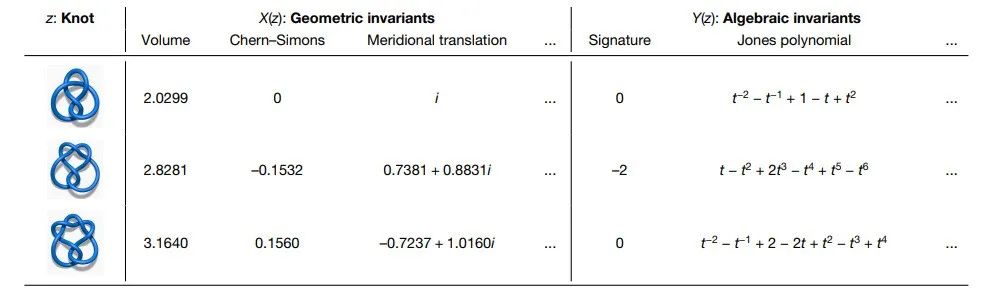

我们的假设是,纽结的双曲不变量和代数不变量之间存在一种未被发现的关系。监督学习模型能够检测,很多几何不变量和符号差 σ(K)(signature)之间存在一种模式,这里的符号差可编码关于纽结K的重要信息,但之前人们并不知道它与双曲几何有关。如图3a所示,归因技术确定的最相关的特征是尖形几何(cusp geometry)的三个不变量,图3b中部分地显示了这种关系。使用仅由这些测量值组成的X(z)训练第二个模型实现了非常相似的准确度,这表明它们是一组足够的特征,可以捕获几何不变量对符号差的几乎所有影响。这三个不变量是横向平移μ和纵向平移λ的实部和虚部。这些量与符号差之间存在非线性的多元关系。在被引导关注这些不变量后,我们发现,通过使用一个与符号差线性相关的新数学量,可以更好地理解这种关系。

图3. 扭结理论归因。a. 每个输入X(z)的属性值。具有高值的特征是那些学习函数最敏感的特征,并且可能与进一步探索相关。95% 置信区间误差线跨越模型的 10 次重新训练。b. 相关特征的示例可视化——经向平移相对于符号差的实部,由纵向平移着色。

我们引入了“自然斜率”(natural slope),定义为 slope(K)=Re(λ/μ),其中Re表示实部。它有以下几何解释:可以将经线实现为欧几里得环面上的测地线γ。如果给出正交的测地线γ⊥,它最终会返回并与γ 交于某点。这样做时,它将沿着经度减去纬度的倍数行进,这个倍数就是自然斜率。它不必是整数,因为 γ⊥ 的端点可能与其起点不同。我们最初关于自然斜率和特征的猜想如下。

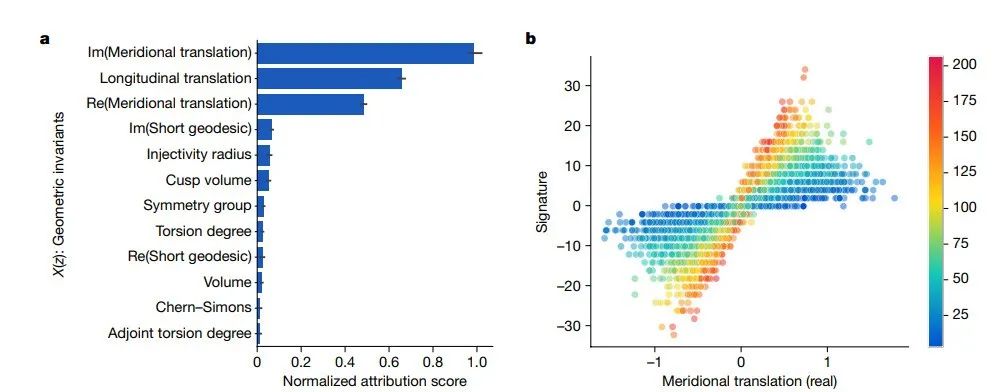

猜想:存在常数c1和c2,使得对于每个双曲扭结K,

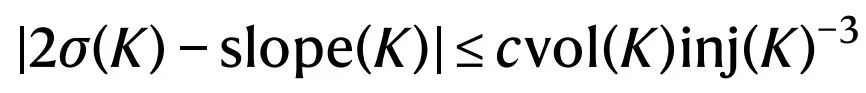

虽然这一猜想得到了对从不同分布采样的几个大型数据集的分析的支持,但我们能够使用特定形式的编织(braiding)构建反例。随后,我们建立斜率 slope(K)、符号差 σ(K)、体积 vol(K) 和第二个最显著的几何不变量——注入半径(injectivity radius)inj(K)之间的关系[27]。

定理:存在一个常数c使得对于任何双曲扭结K,

事实证明,注入半径往往不会变得非常小,即使对于大体积的纽结也是如此。因此,inj(K)-3这一项在测试中往往不会变得非常大。但是显然需要有一个定理来避免对 inj(K)-3的依赖,我们给出的结果依赖于短测地线,这是补充信息中的另一个显著特征。上述定理的更多细节和完整证明可在参考文献[27]中找到。在我们生成的数据集中,可以设置c ≥0.23392的下限,推测c最大在0.3是合理的,这在我们计算的区域中给出了紧密的关系。

上述定理是连接纽结的代数和几何不变量的结果之一,它具有各种有趣的应用。它直接暗示符号差控制纽结上的非双曲 Dehn 手术(Dehn surgery),自然斜率控制 空间表面的亏格,

空间表面的亏格, 空间的边界为扭结。我们预计新发现的自然斜率和特征之间的关系将在低维拓扑中具有许多其他应用。令人惊讶的是,在一个已被广泛研究的领域中,这种简单而深刻的联系却被忽视了。

空间的边界为扭结。我们预计新发现的自然斜率和特征之间的关系将在低维拓扑中具有许多其他应用。令人惊讶的是,在一个已被广泛研究的领域中,这种简单而深刻的联系却被忽视了。

5. 表示论:对称群组合不变性猜想

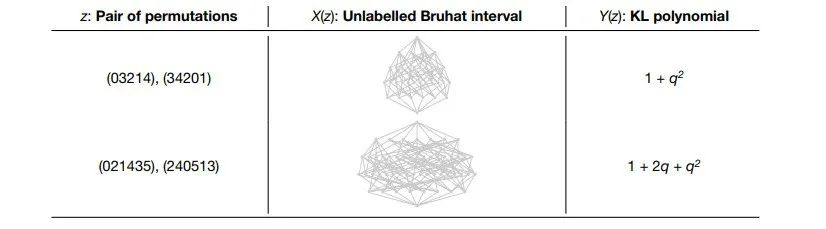

表示论是线性对称的理论。所有表示的组成单元都是不可约的,理解它们是表示论最重要的目标之一。不可约表示概括了傅立叶分析的基本频率[28] 。在几个重要的例子中,不可约表示的结构由 Kazhdan-Lusztig(KL)多项式控制,这些多项式与组合学、代数几何和奇点理论有着深厚的联系。KL多项式是附加到对称群中的元素对(或者更一般地说,Coxeter群中的元素对)的多项式。组合不变性猜想(combinatorial invariance conjecture)是关于KL多项式的一个引人入胜的开放猜想,它已经存在 40 年,其证明仅取得了部分进展[29]。它指出,对称群SN中两个元素的 KL 多项式可以从它们未标记的 Bruhat 区间 [30](一个有向图)中计算出来。理解这些对象之间关系的一个障碍是,非平凡KL多项式(不等于1的那些)的 Bruhat 区间是非常大的图,很难建立直觉。图4显示了一些小的Bruhat区间及其 KL 多项式的例子。

图4. 两个示例数据集元素,一个来自S5,一个来自S6。组合不变性猜想指出,一对置换的KL多项式应该可以从它们未标记的Bruhat区间计算出来,但是此前人们并不知道计算的函数。

注:Bruhat 区间是一种图,表示一次只交换两个对象,让集合中的对象逆转顺序的所有不同方式。KL多项式告诉数学家关于这个图在高维空间中存在的不同方式的一些深刻而微妙的性质。只有当 Bruhat 区间有100或1000个顶点时,才会出现有趣的结构。

我们将此猜想作为初始假设,并发现监督学习模型能够以相当高的准确度从Bruhat区间预测KL多项式。通过对我们将Bruhat区间输入网络的方式进行实验,很明显,某些图和特征的选择特别有助于准确预测。特别是,我们发现一个受先前工作[31]启发的子图可能足以计算 KL多项式,这得到了一个更准确的估计函数的支持。

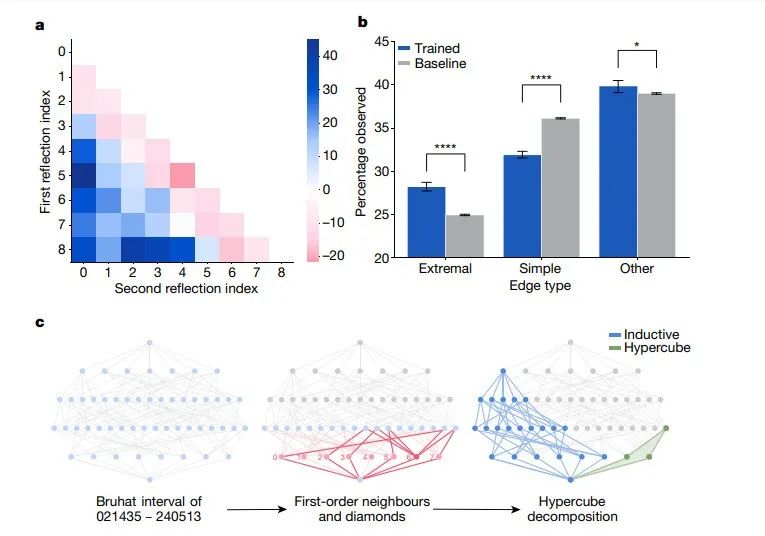

通过计算归因技术确定为最相关的显著子图,并分析这些图相比于初始图的边缘分布,我们发现了进一步的结构证据。在图5a中,我们通过它们表示的反射(reflection,欧氏空间中把一个物体变换成它的镜像的映射)来汇总显著子图中边缘的相对频率。它表明极值反射(extremal reflection),对于SN中(形式为(0, i)或(i, N−1)的那些)在显著子图中比人们预期的更常见,代价是简单的反射(形式为(i, i+ 1)),这在图5b中模型的多次重新训练中得到证实。这是值得注意的,因为边缘标签没有被提供给网络,并且无法从未标记的Bruhat区间中恢复。从KL多项式的定义可以直观看出,简单反射和非简单反射的区别与计算它有关;然而,最初并不能明显看出,极值反射会在显著子图中过多表示。考虑到这一观察结果,我们发现一个区间可以自然分解为两部分——由一组极值边缘诱导的超立方体,和与一个与 SN-1 中的区间同构的图。

图 5. 表示论归因。a. 在预测q4时,与数据集中跨区间的平均值相比,显著子图中存在的反射增加百分比的示例热图。b. 与来自数据集的10个相同大小的自举样本相比,模型的10次再训练在显著子图中观察到的每种类型的边缘的百分比。误差线是95%的置信区间,显示的显著性水平是使用双侧双样本t检验确定的。*p < 0.05;****p < 0.0001。c,通过假设、监督学习和归因的迭代过程发现的有趣子结构的区间021435–240513∈S6的说明。受先前工作[31]启发的子图以红色突出显示,超立方体以绿色突出显示,分解成分与SN-1中的区间同构以蓝色突出显示。

这两种结构的重要性,如图5c所示,证明了KL多项式可以通过补充信息中总结的漂亮公式直接从超立方体和SN-1成分中计算。数学结果的进一步详细处理在参考文献[32]中给出。

定理:每个Bruhat区间都允许沿其极值反射进行典型超立方体分解,从中可以直接计算KL多项式。

值得注意的是,进一步的测试表明所有的超立方体分解都正确地确定了KL多项式。对于直到S7的对称群中的所有大约3×106个区间和从对称群S8和S9采样的超过1.3×105的非同构区间,都可以进行计算验证。

猜想:无标记的Bruhat区间的KL多项式可以用前面的公式计算出任何超立方体分解来得到。

这个猜想的解决方案,如果被证明是正确的,将解决对称群的组合不变性猜想。这是一个很有前景的方向,因为该猜想不仅在相当多的例子中得到了经验验证,而且还有一个特别好的形式,可以提出攻破该猜想的潜在途径。这个案例展示了如何从训练的模型中获得关于大型数学对象行为的非微观见解,从而发现新的结构。

6. 结论

在这项工作中,我们展示了一个数学家使用机器学习的框架,该框架导致了两个不同学科的数学洞察力:纽结的代数和几何结构之间的第一个联系,以及对表示论中一个长期未决猜想的可能证明方案。我们不是使用机器学习直接生成猜想,而是专注于帮助指导数学家高度专业的直觉,产生既有趣又深刻的结果。很明显,直觉在许多人类追求的精英表现中起着重要作用。例如,它对顶级围棋玩家至关重要,而AlphaGo[33]的成功部分来自于它使用机器学习来学习人类凭直觉执行的游戏元素的能力。它对顶级数学家也至关重要——拉马努金被称为直觉之王 [34],可以激发著名数学家对其在各自领域中的地位的反思 [35,36]。由于数学是一项与围棋截然不同、更具合作性的工作,人工智能在辅助直觉方面的作用要自然得多。在这里,我们表明在协助数学家进行这方面的工作方面,确实存在富有成效的空间。

我们的案例研究表明,在一个被充分研究的、数学上有趣的领域中,一个基础性的联系是如何被忽视的,以及这个框架如何让数学家更好地理解那些大到他们无法观察到的物体的行为模式。这个框架在哪些方面有用是有限制的——它需要有能力生成对象表示的大型数据集,并且在可计算的例子中可以发现模型。此外,在某些领域中,感兴趣的功能可能难以在这种范式下学习。然而,我们相信有许多领域可以从该方法中受益。更广泛地说,我们希望这个框架是一种有效的机制,允许将机器学习引入数学家的工作,并鼓励两个领域之间的进一步合作。

参考文献

1. Borwein, J. & Bailey, D. Mathematics by Experiment (CRC, 2008).

2. Birch, B. J. & Swinnerton-Dyer, H. P. F. Notes on elliptic curves. II. J. Reine Angew. Math. 1965, 79–108 (1965).

3. Carlson, J. et al. The Millennium Prize Problems (American Mathematical Soc., 2006).

4. Brenti, F. Kazhdan-Lusztig polynomials: history, problems, and combinatorial invariance. Sémin. Lothar. Combin. 49, B49b (2002).

5. Hoche, R. Nicomachi Geraseni Pythagorei Introductions Arithmeticae Libri 2 (In aedibus BG Teubneri, 1866).

6. Khovanov, M. Patterns in knot cohomology, I. Exp. Math. 12, 365–374 (2003).

7. Appel, K. I. & Haken, W. Every Planar Map Is Four Colorable Vol. 98 (American Mathematical Soc., 1989).

8. Scholze, P. Half a year of the Liquid Tensor Experiment: amazing developments Xena https://xenaproject.wordpress.com/2021/06/05/half-a-year-of- the-liquid-tensor- experiment-amazing-developments/ (2021).

9. Fajtlowicz, S. in Annals of Discrete Mathematics Vol. 38 113–118 (Elsevier, 1988).

10. Larson, C. E. in DIMACS Series in Discrete Mathematics and Theoretical Computer Science Vol. 69 (eds Fajtlowicz, S. et al.) 297–318 (AMS & DIMACS, 2005).

11. Raayoni, G. et al. Generating conjectures on fundamental constants with the Ramanujan machine. Nature 590, 67–73 (2021).

12. MacKay, D. J. C. Information Theory, Inference and Learning Algorithms (Cambridge Univ. Press, 2003).

13. Bishop, C. M. Pattern Recognition and Machine Learning (Springer, 2006).

14. LeCun, Y., Bengio, Y. & Hinton, G. Deep learning. Nature 521, 436–444 (2015).

15. Raghu, M. & Schmidt, E. A survey of deep learning for scientific discovery. Preprint at https://arxiv.org/abs/2003.11755 (2020).

16. Wagner, A. Z. Constructions in combinatorics via neural networks. Preprint at https://arxiv.org/abs/2104.14516 (2021).

17. Peifer, D., Stillman, M. & Halpern-Leistner, D. Learning selection strategies in Buchberger’s algorithm. Preprint at https://arxiv.org/abs/2005.01917 (2020).

18. Lample, G. & Charton, F. Deep learning for symbolic mathematics. Preprint at https://arxiv.org/abs/1912.01412 (2019).

19. He, Y.-H. Machine-learning mathematical structures. Preprint at https://arxiv.org/abs/2101.06317 (2021).

20. Carifio, J., Halverson, J., Krioukov, D. & Nelson, B. D. Machine learning in the string landscape. J. High Energy Phys. 2017, 157 (2017).

21. Heal, K., Kulkarni, A. & Sertöz, E. C. Deep learning Gauss-Manin connections. Preprint at https://arxiv.org/abs/2007.13786 (2020).

22. Hughes, M. C. A neural network approach to predicting and computing knot invariants. Preprint at https://arxiv.org/abs/1610.05744 (2016).

23. Levitt, J. S. F., Hajij, M. & Sazdanovic, R. Big data approaches to knot theory: understanding the structure of the Jones polynomial. Preprint at

https://arxiv.org/abs/1912.10086 (2019).

24. Jejjala, V., Kar, A. & Parrikar, O. Deep learning the hyperbolic volume of a knot. Phys. Lett. B 799, 135033 (2019).

25. Tao, T. There’s more to mathematics than rigour and proofs Blog https://terrytao.wordpress.com/career-advice/theres-more-to-mathematics-than-rigour-and-proofs/ (2016).

26. Kashaev, R. M. The hyperbolic volume of knots from the quantum dilogarithm. Lett. Math. Phys. 39, 269–275 (1997).

27. Davies, A., Lackenby, M., Juhasz, A. & Tomašev, N. The signature and cusp geometry of hyperbolic knots. Preprint at arxiv.org (in the press).

28. Curtis, C. W. & Reiner, I. Representation Theory of Finite Groups and Associative Algebras Vol. 356 (American Mathematical Soc., 1966).

29. Brenti, F., Caselli, F. & Marietti, M. Special matchings and Kazhdan–Lusztig polynomials. Adv. Math. 202, 555–601 (2006).

30. Verma, D.-N. Structure of certain induced representations of complex semisimple Lie algebras. Bull. Am. Math. Soc. 74 , 160–166 (1968).

31. Braden, T. & MacPherson, R. From moment graphs to intersection cohomology. Math. Ann. 321, 533–551 (2001).

32. Blundell, C., Buesing, L., Davies, A., Veličković, P. & Williamson, G. Towards combinatorial invariance for Kazhdan-Lusztig polynomials. Preprint at arxiv.org (in the press).

33. Silver, D. et al. Mastering the game of Go with deep neural networks and tree search. Nature 529, 484–489 (2016).

34. Kanigel, R. The Man Who Knew Infinity: a Life of the Genius Ramanujan (Simon and Schuster, 2016).

35. Poincaré, H. The Value of Science: Essential Writings of Henri Poincaré (Modern Library, 1907).

36. Hadamard, J. The Mathematician’s Mind (Princeton Univ. Press, 1997).

37. Bronstein, M. M., Bruna, J., Cohen, T. & Veličković, P. Geometric deep learning: grids, groups, graphs, geodesics, and gauges. Preprint at https://arxiv.org/abs/2104.13478 (2021).

38. Efroymson, M. A. in Mathematical Methods for Digital Computers 191–203 (John Wiley, 1960).

39. Xu, K. et al. Show, attend and tell: neural image caption generation with visual attention. In Proc. International Conference on Machine Learning 2048–2057 (PMLR, 2015).

40. Sundararajan, M., Taly, A. & Yan, Q. Axiomatic attribution for deep networks. In Proc. International Conference on Machine Learning 3319–3328 (PMLR, 2017).

41. Bradbury, J. et al. JAX: composable transformations of Python+NumPy programs (2018); https://github.com/google/jax

42. Martín A. B. A. D. I. et al. TensorFlow: large-scale machine learning on heterogeneous systems (2015); https://doi.org/10.5281/zenodo.4724125.

43. Paszke, A. et al. in Advances in Neural Information Processing Systems 32 (eds Wallach, H. et al.) 8024–8035 (Curran Associates, 2019).

44. Thurston, W. P. Three dimensional manifolds, Kleinian groups and hyperbolic geometry. Bull. Am. Math. Soc 6, 357–381 (1982).

45. Culler, M., Dunfield, N. M., Goerner, M. & Weeks, J. R. SnapPy, a computer program for studying the geometry and topology of 3-manifolds (2020); http://snappy.computop.org.

46. Burton, B. A. The next 350 million knots. In Proc. 36th International Symposium on Computational Geometry (SoCG 2020) (Schloss Dagstuhl-Leibniz-Zentrum für Informatik, 2020).

47. Warrington, G. S. Equivalence classes for the μ-coefficient of Kazhdan–Lusztig polynomials in Sn. Exp. Math. 20, 457–466 (2011).

48. Gilmer, J., Schoenholz, S. S., Riley, P. F., Vinyals, O. & Dahl, G. E. Neural message passing for quantum chemistry. Preprint at https://arxiv.org/abs/1704.01212 (2017).

49. Veličković, P., Ying, R., Padovano, M., Hadsell, R. & Blundell, C. Neural execution of graph algorithms. Preprint at https://arxiv.org/abs/1910.10593 (2019).

(参考文献可上下滑动查看)

未来智能实验室的主要工作包括:建立AI智能系统智商评测体系,开展世界人工智能智商评测;开展互联网(城市)大脑研究计划,构建互联网(城市)大脑技术和企业图谱,为提升企业,行业与城市的智能水平服务。每日推荐范围未来科技发展趋势的学习型文章。目前线上平台已收藏上千篇精华前沿科技文章和报告。

如果您对实验室的研究感兴趣,欢迎加入未来智能实验室线上平台。扫描以下二维码或点击本文左下角“阅读原文”

)