来源:ScienceAI

编辑:萝卜皮

当今最成功的人工智能算法——人工神经网络,松散地基于我们大脑中复杂的真实神经网络网络。但与我们高效的大脑不同,在计算机上运行这些算法会消耗巨大的能量:最大的模型在其生命周期中消耗的能量几乎与五辆汽车一样多。

进入神经形态计算,它更接近我们大脑的设计原理和物理特性,可能成为未来人工智能节能的新方向。神经形态设计不是在中央处理单元和内存芯片之间长距离穿梭数据,而是模仿我们头脑中果冻状物质的结构,计算单元(神经元)放置在内存旁边(存储在连接神经元的突触中)。

为了使它们更像大脑,研究人员将神经形态芯片与模拟计算相结合,模拟计算可以处理连续信号,就像真正的神经元一样。由此产生的芯片与当前依赖于 0 和 1 二进制信号处理的纯数字计算机的架构和计算模式有很大不同。

以大脑为向导,神经形态芯片有望在某一天消除人工智能等数据密集型计算任务的能耗限制。不幸的是,由于被称为设备不匹配的问题,人工智能算法在这些芯片的模拟版本上表现不佳:在芯片上,模拟神经元内的微小组件由于制造过程中的误差而在尺寸上不匹配。由于单个芯片不够复杂,无法运行最新的训练程序,因此必须首先在计算机上对算法进行数字化训练。但是,当算法转移到芯片上时,一旦遇到模拟硬件上的不匹配,它们的性能就会崩溃。

Friedrich Miescher 生物医学研究所和海德堡大学的研究人员,于 2022 年 1 月发表在《PNAS》上的一篇题为「Surrogate gradients for analog neuromorphic computing」的论文揭示了绕过这个问题的方法。

该团队表明,一种称为尖峰神经网络的人工智能算法——它使用大脑的独特通信信号,称为尖峰——可以与芯片一起学习如何补偿设备不匹配。这篇论文是朝着使用 AI 进行模拟神经形态计算迈出的重要一步。

论文链接:https://www.pnas.org/doi/10.1073/pnas.2109194119

「令人惊奇的是,它运行得非常好!」荷兰国家数学和计算机科学研究所 CWI 的脉冲神经网络专家 Sander Bohte 说, 「这是一项相当大的成就,可能是更多模拟神经形态系统的蓝图。」

模拟计算对基于大脑的计算的重要性是微妙的。数字计算可以有效地表示大脑尖峰信号的一个二进制,即一种像闪电一样穿过神经元的电脉冲。与二进制数字信号一样,要么发出尖峰信号,要么不发出尖峰信号。但是随着时间的推移,尖峰是连续发送的——这是一个模拟信号——我们的神经元首先决定发出尖峰的方式也是连续的,这取决于细胞内随时间变化的电压。(与细胞外电压相比,当电压达到特定阈值时,神经元会发出尖峰信号。)

「在类比中,大脑核心计算的巧妙之处便在于此。模拟大脑的这一关键方面是神经形态计算的主要驱动力之一。」苏黎世大学和苏黎世联邦理工学院的神经形态工程研究员 Charlotte Frenkel 说。

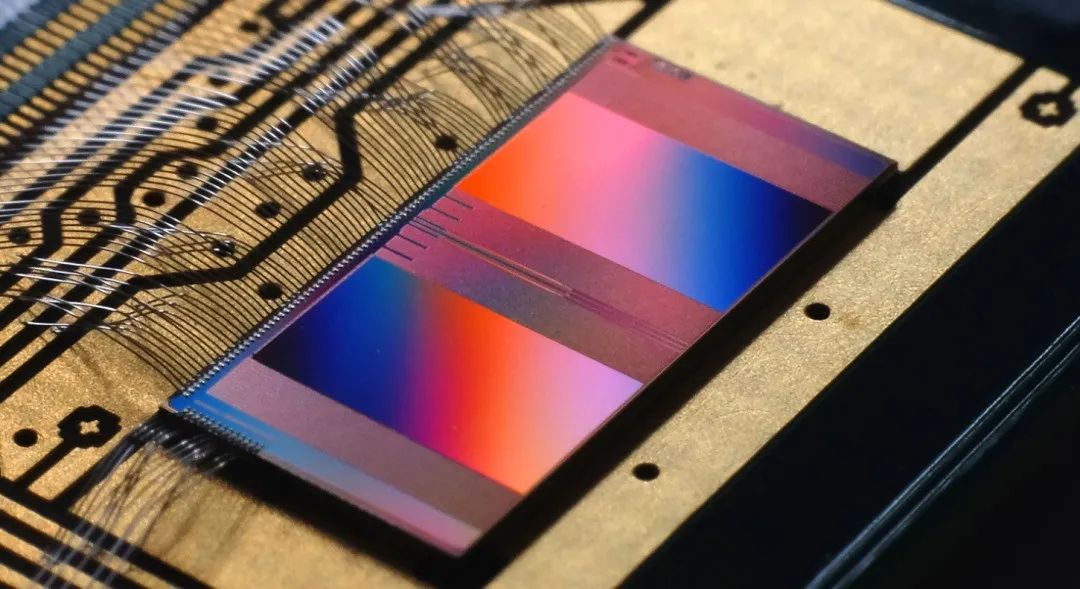

2011 年,海德堡大学的一组研究人员开始开发一种兼具模拟和数字功能的神经形态芯片,以对大脑进行密切建模以进行神经科学实验。现在由 Schemmel 领导的团队推出了最新版本的芯片,称为 BrainScaleS-2。芯片上的每个模拟神经元都可以模仿脑细胞的输入和输出电流和电压变化。

「你真的拥有了一个不断交换信息的动态系统。」Schemmel 说,而且由于材料具有不同的电气特性,芯片传输信息的速度比我们的大脑快 1000 倍。

但是由于模拟神经元的特性变化如此之小——设备不匹配问题——电压和电流水平也因神经元而异。算法无法处理这个问题,因为它们是在具有完全相同数字神经元的计算机上训练的,突然它们在芯片上性能直线下降。

新研究展示了前进的方向。通过将芯片包含在训练过程中,作者表明脉冲神经网络可以学习如何校正 BrainScaleS-2 芯片上的不同电压。「这种训练设置是第一个令人信服的证据,证明可变性不仅可以[补偿],而且可能被利用。」Frenkel 说。

为了解决设备不匹配问题,该团队将一种允许芯片与计算机对话的方法与一种称为代理梯度的新学习方法相结合,该方法由 Zenke 共同开发,专门用于脉冲神经网络。它通过改变神经元之间的连接,来最小化神经网络在任务中产生的错误数量。(这类似于非尖峰神经网络使用的方法,称为反向传播。)

实际上,替代梯度方法能够在计算机训练期间纠正芯片的缺陷。首先,脉冲神经网络使用芯片上模拟神经元的变化电压执行一项简单的任务,将电压记录发送回计算机。在那里,该算法自动学习如何最好地改变其神经元之间的连接,以仍然与模拟神经元很好地配合,并在学习的同时不断地在芯片上更新它们。然后,当训练完成时,脉冲神经网络在芯片上执行任务。

研究人员报告说,他们的网络在语音和视觉任务上达到了与在计算机上执行任务的顶级尖峰神经网络相同的准确度水平。换句话说,该算法准确地了解了克服设备不匹配问题需要做出哪些改变。

苏塞克斯大学的计算神经科学家 Thomas Nowotny 说:「他们用这个系统解决真正问题所取得的性能是一项巨大的成就。」 而且,正如预期的那样,它们的能源效率令人印象深刻;作者表示,在芯片上运行他们的算法所消耗的能量比标准处理器所需的能量少 1000 倍。

然而,Frenkel 指出,虽然到目前为止能耗是个好消息,但神经形态芯片仍需要通过针对类似语音和视觉识别任务进行优化的硬件来证明自己,而不是标准处理器。Nowotny 警告说,这种方法可能难以扩展到大型实际任务,因为它仍然需要在计算机和芯片之间来回穿梭数据。

长期目标是让神经网络从头到尾在神经形态芯片上训练和运行,根本不需要计算机。但这需要构建新一代芯片,这需要数年时间,Nowotny 说。

目前,Zenke 和 Schemmel 的团队已经证明,脉冲神经网络算法可以处理神经形态硬件上模拟神经元之间的微小变化。「您可以依靠 60 或 70 年的数字计算经验和软件历史。」Schemmel 说,「对于这种模拟计算,我们必须自己做所有事情。」

相关报道:https://www.quantamagazine.org/ai-overcomes-stumbling-block-on-brain-inspired-hardware-20220217/

未来智能实验室的主要工作包括:建立AI智能系统智商评测体系,开展世界人工智能智商评测;开展互联网(城市)大脑研究计划,构建互联网(城市)大脑技术和企业图谱,为提升企业,行业与城市的智能水平服务。每日推荐范围未来科技发展趋势的学习型文章。目前线上平台已收藏上千篇精华前沿科技文章和报告。

如果您对实验室的研究感兴趣,欢迎加入未来智能实验室线上平台。扫描以下二维码或点击本文左下角“阅读原文”