文章目录

- 1 Mispronunciation

- 2 More information for Encoder

- 3 Attention

- 4 Fast Speech and DurIAN

- 5 Dual Learning

- 5 Controllable TTS

- Speaker Embedding

- GST-Tacotron

- Two-stage Training

本文为李弘毅老师【Speech Synthesis - More than Tacotron】的课程笔记,课程视频youtube地址,点这里👈(需翻墙)。

下文中用到的图片均来自于李宏毅老师的PPT,若有侵权,必定删除。

文章索引:

上篇 - 4-1 Tacotron

下篇 - 5 Speaker Verification

总目录

1 Mispronunciation

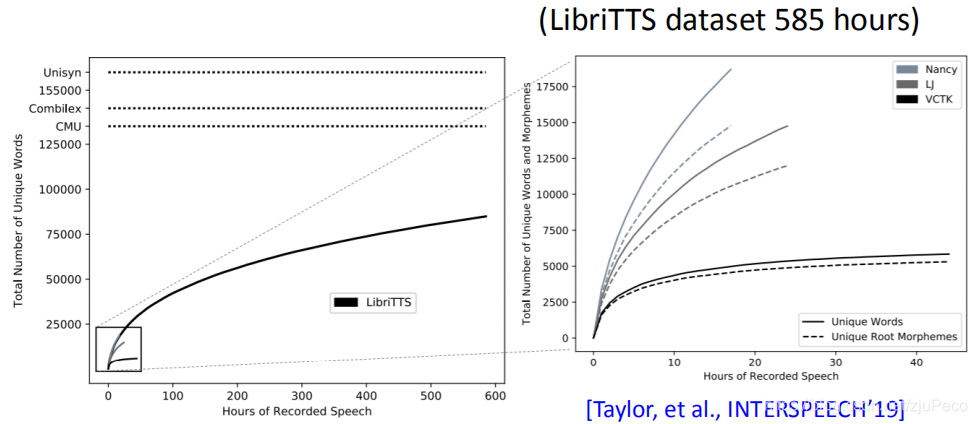

当打分者在给Tacotron打分的时候,打分者认为Tacotron比ground truth分数低的原因是,Tacotron有时会拼错音,这有点让人感到突兀。而这也是因为Tacotron训练时用到的数据集包含的词汇量太少了。如下图所示,最大的LibrTTS dataset,其中的词汇量也就只有七八万的样子,差不多时英文词汇量的十分之一,更关键的是,不断会有新的英文词汇在生活中涌现出来,面对这些新的词汇,Tacotron只能猜一猜了。

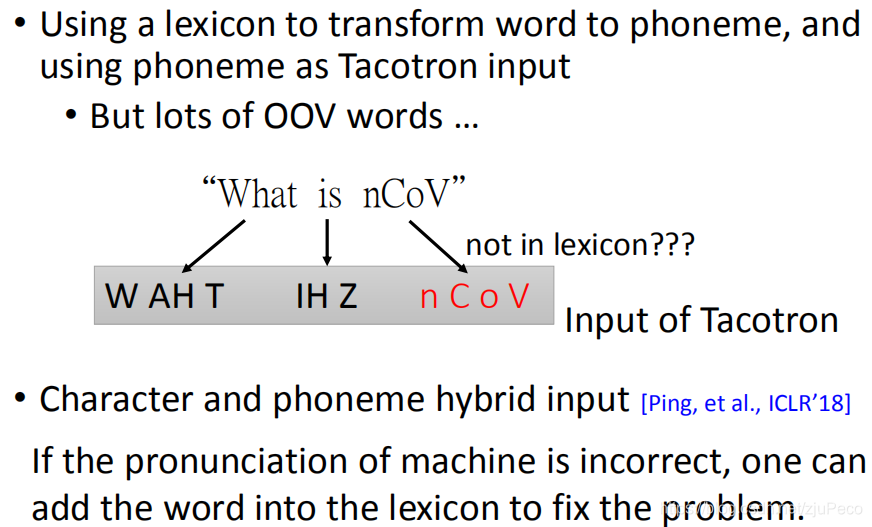

所以,有一种办法就是,构建一个把单词转化为发音单元的lexicon,然后输入发音单元就可以了。不过这种办法的问题在于,lexicon没法包含所有的词汇,比如下图中的"nCoV"这样没在lexicon中的单词出现了的话,模型就没办法了。不过这个lexicon可以一直更新。

2 More information for Encoder

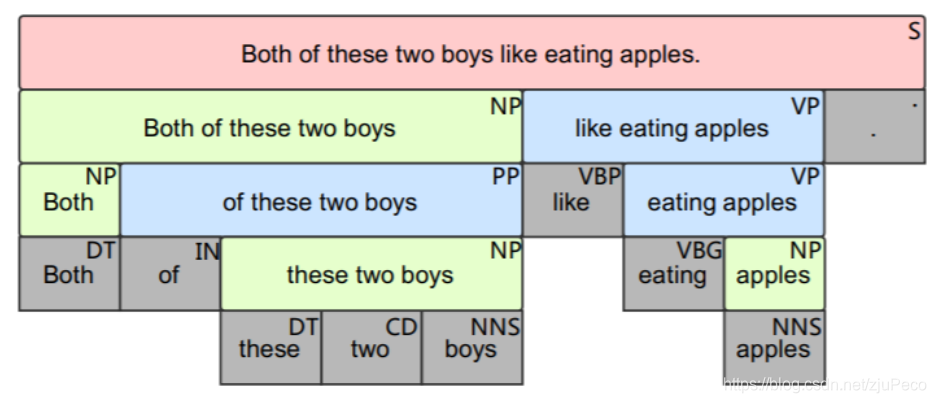

(1)Syntactic information

加入文法的信息是对模型输出语音的停顿是有帮助的,所谓文法的信息就是下图所示的这样,表示了哪些单词可以组成一个短语,在句子中的成分是什么等等。可参见Exploiting Syntactic Features in a Parsed Tree to Improve End-to-End TTS。

(2)BERT embedding as input

有人也试过把文本embedding之后的信息作为输入,这也是有一定帮助的。可参见Pre-trained Text Embeddings for Enhanced Text-to-Speech Synthesis。

3 Attention

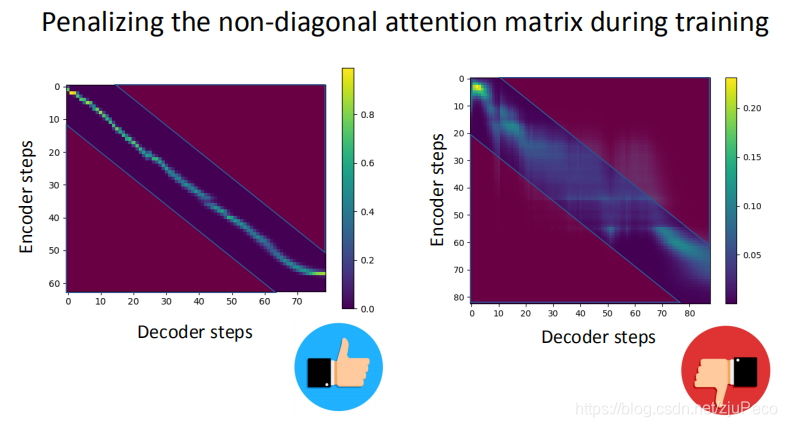

在上篇中,我们有提到过,希望Encoder steps和Decoder steps对应位置的attention都在对角线上,所有有一种很直接的做法就是,划出一块禁止有attention的区域,如果下图中红色位置的区域有attention的话,就对模型进行惩罚。这个就叫做Guided Attention。

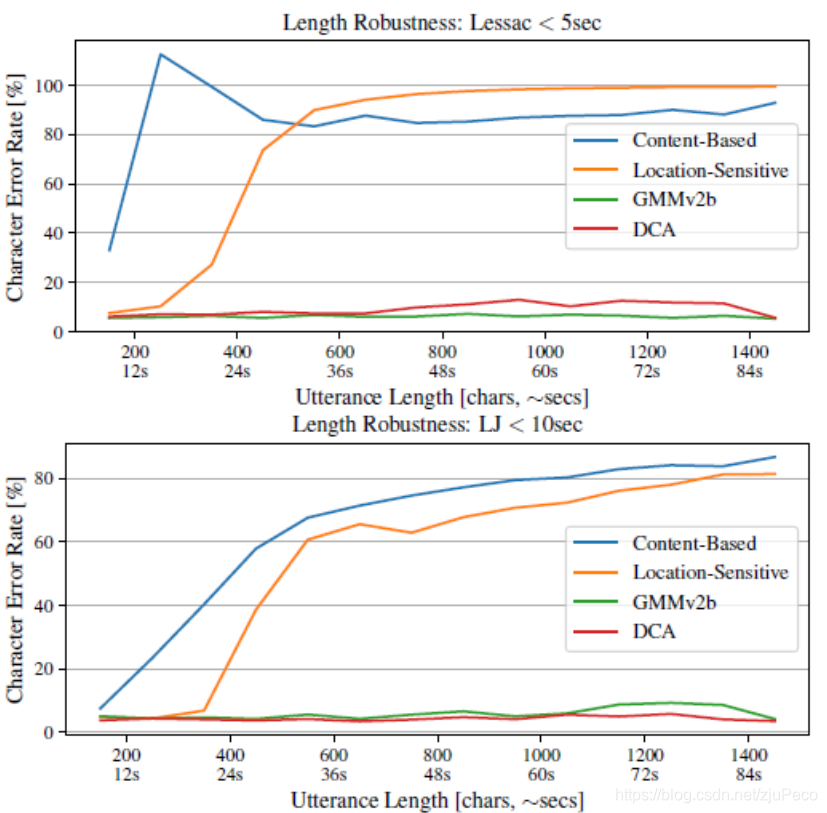

除此之外,还有很多很多其他的Attention,比如在charpeter 1-2中讲过的Location aware。这些attention对模型最终的效果有着很大的影响,具体可参见Location-Relative Attention Mechanisms For Robust Long-Form Speech Synthesis。该文指出,如果只用数据集中长度较短的数据去训练,然后用各种长度的数据来Inference,就会发现,一个好的attention的表现一直很好,但是有些attention面对比较长的数据就坏掉了。下图中的GMMv2b和DCA就是表现比较好的。

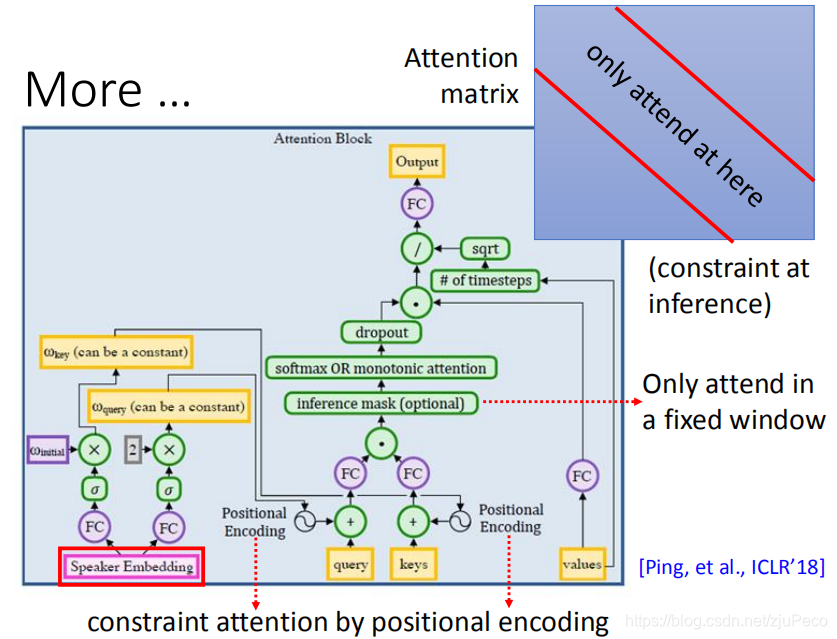

百度也提出过一种attention,这种attention有两个特点。其一是说,它在inference的时候,加了一个mask,把非对角线上的attention给直接置0了。其二是说它在query和keys输入时,都加入了position encoding,然后这个position encoding是根据speaker embedding直接学出来的。这大概是因为不同的人说话的语速是不同的吧。speaker embedding在下面会讲。

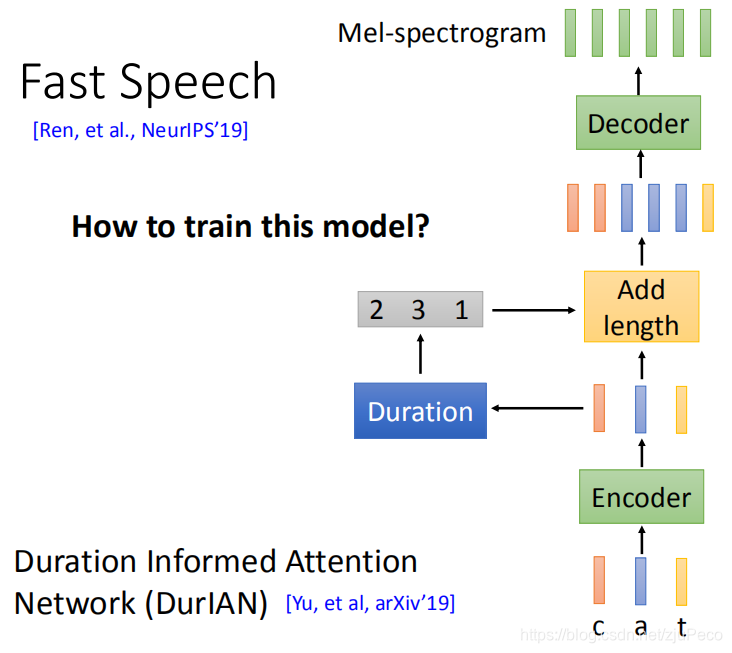

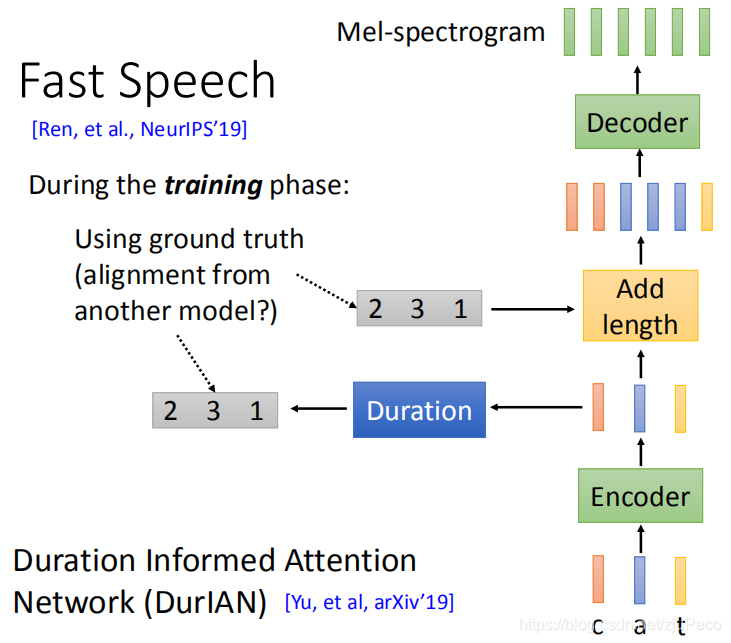

4 Fast Speech and DurIAN

除了Tacotron之外,还有其他的一些效果比较好的Text to Speech(TTS)的模型。比如下图中的Fast Speech和DurIAN。这两个模型是由两个团队在相近的时间提出的,然后思路也基本是一致的。他们的做法是说,先把文字输入到一个encoder当中去抽出一个等长的sequence feature,然后把这个feature放到一个叫做Duration的模块当中去,去预测每个feature需要重复的长度。这里的长度也就是我们最终输出的语音念每个词的长度。结合这个给定的长度和encoder产生的feature,输出一个与最终输出长度相符的sequence feature,再把这个sequence feature放到一个decoder当中去,得到最终的Mel-spectrogram,也就是我们的语音。

那么,这个模型该怎么训练,用end-to-end的方法去硬train的话,是不work的,因为Durantion到Add length这里是不可微分的。虽然可以用强化学习去硬train,但是文章采取了另一种方法。那就是给Duration这里一个ground truth,同时也把ground truth直接喂给Add length,这样用多个loss去train。这里的Duration的ground truth是用类似Tacotron这样的模型跑出来的。

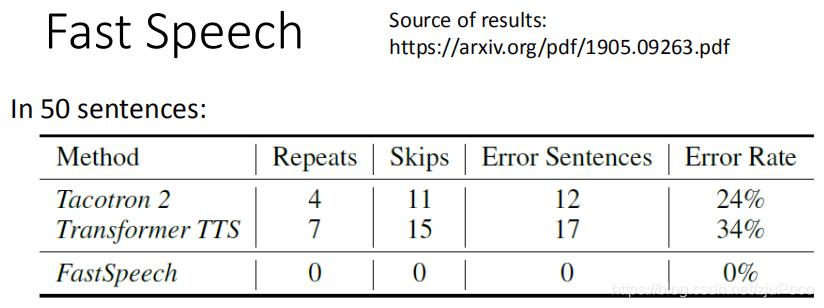

最终的结果,作者选了50个难念的句子试了一下,发现比Tacotron 2和其他模型要好很多。

5 Dual Learning

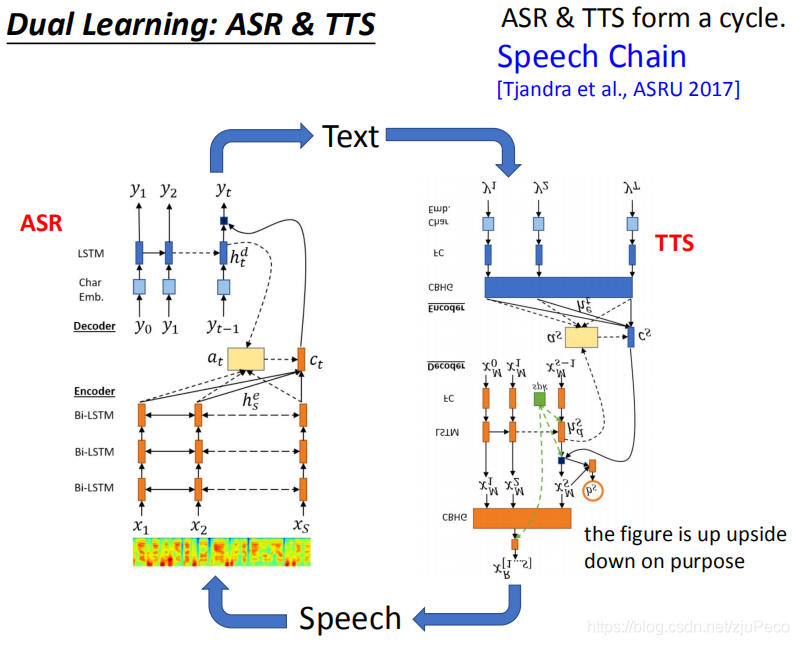

Automated Speech Recognition(ASR)和Text to Speech(TTS)是两个可以相互学习的模型。前者是输入语音,输出文字;后者是输入文字,输出语音。两者可以构成一个Speech Chain来相互学习,相互提升。

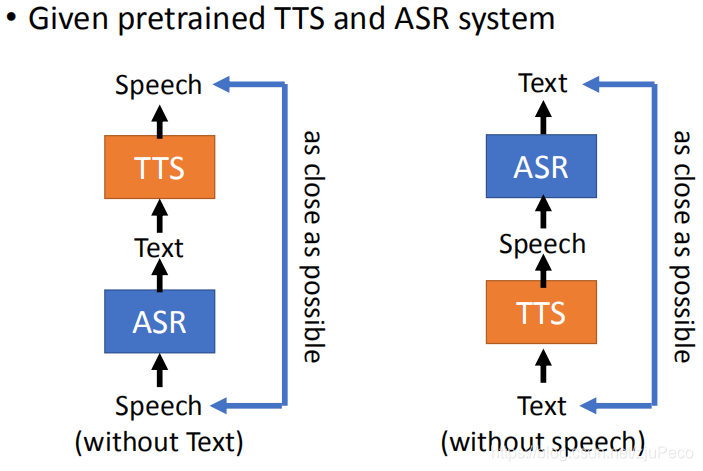

如何去相互学习呢?有两种方法。一种是我们只有语音,没有对应的文字的情况,这个时候,我们就可以把ASR当做encoder输出文字,TTS当做decoder输出语音,然后希望TTS输出的语音和输入的语音越接近越好。其实本质上就是一个auto-encoder的过程。另一用就是我们只有文字,没有语音的情况,做法和前者类似。这里的ASR和TTS都是需要pretrain过的。

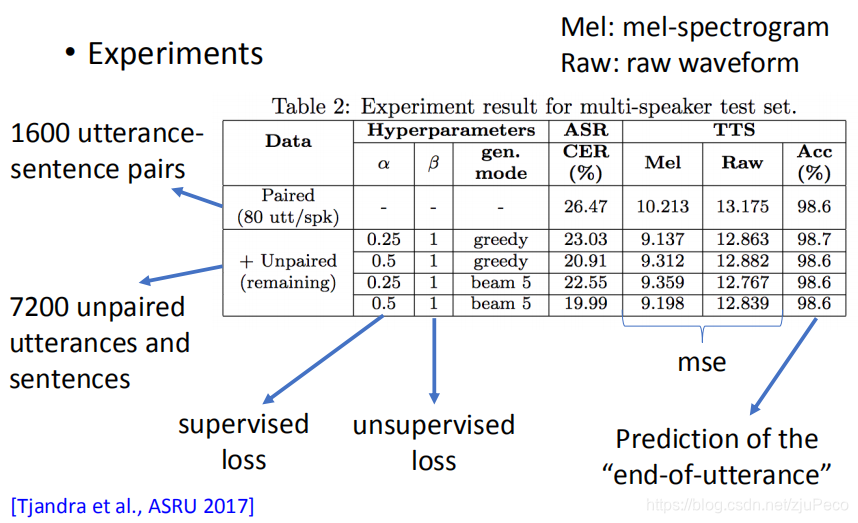

然后经过实验,这样train下来,对两者都有提升。

5 Controllable TTS

最后再来说一下如果去控制TTS。控制的方面主要分为三个方向:

- 说什么

这一块是通过我们输入的文字去控制的。 - 谁在说

谁在说的话可以通过收集某个人的大量语音资料,然后让模型去学习来做到。不过也有其他的方法。 - 怎么说

怎么说指的是说话的语调、重音和音律之类的。这个很难说清楚,英文叫做Prosody,翻译过来可以叫做抑扬顿挫。

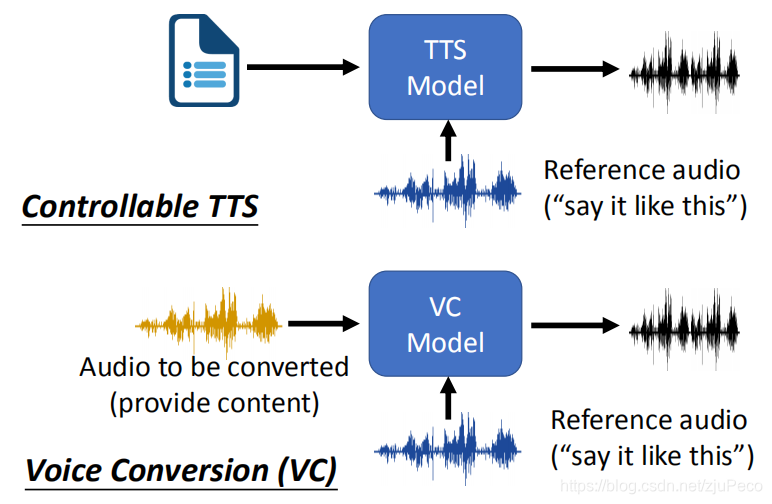

“谁在说”和“怎么说”可以用类似Voice Conversion的做法去实现,就是加入一段reference audio,让模型去学得和这段声音的说话方式类似。在这种情况下,TTS的训练方式也是和VC非常类似的。

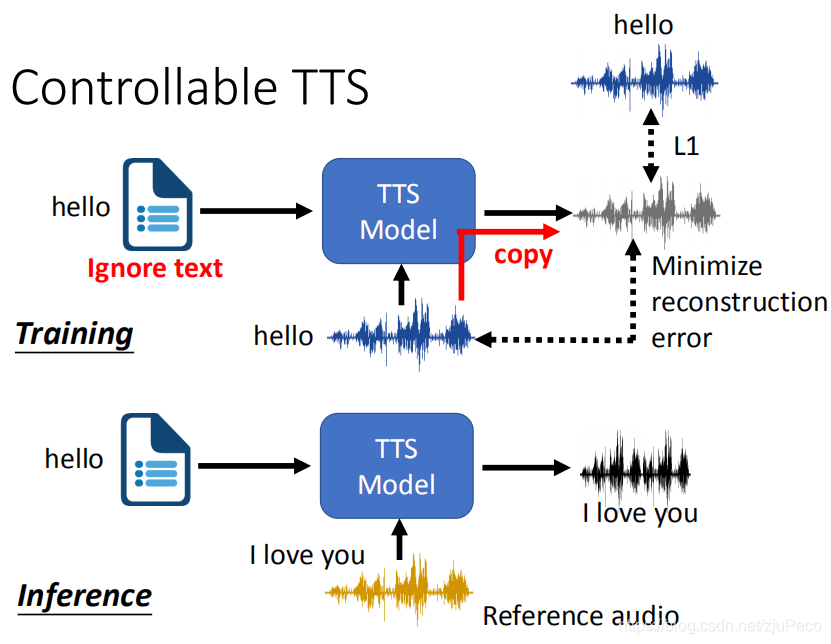

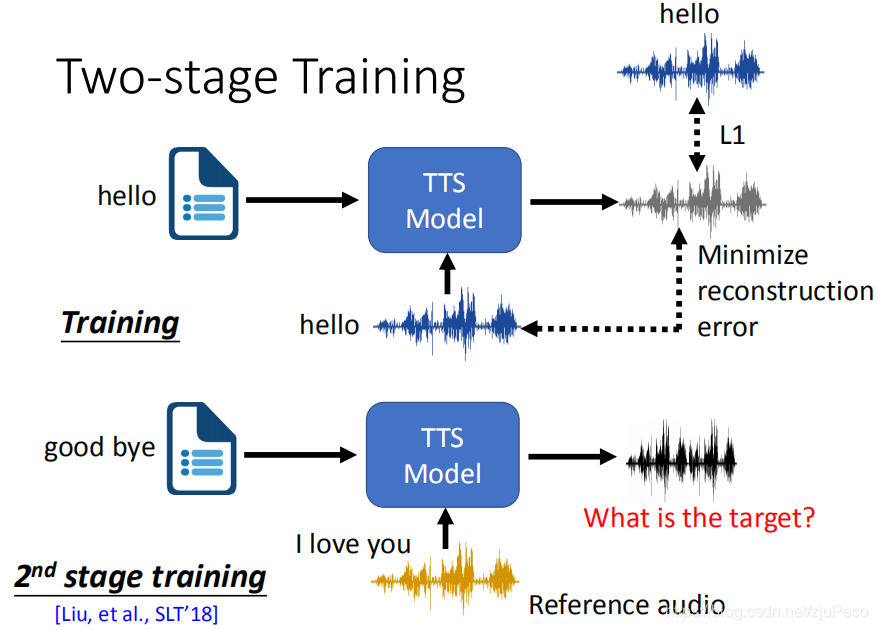

具体的训练方法是,比如我们有一段"hello"的text输入,然后又有一个“hello”的语音输入,我们希望最终输出的语音和我们输入的语音越接近越好。但是这样很可能会让模型偷懒,就是模型可能会无视输入的文字,直接把输入的语音输出了。最终的结果就是,在inference的时候,我们输入文字"hello"和语音"I love you",输出就直接是输入的"I love you"。所以,我们要让模型知道,要从输入的文字去获取内容信息,从输入的语音去获取语者的信息。

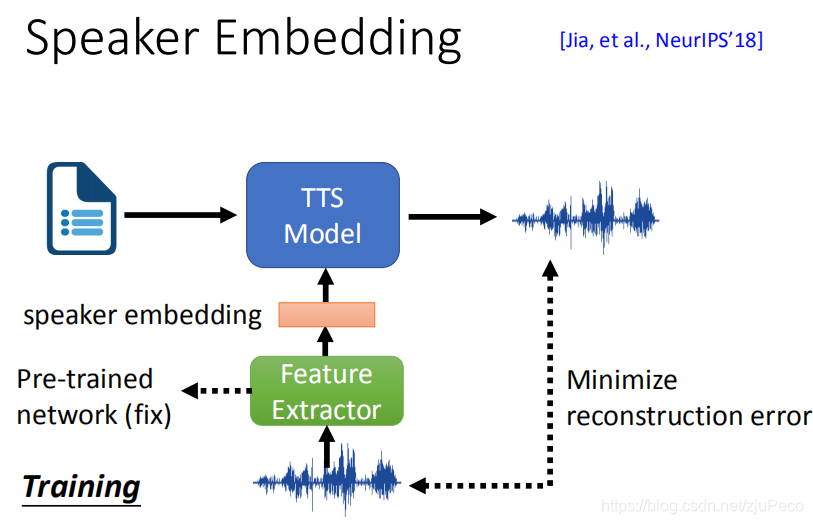

Speaker Embedding

所以,一种非常直观的做法,就是我找一个预训练好的只抽取语者特征的feature extractor来,固定住weights,不参与训练。然后把这个feature extractor输出的speaker embedding当做输入,这样一来,模型就只能够从输入的文字当中去获取输出内容的信息。这种方法,只需要少量的某个语者的语音数据,就可以train出一个该特定语者的TTS。

GST-Tacotron

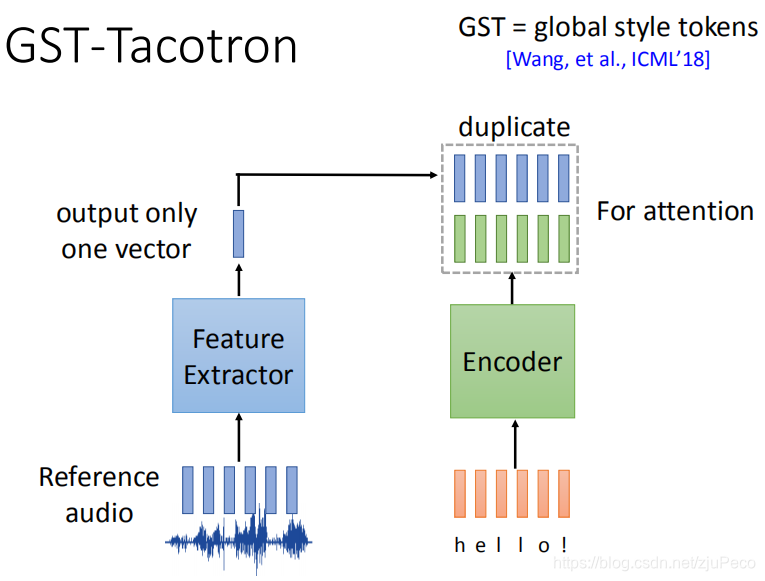

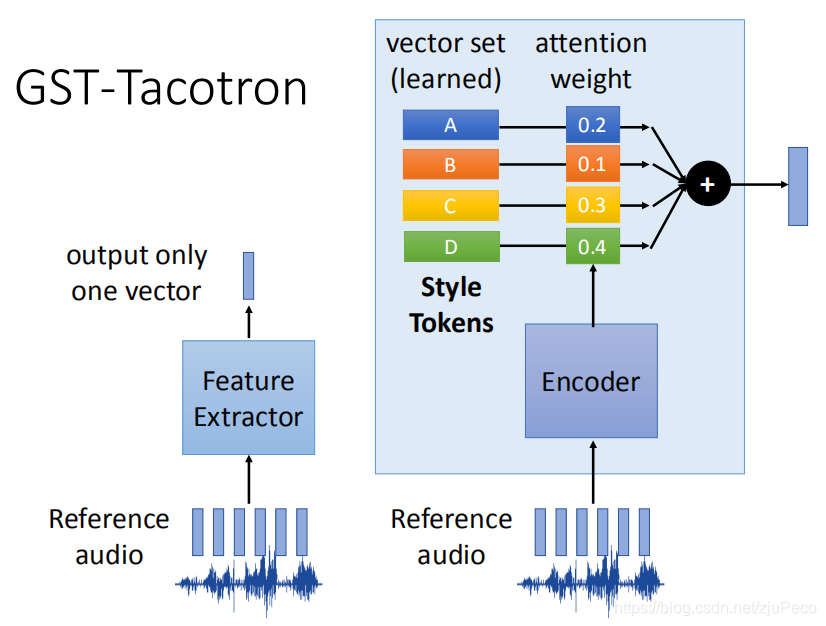

除了speaker embedding之外,GST-Tacotron也可以把输入的reference audio的内容信息过滤掉,只提取语者的特征。文字部分,还是会通过一个Encoder输出对应的sequence feature,不过reference audio这里,会经过一个参与训练的feature extractor,然后这个feature extractor只输出一个vector,这个vector会复制成一个和encoder输出序列长度一样的序列,然后把这两个序列concat或者直接相加即可。这个结果再那去做attention,剩下的部分就可Tacotron一样了。

为什么这么做可以把reference audio中的内容信息过滤掉?这得益于feature extractor的独特设计。feature extractor的内部如下图右半部分所示。reference audio会经过一个encoder输出一系列的weights,然后这些weights会和一些Style Tokens去做相乘求和,最终得到一个vector的输出。这些Style Tokens也是学出来的,神奇的是,当训练完成之后,发现每一个token就会对应一种声音的特征,只要调整attention的weights就可以输出不同的声音。比如有的token代表低音,有的token代表语速等等。

Two-stage Training

最后再介绍一种two-stage training的方法来提取reference audio中的语者信息。这是一种非常直观的做法,既然我们的输入语音和目标语音一样会让模型直接copy输入语音的话,那么我们让输入语音和目标语音不一样就可以了。比如我们输入文字"good bye"和语音"I love you",模型输出语音"good bye"。但这样一来,我们的ground truth去哪里找?

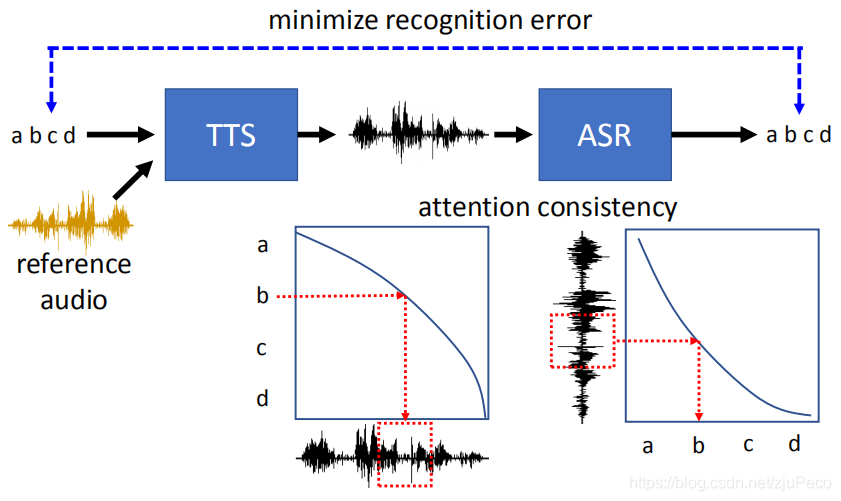

于是,我们这里用到了和上文中提到的dual learning类似的方法。我们会把TTS输出的语音,再放到一个ASR当中去,然后希望ASR输出的文字和输入的文字一致。这里有一个训练attention的技巧,就是,居然输入的某个字符的attention对应这某段语音,那么我们也可以让这段语音的attention对应着某个位置的字符。这样做train起来会容易一些。

)

DFS)