本系列内容:

- Kafka环境搭建与测试

- Python生产者/消费者测试

- Spark接收Kafka消息处理,然后回传到Kafka

- Flask引入消费者

- WebSocket实时显示

版本:

spark-2.4.3-bin-hadoop2.7.tgz

kafka_2.11-2.1.0.tgz

------------------------第1小节:Kafka环境搭建与测试---------------------------

1.Kafka环境搭建与测试

步骤01:解压kafka

tar -zvxf kafka_2.11-2.1.0.tgz -C /usr/local

步骤02:重命名文件夹

cd /usr/local

mv kafka_2.11-2.1.0 /usr/local/kafka

步骤03:配置broker,修改如下文件:

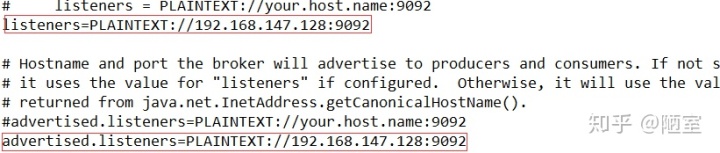

/usr/local/kafka/config/server.properties

将listeners和advertised.listeners节点修改如下,将localhost配置为IP,因为后面需要在windows上写程序连接broker。

如图所示:

2.测试

步骤01:进入kafka目录

cd /usr/local/kafka

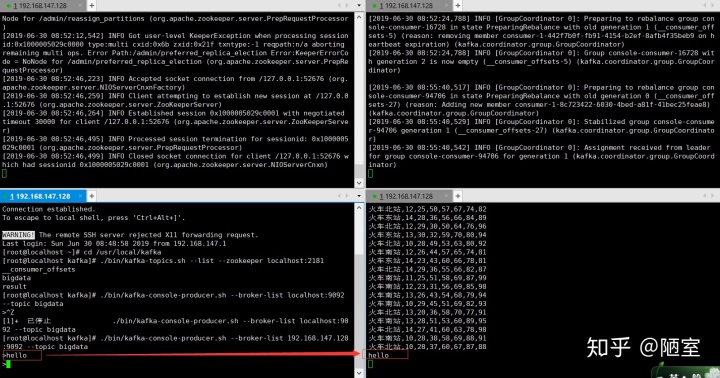

步骤02:打开新窗口,启动:zk server

./bin/zookeeper-server-start.sh config/zookeeper.properties

步骤03:打开新窗口,启动:kafka broker

./bin/kafka-server-start.sh config/server.properties

步骤04:打开新窗口,创建主题:--replication-factor:副本因子,设置副本个数 --partitions:分区数

./bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic bigdata

步骤05:显示主题列表

./bin/kafka-topics.sh --list --zookeeper localhost:2181

步骤06:打开新窗口,启动生产者

./bin/kafka-console-producer.sh --broker-list localhost:9092 --topic bigdata

在命令行中输入:hello

步骤07:启动消费者:--from-beginning 表示获取消费者启动前生产者发出的消息

./bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic bigdata --from-beginning

可以看到窗口中接收到了hello

注意:以上步骤,已经打开了4个shell窗口,在操作期间需要记住那个窗口启动了什么服务

如图所示:

- 消息的有序性)

)

)