2.3.1 线性分类

2.3.1.1 线性分类解释

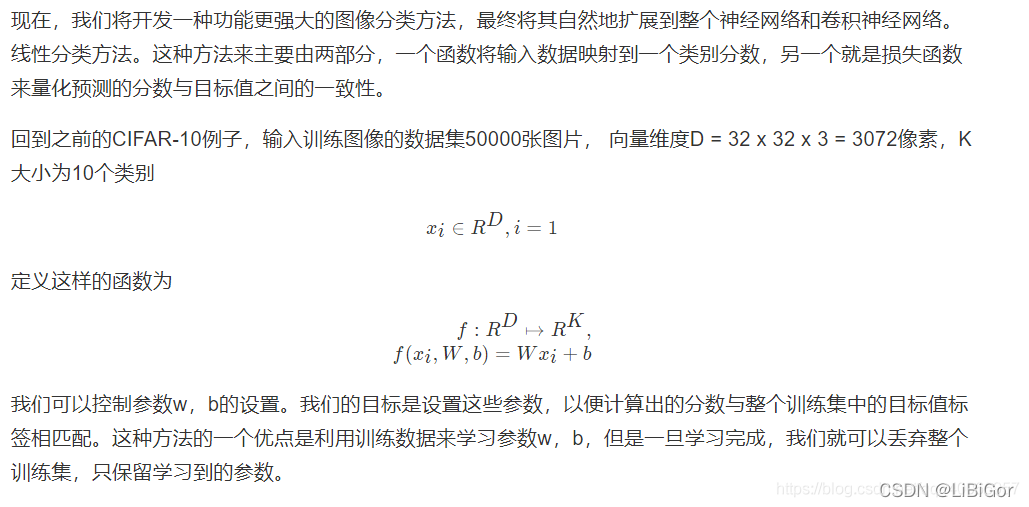

上图图中的权重计算结果结果并不好,权重会给我们的猫图像分配⼀个⾮常低的猫分数。得出的结果偏向于狗。

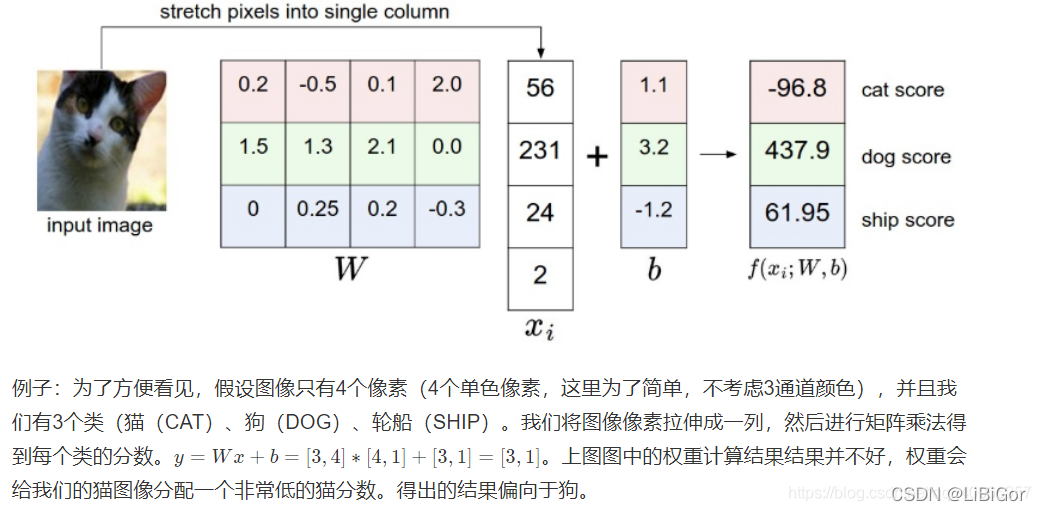

如果可视化分类,我们为了⽅便,将⼀个图⽚理解成⼀个⼆维的点,在下⾯坐标中显示如下:

- 解释:w的每⼀⾏都是其中⼀个类的分类器。这些数字的⼏何解释是,当我们改变w的⼀行时,像素空间中相应的线将以不同的⽅向旋转。⽽其中的偏置是为了让我们避免所有的分类器都过原点。

- 总结:分类器的权重矩阵其实是对应分类的经过训练得到的⼀个分类模板,通过测试数据与分类模板间的数据计算来进⾏分类。在训练的过程中,其实可以看作是权重矩阵的学习过程,也可以看成是分类模板的学习过程,如何从训练样本中学习分类的模板。模板权重的⼤⼩,反映了样本中每个像素点对分类的贡献率。

学习到的权重

2.3.2 损失函数

损失函数是⽤来告诉我们当前分类器性能好坏的评价函数,是⽤于指导分类器权重调整的指导性函数,通过该函数可以知道该如何改进权重系数。CV与深度学习课程之前,⼤家应该都接触过⼀些损失函数了,例如解决⼆分类问题的逻辑回归中⽤到的对数似然损失、SVM中的合⻚损失等等。

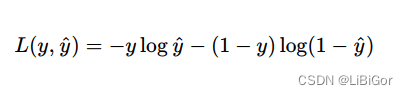

对数似然损失

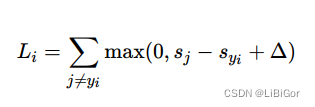

合⻚损失

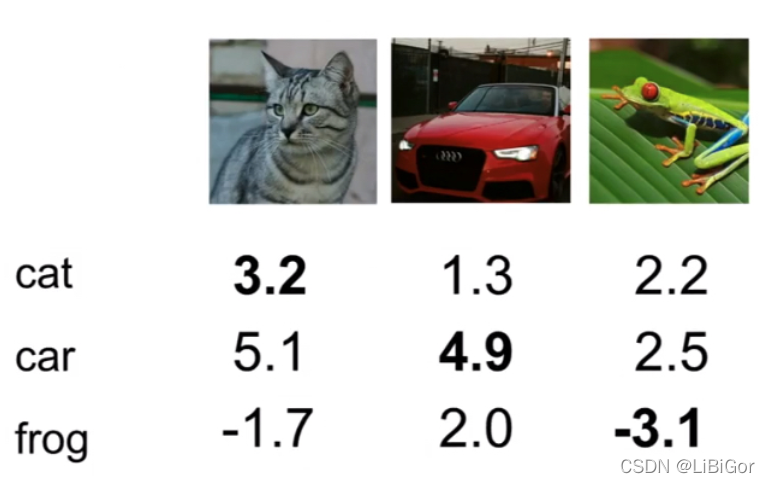

现在回到前⾯的线性分类例⼦,该函数预测在“猫”、“狗”和“船”类中的分数,我们发现,在这个例⼦中,我们输⼊描绘猫的像素,但是猫的分数与其他类别(狗的分数437.9和船的分数61.95)相⽐⾮常低(-96.8)。那么这个结果并不好,我们将会去衡量这样的⼀个成本,如果分类做好了,这个损失将会减少。

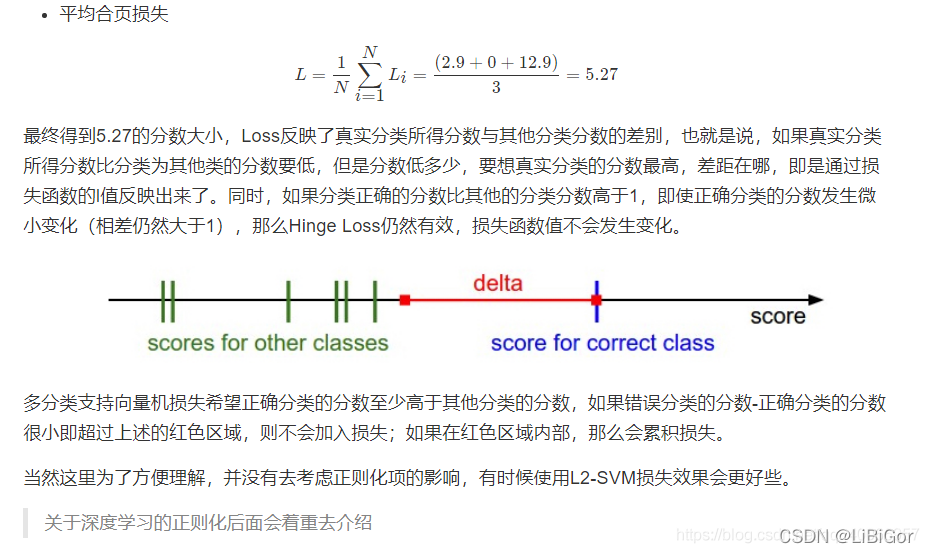

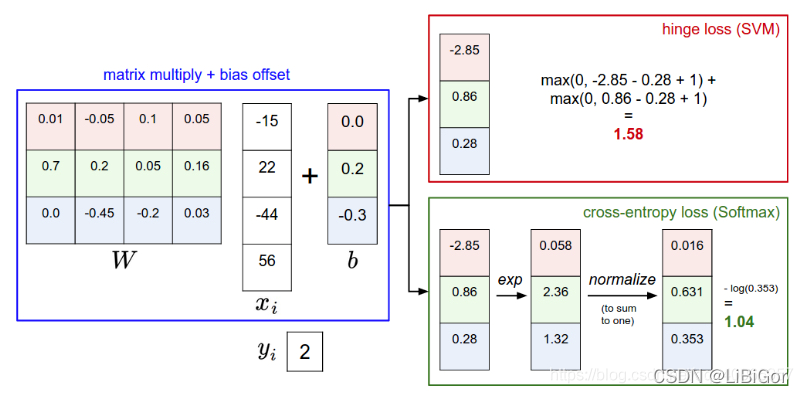

多分类问题的损失该如何去衡量?下⾯会进⾏通常会使⽤的两种⽅式作对⽐,这⾥介绍在图像识别中最常⽤的两个损失——多类别SVM损失(合⻚损失hinge loss)和交叉熵损失,分别对应多类别SVM分类器和Softmax分类器

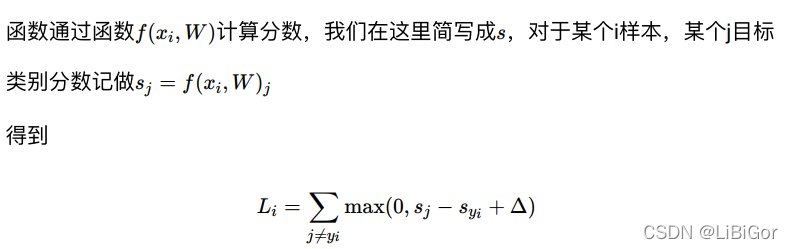

2.3.2.1 多分类SVM损失

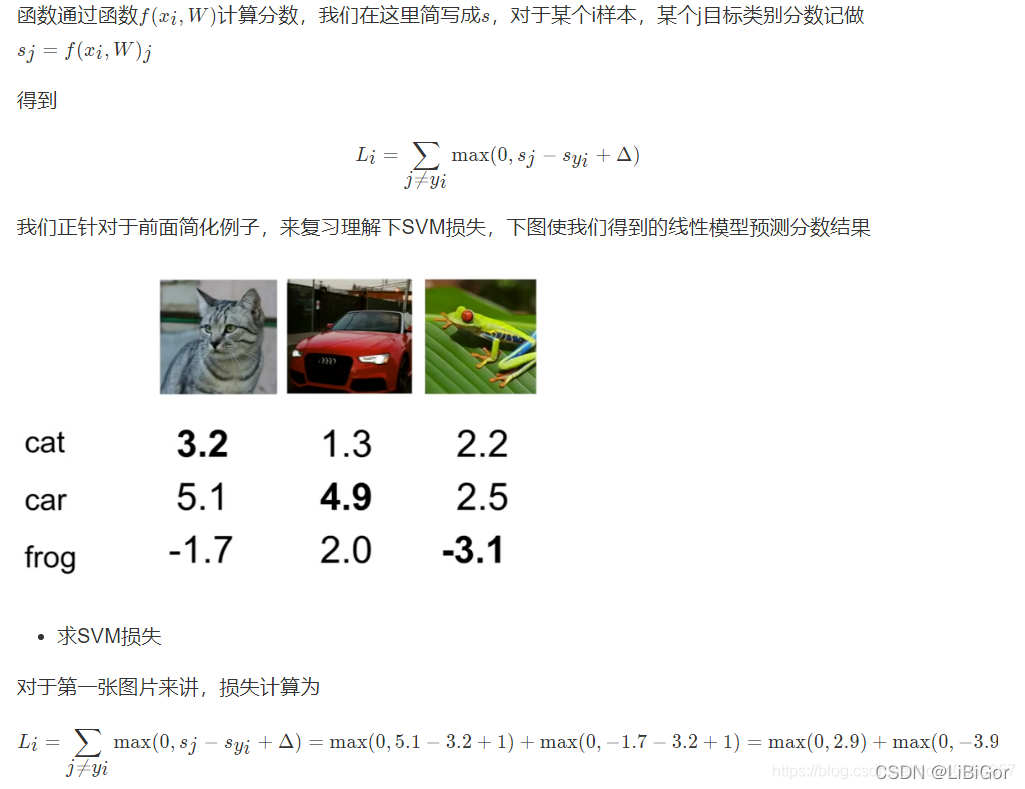

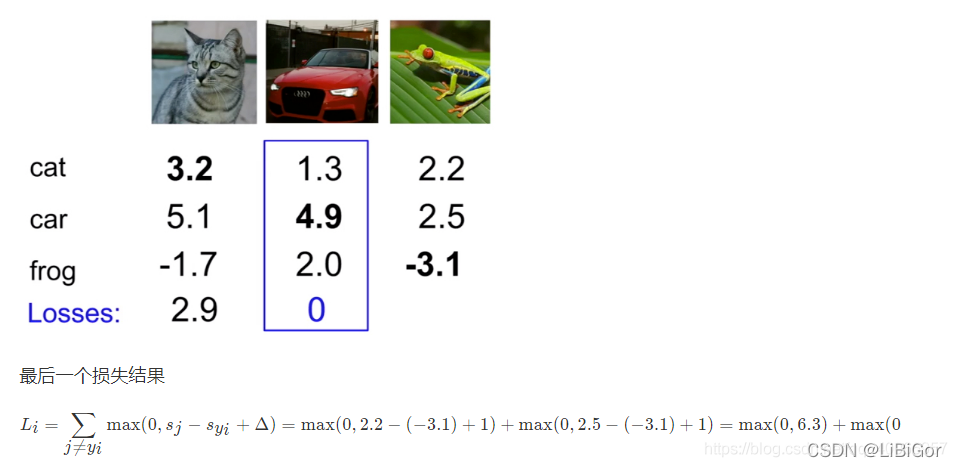

我们正针对于前⾯简化例⼦,来复习理解下SVM损失,下图使我们得到的线性模型预测分数结果

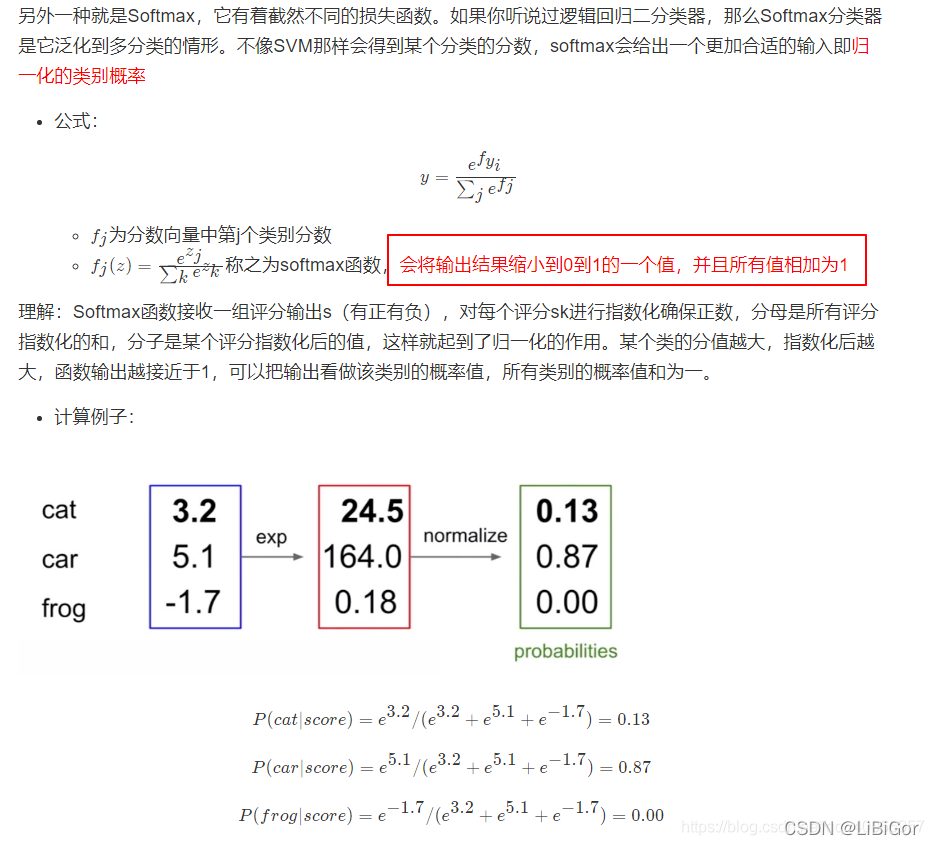

2.2.2.2 Softmax 分类(Multinomial Logistic Regression)与cross-entropy(交叉熵损失)

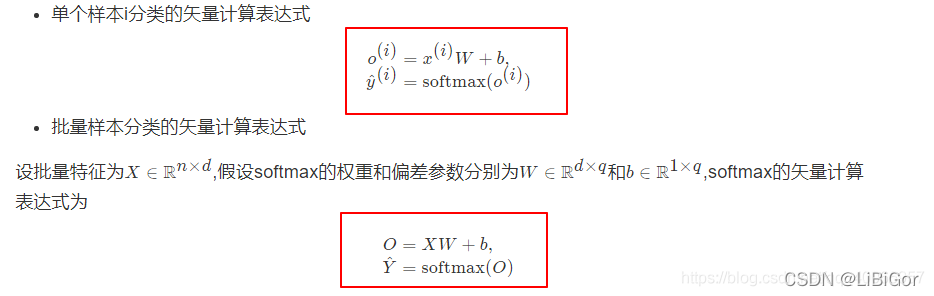

1、Softmax

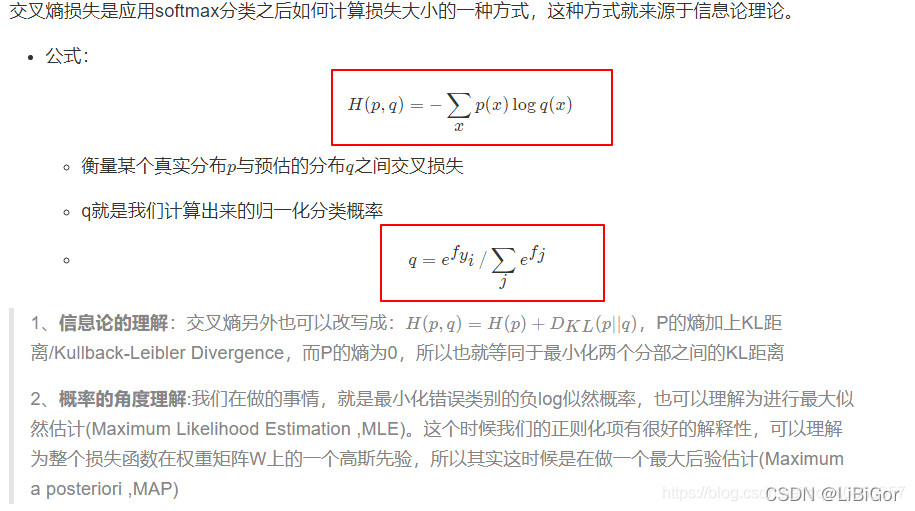

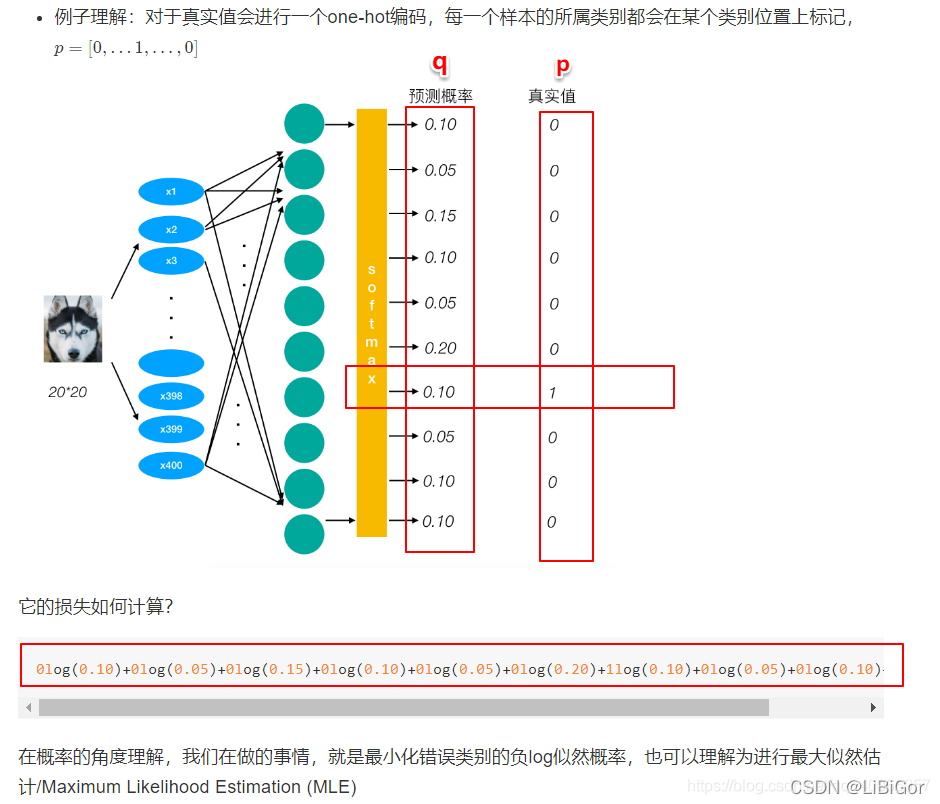

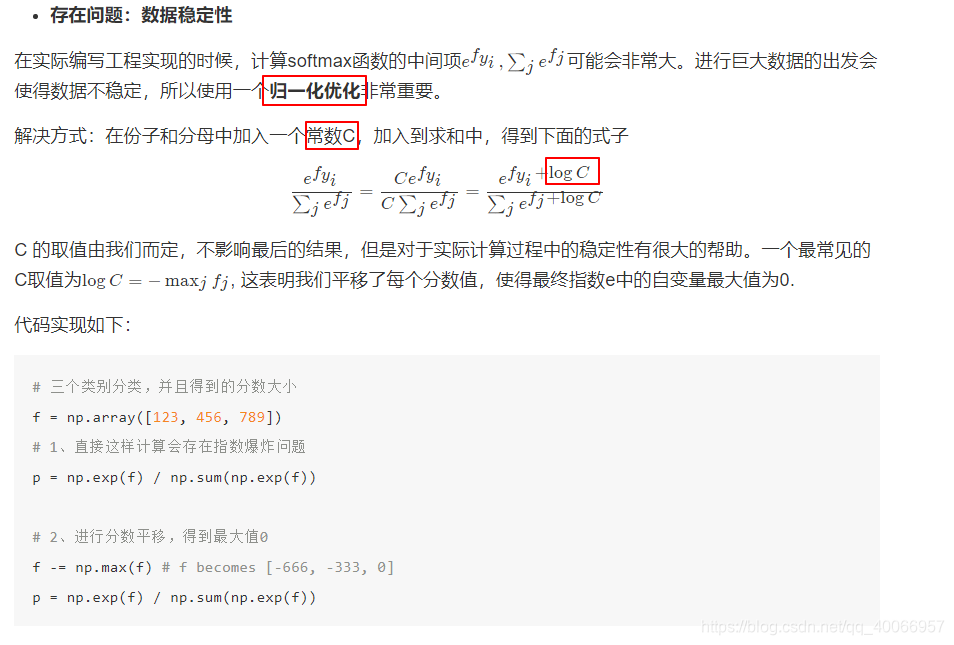

2、cross-entropy

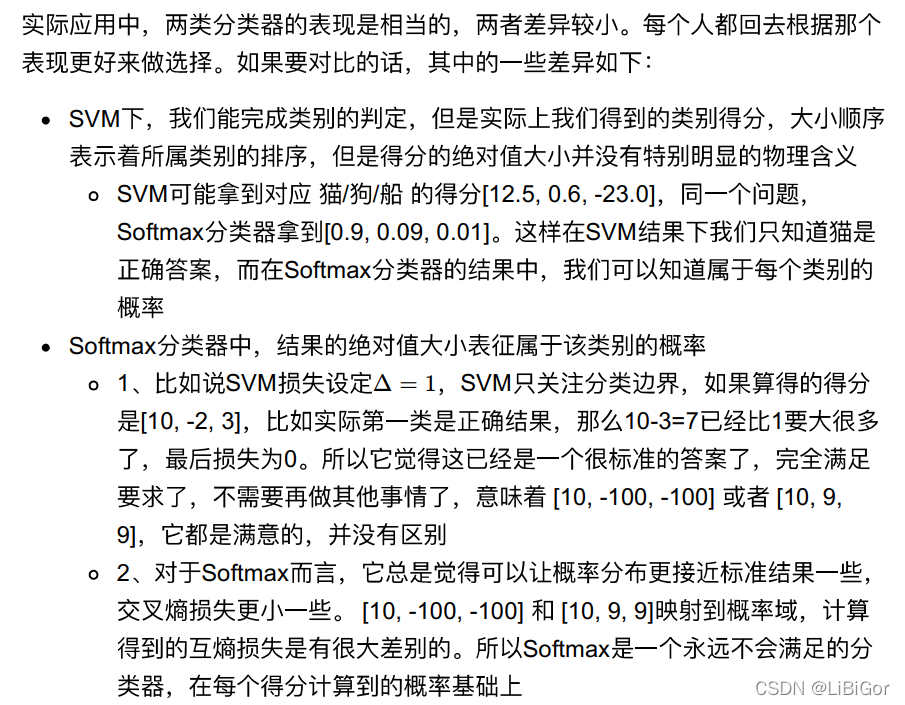

2.3.3 SVM与Softmax对比

下面这张图就清楚的展示了两个分类以及其损失计算方式的区别

![[已解决]fdfs-client-py==1.2.6安装失败](http://pic.xiahunao.cn/[已解决]fdfs-client-py==1.2.6安装失败)

: Can‘t connect to local MySQL server through socket ‘/var/run/mysqld/mysqld.sock‘)

)