大数据概述

数据的表现形式:

- 线下数据信息化:数据库、文字记录、照片……

- 互联网-移动互联网:网页数据、用户行为记录、数字图像……

- 传感器:设备监控、智能家居、摄像头……

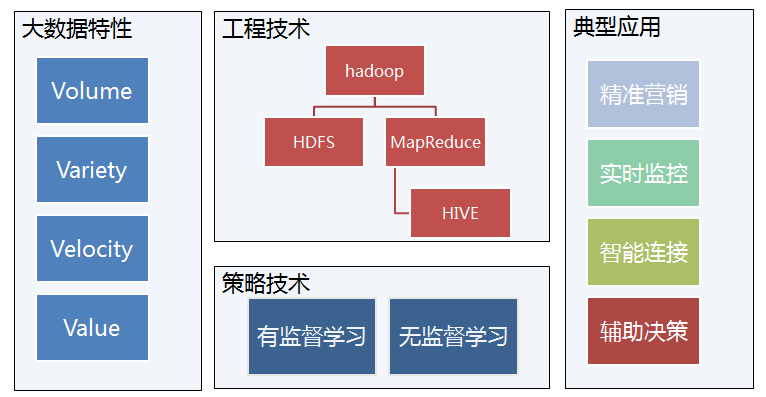

大数据的4V特征:

- 大量化(Volume):存储量大、增量大;

- 多样化(Variety):来源多、格式多;

- 快速化(Velocity):高速数据I/O;

- 价值密度低(Value)

大数据基础技术

一、工程技术

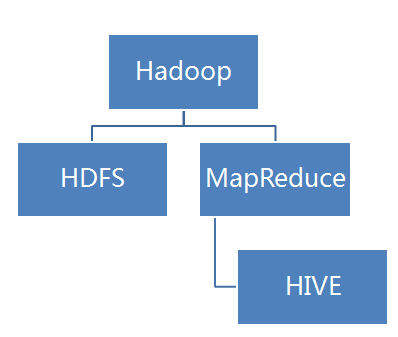

Hadoop介绍

Hadoop是一个能够对大量数据进行分布式处理的软件框架。

Hadoop的框架最核心的设计就是:HDFS和MapReduce。HDFS 实现存储,而 MapReduce实现分析处理。

| 关系型数据库 | Hadoop | |

|---|---|---|

| 数据量 | GB | PB |

| 使用场景 | 点查询或更新 | 整个数据集,一次写多次读,没有更新 |

| 结构化程度 | 结构化 | 半结构化及非结构化 |

| 扩展性 | 线性 | 非线性 |

Hadoop和网格计算的区别:

网格计算:CPU密集型,各个处理单元接收小批量数据,然后贡献CPU,最后提交计算结果;

Hadoop:数据本地化,传输数据量较大,对网络带宽要求较高。

HDFS(Hadoop Distributed File System)基本命令:

%hadoop fs -ls .

%hadoop fs -mkdir books

%hadoop fs -copyFromLocal input/docs/test.txt hdfs://loca1host/user/tom/test.txt

HDFS特点

1.流式访问:

跑在HDFS上的应用与一般的应用不同,它们主要是以流式读为主,做批量处理;比之关注数据访问的低延迟问题,更关键的在于数据访问的高吞吐量。

2.write-one-read-many

一个文件经过创建、写,关闭之后就不需要改变。这一假设简化了数据一致性问题,使高吞吐量的数据访问成为可能。

3.本地计算

移动计算的代价比之移动数据的代价低。一个应用请求的计算,离它操作的数据越近就越高效。将计算移动到数据附近,比之将数据移动到应用所在显然更好,HDFS提供给应用这样的接口。

4.容错及备份

Hadoop有健壮的数据校验+容灾备份。通过配置解决

HIVE

定义:一个构建在Hadoop上的数据仓库框架。

目的: 可以通过类SQL语句快速实现简单的MapReduce统计,使熟悉SQL的用户无缝使用Hadoop。

特点:语法基本和MySQL相同,但是功能没有MySQL丰富,满足最基本的SQL语法要求。

HIVE的实现逻辑

select year,count(temperature)

from src

where year>1990

group by year

having count(temperature)>1000;

这个sql的语义是:

1)(map)从src表中选出所有的记录,选出year>1990的记录;

2)(partition and shuffle)按照year进行分组(year相同的记录放到一组);

3)(reduce)对每个分组计算count(temperature),选出count(temperature)>1000的记录;

4)最后对于计算结果选出year和count(temperature)的值作为返回结果

小结:

二、策略技术

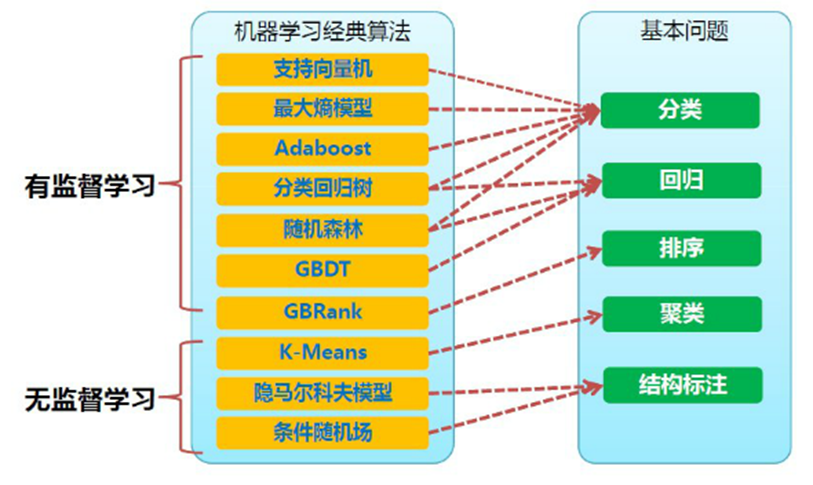

机器学习中经典算法和对应问题

有监督学习:对具有概念标记(分类)的训练样本进行学习,以尽可能对训练样本集外的数据进行标记(分类)预测。这里,所有的标记(分类)是已知的。无监督学习:对没有概念标记(分类)的训练样本进行学习,以发现训练样本集中的结构性知识。这里,所有的标记(分类)是未知的。因此,训练样本的岐义性高。聚类就是典型的无监督学习

定量输出称为回归,或者说是连续变量预测;定性输出称为分类,或者说是离散变量预测。

典型应用

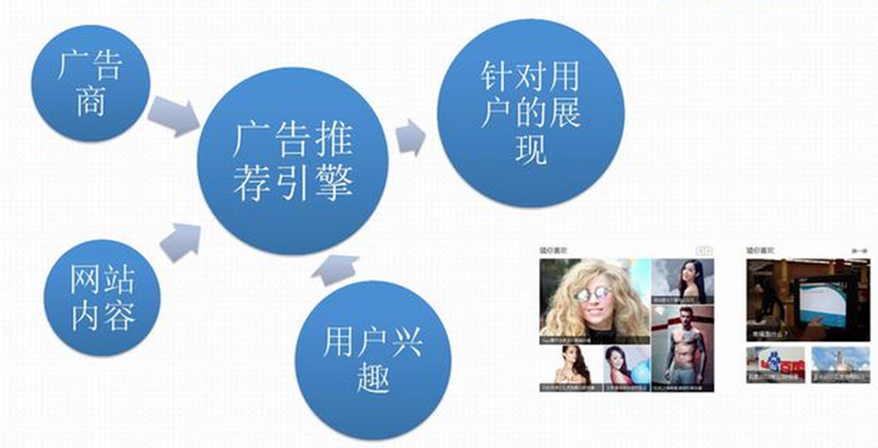

- 精准营销:广告变现

- 精准营销:推荐引擎

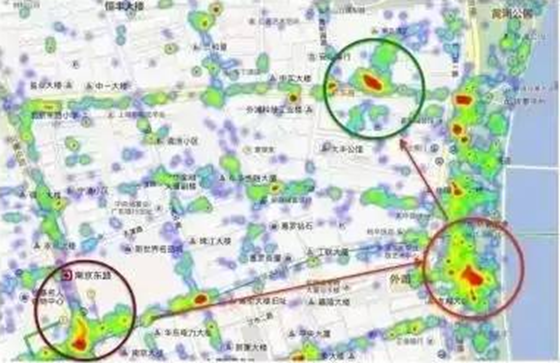

- 实时监控:上海外滩踩踏事件

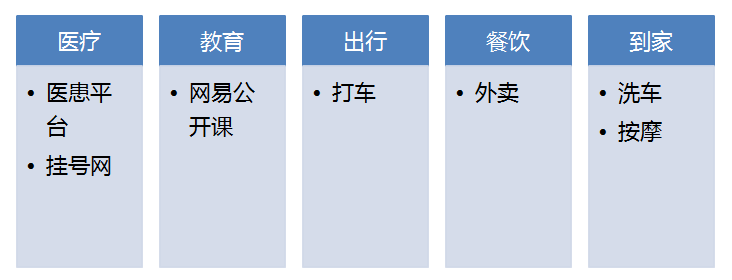

- 智能链接:互联网+O2O

- 智能链接:互联网+O2O:Uber

- 辅助决策:智能选股

- 辅助决策:智能选址

总结

本文参考自牛客网。