未经私信同意禁止转载!

前言

CFFI是连接Python与c的桥梁,可实现在Python中调用c文件。CFFI为c语言的外部接口,在Python中使用该接口可以实现在Python中使用外部c文件的数据结构及函数。

Python运行比较低,尤其是操作字节流的时候,为了提升效率,可以通过CFFI在我们的Python设计中嵌入C,大大提升程序的效率。前面的文章《给我儿子做个自动读故事的机器》https://www.jianshu.com/p/56df82bd4dbb中要对音频文件进行操作,涉及到字节流,运行效率低,会引发系统延迟很大。所以这篇文章的第二部分就是一个CFFI的实例来加速文件操作。

一、CFFI的使用

CFFI是一个python库,这个库里面有函数可以调用编译器对C语言源文件进行编译,输出一个.so库文件,这库文件就可以 被python调用,就向调用你自己编写的.py文件一样。并且CFFI在PYNQ已经被预装好了,无需自己安装。如果是在Ubuntu下面使用,可能需要自己手动安装一下,需要说明的是,CFFI需要编译器,所以你的系统中需要安装一下编译器,我用的是gcc。

CFFI有ABI和API两种形式。ABI 驳接的是已经编译好的 binary,API 更快,把 C 代码编译出来使用。关于编译器的使用又分为in-line和out-line两种形式。in-line 即时编译使用,out-line 离线编译后调用。这两两组合一共有四种应用方式,这些PYNQ全都支持。

下面这篇文章有比较清楚的介绍,也有详细的例子,大家可以参考一下。https://www.cnblogs.com/ccxikka/p/9637545.html

接下来我们要介绍一个简单的例子,来展示的是API out-line的应用,并且这个例子调用的是自己编写的外部文件,比上面那个链接里面展示的内容要复杂。

在工程目录下建立三个设计文件如下图:

.c 和.h是源码文件,这个不用个多说。build.py是用用来对源文件进行编译生成库的。

.c文件里面写了一个加法函数

#include <stdio.h>

#include "demo.h"

int add(int a, int b)

{

int c;

c = a+b;

return c;

}.h文件对函数进行声明 int add(int a, int b); 接下来是最重要的build 文件。这里包含源文件添加和编译函数。

#

import cffiffi = cffi.FFI() #生成cffi实例ffi.cdef("""int add(int a, int b);""") #函数声明,。。这个地方应该更好的写法,但是我没搞懂ffi.set_source('demo_module', ##这就是生成的库的名字,将来会在python里面调用"""#include "demo.h" """,sources=['demo.c'])if __name__ == '__main__':

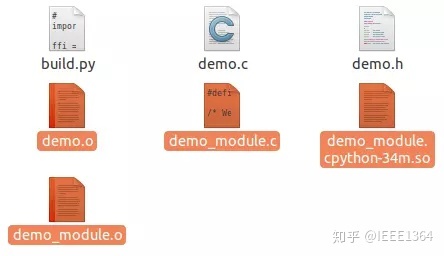

#compile是离线方式的专用方法,它的作用是让编译器编译出可调用的.so文件ffi.compile(verbose=True)在python 里面运行build.py。如果没有错误,将生成以下几个文件

其中.so文件就是我们的库文件。

这个demo的测试语句是这样的写的

import demo_module.lib as demo

print(demo.add(2,4))

正确运行后将得到加法的结果。

这个模板大家可以直接拿过去用,不需要自己编写,只需要在build.py文件中替换自己的文件名和函数名就可以了。

二、PYNQ嵌入C语言操作WAV文件

在《给我儿子做个自动读故事的机器》中需要用到python对讯飞返回的16kHz单通道16bit WAV 转换为48kHz 双通道24bit编码方式。在PYNQ上用Python做有连个问题,一是涉及字节流操作效率很低,系统时延大,二是麻烦,没有专门的python库可以完成这种操作,需要用各种函数来拼接。

关于WAV文件的解析有以下两篇文章写得比较好,信息清楚全面。https://zhuanlan.zhihu.com/p/27338283https://blog.csdn.net/zhihu008/article/details/7854529

转换函数如下:

void convert(char inputfilename[],char outputfilename[])

{FILE *fin; FILE *fout;if((fin= fopen(inputfilename,"rb"))==NULL){printf("error! can't find audio file!n");exit(1);}if((fout= fopen(outputfilename,"wb+"))==NULL){printf("error! can't find output file!n");exit(1);}Wav wav;RIFF_t riff;FMT_t fmt;Data_t data;fread(&wav, 1, sizeof(wav), fin);unsigned int inputlength = wav.data.Subchunk2Size;unsigned int outputlength =(unsigned int) wav.data.Subchunk2Size*2*24/16*(48000/16000);unsigned char inputflow[inputlength];unsigned char outputflow[outputlength];unsigned char *inputpointer= inputflow;fread(inputpointer,1, inputlength,fin);unsigned int j=0;unsigned int k=0;for(j=0;j<inputlength/2;j++){k= j*18;outputflow[k] = 0;outputflow[k+1] = inputflow[2*j];outputflow[k+2] = inputflow[2*j+1];outputflow[k+3] = 0; outputflow[k+4] = 0;outputflow[k+5] = 0;outputflow[k+6] = 0;outputflow[k+7] = 0;outputflow[k+8] = 0;outputflow[k+9] = 0;outputflow[k+10] = inputflow[2*j];outputflow[k+11] = inputflow[2*j+1];outputflow[k+12] = 0; outputflow[k+13] = 0;outputflow[k+14] = 0;outputflow[k+15] = 0;outputflow[k+16] = 0;outputflow[k+17] = 0; }wav.fmt.NumChannels = 2;wav.fmt.SampleRate = 48000;wav.fmt.BitsPerSample = 24;wav.fmt.BlockAlign = 2*24/8;wav.fmt.ByteRate = wav.fmt.SampleRate*2*24/8;wav.data.Subchunk2Size = outputlength;wav.riff.ChunkSize = outputlength+36;fwrite(&wav, 1, sizeof(wav), fout);fwrite(outputflow,1,outputlength,fout);printf("convert finishedn");fclose(fin);fclose(fout);

}

所有设计文件和编译生成的文件打包放在网盘上。

链接:https://pan.baidu.com/s/13F-wB5zFpFRwtpp_pQb24A 密码:p2sc

说明:

1.设计文件一定要在PYNQ平台上编译。因为PYNQ上的编译器和ubuntu下不一样,生成的库是无法通用的。

2.不知道为什么生成的.so库文件无法在jupyter里面运行,只能在python3下面运行。这里有妖,找个时间研究下。

3.现在这个程序其实写的很简单,有个问题是占用内存很大,会将整个转化后的音频流数据都放在ram里面,然后一次性写入,耗费ram。差不多一个5s长的音频会消耗1M内存。如果要处理一个大的音频文件,需要修改代码。要知道PYNQ只有512M内存。

后记

CFFI的应用对PYNQ是一个极大的扩展,意味着很多已经成型的C语言库都可以被调用,能够有效地扩展PYNQ的应用范围和运行效率。

当然,使用FPGA部分来加速自然效率更高,但是开发难度相对大很多,还要修改overlay,应用的可移植性不是很好。CFFI 是一个比较中性的选择。Xilinx 的HLS可以对逻辑开发进行C语言支持,在CFFI中应用的C代码也许可以比较方便地转化为硬件逻辑,或者作为算法验证的前一个步骤。当然这一点只是我的推断,因为我对C语言的逻辑开发并不熟悉。

欢迎关注我的专栏《电子工程师有多无聊》,你可以看到更多关于使用Python进行硬件编程的文章。如果你有兴趣,也欢迎投稿。

)

项目概况)

)

)

)

)