步骤

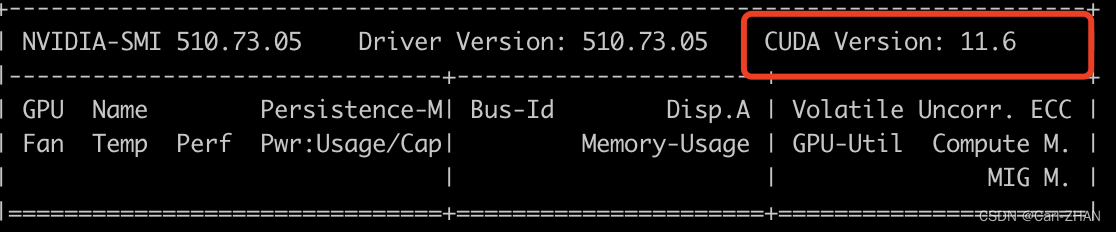

首先查看自己设备的cuda版本

#如下linux指令都可以,主要还是以nvidia-smi为主

nvidia-smi

nvcc -V

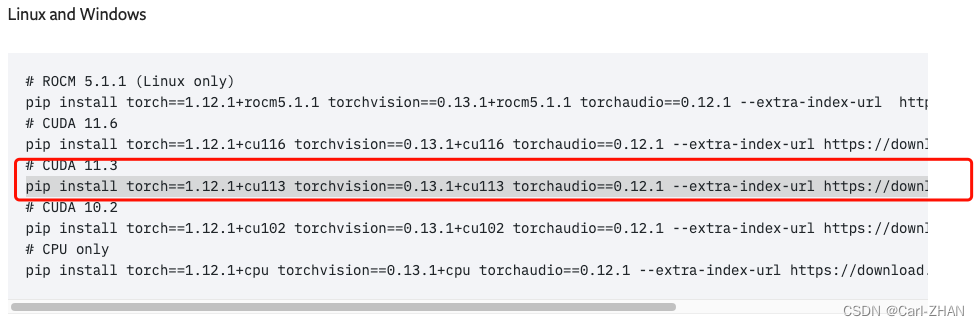

用的python版本是3.8

torch版本用的1.12.1+cu113

torch网址:https://pytorch.org/get-started/previous-versions/

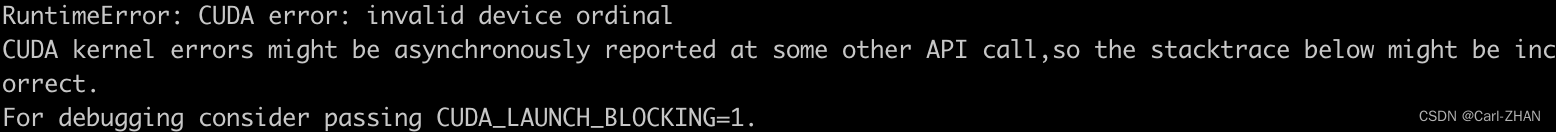

安装完后发现出现如下问题:

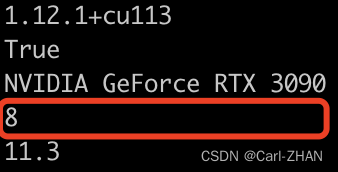

import torch

print(torch.__version__) # 查看pytorch安装的版本号

print(torch.cuda.is_available()) # 查看cuda是否可用。True为可用,即是gpu版本pytorch

print(torch.cuda.get_device_name()) # 返回GPU型号

print(torch.cuda.device_count()) # 返回可以用的cuda(GPU)数量,0代表一个

print(torch.version.cuda)

运行发现GPU数量为1,原本应该是8.

解决方案

在linux指令里面输入:

#GPU的数量export CUDA_VISIBLE_DEVICES=[GPU的个数]

#eg. 8卡就用下语句

export CUDA_VISIBLE_DEVICES=0,1,2,3,4,5,6,7

#4卡

export CUDA_VISIBLE_DEVICES=0,1,2,3

重新运行后可以看到GPU的数量为8.

export CUDA_VISIBLE_DEVICES=device_ids例如,要将环境变量设置为使用设备 0 和 1,可以执行以下命令:export CUDA_VISIBLE_DEVICES=0,1如果要使用所有可见的设备,可以将 `device_ids` 设置为空:export CUDA_VISIBLE_DEVICES=这将清除 `CUDA_VISIBLE_DEVICES` 环境变量,使所有可见的设备都可用。

)

)

——raid5与btrfs文件系统无损原数据扩容)

)